MLNLP社区是国内外知名的机器学习与自然语言处理社区,受众覆盖国内外NLP硕博生、高校老师以及企业研究人员。

社区的愿景是促进国内外自然语言处理,机器学习学术界、产业界和广大爱好者之间的交流和进步,特别是初学者同学们的进步。关于大模型的商业落地,一个非常容易想到的场景就是智能客服,作为不止是大模型也是 NLP 领域的一个最主要的应用场景,由于人工客服的高昂成本,AI 客服伴随着模型技术的发展也逐步走进我们的生活,在手机里各种主要的 APP 几乎都配备了一个智能客服。

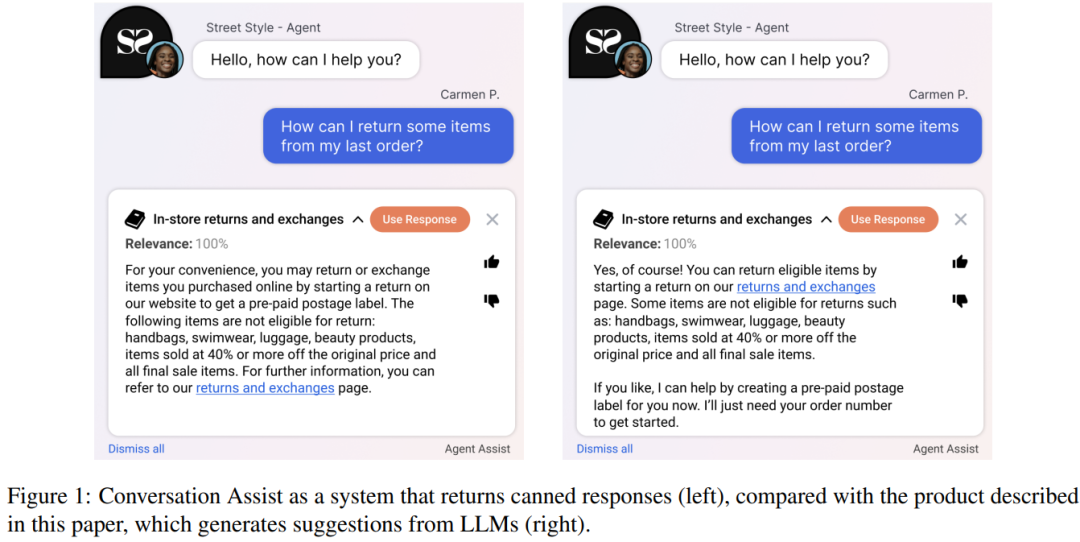

而以 Chat 命名的大规模语言模型(LLMs)似乎天然的适配智能客服的应用场景,大模型驱动的智能客服也是一个非常具有想象力的落地方向。但是,在今年的 ACL 2023 中,来自对话式 AI 科技公司 LivePerson 的研究人员针对大模型“取代”客服工作算了一笔经济账,结果发现,用 GPT-3 等大模型做智能客服的 Backbone 反而有可能要赔钱?

大模型的壁垒,也是大模型当下一个不可回避的问题,可能就是它高昂的训练与响应成本,使用 GPT-2 与 Nvidia A100 GPU 进行单次响应的成本约为 0.0011 美分,而如果这个模型换为基于 GPT-3 的 Davinci 模型,使用 OpenAI 的 API 的单次响应成本则将会变为 1.1 美分。而这种成本测算方式的一个突出问题就在于,显然这种粗略的 API 成本可能与企业商业使用的成本具有明显区别,同时这个成本也必然会伴随着大模型的高速发展而不断发生变化。并且,在许多大模型的应用场景中,并非是直接调用原始的大模型 API,而是需要在落地场景下对大模型进行比如 Prompt 调用层面的“微调”,因此针对大模型使用成本的测算将会成为一个突出的问题。

也因此,这篇论文提出了一个期望净成本节约(Expected Net Cost Savings,ENCS)的框架,期望测算各种 LLMs 与不同品牌下大模型部署者节省的成本与花费的成本的综合关系,也正是通过这个 ENCS 框架,作者团队通过一个案例研究发现,使用一些较小的模型,比如 GPT-2 完成推理与响应的任务,其成本节约效果要优于 GPT-3,其核心原因在于尽管损失了一部分“响应质量”,但是却大大降低了其“响应成本”,这表明,目前这些大模型的响应成本对于实际使用的客户而言还是过高,无法真正实现成本的节约。

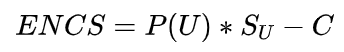

ENCS

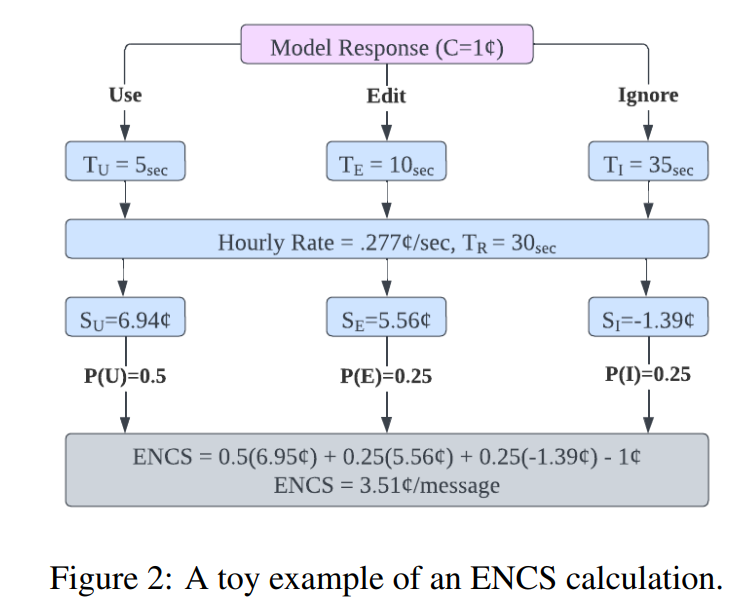

首先来看一下这个期望净成本节约 ENCS 是如何进行测算的,ENCS 的整体测算流程可以从下图中看出,更一般的说,ENCS 测算的是大模型生成的每个响应生效或被使用的概率 P(U) 乘以每个对大模型响应的使用带来的费用节省 SU,减去生成该响应的成本,即:

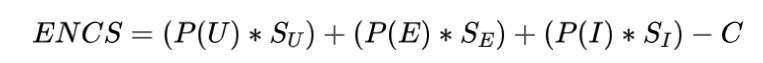

而如果再细化一点,如果对大模型生成的响应不直接使用而是进行编辑或是“忽略”时(忽略一般可能带来负的费用节省),可以将上式修正为:

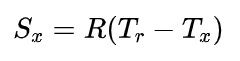

此处的 SU,SE,SI 等均可以从人类客服的每小时费用 R 与人类客服响应时间 Tr 与接受、编辑与忽略响应时所花费的时间进行估计:

一个简单的面对大模型的响应有可能的三种动作接受、编辑与忽略计算 ENCS 值的小例子如下图所示:

案例研究

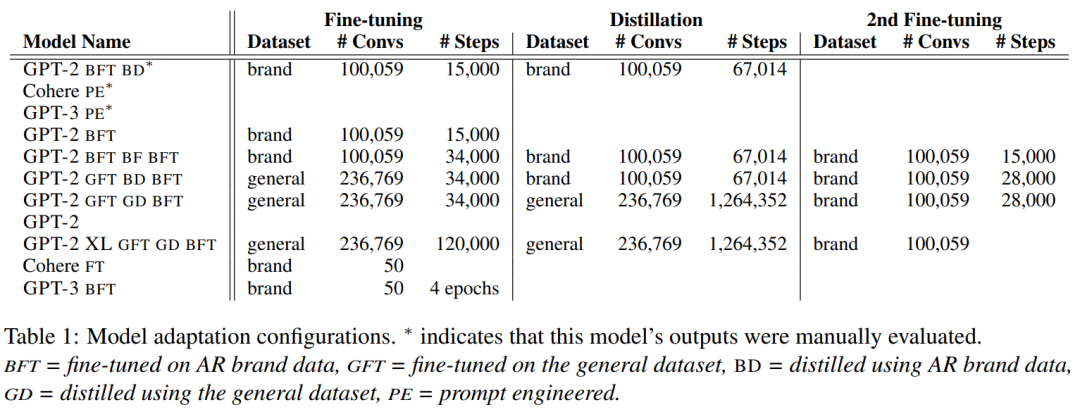

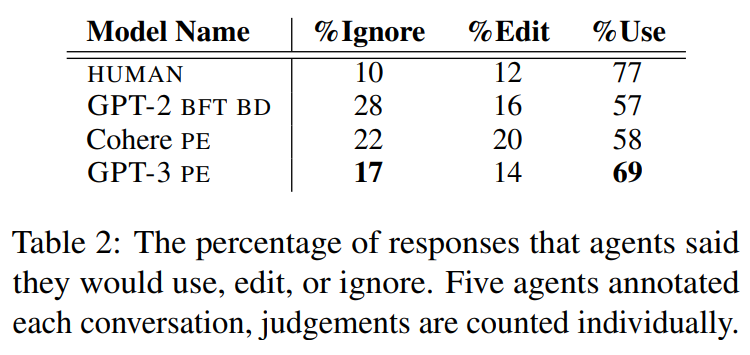

论文针对一家匿名零售商(AR)展开了案例研究,AR 的客户群体主要由在 AR 平台进行买卖的商家与消费者组成,AR 雇佣的专业人类客服会接受专业的培训,可以就不同的客户及各种不同的问题做出专业的回复。AR 共计雇佣约 350 名客服,平均每月发送 100000 条消息,约进行 15000 轮对话。通过该零售商提供的对话数据,论文构建了一个针对 AR 零售商的定制训练数据集(Brand)与一个问题的通用数据(General),采用三种主流的训练策略——Prompt Engineering, Fine-tuning 以及知识蒸馏,对 11 种主流模型进行了训练: 为了获取针对这些“智能客服”回答响应的“有用程度”,论文采用专家打分的方式,对这些模型的每个对话进行了接受、编辑与忽略的评分判断,哪怕对于人工客服,人们也并不总是接受他们的回复,而在智能客服中,基于 GPT-3 的模型表现最佳。

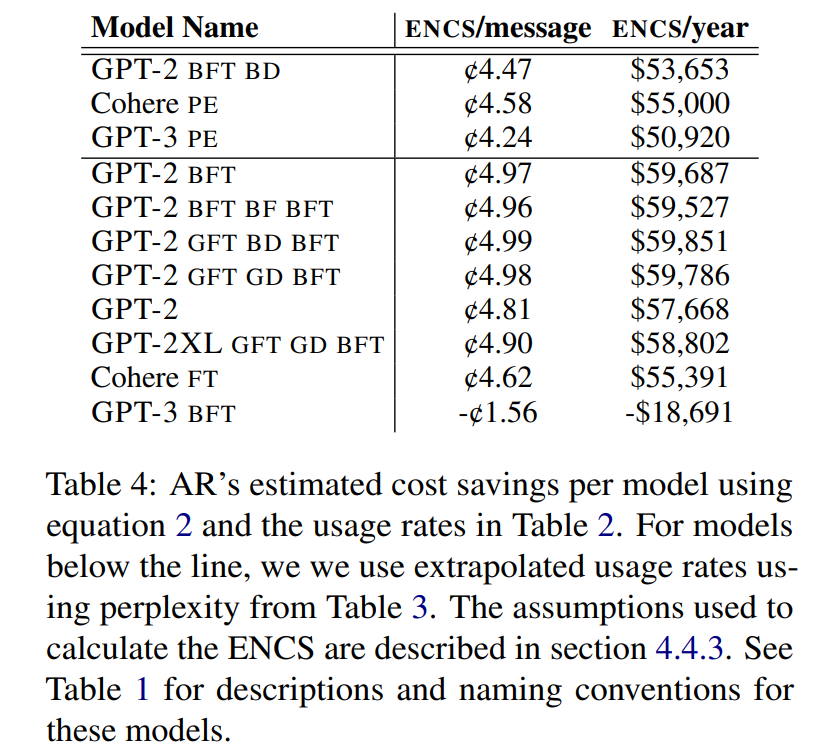

为了获取针对这些“智能客服”回答响应的“有用程度”,论文采用专家打分的方式,对这些模型的每个对话进行了接受、编辑与忽略的评分判断,哪怕对于人工客服,人们也并不总是接受他们的回复,而在智能客服中,基于 GPT-3 的模型表现最佳。 假设一个人工客服每小时的成本为 10$,即 SU=SE=SI=10,每条消息平均需要 30 秒,而使用 LLMs 可以节省 25 秒,GPT-2 的模型生成成本为 0.002 美分,使用 Distilled GPT-2 需要 0.0011 美分,使用 OpenAI 的 API 成本为 1.09 美分,使用微调模型的成本为 6.54 美分,使用 Cohere 的 API 的成本为 0.25 美分,使用微调模型的成本为 0.5 美分。通过使用 ENCS 评估各个模型的“成本节约力度”,结果如下图所示,可以看出具有更高响应质量的 GPT-3 反而会造成负的 ENCS 值,即不仅不会为企业带来成本的节约,甚至还会加重企业成本的负担。

假设一个人工客服每小时的成本为 10$,即 SU=SE=SI=10,每条消息平均需要 30 秒,而使用 LLMs 可以节省 25 秒,GPT-2 的模型生成成本为 0.002 美分,使用 Distilled GPT-2 需要 0.0011 美分,使用 OpenAI 的 API 成本为 1.09 美分,使用微调模型的成本为 6.54 美分,使用 Cohere 的 API 的成本为 0.25 美分,使用微调模型的成本为 0.5 美分。通过使用 ENCS 评估各个模型的“成本节约力度”,结果如下图所示,可以看出具有更高响应质量的 GPT-3 反而会造成负的 ENCS 值,即不仅不会为企业带来成本的节约,甚至还会加重企业成本的负担。 具体而言,AR 零售商使用 GPT-2 BFT BD 单条消息可以节省 4.47 美分,根据 AR 每年的消息数量 1200000 条来计算,使用 GPT-2 模型可以节约 53653 美元,而使用 GPT-3 模型则可能要亏损约 18691 美元。针对计算得到的 ENCS,可以为每个模型计算得到一个盈亏平衡点,如下图所示,当绿色线(劳动力成本节约)与红色线(模型建设投入)相交时达到盈亏平衡,可以得到,对于一个每年消息总量约 500000 条的小企业而言,使用大模型构建智能客服必须快速的降低前期的研发成本,而对于一个每年约有 2000 万条消息的大企业而言,使用大模型构建智能客服才会真正带来成本节约。

具体而言,AR 零售商使用 GPT-2 BFT BD 单条消息可以节省 4.47 美分,根据 AR 每年的消息数量 1200000 条来计算,使用 GPT-2 模型可以节约 53653 美元,而使用 GPT-3 模型则可能要亏损约 18691 美元。针对计算得到的 ENCS,可以为每个模型计算得到一个盈亏平衡点,如下图所示,当绿色线(劳动力成本节约)与红色线(模型建设投入)相交时达到盈亏平衡,可以得到,对于一个每年消息总量约 500000 条的小企业而言,使用大模型构建智能客服必须快速的降低前期的研发成本,而对于一个每年约有 2000 万条消息的大企业而言,使用大模型构建智能客服才会真正带来成本节约。

总结与讨论

这篇论文针对大模型应用在智能客服领域的商业场景进行了细致深入的研究,同时提出了一种评估大模型响应到底带来了多少“成本节约”问题的分析框架 ENCS,给出了一个有点反直觉但是又十分合理的结论——在当下大模型的应用成本仍然较高,只有大企业的大体量带来的规模效应才有可能有动力去完成大模型的实际部署,对于小企业而言大模型的应用成本仍然过高。不过这些分析也主要试图提供一些管理、决策之上的洞见,在更细致的成本测算之上还有许多工作需要去做,当然,最后,这些洞见不仅呼唤着大模型的技术进步为我们带来成本的降低,也呼唤着一些第三方平台企业的出现解决一些小企业用不起大模型的现实问题,且让我们期待一下大模型未来的进步吧!论文题目:

The economic trade-offs of large language models:

A case study

论文链接:

https://arxiv.org/pdf/2306.07402.pdf

扫描二维码添加小助手微信

即可申请加入自然语言处理/Pytorch等技术交流群关于我们

MLNLP 社区是由国内外机器学习与自然语言处理学者联合构建的民间学术社区,目前已经发展为国内外知名的机器学习与自然语言处理社区,旨在促进机器学习,自然语言处理学术界、产业界和广大爱好者之间的进步。社区可以为相关从业者的深造、就业及研究等方面提供开放交流平台。欢迎大家关注和加入我们。