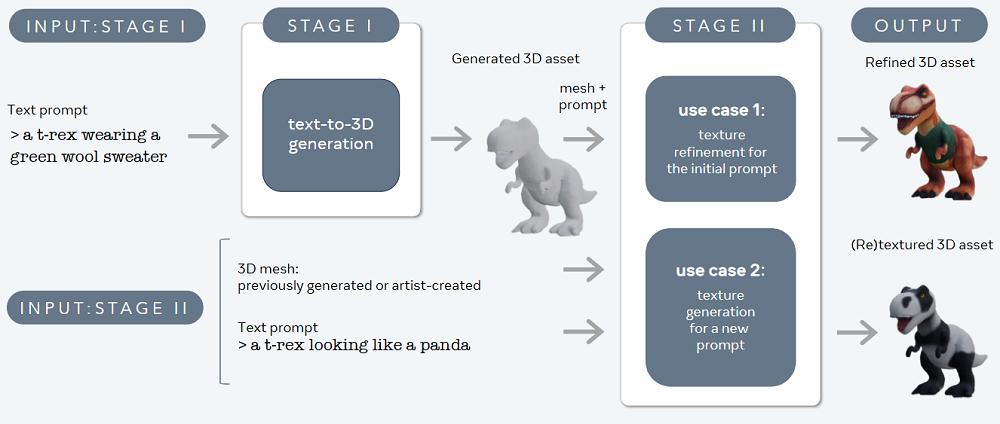

Meta的文生3D模型或将给3D创作生态带来剧变。智东西7月3日消息,今日凌晨,Meta发布了他们的文生3D模型Meta 3D Gen(简称3DGen),给文生3D赛道抛下一颗重磅炸弹。3DGen能在1分钟时间里根据文本提示词快速生成3D资产(指制作3D动画的数字化资源,如3D模型、纹理贴图、材质等),速度是现有其它系统的3-10倍。它还能在同一3D形状的基础上快速调整纹理贴图,帮助创作者实现快速迭代。基于物理的渲染技术(PBR)是3DGen最重要的特点。之前大部分3D生成模型都不具备这一功能,这给AI生成的3D资产的实际应用带来不便。PBR能将3D模型的物理属性融入到3D资产中,让3D模型与模拟的物理世界的互动更为自然,是创建逼真的影像和自然真实的环境的重要技术。支持PBR的3DGen能更好地融入游戏开发者、电影后期制作者的工作流中。Meta还在技术文档中详细介绍了3DGen背后的技术方法。他们采取了两步走的方式实现3D资产生成。一个名为AssetGen的模型被用于生成基础的3D形状和纹理,另一个名为TextureGen的模型专门用于生成质量更高的纹理,优化AssetGen的生成结果。

▲3DGen的演示视频(图源:Meta)

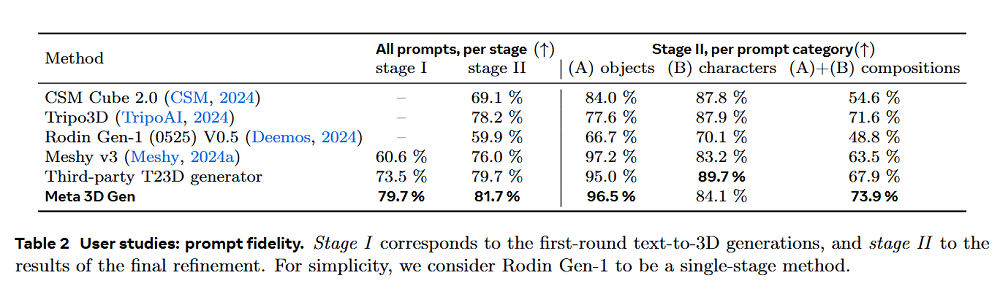

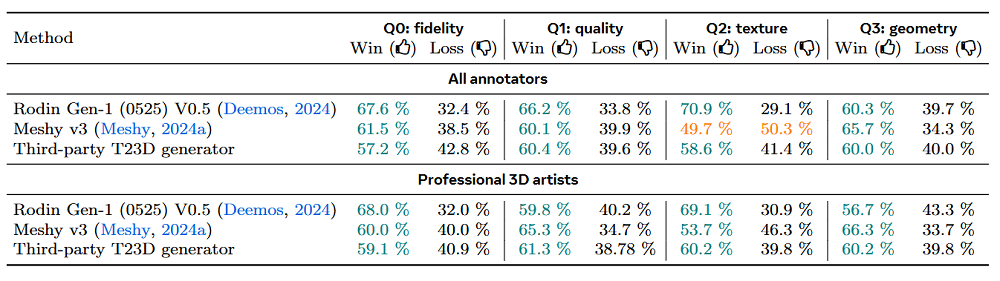

采取这一技术路径的3DGen在Meta进行的测试中获得了专业创作者和普通人的高度评价,在提示词忠实度、纹理质量、几何性质和图像质量上都获得了比大多数3D生成模型更高的得分。

制作3D资产一直是设计和开发电子游戏、VR/AR应用以及电影特效行业耗时最久且最具挑战性的问题之一。Meta本次推出3DGen便是为了给这一问题提供一个可能的解决方案。Meta在技术报告中称,3D资产生成远比图像和视频生成困难。在实际应用中的3D资产要求极高,目前并没有大量现成的3D资产可供训练。供图像和视频模型训练的数据是数以十亿计的,而可用于训练的3D资产的数量要小3-4个数量级。因此,3D生成必须从非3D图像和视频中学习,并学会从2D的观察中推断出3D信息。3DGen支持复杂的文本提示,与其它文生3D方法相比,对文本提示的忠实度较高。Meta称3DGen生成一个3D资产仅需不到1分钟,速度比现有其它系统快3-10倍。在初始生成完成后,3DGen还可根据新提示词给出的需求,在20秒内重新调整原3D资产的纹理。Meta目前并未公开测试这一系统,但他们在社交媒体X上公布了一段3分钟的视频,具体展示了这一模型的生成效果和功能。下方生成结果的提示词是“a pug made out of metal(一只金属的哈巴狗)”。生成结果完全符合提示词内容,画面中这只金属的哈巴狗的3D网格(3D模型的框架)结构符合真实世界中哈巴狗的外貌,纹理清晰度和分辨率也比较理想。

▲3DGen能生成纹理质量较高的3D资产(图源:Meta)

Meta在X上分享的视频中还展示了3DGen的纹理调整功能。这一功能让3DGen按照指定风格改变整个场景中的纹理。在下方的演示视频中,测试人员输入了恐怖片、像素风等提示词,3DGen快速地生成了指定风格的3D纹理。这些纹理被统一地运用到了场景内的所有3D形象上,生成质量较好。

▲3DGen能根据提示词给同一3D网格赋予不同的纹理(图源:Meta)

过去,AI生成的3D资产通常不具备真实的光照和材质属性,从而限制了它们在专业工作流程中的实用性。3DGen系统支持基于物理的渲染(PBR)和人类艺术家3D网格输入,这能让创作者更便捷地将3DGen生成的3D资产融入到自己的工作流中。PBR技术将一些基于物理规律的属性信息到了3D贴图中,如某一特定材质的反照率、粗糙度、金属度、不透明度、折射效果、自发光等。这项技术的运用让计算机不仅能理解3D资产的形状,还能理解3D资产会如何与光线等物理世界的因素产生交互作用,这对创建逼真的影像和自然真实的环境是不可或缺的,还能确保创作过程中的一致性。这项技术目前已经广泛运用于建筑可视化、游戏、VR/AR、电影特效制作等行业,是创作高质量3D资产的重要方式。支持PBR技术的3DGen生成的3D形象不仅在处于静态时拥有较高的质量,也能在3D形象移动时保持极高的真实性。在Meta的宣传视频中,他们输入了“a futuristic robot(未来风的机器人)”这一提示词,并让3D计算机图形技术公司Mixamo完成了这一3D资产的人物动作自动绑定和动画。画面中,机器人在舞动时表面金属的光泽变化十分真实,这便是PBR技术的功劳。

▲动起来的3DGen生成结果(图源:Meta)

3DGen支持人类艺术家创作的3D网格输入,这一功能颇具实用性。在长期的创作过程中,艺术家或者企业已经积累了大量人工制作的3D网格,这些网格的质量一般都会高于AI生成的网格。3DGen可以在人类艺术家制作的3D网格基础上,用AI给网格赋予多样的纹理,在快速生成的同时保持生成结果质量的相对稳定。

▲无纹理3D网格(图源:Meta)

在输入“a majestic monarch butterfy(一只威严的帝王蝶)”和“a magical butterfly, arcane sigils on its wings, sparkling(一只神秘的蝴蝶,翅膀上有神秘的符文,闪闪发光)”这两个提示词后,3DGen就能让这只无纹理的蝴蝶变得栩栩如生。

▲基于无纹理3D网格生成的3D资产(图源:Meta)

Meta介绍了3DGen的技术原理。他们将3D生成分为两个步骤,并分别使用了两个组件,一个用于文本到3D生成,另一个用于文本到纹理生成,这一方法显著提高了3D生成的效果。用于文本到3D生成的模型名为Meta 3D AssetGen(简称AssetGen),它主要用于创建初始的3D资产,也就是带有较为粗糙的纹理和PBR材质贴图的3D网格(类似上文展示的无纹理蝴蝶)。这一过程耗时仅为30秒。用于文本到纹理生成的模型名为Meta 3D TextureGen(简称TextureGen),它能为这一3D资产生成质量更高的纹理和PBR贴图,或是创建不同风格的纹理。这一过程仅需20秒便可完成。

▲3DGen的技术原理(图源:Meta)

AssetGen和TextureGen使3DGen可以融合图像、3D形状和外观以及UV纹理贴图这3个表现形式。AssetGen为TextureGen完成了较为复杂的3D形状生成工作,TextureGen是针对UV纹理贴图进行优化的模型。TextureGen的训练数据是人类艺术家的UV纹理贴图,这些高质量的训练数据显著提升了模型表现,因此能生成比AssetGen更为真实的纹理。可以说,AssetGen和TextureGen是两个优势互补的模型。此外,Meta称这一3D资产生成的全过程都建立在Meta文生图模型Emu之上。为评估3DGen的效果,Meta邀请了专业创作者和普通人参与了他们的研究,对提示词忠实度和视觉质量进行打分。Meta选取了多个目前可以访问的3D生成模型作为比较对象。3DGen在3D形状生成和纹理生成这两个阶段的提示词忠实度评分都高于其它模型。在按照生成对象类型分类的打分结果中,3DGen在物体和组合场景中的忠实度排名第一,而在人物的忠实度上表现略逊于其它模型。

▲3DGen提示词忠实度得分(图源:Meta)

生成质量方面,Meta选取了表现较好的3款第三方模型,让专业创作者和普通人一同评价模型生成效果。结果显示,在忠实度、图像质量、纹理质量和几何性质上,3DGen都具有压倒性的优势。

▲3DGen与其它模型比较生成质量(图源:Meta)

Meta官宣3DGen之后,网友立刻想到了许多可能的应用场景。有不少网友认为将生成的3D资产3D打印出来会是不错的尝试,也有网友认为这将彻底改变游戏开发行业的规则。

▲网友评价(图源:X)

AI 3D生成技术的快速发展对实现3D建模行业的技术进阶有重大意义。人工3D建模费时费力,在游戏和影视作品中运用3D形象在过去是属于少数大型公司的特权,AI 3D生成技术能简化3D建模流程,缩短3D建模时间。目前,已有不少行业使用了3D生成技术。美国3D生成创企Meshy AI发布的免费3D模型Meshy目前已被大量独立游戏开发者使用,让几个人的小团队也能开发出真实度极高的游戏。然而,这项技术的出现也引发了人们对3D建模这一职业未来的疑问。虽然3DGen可能会提高3D艺术家的生产力,但它也可能减少对某些类型的常规3D资产创建的需求。或许在未来,创作者需要更关注那些AI难以复制的创意方向,或是从事更为复杂的定制工作。(本文系网易新闻•网易号特色内容激励计划签约账号【智东西】原创内容,未经账号授权,禁止随意转载。