“解锁生成式AI的更多应用,首先需要解决成本问题。”2023 WAIC上,高通展示了这样一项技术:将生成式AI模型 Stable Diffusion放在搭载了第二代骁龙8的移动平台的手机上运行,在15秒内执行了20步推理,并生成了一张512x512像素的图像。

从实际演示效果来看,所生成图像的效果与云端处理水平相差无几,用户输入文本也完全不受限制。Stable Diffusion作为从文本到图像的生成式AI模型,碍于超过10亿的巨大参数,此前主要限于在云端运行,这一次高通却使其从云端转移到终端,向外界证明其对AI未来的预判:AI处理需要云端与终端协同处理才能实现AI规模化的扩展并发挥最大潜能,端云结合的混合AI是AI的未来。AI早已无处不在,智能手机、PC、XR头显、智能汽车等众多终端设备已经具备强大的AI能力,例如完成拍摄之后直接在终端完成图像处理。过去半年多火爆的生成式AI,意味着AI变革时刻的到来,也刺激了AI市场的发展。根据瑞银2023年2月份估计显示,生成式AI的市场规模将达到1万亿美元。市场规模巨大的背后,训练AI模型的成本也巨大。拥有数十亿参数的众多生成式AI模型对基础设施提出了极高的要求,无论是AI模型优化参数的AI训练,还是执行该模型的推理,至今都受限于大型复杂模型而需要在云端部署。在云端进行推理的成本已经很昂贵,模型的推理成本又将随着日活用户数量及其使用频率的增加而增加,因此无论规模大小的公司都将负担昂贵的运营成本。例如,对于基于生成式AI的搜索引擎企业而言,用户每一次的搜索查询成本都是传统搜索方法的10倍,假设每天有超过100亿次的搜索查询,企业每年的增量成本也将达到数十亿美元。“混合AI能够解决上述问题,正如传统计算从大型主机和瘦客户端演变为当前云端和PC、智能手机等边缘终端相结合的模式”,高通公司发布的白皮书《混合AI是AI的未来》阐释了这一观点。高通产品管理高级副总裁兼AI负责人Ziad Asghar也表示:“为实现生成式AI的规模化扩展,AI处理的重心正向边缘转移。混合AI架构在云端和边缘终端之间分配并协同处理AI工作负载,能够实现更强大,更高效且高度优化的AI。”

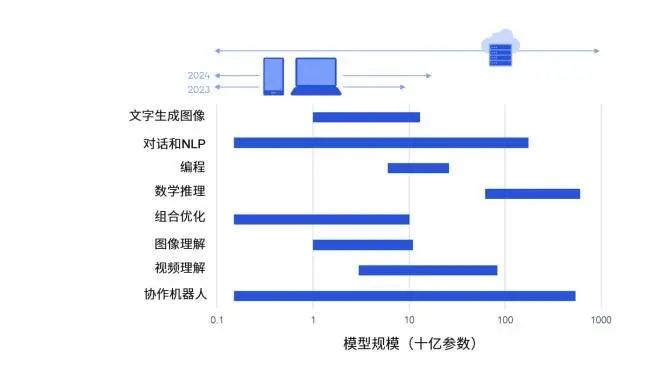

数量可观的生成式 AI 模型可从云端分流到终端上运行混合AI能够将一些处理从云端转移到边缘终端,因此能够适当减轻云基础设施的压力并减少支出。例如开发者基于完全在终端运行的Stable Diffusion创建应用程序,对于生成的每个图像承担更低的查询成本,或者完全没有成本。除了节省成本,混合AI架构还具有能耗、性能、隐私、安全和个性化方面的优势。例如边缘终端总是能以很低的能耗运行生成式AI模型,以及在生成式AI对云的需求爆满而需要排队时,向边缘终端转移计算负载就能避免这一现象发展,某些时候即便是在用户无连接的情况下,也正常运行生成式AI应用。在隐私安全方面,终端侧AI还能保证查询记录和个人信息完全保留在终端,打消企业和个人使用生成式AI的安全顾虑。甚至还能借助数字助手对用户的表情和喜好进行个性化分析,提供更贴合每个个体的用户体验。混合AI架构之所以能够实现AI的规模化扩展并发挥其最大潜能,至关重要的一点是其能够根据模型和查询需求的复杂度等因素,选择不同方式在云端和终端侧之间分配处理负载。

如果模型大小、提示和生成长度小于某个限定值,并且能够提供可接受的精确度,推理即可完全在终端侧进行。如果是更复杂的任务,模型则可以跨云端和终端运行。混合AI还能支持模型在终端和云端同时运行,也就是在终端侧运行轻量版模型的同时,在云端并行处理完整模型的多个标记(token),并在需要时更正终端的处理结果。由于计算负载的分配方式多样,混合AI架构几乎适用于所有生成式AI应用和终端领域,但真正实现终端和云端的高效配合,以及不同工作负载的合理分配,并不是一件容易的事情,在AI领域深耕和积累十多年的高通深有体会。一方面需要具备一定的算法和模型开发技术能力,能够对AI模型进行压缩。高通在很早的时候就已经在研究生成式对抗网络(GAN)和变分自编码器(VAE),利用VAE技术,高通创建了更好的视频和语音编解码器,能够将模型规模控制在1亿参数以下,得以在终端运行。

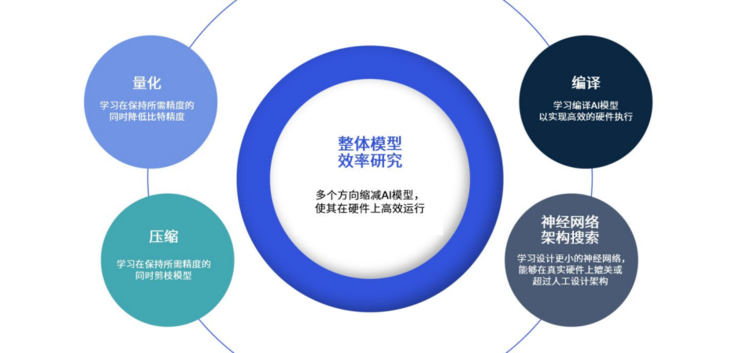

缩减之后的AI模型,只有保证足够的精度才具备实际用处。高通针对量化、压缩、编译、神经网络架构搜索多个领域做出研究,例如在量化方面,高通将FP32模型量化压缩到INT4模型,实现64内存和计算能效提升,高通的实现数据表明,在借助高通的量化感知训练后,不少生成式AI模型可以量化至INT4模型,与INT8相比,性能提升约90%,能效提升大约60%。另一方面,足够强大的终端处理能力是实现混合AI的关键,这就需要在AI相关硬件、软件、生态等诸多方面拥有产品技术储备,高通也已经在这些方面全方位布局。硬件层面,高通所推出的高通AI引擎为智能手机提供支撑,实现的能效是竞品的两倍。具体而言,高通AI引擎采用异构计算架构,包括Hexagon处理器,Adreno GPU 和Kryo CPU都对终端的AI应用进行针对性优化。Hexagon处理器作为高通AI引擎最为关键的部分,自2007年首次推出,迄今为止历经数次迭代,最新的Hexagon处理器包含标量、向量和张量处理器,能够很好地与神经网络模型的不同部分实现匹配,Hexagon还配备了专门的供电系统,方便按照工作负载适配功率,从而提升系统的能效比。另外,Hexagon处理器支持微切片推理和INT4硬件加速,在AI处理方面能够在占用更低内存和更低功耗的情况下,实现更高的性能。要让高通AI引擎发挥作用,软件能力的构建自然不容忽视。高通AI软件栈不仅支持TensorFlow、PyTorch、ONNX和Keras等主流AI框架以及TensorFlowLite、TensorFlow Lite Micro和ONNX Runtime等runtime,还集成了高通神经网络处理SDK,面向Android、Linux和Windows不同版本,开发库和服务支持最新编程语言、虚拟平台和编译器。这意味着,基于高通AI软件栈,AI开发者只需要创建一次AI模型,就能实现不同产品的部署。另外高通AI软件栈集成的高通AI Studio,支持从模型设计到优化、部署和分析的完整工作流,将提供的全部工具都集成到一个图形用户界面,为开发者提供可视化的工具,能够实时查看模型开发进度,优化开发体验。有了硬核技术支撑的混合AI,如何赋能生成式AI给客户带来新的体验?在智能手机领域,每日百亿量级的搜索量被满足,对话功能将不断改进和强大, 精准的终端侧用户画像与能够理解文字、语音、图像、视频等任何其他输入模态的大语言模型相结合,智能手机即将成为用户真正的数字助手,与用户自然沟通,提供准确又贴切的回答。笔记本电脑和PC等原先被视为生产工具的设备,正在向生产力方向演进,例如Microsoft Office 365,可以利用大语言模型的功能和Microsoft Graph 与 Microsoft 365 应用中的用户数据,化身为Office工作者的得力助手,编写文档或演示文稿,又或者是分析数据和会议协作,承担起一部分工作量。在AI驱动的汽车座舱中,数字助手可以访问用户的个人数据,根据驾乘人员的个人习惯,包括常用的出行路线以及天气情况规划导航路线,对驾乘人员进行识别,提供定制化的音乐和播客体验。生成式AI能够为XR提供很多令人兴奋的前景,例如下一代AI渲染工具将赋能内容创作者使用如文本、语音、图像或视频等各种类型的提示,生成3D物体和场景,最终创造出完整的虚拟世界。此外,内容创作者还将利用文本生成文本的大语言模型,让能够发出声音并表达情绪的虚拟化身生成类人对话,带来完全沉浸式的内容体验。

生成式 AI 基于简单提示创造的沉浸式 3D 虚拟世界白皮书《混合AI是AI的未来》指出,Stable Diffusion等文本生成图像类的模型很快将赋能内容创作者在3D物体上生成逼真的纹理,并预计这些功能将在一年内在智能手机上实现,并延伸至XR终端。而首批文本生成3D和图像生成3D类的模型将在未来几年实现边缘侧部署。无数物联网细分领域也将进一步从生成式AI中受益,例如零售行业,商店经理可以根据即将发生的事件预测非周期性的促销机会,并做好相应准备;能源行业,运营团队可以创建极端负荷场景并预测电力需求,以及特殊情况下潜在的电网故障,以便于更高效的管理资源,避免断电等等。如果没有建立繁荣的生态作为支撑,这些生成式AI能够带来的用户体验升级也只不过空中楼阁,但高通在终端市场数十亿量级的覆盖和连接,让这一切看起来都切实可行。据市场调研机构Counterpoint数据统计,搭载骁龙和高通平台的已上市用户终端数量已经达到数十亿台,且每年都有数亿台的新终端在进入市场。结合高通在生成式AI的研究积累,这些美好愿景已经在路上,AI 未来已来。