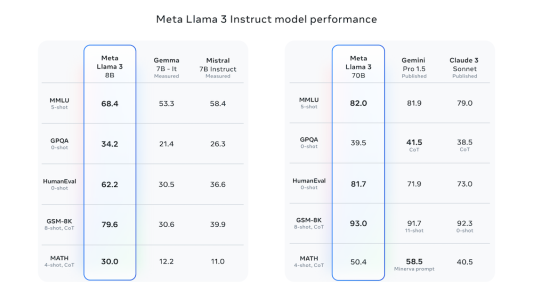

智东西4月19日消息,昨夜,Meta推出迄今为止能力最强的开源大模型Llama 3系列,发布8B和70B两个版本。Llama 3在一众榜单中取得开源SOTA(当前最优效果)。Llama 3 8B在MMLU、GPQA、HumanEval、GSM-8K等多项基准上超过谷歌Gemma 7B和Mistral 7B Instruct。

▲Llama 3与Gemma、Mistral、Gemini、Claude 3的模型性能对比表

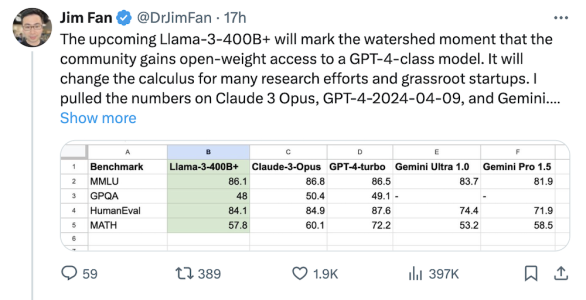

Llama 3 70B也在MMLU、HumanEval、GSM-8K等基准上超越了闭源的谷歌Gemini Pro 1.5、Claude 3 Sonnet。Llama 3系列最大模型规模将超过4000亿参数,英伟达科学家Jim Fan认为,这一版本未来的推出将意味开源社区的一个分水岭,开源模型将一举翻越GPT-4这一高峰。

▲Jim Fan对Llama 3表示赞叹

Llama 3模型基于超过15T个token的公开数据预训练,其中数据量是Llama 2的七倍,代码量也增至四倍。此外,Llama 3的训练效率比Llama 2提升了三倍。同日,Meta CEO扎克伯格宣布基于Llama 3模型,Meta的AI助手现在已经覆盖Instagram、WhatsApp、Facebook等全系应用,并单独开启了网站。Llama 3一经发布,AWS、微软Azure、谷歌云、百度智能云,以及Hugging Face、IBM WatsonX、英伟达NIM和Snowflake陆续宣布其平台上线Llama 3,支持Llama 3训练、部署和推理运行。Llama 3官方地址:

https://llama.meta.com/llama-downloads/

GitHub地址:

https://github.com/meta-llama/

Meta AI地址:https://www.meta.ai/

Meta表示,他们的新一代模型Llama 3将与当前最好的闭源模型相媲美。他们希望通过解决开发者的反馈意见来提高Llama 3的实用性,并继续在大语言模型的使用和部署方面发挥领导作用。Meta秉承了开源精神,使社区能够在模型开发阶段就能够使用它们。今天发布的模型是Llama 3系列的第一个,未来,Meta计划使Llama 3成为多语言、多模态、具有更长上下文的模型。在技术上,Llama 3的8B和70B模型实现了对Llama 2的显著超越,代表了当前LLM的最高水平。通过优化预训练和微调过程,Meta的模型在8B和70B参数规模上表现最佳。后期训练的改进减少了误拒率,增强了响应的一致性和多样性,使得Llama 3在推理、代码生成和指令遵循等任务上更加出色,同时提升了用户对其行为和输出的控制灵活性。Llama 3的开发过程中,Meta不仅关注了模型在标准基准测试上的表现,还试图优化其在实际场景中的性能。为此,Meta开发了一个新的和高质量的人类评估数据集。该评估集包含1800个提示,涵盖12种关键用例,分别为:征求建议、头脑风暴、分类、封闭式问题解答、编码、创意写作、提取、人物角色、开放式问题解答、推理、改写和总结。为了防止模型在这个评估集上意外地过度拟合,即使是Meta的制作团队也无法访问这个评估集。

▲真人评估结果表

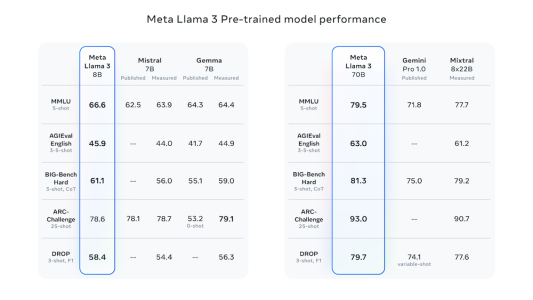

根据他们的评估集,标注者的偏好排名突显了他们70B参数的指令跟随模型在真实场景中优于竞争对手模型。另外,他们的预训练模型也为这些规模的LLM模型确立了一个新的技术水平。

▲Llama 3预训练模型数据对比表

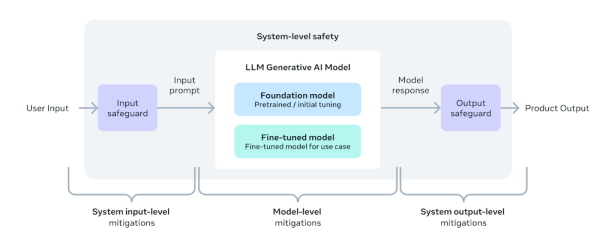

为了开发一个优秀的语言模型,Meta认为创新、规模化和简化优化是至关重要的。在Llama 3项目中,他们专注于四个关键因素:模型架构、预训练数据、扩大预训练规模和指令微调。1. 模型架构:采用128k token的分词器,注意力机制提高推理效率根据设计理念,Meta在Llama 3选择了一个相对标准的仅解码器的Transformer架构,并在Llama 2的基础上做了几项关键改进。Llama 3使用一个拥有128k个token的分词器,能够更有效地编码语言,这大大提高了模型的性能。为了提高Llama 3模型的推理效率,Meta在8B和70B大小的模型中都采用了注意力机制。Meta还在8192个token的序列上对模型进行了训练,并使用掩码来确保自注意力机制不会跨越文档边界。2. 训练数据:超15T个token数据预训练,达Llama 2七倍Meta投资了大量资金来构建Llama 3的高质量训练数据集。该模型基于超过15万亿个token的公开数据预训练,其中数据量是Llama 2的七倍,代码量也增至四倍。Llama 3还特别集成了超过5%的多语言数据,覆盖30多种语言,尽管这些语言的表现尚未与英语持平。为保证训练质量,Meta设计了数据过滤流程,采用启发式过滤器、不安全内容过滤器、语义重复数据删除方法和文本分类器等过滤管道,筛选优质数据。此外,Llama 2的文本分类器依旧被用于生成驱动Llama 3的高质量数据集。Meta通过实验确定了最佳数据组合,以优化Llama 3在各种任务上的表现,如问答、STEM(科学、技术、工程、数学)领域、编程和历史知识等。3. 预训练规模:性能始终呈对数线性增长,Llama 3训练效率比Llama 2提升三倍Meta在Llama 3模型的预训练上投入巨大,开发了详细的尺度定律来指导最佳数据组合和训练计算的使用。这使得他们能预测模型性能,并确保模型在多样的应用场景中表现出色。在扩展过程中,Meta发现即使在模型训练了两个数量级的数据之后,模型性能仍然会继续提高。Llama 3的8B和70B参数模型在经过多达15T个token的训练后,其性能仍呈对数线性增长。为训练最大的Llama 3模型,Meta采用了数据、模型和管道并行技术。最高效的实现方式在同时使用16000个GPU进行训练时,每个GPU的计算利用率超过了400TFLOPS。他们还开发了新训练堆栈提高GPU运行时间,增强了硬件可靠性和数据损坏检测,创造了新的存储系统以降低检查点和回滚成本。这些创新使Llama 3的训练效率比Llama 2提升了三倍。4. 指令微调:后期训练四种相结合,模型学会如何去选择为了充分发挥预训练模型在聊天应用中的潜力,他们创新了对模型进行微调的方法。他们的后期训练方法是将监督微调、拒绝采样、近端策略优化和直接策略优化结合起来。在微调过程中使用的提示质量以及在策略优化中使用的偏好排名对模型的性能有着很大的影响。通过精心策划的数据和多轮质量保证,他们取得了模型质量的一些重大改进。通过使用近端策略优化和直接策略优化从偏好排名中学习,这两种方法极大地提高了Llama 3在推理和编码任务上的性能。他们发现,如果你向一个模型提出一个它难以回答的推理问题,那么该模型有时会产生正确的推理路径:模型知道如何生成正确的答案,但它不知道如何选择它。通过对偏好排名进行训练,使模型学会了如何进行选择。5. Llama 3的额外构建:引入新的信任和安全工具,使用torchtune开发 通过这个版本的发布,他们提供了新的信任和安全工具,包括Llama Guard 2和Cybersec Eval 2的更新组件,并引入Code Shield,这是一种用于推理时过滤LLM产生的不安全代码的保护装置。他们用torchtune开发了Llama 3。torchtune是一个新的PyTorch原生库,用于轻松编写、微调和实验LLM。

Meta采用了一种新的、系统级的方法来开发和部署Llama。他们将Llama模型视为更广泛系统的一部分,该系统让开发人员掌握主导地位。Llama模型将作为系统的基础部分,开发人员将根据其独特的最终目标设计该系统。

▲Llama 3预训练模型数据对比表

他们的“红队方法”利用人类专家和自动化方法生成对抗性提示,试图引发问题性的响应。例如,他们进行全面测试以评估与化学、生物、网络安全和其他风险领域相关的滥用风险。所有这些努力都是迭代的,并用于指导发布的模型的安全微调。Llama Guard模型旨在确保及时响应安全,它可根据应用需求进行微调。其中,新的Llama Guard 2使用MLCommons分类体系,以支持行业标准的制定;CyberSecEval 2在其前身的基础上进行了扩展,添加了更多度量指标,以评估LLM的安全性;Code Shield可以在推断时过滤不安全代码,以减轻相关风险。此外,Meta更新了其《负责任使用指南》,他们建议开发人员按照应用程序的内容指南检查和过滤所有输入和输出。同时,鼓励开发人员考虑使用云服务提供商提供的内容审核API和其他工具来进行负责任的部署。Llama 3将很快在所有主要平台上推出,包括云服务提供商和模型API提供商。更新的分词器效能和新增的分组查询注意力(GQA)功能使得Llama 3保持了与Llama 2相当的推理效率。Llama Recipes提供了各种用例示例,从微调涵盖到部署再到模型评估。Llama 3的8B和70B模型是Meta未来计划的开始,他们成将推出更多功能强大的模型,包括多模态能力、多语言对话能力等,同时,他们也会发布详细的研究论文。令人期待的是,Meta最大的模型参数超过了400B。虽然这些模型仍在训练中,Meta团队表示对它的发展感到非常兴奋。

▲仍在训练的400B参数的Llama 3模型

Meta将最新的模型集成到Meta AI中,并将其推广到更多国家的应用程序中。用户可以在Facebook、Instagram、WhatsApp、Messenger和Web上使用Meta AI,从而实现各种目标。同时,Meta表示未来即将推出一个基于Llama 3的多模态Meta AI智能眼镜。

Meta的Llama 3模型在大语言模型领域取得了显著的技术进步,特别是在预训练数据的规模和质量上。该模型通过优化训练和评估,提升了多任务性能,并注重安全性和多语言支持。Llama开源系列对AIGC的贡献,以及对高效训练技术和未来模型的规划,预示着其在AI行业的长期影响力。与此同时,Meta强调负责任的AI实践,预示了其对社会责任的承诺。

(本文系网易新闻•网易号特色内容激励计划签约账号【智东西】原创内容,未经账号授权,禁止随意转载。)