出品 | OSC开源社区(ID:oschina2013)先来看一段最近在网上非常火的视频:

视频展示了一项最新的 AI 技术——用户只需拖拽图片中的像素点和方向即可实现精确控制,从而对图片进行局部微调。

看到如此“神一般的操作”,国外科技大V直言 Photoshop “寄了”:

这项称作「DragGAN」的技术与最近火热的大语言模型无关,它是来自 Google 的研究人员与 Max Planck 信息学研究所和麻省理工学院 CSAIL 一起打造的新模型。从名字来看 (Drag Your GAN),其本质上是为各种 GAN 开发的一种交互式图像操作方法。

GAN 是生成对抗网络 (Generative Adversarial Networks) 的缩写,是深度学习中一种重要的方法。GAN 由两个神经网络组成,分别是生成器 (Generator) 和判别器 (Discriminator)。这两个网络相互对抗,同时也在相互学习,因此得名"对抗"。在一个典型的 GAN 训练过程中,生成器的目标是生成尽可能真实的假样本,以欺骗判别器,而判别器的目标是识别出这些由生成器生成的假样本。这个过程类似于警察与伪钞制作者的博弈:伪钞制作者尽可能地制造真实的伪钞,而警察则尽可能地去识别这些伪钞。这个对抗过程会导致生成器生成的样本越来越逼真,判别器对真假样本的判别能力也越来越强。这种模型已经在很多领域取得了成功,包括图像生成、超分辨率、图像修复等。可以看到,这款基于 DragGAN 的工具能够非常直观地实现图像编辑,用户只需要控制图像中的像素点和方向,就可以让图像变形。如下面的 GIF 图所示。一句话总结:DragGAN 可以让用户快速调整照片主体的位置、姿态、表情、大小和角度等。

如今文本转图像的工具已经非常多了,但你输入的提示词跟你最终想要的图像并不一定能够完全一致,可能在大小、角度等各个方面存在一些偏差。DragGAN 真正有趣的地方在于,它不仅可以生成逼真的图像,还可以灵活和精确地控制图像。与之前的许多方法相比,DragGAN 的研究人员通过不依赖领域特定的建模或辅助网络,提出了一个通用框架。为了实现这一点,DragGAN 包含两个主要组成部分:基于特征的运动监督,引导手柄点向目标位置移动;

以及一种新的点追踪方法,利用判别生成器特征来定位手柄点的位置。

DragGAN 模型提供了一个明确的解决方案。界面与传统图像变形的方法相同,但与简单地模糊和涂抹现有像素不同,该模型的变形在 GAN 学习的图像流形上进行,会重新生成对象。

正如研究人员所写:“我们的方法可以产生遮挡内容的“幻象”,比如狮子嘴里的牙齿,也可以根据对象的刚性进行变形,比如马腿的弯曲。”

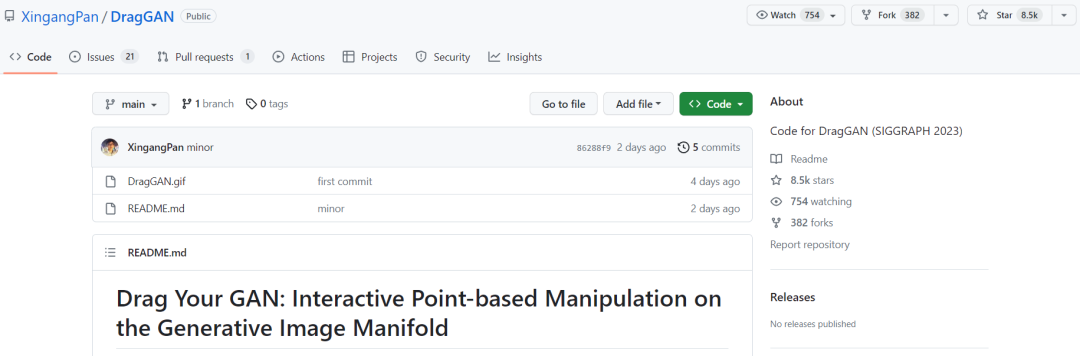

研究人员表示,他们的方法在基于 GAN 的操作中优于 SOTA,并为图像编辑开辟了新方向。在接下来的几个月里,他们希望将基于点的编辑扩展到 3D 生成模型。据称该项目的代码将在 6 月开源,目前其在 GitHub 上的 star 数量已超过 8K。

https://vcai.mpi-inf.mpg.de/projects/DragGAN/

https://vcai.mpi-inf.mpg.de/projects/DragGAN/data/paper.pdf

https://github.com/XingangPan/DragGAN

2023 年 5 月 27-28 日,GOTC 2023 全球开源技术峰会将在上海张江科学会堂隆重举行。为期 2 天的开源行业盛会,将以行业展览、主题发言、特别论坛、分论坛、快闪演讲的形式来诠释此次大会主题 ——“Open Source, Into the Future”。与会者将一起探讨元宇宙、3D 与游戏、eBPF、Web3.0、区块链等热门技术主题,以及 OSPO、汽车软件、AIGC、开源教育培训、云原生等热门话题,探讨开源未来,助力开源发展。长按识别下方二维码立即查看 GOTC 2023 详情/报名。