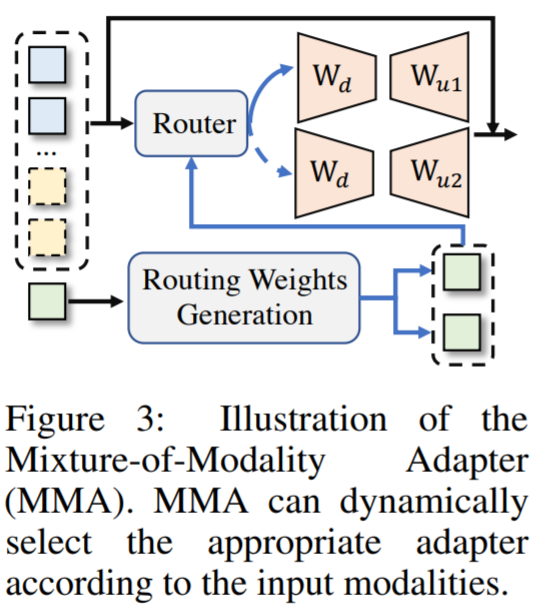

本文提出了一种新颖且经济实惠的解决方案,用于有效地将 LLMs 适应到 VL(视觉语言)任务中,称为 MMA。MMA 不使用大型神经网络来连接图像编码器和 LLM,而是采用轻量级模块,即适配器,来弥合 LLMs 和 VL 任务之间的差距,同时也实现了图像模型和语言模型的联合优化。同时,MMA 还配备了一种路由算法,可以帮助 LLM 在不损害其自然语言理解能力的情况下,在单模态和多模态指令之间实现自动切换。

最近几个月,ChatGPT 等一系列大型语言模型(LLM)相继出现,随之而来的是算力紧缺日益严重。虽然人人都想打造专属于自己的大模型,但是能负担得起上亿参数模型训练的机构却寥寥无几。在快速发展的人工智能领域,以高效和有效的方式使用大型语言模型正变得越来越重要。此前,Meta 开源了羊驼(LLaMA)系列模型,之后在此基础上,研究者纷纷二创推出自己的羊驼模型。近日,来自厦门大学的研究者提出了一种新颖且有效的视觉 - 语言指令调优解决方案:MMA(Mixture-of-Modality Adaptation),并将其应用于 LLaMA 系列模型上,得到 LaVIN 模型。LaVIN 只有 3~5M 的训练参数, 仅需 1.4 小时即可在 ScienceQA 数据集上进行微调。近年来,大型语言模型(LLM)不断推动着自然语言理解的上限,其参数规模和预训练数据规模也在不断增加。指令调优(instruction tuning)技术的引入使得 LLM 能够进行类似人类的对话交流,完成各种自然语言处理(NLP)任务,从而使人工智能逐渐接近通用人工智能,如 GPT-3.5 。AI 发展的下一个里程碑式进展通常被认为是将这些 LLM 扩展到多模态,例如视觉 - 语言(VL)学习,这样一来 LLM 可以适用于更多真实世界场景,而这一目标 GPT-4 已经实现了,其采用大规模的视觉 - 语言语料库来直接训练多模态 GPT。然而,GPT-4 的训练机制非常昂贵,近期的研究方向仍然致力于高效的 LLM VL 多模态适应。如图 1 所示,现有的 LLM 多模态解决方案大致分为两个类别,即专家系统和模块化训练。在专家系统解决方案中,LLM 通常充当管理者的角色,解释不同的自然语言指令,然后调用相应的视觉模型来处理输入图像,例如图像字幕生成、视觉问答或文本到图像生成。这种解决方案的优点在于它不需要重新训练 LLM,并且可以充分利用现有的视觉模型。然而,LLM 和各种视觉模型在计算和参数方面仍然存在显著冗余,导致内存占用过大。同时,LLM 和视觉模型的联合优化仍然是一个具有挑战性的问题。在这种情况下,对 LLM 的模块化训练引起了越来越多的关注。如图 1 为模块化训练范式,这时需要 LLM 部署一个额外的「neck branch」来连接视觉编码器,然后在对大量的图像 - 文本对进行跨模态对齐的预训练。之后,通过视觉 - 语言指令对「neck branch」和 LLM 进行联合微调。尽管这种方法有效,但所需的视觉 - 语言预训练对于 LLM 的快速适应仍然代价高昂。比如,BLIP2 的预训练需要耗费超过 100 个 GPU 小时来处理 1.29 亿个图像 - 文本对。又比如,LLaVA-13B 在视觉 - 语言指令调优期间需要微调整个 LLM,从而导致训练时间和中间存储开销显著增加。本文提出了一种新颖且有效的视觉 - 语言指令调优解决方案,称为混合模态适应 (Mixture-of-Modality Adaptation,MMA)。与现有的模块化训练方案不同,MMA 是一种端到端的优化机制。通过使用轻量级适配器(adapter)连接图像编码器和 LLM,MMA 可以通过少量参数联合优化整个多模态 LLM。与现有解决方案相比,MMA 节省了数千倍的存储开销。- 论文地址:https://arxiv.org/pdf/2305.15023.pdf

- 项目地址:https://github.com/luogen1996/LaVIN

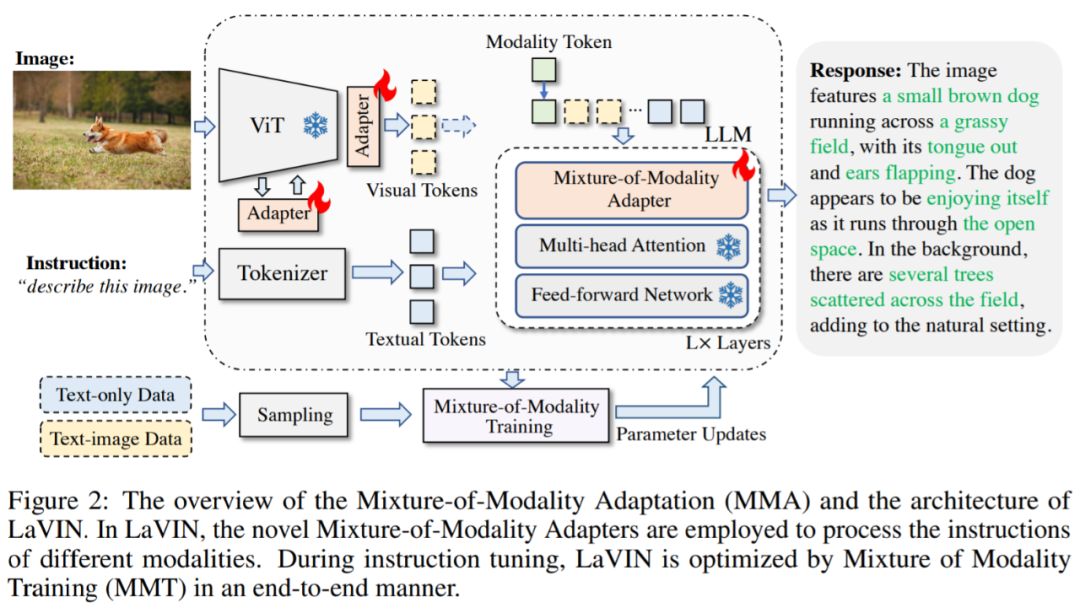

为了在纯文本指令和图像文本指令之间快速切换,MMA 为插入的适配器配备了路由方案,可以为不同模态的输入动态选择合适的适配路径,从而很好地保留 LLM 的 NLP 能力。为了验证 MMA,该研究将其应用于 Meta 最近提出的 LLaMA 系列模型上,并将二者结合之后的大型视觉 - 语言指令模型称为 LaVIN。在 MMA 的帮助下,LaVIN 可以在 VL 任务上实现低成本且快速的适应,而无需额外的大规模预训练。为了验证 LaVIN 的性能,该研究首先在 ScienceQA 数据集上进行了定量实验。实验结果表明,LaVIN 可实现与先进多模态 LLM(例如 LLaVA )相当的性能,同时减少高达 71.4% 的训练时间和 99.9% 的存储成本。特别地,使用 8 个 A100 GPU 在 ScienceQA 上微调 LaVIN 仅需 1.4 小时,并且仅需更新 3.8M 参数。此外,该研究还通过调整 52k 纯文本指令和 152k 文本 - 图像对,将 LaVIN 扩展为多模态聊天机器人。定性实验表明,LaVIN 可以准确地执行各种人类指令(例如编码、解数学题等等),同时产生比现有多模态聊天机器人更好的视觉 - 语言理解。MMA 架构如图 2 所示,其包括两个新设计,即 Mixture-of-Modality Adapter (MM-Adapter)和 Mixture-of-Modality Training (MMT)。具体而言,MM-Adapter 通过轻量级适配器将 LLM 扩展为具有多模态的能力,同时还能实现单模态和多模态指令之间的自动切换。之后,通过 MMT 对整个多模态 LLM 进行联合优化,该优化过程在训练时间和存储方面都更加高效。

首先,该研究引入了一个模态 token 来表示输入模态,其定义为:

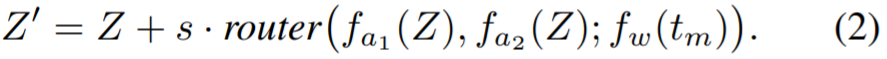

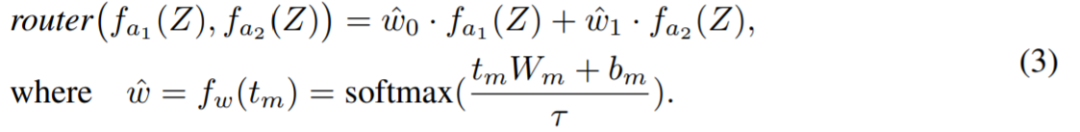

其中 为模态嵌入。MM-Adapter 定义为:

为模态嵌入。MM-Adapter 定义为:

如图 3 所示,实现动态自适应的关键在于路由函数的设计,其公式为:

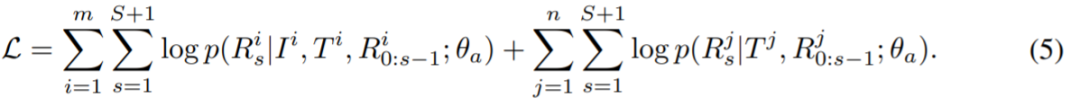

根据公式 2 和 3,MM-Adapter 可以根据输入指令的模态选择最佳的适应路径。更重要的是,MM-Adapter 过程只引入了一小部分额外参数,因此仍然是高效的。同时,MM-Adapter 还可以作为单模态适配器来改善适应能力,因此该研究还将其应用于图像编码器。基于 MM-Adapter,MMT 的目标是冻结大型图像编码器和 LLM,只微调嵌入的适配器。在这种情况下,整个多模态 LLM 可以以端到端的方式进行联合优化。具体而言,端到端的优化目标可以通过以下方式进行建模:

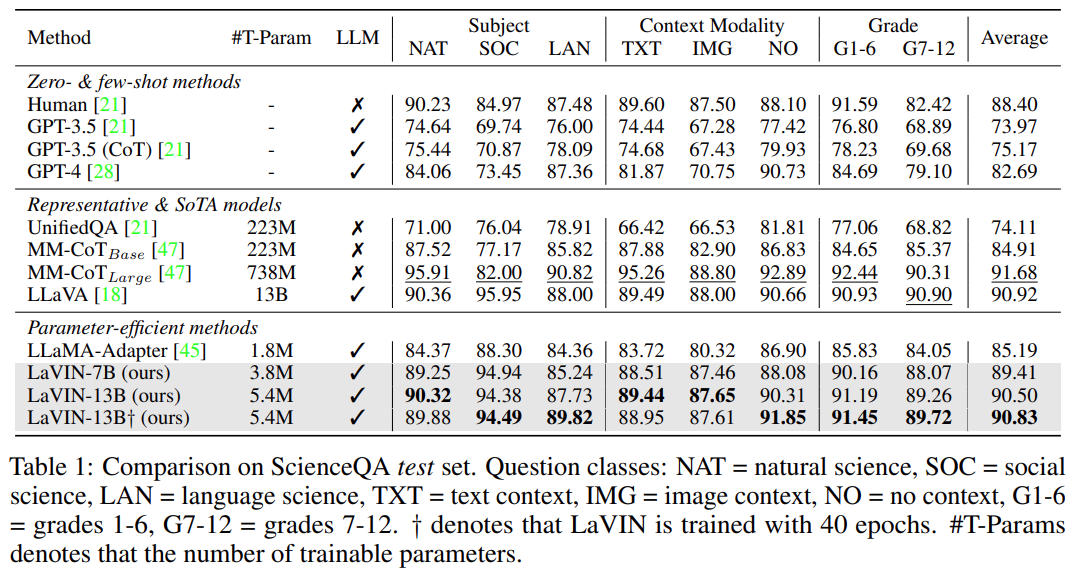

在此训练方案中,优化的参数数量仍然保持在非常小的规模,例如 3∼5M,这大大减少了训练时间和存储成本。与现有的模块化训练范式相比,MMA 不需要额外的视觉 - 语言预训练,并且可以端到端地优化整个模型,进一步提高了训练效率。在实验方面,该研究首先在 ScienceQA 数据集上将 LaVIN 与现有 SOTA 方法进行了比较,结果如下表 1 所示。与其他方法相比,LaVIN 在性能和训练效率之间实现了更好的权衡。

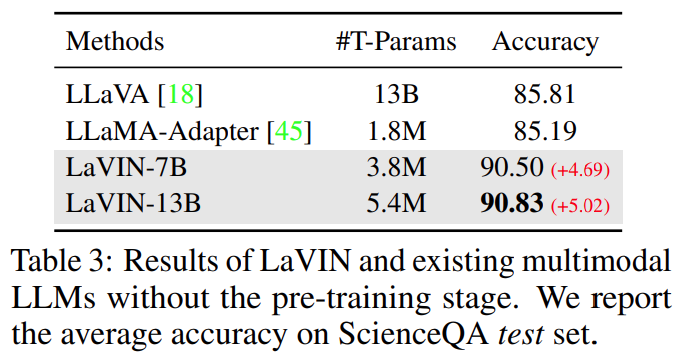

然后,该研究将 LaVIN 与不含 VL 预训练的现有方法进行了实验比较,结果如下表 3 所示。在 MMA 的帮助下,LaVIN 明显优于其他方法。这表明 MMA 在 VL 适应方面的高效性。

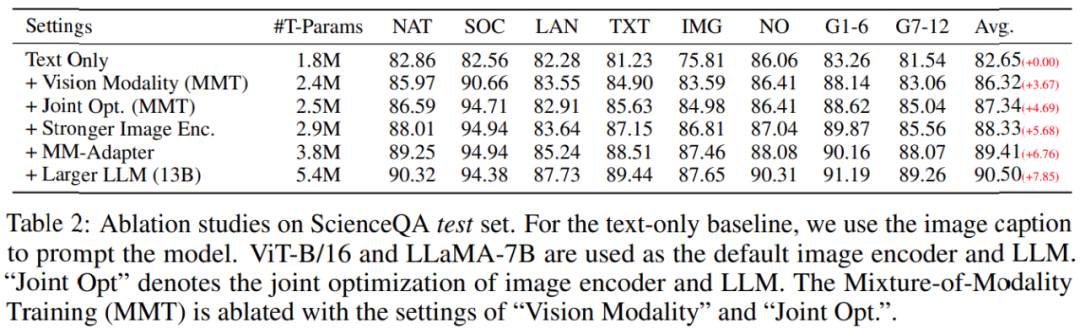

此外,该研究还进行了消融实验,结果如下表 2 所示。实验结果表明,通过图像编码器和 LLM 的联合优化,LaVIN 的性能从 86.32 进一步提升到了 87.34,这说明联合优化对于多模态 LLM 是非常重要的。在混合模态训练(mixture-of-modality training,MMT)的帮助下,LaVIN 已经超越了现有的参数高效方法(LLaMA-Adapter)。

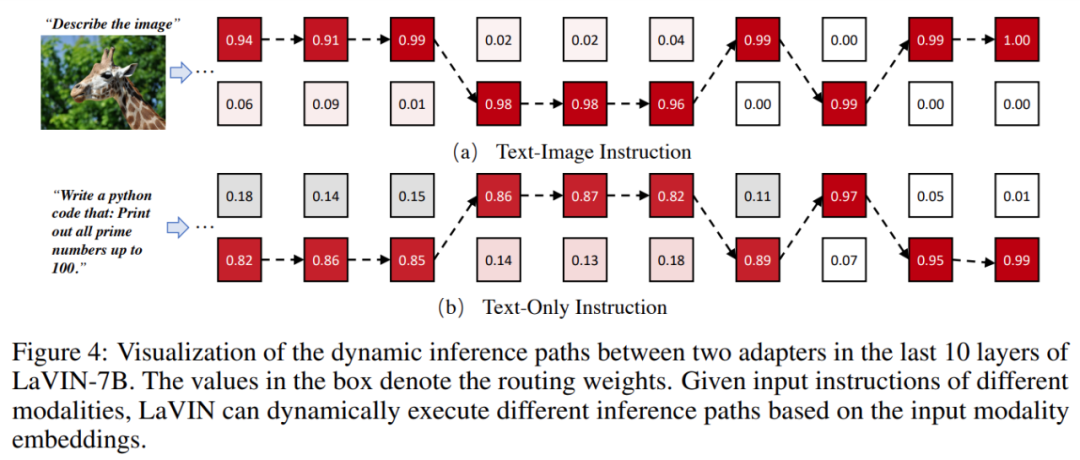

下图 4 是该研究将 LaVIN 对于纯文本和文本 - 图像指令输入的相应路由权重可视化的结果。我们可以发现 MM-Adapter 有效地将不同模态的推理解耦到两组适配器中。

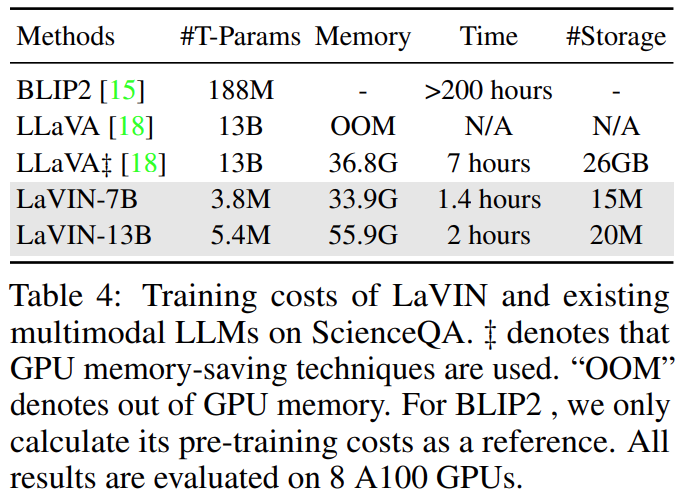

表 4 比较了 LaVIN、LLaVA 和 BLIP2 训练支出:

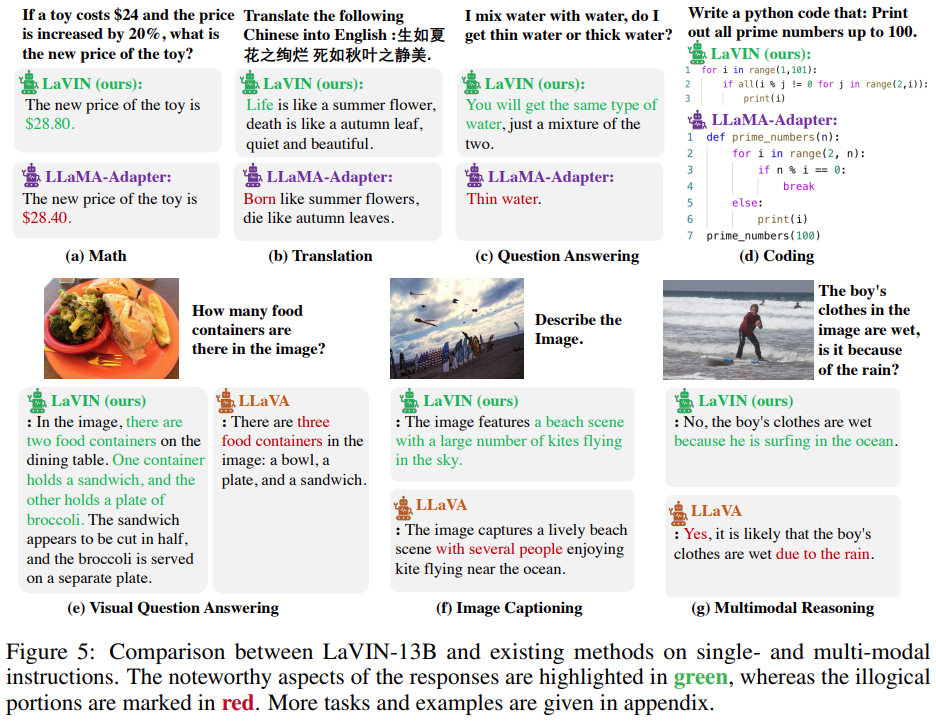

图 5 比较了 LaVIN 与现有方法在单模态和多模态的指令跟随任务上的表现,例如数学、编码和图像字幕。与 LLaVA 和 LLaMA-Adapter 相比,LaVIN 在多个任务上实现了整体更好的回答。

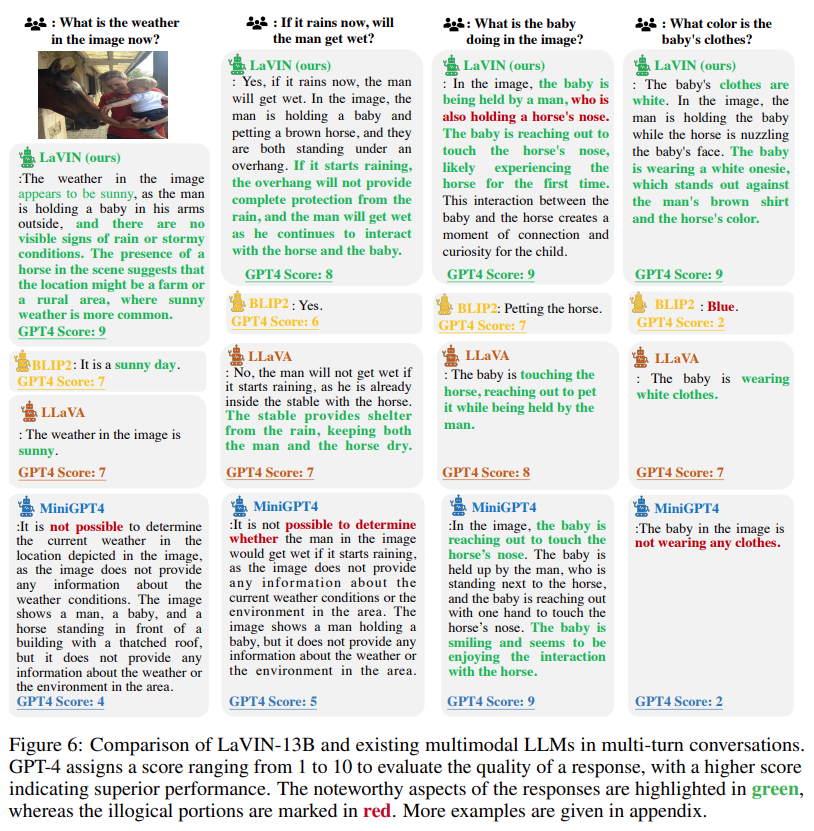

图 6 比较了 LaVIN 与现有的多模态 LLM 在多轮对话中的表现,并使用 GPT-4 评估它们回答的质量。结果表明,LaVIN 得分最高,这说明了 LaVIN 在多模态对话方面具有更优秀的能力。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]