作者|赵健

7月11日,英特尔在北京举办AI产品战略暨Gaudi2新品发布会,正式于中国市场推出第二代深度学习加速器——Habana Gaudi2。

Habana是成立于2016年的AI芯片厂商,总部位于以色列,为数据中心提供可编程深度学习加速器。Habana在2019年推出了第一代Gaudi芯片,并在这一年12月被其早期投资人英特尔收购。

其实在2022年5月,英特尔已经发布过Gaudi2。而这一次在北京的产品发布,是面向中国市场的“定制版”,类似英伟达推出A100与H100的定制版A800与H800。

英特尔执行副总裁兼数据中心与人工智能事业部总经理Sandra Rivera强调,Gaudi2是完全合法合规的。

在性能方面,这款中国定制版训练最主要的性能裁剪在于网络端口。Gaudi2有21个百兆端口,而国际版有24个。不过,英特尔Habana Labs首席运营官Eitan Medina表示,“从客户使用情况来看,预计影响会非常小”。

Gaudi2的推出,为训练大模型提供了英伟达之外的替代方案。在此之前,英伟达的GPU芯片——A100与H100,几乎垄断了训练大模型的市场。供需的极度不平衡也让GPU一芯难求。

相比英伟达GPU,Gaudi2最显著的优势在于“更高的性价比”。英特尔表示,将致力于为中国用户提供更高的深度学习性能和效率,从而成为大规模部署AI的更优解。

目前,英特尔正与浪潮信息合作,打造并发售基于Gaudi2深度学习加速器的浪潮信息AI服务器。此外,新华三与超聚变也是英特尔的合作伙伴。

1.用性价比挑战英伟达

目前,业内普遍认为生成式AI和大语言模型仅适宜在GPU上运行。但英特尔Gaudi2正在向英伟达发起挑战。

Gaudi2深度学习加速器暨Gaudi2夹层卡HL-225B,以第一代Gaudi高性能架构为基础,采用了台积电7nm工艺,专为训练大语言模型而构建。该加速器具备:

24个可编程Tensor处理器核心(TPCs)

21个100 Gbps(RoCEv2)以太网接口

96GB HBM2E内存容量

2.4TB/秒的总内存带宽

48MB片上SRAM

集成多媒体处理引擎

演讲者为英特尔执行副总裁兼数据中心与人工智能事业部总经理Sandra Rivera

演讲者为英特尔执行副总裁兼数据中心与人工智能事业部总经理Sandra Rivera

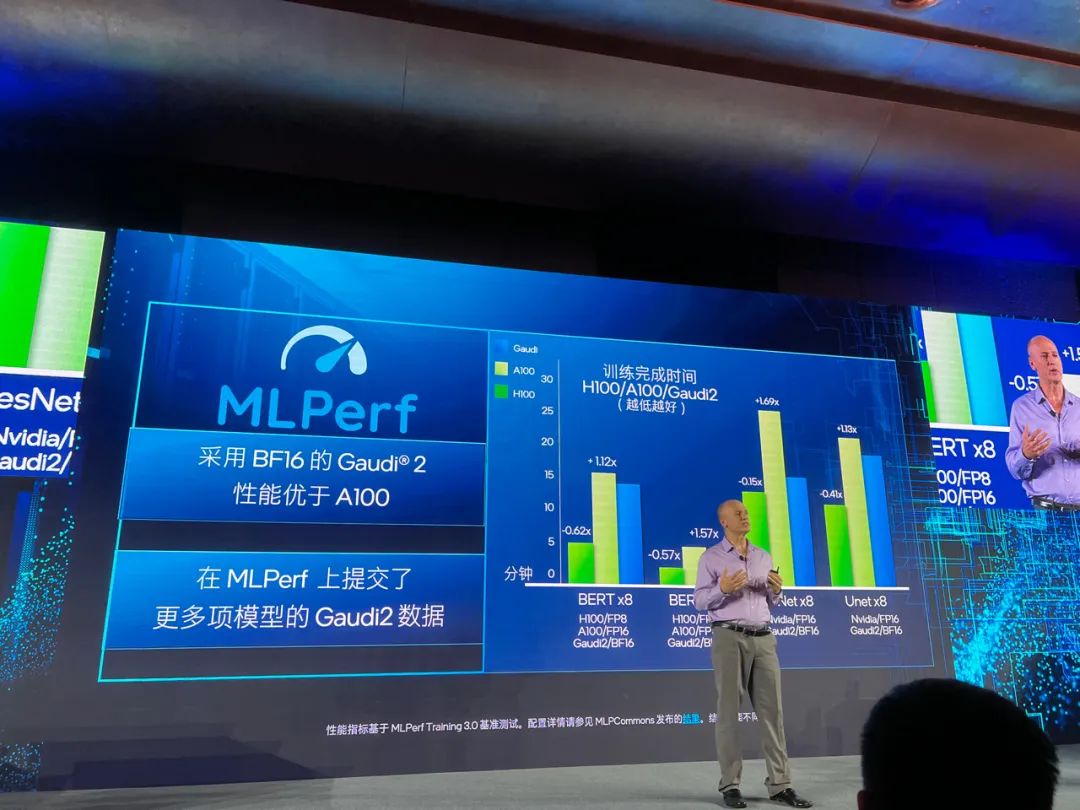

Gaudi2真实性能表现如何?在发布会现场,英特尔多次与英伟达进行参数对比。在6月公布的MLCommons MLPerf基准测试(被普遍认为是最具信服力的AI性能测试基准)结果中,Gaudi2在GPT-3模型、计算机视觉模型ResNet-50(使用8个加速器)、Unet3D(使用8个加速器),以及自然语言处理模型BERT(使用8个和64个加速器)上均取得了比A100更优异的结果,但还弱于H100。 演讲者为英特尔Habana Labs首席运营官Eitan Medina

演讲者为英特尔Habana Labs首席运营官Eitan Medina

在MLCommons刚刚公布的MLPerf训练3.0结果中,Gaudi2在1750亿参数的GPT-3模型上,从256个加速器到384个加速器可实现接近线性的95%扩展效果。英特尔表示,Gaudi2的每瓦性能大约是A100的两倍。而随着性能的进一步优化,英特尔预计在今年9月,Gaudi2的性价比将会超过H100。值得一提的是,Gaudi2是仅有的两个向GPT-3大模型训练基准提交性能结果的解决方案之一。英特尔Habana Labs首席运营官Eitan Medina强调:“这说明了其他半导体厂商还无法构建针对GPT-3的解决方案”。除了模型的训练,还需要模型的推理。Gaudi2可为大规模的多模态和语言模型提供出色的推理性能。在最近的Hugging Face评估中,Gaudi2在大规模推理方面的表现,包括在运行Stable Diffusion、70亿以及1760亿参数BLOOMz模型时,都在行业内保持领先。其中,与英伟达A100相比,Stable Diffusion推理时延降低2.21倍。值得一提的是,下一代Gaudi3预计在明年推出,采用台积电5nm工艺。2.英特尔的AI战略

英特尔拥有庞大丰富的产品线,Gaudi2并非唯一的AI产品。针对AI在不同场景、不同环节的异构计算需求,英特尔将其产品线分为通用计算与加速计算。其中,英特尔的CPU产品,第四代至强处理器解决通用计算,满足客户在大部分模型较小场景的AI推理需求;Gaudi2解决加速计算,解决大模型的训练及推理需求。在通用计算层面,第四代英特尔至强可扩展处理器(英特尔AMX)为广泛的AI负载和用例提供10倍的推理和训练性能以及代际性能提升,同时每瓦性能比也比前代提高7.7倍。在6月底公布的MLPerf训练3.0结果表明,第四代至强可扩展处理器为企业提供了“开箱即用”的功能,可以在通用系统上部署AI,避免了引入专用AI系统的高昂成本和复杂性。第四代至强可扩展处理器也能够支持Stable Diffusion。英伟达DGX H100系统也会选择搭配英特尔CPU,从而为企业级AI提供高速、高能效并节省成本。百度、美团是英特尔AMX的客户。英特尔AMX助力百度文心一言轻量版ERNIE-Tiny性能提升2.66倍,助力美团加速视觉AI推理服务,成本降低80%。值得一提的是,在加速计算层面,英特尔除了推出人工智能专用芯片Gaudi2之外,也在2022年推出了面向数据中心的的GPU Max系列(代号为Ponte Vecchio)。两款产品在AI计算层面存在一定的重合度。对此,英特尔透露会在2025年把Gaudi产品线与GPU产品线整合为统一架构的新产品,并带来更好的软件适配能力与AI处理能力。此外,正如英伟达依靠CUDA构建护城河,英特尔也在加强软件开发生态的支持。英特尔推出的软件套件针对Gaudi平台深度学习业务进行了优化,集成了对TensorFlow和PyTorch框架的支持,并面向400多个机器学习和深度学习AI模型进行验证,涵盖每个业务领域使用的最常见AI用例。总结来看,英特尔正在通过异构产品组合、开放式的软件栈以及用于大模型训练的Gaudi2集群,来降低人工智能的准入门槛,来满足庞大的市场需求。芯片是大模型训练及推理的基础设施,也是这场大模型淘金热必不可少的“铲子”。如今,随着主流半导体巨头纷纷布局,这场大模型的芯片战已经彻底打响了。

END.

演讲者为英特尔执行副总裁兼数据中心与人工智能事业部总经理Sandra Rivera

演讲者为英特尔Habana Labs首席运营官Eitan Medina