7 月 29 日,《纽约时报》的记者在谷歌实验室,率先看到了谷歌最新推出的 RT-2 模型驱动的机器人。

一个单臂机器人站在一张桌子前。桌子上坐着三个塑料雕像:狮子、鲸鱼和恐龙。工程师给机器人发出指令:「捡起灭绝的动物。」机器人呼呼地响了一会儿,然后手臂伸出,爪子张开落下。它抓住了恐龙。《纽约时报》描述道,「直到上周,这一演示还是不可能的。机器人无法可靠地操纵它们以前从未见过的物体,它们当然也无法实现从「灭绝的动物」到「塑料恐龙」的逻辑飞跃。」虽然仍然存在于展示之中,且谷歌并不打算立即进行更大规模的发布或者对其进行商业化,但这一展示已经足以展现大模型为机器人能够带来的机遇的一角。在大模型时代到来之前,人们训练机器人,通常针对每个任务进行优化,比如抓取某种玩具,需要足量的数据,机器人才能准确地从各个角度、各个光线下识别这种玩具,抓取成功。而让机器人意识到自己有抓取玩具的任务,也需要对机器人进行编程才能解决。而大模型的智能和泛化能力,让人们看到了解决这些问题,走向通用机器人的一道曙光。谷歌新的 RT-2 模型,全称为 Robotic Transformer 2,运用 Transformer 架构作为其模型的基座。2018 年被提出的 Transformer 架构,是目前火遍全球的大语言模型(LLM)的最底层的基座,但事实上,作为一种架构,Transformer 不止可以应用于大语言模型当中,也可以用于训练其他类型的数据。早在今年 3 月份,谷歌就发布了 PaLM-E,是当时世界上最大视觉语言模型(VLM)。大语言模型中,语言被编码为向量,人们为模型提供大量的语料,使其能够预测出人类通常下一句会说什么,借此生成语言回答。而在视觉语言模型中,模型可以将图像信息编码为与语言类似的向量,让模型既能「理解」文字,又能用相同方式「理解」图像。而研究员们为视觉语言模型提供大量的语料和图像,使其能够执行视觉问答、为图像添加字幕和物品识别等任务。无论是图像还是语言,都是相对容易大量获取的数据。因此,模型很容易取得令人惊艳的成果。而想使用 Transformer 架构来生成机器人行为,却有一个很大的难点。「涉及到机器人动作的数据非常昂贵。」清华大学交叉信息研究院助理教授许华哲教授告诉极客公园,「视觉和语言数据都来自于人类,是被动数据,而机器人的动作数据,全部是来自于机器人的主动数据。比如我想研究机器人倒咖啡的动作,不管是写代码让机器人执行,还是利用其他的方式让机器人执行,都是需要机器人实际执行一遍这个操作才能得到这个数据。因此,机器人的数据与语言和图片的规模和量级是完全不一样的。」在谷歌研究的第一代机器人 Transformer 模型 RT-1 中,谷歌第一次开启了这样的挑战,尝试建立一个视觉语言动作模型。为了建立这样的模型,谷歌使用了 13 个机器人,在一个搭建的厨房环境中耗时 17 个月收集到了机器人在 700 多个任务上的主动数据组建的数据集。- 和机器人动作——机器手进行任务时在 xyz 轴和偏转数据等。

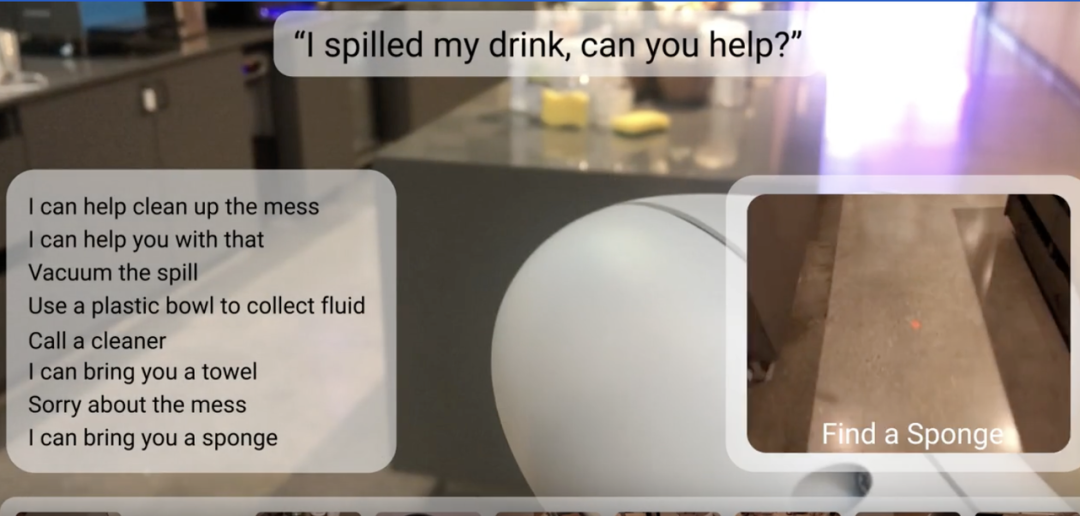

虽然当时得到了较好的实验效果,但可想而知,想要进一步增加数据集内数据的数量,将是一件非常难的事情。 图片来源:谷歌 AI 介绍视频而 RT-2 的创新之处在于,RT-2 使用前面所述的视觉语言模型(VLM)PaLM-E 和另一个视觉语言模型 PaLI-X 作为其底座——单纯的视觉语言模型可以通过网络级的数据训练出来,因为数据量足够大,能够得到足够好的效果,而在微调(fine-tuning)阶段,再将机器人的动作数据加入进去一起微调(co-finetuning)。这样,机器人相当于首先已经拥有了一个在海量数据上学习过了的常识系统——虽然还不会抓取香蕉,但是已经能够认识香蕉了,甚至也知道了香蕉是一种水果,猴子会比较喜欢吃。而在微调阶段,通过再加入机器人在真实世界中看到香蕉后是如何抓取香蕉的知识,机器人就不但拥有了在各种光线和角度下识别香蕉的能力,也拥有了能够抓取香蕉的能力。在这种方式下,用 Transformer 架构训练机器人所需的数据显著降低了。RT-2 在微调阶段直接使用了 RT-1 训练阶段使用的视觉/语言/机器人动作数据集。谷歌给出的数据显示,在抓取训练数据中原来出现过的物品时,RT-2 的表现与 RT-1 同样好。而因为有了「拥有常识的大脑」,在抓取之前没有见过的物品时,成功率从 RT-1 的 32% 提升到了 62%。「这就是大模型的妙处。」许华哲讲道,「你没有办法把它拆解成因为它识别到了两个物体是材质相似,还是因为大小相近还是因为别的什么原因抓取的成功率提升了。它学到的东西足够多了之后,就会涌现出一些能力。」学术上,RT-2 展现的很强的泛化性有可能解决机器人训练数据不足的难题。而在此之外,RT-2 给人的直观震撼还是来自于它所展现的智能的一面。在实验中,研究员希望它能够拿起一个「能够用作锤子的东西」,机器人在一堆物品中拿起了石头,而在被要求拿起一个提供给疲惫的人的饮料时,机器人在一堆物品中选择了红牛。这样的技巧来自在进行大模型训练时,研究员引入「思维链」(chain of thought)的能力。而这样的多段语义推理在传统的机器人模仿学习研究中时非常难以做到的。不过,利用自然语言与机器人交互,并不是 RT-2 的创见。在过去的机器人研究中,研究者始终需要将任务要求转换为代码而让机器人能够理解,同时一旦出现问题,也需要编写代码来纠正机器人的行为,整个过程需要多次交互,效率较低。而既然我们已经有了非常智能的对话机器人了,下面比较自然的一步,自然是让机器人与人类用自然语言交互。「我们大约两年前开始研究这些语言模型,然后我们意识到它们蕴藏着丰富的知识。」谷歌研究科学家卡罗尔·豪斯曼 (Karol Hausman) 表示,「所以我们开始将它们连接到机器人。」不过,让大模型作为机器人的头脑,也有着自己的难题。其中最重要的一个问题之一,就是 grounding 问题,即如何使大模型通常比较天马行空的回应,转化成驱动机器人行动的指令。2022 年,谷歌推出 Say-can 模型。模型正如其名,采用两重考量来帮助机器人行动。一重考量是 say,模型通过与谷歌的大语言模型 PaLM 模型结合,可以通过自然语言和人类交互,把获得的任务进行分解,找到最适合当前行动;另一重考量是 can,模型通过一个算法,计算出当前机器人能够成功执行这一任务的概率。机器人根据这两重考量下,进行动作。比如对机器人讲「我的牛奶撒了,你能不能帮我?」机器人会首先通过语言模型进行任务规划,这时可能最合理的方式是找到一个清洁工,其次是找一块海绵自己擦。然后机器人会通过算法计算出作为机器人,它能够成功找到清洁工的概率很低,而找到海绵自己擦的概率很高。在两重考虑后,机器人就会选择寻找海绵擦牛奶的行动。

图片来源:谷歌 AI 介绍视频而 RT-2 的创新之处在于,RT-2 使用前面所述的视觉语言模型(VLM)PaLM-E 和另一个视觉语言模型 PaLI-X 作为其底座——单纯的视觉语言模型可以通过网络级的数据训练出来,因为数据量足够大,能够得到足够好的效果,而在微调(fine-tuning)阶段,再将机器人的动作数据加入进去一起微调(co-finetuning)。这样,机器人相当于首先已经拥有了一个在海量数据上学习过了的常识系统——虽然还不会抓取香蕉,但是已经能够认识香蕉了,甚至也知道了香蕉是一种水果,猴子会比较喜欢吃。而在微调阶段,通过再加入机器人在真实世界中看到香蕉后是如何抓取香蕉的知识,机器人就不但拥有了在各种光线和角度下识别香蕉的能力,也拥有了能够抓取香蕉的能力。在这种方式下,用 Transformer 架构训练机器人所需的数据显著降低了。RT-2 在微调阶段直接使用了 RT-1 训练阶段使用的视觉/语言/机器人动作数据集。谷歌给出的数据显示,在抓取训练数据中原来出现过的物品时,RT-2 的表现与 RT-1 同样好。而因为有了「拥有常识的大脑」,在抓取之前没有见过的物品时,成功率从 RT-1 的 32% 提升到了 62%。「这就是大模型的妙处。」许华哲讲道,「你没有办法把它拆解成因为它识别到了两个物体是材质相似,还是因为大小相近还是因为别的什么原因抓取的成功率提升了。它学到的东西足够多了之后,就会涌现出一些能力。」学术上,RT-2 展现的很强的泛化性有可能解决机器人训练数据不足的难题。而在此之外,RT-2 给人的直观震撼还是来自于它所展现的智能的一面。在实验中,研究员希望它能够拿起一个「能够用作锤子的东西」,机器人在一堆物品中拿起了石头,而在被要求拿起一个提供给疲惫的人的饮料时,机器人在一堆物品中选择了红牛。这样的技巧来自在进行大模型训练时,研究员引入「思维链」(chain of thought)的能力。而这样的多段语义推理在传统的机器人模仿学习研究中时非常难以做到的。不过,利用自然语言与机器人交互,并不是 RT-2 的创见。在过去的机器人研究中,研究者始终需要将任务要求转换为代码而让机器人能够理解,同时一旦出现问题,也需要编写代码来纠正机器人的行为,整个过程需要多次交互,效率较低。而既然我们已经有了非常智能的对话机器人了,下面比较自然的一步,自然是让机器人与人类用自然语言交互。「我们大约两年前开始研究这些语言模型,然后我们意识到它们蕴藏着丰富的知识。」谷歌研究科学家卡罗尔·豪斯曼 (Karol Hausman) 表示,「所以我们开始将它们连接到机器人。」不过,让大模型作为机器人的头脑,也有着自己的难题。其中最重要的一个问题之一,就是 grounding 问题,即如何使大模型通常比较天马行空的回应,转化成驱动机器人行动的指令。2022 年,谷歌推出 Say-can 模型。模型正如其名,采用两重考量来帮助机器人行动。一重考量是 say,模型通过与谷歌的大语言模型 PaLM 模型结合,可以通过自然语言和人类交互,把获得的任务进行分解,找到最适合当前行动;另一重考量是 can,模型通过一个算法,计算出当前机器人能够成功执行这一任务的概率。机器人根据这两重考量下,进行动作。比如对机器人讲「我的牛奶撒了,你能不能帮我?」机器人会首先通过语言模型进行任务规划,这时可能最合理的方式是找到一个清洁工,其次是找一块海绵自己擦。然后机器人会通过算法计算出作为机器人,它能够成功找到清洁工的概率很低,而找到海绵自己擦的概率很高。在两重考虑后,机器人就会选择寻找海绵擦牛奶的行动。 图片来源:Saycan 介绍视频虽然在这样双层模型架构中,机器人能够成功做出的动作已经是预先设计好的,大语言模型只是能够帮助机器人选择合适的任务规划。在这样模型中,机器人已经展现出了极强的智能感。不过,虽然从外在看起来效果是类似的,RT-2 采取的是另一种道路。通过训练时模型就同时学习视觉、语言、机器人行为这三种数据,RT-2 的模型并不是先进行任务分解,再进行任务操作,而是自然语言输入后,通过模型的运算,直接产生动作的输出。「双层结构类似于我想去做一件事情,脑袋里先想好第一步干这个,第二步干那个,然后再挨个执行这些策略。」许华哲教授表示,「而端到端的结构类似于我也没有特别仔细想第一步、第二步是什么,就把这个事情给干了。」后者的一个例子可以类比于我们每天在手机上打字聊天,我们打字聊天时一般不会认真思考肌肉具体要如何去动作,而是想到了要打的字,就直接打出来了。「两种不同的路线或者不同的方法,都还没有证明自己是唯一正确的方式。」许华哲表示。但由于 RT-2 的优秀表现,一个模型能够接管输入输出的技术方向,似乎值得探索。「由于这一变化(RT-2 的优秀表现),我们不得不重新考虑我们的整个研究规划了,」谷歌 DeepMind 机器人技术主管文森特·范霍克(Vincent Vanhoucke)表示。「之前所做的很多事情都完全变成无用功了。」谷歌的 RT-2 机器人并不完美。在《纽约时报》记者目睹的实际演示中,它错误地识别了一罐柠檬味苏打水的味道(说成「橘子味」)。还有一次被问到桌子上有什么水果时,机器人回答成「白色」(实际是香蕉)。谷歌发言人解释说,该机器人使用了缓存的答案来回答之前测试者的问题,因为它的 Wi-Fi 曾短暂中断过。除此之外,利用大模型训练机器人,不可避免地要面对成本问题。目前谷歌的机器人在进行推理和判断的时候,需要将数据传到云端,由多块 TPU 一起进行计算,再将结果发回机器人,由机器人执行操作。这样的计算可想而知十分昂贵。谷歌 DeepMind 机器人技术主管文森特·范霍克(Vincent Vanhoucke)认为,新的研究开启了机器人能够在有人的环境中使用的大门——研究者认为,内置了语言模型的机器人可以进入仓库、用于医疗行业,甚至成为家庭助理,帮助折叠衣物、从洗碗机中取出物品、在房子周围收拾东西。「如果你开一个工厂,需要使用机器人,成功率一定是要求很高的。你不会希望说买了机器人后,还需要很多人去维护这个机器人,完善机器人做的不够好的事情。那这样成本太高了。」许华哲教授表示,「家居场景下的机器人可能是另一个情形,因为也许家居场景下的一些任务的成功率要求没有那么高。比如叠衣服,叠的没有那么好,可能在你眼中这个任务失败了,但对你的影响也不会非常大。」人工智能三巨头之一的杨立昆(Yaan Lecun)有一个强调过许多次的著名论断:人工智能还不够聪明。任何一个孩子都能很快学会收拾桌子,把碗放进洗碗机,而机器人却做不到。目前的机器人研究或许确实如此,但正如不完美的 GPT-3 让业界看到了大模型发展的方向一样,或许今天不完美的 RT-2 也将开启机器人进入家庭成为我们的助手的未来时代。本文为极客公园原创文章,转载请联系极客君微信 geekparkGO近日,以北京为代表的国内旅游城市酒店大幅涨价引发网络热议,「月薪2万住不起如家汉庭」登上热搜。

图片来源:Saycan 介绍视频虽然在这样双层模型架构中,机器人能够成功做出的动作已经是预先设计好的,大语言模型只是能够帮助机器人选择合适的任务规划。在这样模型中,机器人已经展现出了极强的智能感。不过,虽然从外在看起来效果是类似的,RT-2 采取的是另一种道路。通过训练时模型就同时学习视觉、语言、机器人行为这三种数据,RT-2 的模型并不是先进行任务分解,再进行任务操作,而是自然语言输入后,通过模型的运算,直接产生动作的输出。「双层结构类似于我想去做一件事情,脑袋里先想好第一步干这个,第二步干那个,然后再挨个执行这些策略。」许华哲教授表示,「而端到端的结构类似于我也没有特别仔细想第一步、第二步是什么,就把这个事情给干了。」后者的一个例子可以类比于我们每天在手机上打字聊天,我们打字聊天时一般不会认真思考肌肉具体要如何去动作,而是想到了要打的字,就直接打出来了。「两种不同的路线或者不同的方法,都还没有证明自己是唯一正确的方式。」许华哲表示。但由于 RT-2 的优秀表现,一个模型能够接管输入输出的技术方向,似乎值得探索。「由于这一变化(RT-2 的优秀表现),我们不得不重新考虑我们的整个研究规划了,」谷歌 DeepMind 机器人技术主管文森特·范霍克(Vincent Vanhoucke)表示。「之前所做的很多事情都完全变成无用功了。」谷歌的 RT-2 机器人并不完美。在《纽约时报》记者目睹的实际演示中,它错误地识别了一罐柠檬味苏打水的味道(说成「橘子味」)。还有一次被问到桌子上有什么水果时,机器人回答成「白色」(实际是香蕉)。谷歌发言人解释说,该机器人使用了缓存的答案来回答之前测试者的问题,因为它的 Wi-Fi 曾短暂中断过。除此之外,利用大模型训练机器人,不可避免地要面对成本问题。目前谷歌的机器人在进行推理和判断的时候,需要将数据传到云端,由多块 TPU 一起进行计算,再将结果发回机器人,由机器人执行操作。这样的计算可想而知十分昂贵。谷歌 DeepMind 机器人技术主管文森特·范霍克(Vincent Vanhoucke)认为,新的研究开启了机器人能够在有人的环境中使用的大门——研究者认为,内置了语言模型的机器人可以进入仓库、用于医疗行业,甚至成为家庭助理,帮助折叠衣物、从洗碗机中取出物品、在房子周围收拾东西。「如果你开一个工厂,需要使用机器人,成功率一定是要求很高的。你不会希望说买了机器人后,还需要很多人去维护这个机器人,完善机器人做的不够好的事情。那这样成本太高了。」许华哲教授表示,「家居场景下的机器人可能是另一个情形,因为也许家居场景下的一些任务的成功率要求没有那么高。比如叠衣服,叠的没有那么好,可能在你眼中这个任务失败了,但对你的影响也不会非常大。」人工智能三巨头之一的杨立昆(Yaan Lecun)有一个强调过许多次的著名论断:人工智能还不够聪明。任何一个孩子都能很快学会收拾桌子,把碗放进洗碗机,而机器人却做不到。目前的机器人研究或许确实如此,但正如不完美的 GPT-3 让业界看到了大模型发展的方向一样,或许今天不完美的 RT-2 也将开启机器人进入家庭成为我们的助手的未来时代。本文为极客公园原创文章,转载请联系极客君微信 geekparkGO近日,以北京为代表的国内旅游城市酒店大幅涨价引发网络热议,「月薪2万住不起如家汉庭」登上热搜。