2023年是AIGC大爆发的一年!尤其是视频生成(Video Generation)领域已经成为当前各大公司、高校发力的重点目标。

视频生成之所以如此重要,是因为它能够帮助人们快速创建各种类型的视频内容,在教育、娱乐、自动驾驶、元宇宙等行业都能发挥出强大作用。2023年视频生成商用级代表性产品有:Runway公司的Gen-2(当前明星产品)、Pika Labs推出的Pika1.0(2023年大黑马) 、Stability AI 开源的Stable Video Diffusion(正式从图片生成进军到视频生成)、谷歌于2023年底发布的VideoPoet视频生成大语言模型,能够执行各种视频生成任务。

2023年视频生成学术级代表性(论文)工作有:Meta提出Emu Video、谷歌&斯坦福李飞飞团队提出W.A.L.T、英伟达提出VideoLDM(收录于顶会CVPR 2023)等等。

眼尖的同学应该已经发现了:上面盘点的视频生成工作都是国外团队做的。其实国内视频生成技术发展的也相当快速,比如阿里云推出的Animate Anyone、字节跳动推出的MagicAnimate等。这里Amusi重点聊一下阿里云自研的视频生成爆款出圈之作:Animate Anyone。其实在2023年11月底,这项工作的论文和项目主页一经发布,便在X(前Twitter)、YouTube等社交媒体平台上爆火。相关视频播放量累计超1亿,该项目GitHub的Star数量也已经超1.1万!行业开发者等待着它开源,普罗大众更是期待着它早点开放使用。到底有没有很火爆?来问问友商,如下图可知,百度文心一言都已经知道Animate Anyone了。就在最近,阿里云通义千问APP正式上线了Animate Anyone!上传一张真人、动漫、卡通等角色照片,即可免费生成一段舞蹈视频。目前该功能创作的视频正在国内外各大社交平台上刷屏(今天还看到很多好友在朋友圈分享用通义千问APP生成的"魔性视频")。该如何使用?你可以直接在手机应用商店中下载通义千问APP,然后在APP内输入回复「通义舞王」、「全民舞王」或者「Animate Anyone」关键词后,即可进入体验页面。通义千问目前为用户提供了12种热门舞蹈模板,包括现在爆火全网的科目三,还有DJ慢摇、鬼步舞、兔子舞等等。当你选择目标舞蹈模板后,按照官方【上传形象建议】上传照片,然后耐心等待,即可生成逼真的舞蹈视频。温馨提示:现在试用该功能的人很多,生成时间会比较长,所以你上传照片后,可以离开生成页面,当后台处理好后,会自动给你发通知。

正常真人照片的测试应该很常见了,这里我直接从网上找了一张兵马俑的照片,让我们来看看测试效果究竟如何?

兵马俑跳"只想对你说「爱你」",舞蹈动作很丝滑,相当生动、形象!嫌弃兵马俑跳【爱你】不够温柔?那可以让你的收藏的手办动起来!这里我输入一张蕾姆手办的照片,这效果太顶了!蕾姆手办测试图片

那么Animate Anyone生成效果为何如此惊艳呢?核心原因是因为它实现了人物形象一致,动作流畅可控的人物动作视频生成。这个是当前视频生成领域中的核心难点,而阿里云提出的Animate Anyone工作实现了突破性进展,很好地解决了这个挑战。你肯定会好奇这么出圈、这么神奇的Animate Anyone的背后究竟使用了哪些技术?下面我将带你剖析算法细节,希望对你有所帮助。【一段话总结】Animate Anyone:一个为"角色动画(Character Animation)"量身定制的新框架,利用扩散模型的力量,可以将角色照片转换为由所需姿势序列控制的动画视频,与其他图像到视频方法相比,在角色动画方面产生更好的结果!特别是纹理一致性和时间稳定性!

Animate Anyone: Consistent and Controllable Image-to-Video Synthesis for Character Animation

主页链接:

https://humanaigc.github.io/animate-anyone/

代码链接:

https://github.com/HumanAIGC/AnimateAnyone

论文链接:

https://arxiv.org/abs/2311.17117

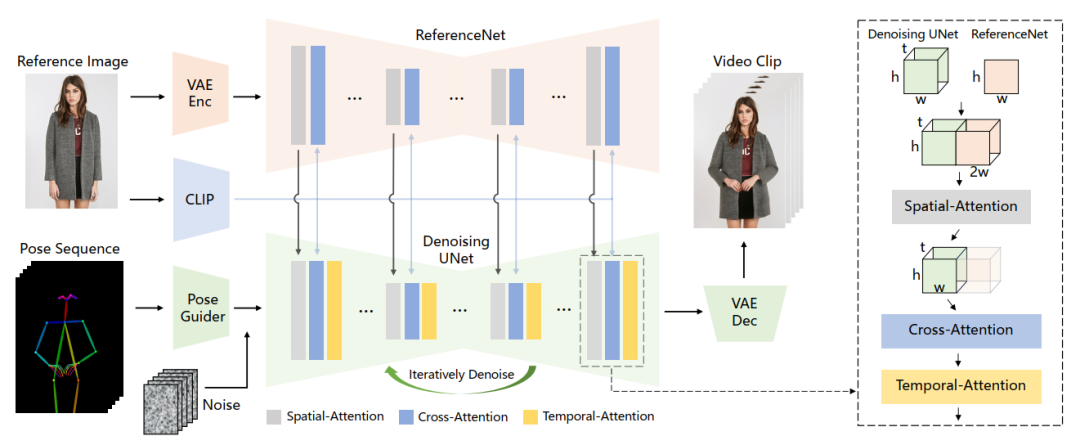

简单来说,本工作继承了来自Stable Diffusion的网络设计和预训练权重,并修改去噪U-Net以适应多帧输入。与之前的工作相比,首先,它有效地保持了视频中人物外观的空间和时间一致性。其次,它生成的高清视频不会出现时间抖动或闪烁等问题。第三,它能够将任何角色图像动画化为视频,不受特定领域的限制。 整体网络结构如下图所示,姿态序列最初使用Pose Guider进行编码,并与多帧噪声融合,然后由去噪UNet进行视频生成的去噪过程。去噪UNet的计算块由空间注意力、交叉注意力和时间注意力组成,如下图右侧虚线框所示。参考图像的整合涉及两个方面。首先,通过ReferenceNet提取细节特征,并将其用于空间注意力。其次,通过CLIP图像编码器提取语义特征进行交叉注意力。时间注意力在时间维度上运作。最后,VAE解码器将结果解码为视频片段。

下面我们一一拆解网络中三个关键组成部分,详细介绍。为了解决保持外观一致性的挑战,本工作提出了ReferenceNet:参考图像特征提取网络,可以从参考图像中编码角色的外观特征。它专门设计为对称 UNet 结构,用于捕获参考图像的空间细节。在 UNet 块的每个相应层,使用空间注意力将 ReferenceNet 的特征集成到去噪 UNet。

虽然ReferenceNet为去噪UNet引入了数量相当的参数,但在基于扩散的视频生成中,所有视频帧都要经过多次去噪,而ReferenceNet在整个过程中只需要提取一次特征。因此,在推理过程中,它不会导致计算开销的显著增加。 为了确保姿态可控性,本工作设计了一种轻量级姿态引导器(Pose Guider),以有效地将姿态控制信号集成到去噪过程中,实现可控的角色动作。该轻量级姿态引导器利用四个卷积层(4×4 kernels,2×2 trides,使用16,32,64,128通道)以与latent噪声相同的分辨率姿态图像对齐。随后,处理后的姿态图像在被输入到去噪UNet之前被添加latent噪声。姿态引导器是用高斯权重初始化的,在最终的投影层中,使用了零卷积。为了实现时间稳定性,本工作引入时间层(Temporal layer)来对多个帧之间的关系进行建模,从而在模拟连续且平滑的时间运动过程的同时保留视觉质量的高分辨率细节。时间层在Res-Trans块内的空间注意力和交叉注意力分量之后被整合。时间层的设计灵感来自AnimateDiff。具体来说,对于特征图x∈R^b×t×h×w×c,首先将其reshape为x∈R^(b×h×w)×t×c,然后进行时间注意力,即沿着维度t的自注意力。来自时间层的特征通过残差连接被合并到原始特征中。这种设计与下面要介绍的训练方法相一致。时间层仅应用于去噪UNet的Res-Trans块内。对于ReferenceNet,它计算单个参考图像的特征,并且不参与时间建模。由于姿势引导器实现了角色连续运动的可控性,实验表明,时间层确保了时间的平滑性和外观细节的连续性,从而无需复杂的运动建模。第一阶段,使用单独的视频帧来执行训练。在去噪UNet中,暂时排除temporal layer,模型以单帧噪声作为输入。ReferenceNet和Pose Guider在此阶段训练。参考图像是从整个视频片段中随机选择的。基于来自Stable Diffusion的预训练权重来初始化去噪UNet和ReferenceNet的模型。Pose Guider使用高斯权重进行初始化,但最终投影层使用零卷积。VAE的编码器和解码器以及CLIP图像编码器的权重都保持不变。该阶段的优化目标是使模型能够在给定参考图像和目标姿态的条件下生成高质量的动画图像。 第二阶段,将temporal layer引入第一阶段训练好的模型中,并使用来自AnimateDiff的预训练权重对其进行初始化。该模型的输入包括一个24帧的视频片段。在第二阶段,只训练temporal layer,同时固定网络其余部分的权重。在两个特定的基准中评估了Animate Anyone的性能:UBC时装视频合成(Fashion Video Synthesis)和TikTok人体舞蹈生成(Human Dance Generation)。采用SSIM、PSNR和LPIPS指标对于图像级质量进行定量评估,采用FVD指标对视频级进行定量评估。在UBC时装视频合成(Fashion Video Synthesis)基准上的性能如Table 1所示。Animate Anyone的实验结果优于其他方法,特别是在FVD指标方面表现出显著领先。定性比较如Figure 4所示,DreamPose和BDMM生成的视频未能保持服装细节的一致性,在颜色和精细结构元素方面出现了明显的错误。相比之下,Animate Anyone产生的结果有效地保持了服装细节的一致性。 在TikTok人体舞蹈生成(Human Dance Generation)基准上的性能如Table 2所示。Animate Anyone同样取得了最好的结果。另外值得一提的是:Animate Anyone的训练仅在TikTok数据集上进行,产生的结果优于DisCo。定性比较如Figure 5所示,Animate Anyone即使没有利用人体掩码(mask)的外显学习,也可以从主体的运动中掌握前景-背景关系。此外,在复杂的舞蹈序列中,Animate Anyone在整个动作中保持视觉连续性方面表现突出,并在处理不同角色外观方面表现出更强的稳健性。 由上可知,Animate Anyone的性能表现遥遥领先!该工作可以作为角色视频创作的基础解决方案,激发更多创新和创意应用的开发。Animate Anyone 具备十分优秀的视频生成性能和用户体验,达到了真正的“上手即用”。而通义大模型家族更是在不断丰富,已经全面覆盖了文本、语音及图像等模态。在此,我非常期待阿里云自研大模型“通义千问”支持更多的功能、插件。最后希望国产AIGC、大模型发展越来越好!给每个人带来便利! 整理不易,请点赞和在看