市场上存在多种计算光模块与GPU比例的方法,导致结果不相同。造成这些差异的主要原因是不同网络结构中光模块数量的波动。所需的光模块的准确数量主要取决于几个关键因素。

相关链接:

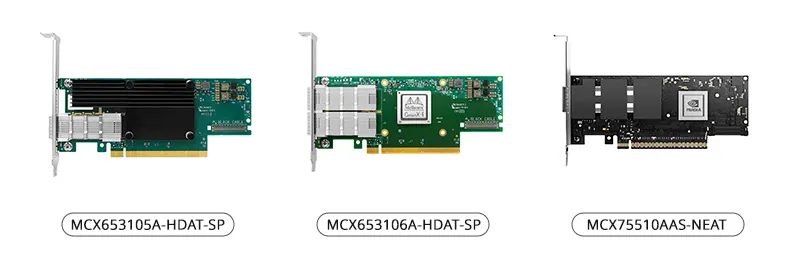

主要包括两个网卡,ConnectX-6 (200Gb/s,主要用于A100)和ConnectX-7 (400Gb/s,主要用于H100)。

同时,下一代ConnectX-8800Gb/s预计将于2024年发布。交换机型号

主要包括两种类型的交换机,QM 9700交换机(32口OSFP 2x400Gb/s),共64通道400Gb/s传输速率,总吞吐率达到51.2Tb/s。

而QM8700交换机(40口QSFP56,共40个通道,传输速率为200Gb/s,总吞吐率为16Tb/s)。

单元数量(可扩展单元)

单元数量决定了交换机网络架构的配置。小批量采用两层结构,而大批量采用三层结构。H100 SuperPOD:每台由32个节点(DGX H100服务器)组成,最多支持4台组成集群,采用双层交换架构。A100 SuperPOD:每台由20个节点(DGX A100服务器)组成,最多支持7台组成集群。如果单元数超过5个,则需要三层交换架构。

四大网络配置下的光模块需求

A100+ConnectX6+QM8700三层网络:比例1:6,全部采用200G光模块。A100+ConnectX6+QM9700两层网络:1:0.75的800G光模块+1:1的200G光模块。H100+ConnectX7+QM9700两层网络:1:1.5的800G光模块+1:1的400G光模块。H100+ConnectX8(尚未发布)+QM9700三层网络:比例1:6,全部采用800G光模块。假设2023年H100出货量为30万台,A100出货量为90万台,总需求量为315万台200G、30万台400G、787.5万台800G光模块。这会导致人工智能市场的显著增长,预计规模将达到13.8亿美元以2024年出货150万台H100和150万台A100为例,200G总需求量为75万台,400G光模块75万台,800G光模块675万台。这将导致人工智能市场的显著增长,预计规模将达到49.7亿美元,大约相当于2021年光模块行业的总市场规模。第一种情况:A100+ConnectX6+QM8700三层网络

A100 GPU设计有8个计算接口,如图所示,左侧有4个接口,右侧有4个接口。目前,A100 GPU的大部分出货量都是与ConnectX-6配合使用,以实现高达200Gb/s的连接速率。

在首层架构中,每个节点有8个接口(端口),节点连接8个叶交换机。每20个节点组成一个单元(SU)。因此,在第一层中,总共需要8xSU台叶交换机,以及8xSUx20根线缆和2x8xSUx20个200G光模块。

在第二层架构中,由于采用了无阻塞设计,上行速率等于下行速率。在第一层中,总单向传输速率为200G乘以线缆数量。由于第二层也采用单缆200G传输速率,因此第二层的线缆数量应与第一层相同,需要8xSUx20线缆和2x8xSUx20 200G光模块。所需脊交换机的数量是通过将线缆数量除以叶交换机数量来计算的,得出所需的(8xSUx200)/(8xSU)脊交换机。但是,当没有足够的叶交换机时,为了节省脊交换机的数量,可以在叶和脊交换机之间建立多个连接(只要不超过40个接口的限制)。因此,当单元数为1/2/4/5时,所需的脊交换机数量为4/10/20/20,所需的光模块数量为320/640/1280/1600。脊交换机的数量不会成比例增加,但光模块的数量会按相同比例增加。当系统扩展到七个单元时,实施第三层架构变得至关重要。由于其非阻塞配置,第三层中所需的线缆数量与第二层的线缆数量保持不变。英伟达(NVIDIA)建议的SuperPOD蓝图需要在七个单元之间集成网络,采用第三层架构及核心交换机。详细的图表说明了不同层的不同数量的交换机以及不同单元数所需的相关布线。

配置140台服务器,参与的A100 GPU总数为1120,计算方式为服务器数量140乘以8。为了支持此配置,需要部署了140台QM8790交换机以及3360根线缆。此外,该配置需要使用6720个200G光模块 。A100 GPU与200G光模块的比例为1:6,具体数量为1120个GPU对应6720个光模块。第二种情况:A100+ConnectX6+QM9700两层网络

目前,该配置方案并不是建议配置的一种。尽管如此,随着时间的推移,越来越多的A100 GPU可能会选择通过QM9700交换机进行连接。这种转变将减少所需光模块数量,但会产生对800G光模块的需求。主要区别可以在第一层的连接中看到,目前使用8根独立200G线缆的方法将被使用QSFP转OSFP适配器替代,每个适配器能够进行两个连接,从而实现1对4的连接。

在第一层中:对于具有7个单元和140个服务器的集群,总共有140x8=1120个接口。这相当于280根1-4线缆,因此需要280个800G和1120个200G光模块。总共需要12台QM9700交换机。在第二层:仅使用800G连接时,需要280x2=5600个800G光模块以及9台QM 9700交换机。因此,对于140台服务器和1120台A100 GPU配置,总共需要21台交换机(12+9),以及840个800G光模块和1120个200G光模块。A100 GPU与800G光模块的比例为1120:840,简化为1:0.75。A1000 GPU和200G光模块的比例为1:1。第三种情况:H100+ConnectX7+QM9700两层网络

H100架构的一个显著特点是,尽管该卡包含8个GPU,但配备了8个400G网卡,这些网卡组合成4个800G接口。这种融合带来了对800G光模块的巨大需求。在第一层中,根据英伟达(NVIDIA)推荐的配置,建议在服务器接口连接1个800G光模块。这可以通过使用带有两根光缆(MPO)的双端口连接来实现,其中每根光缆都插入单独的交换机。

因此,在第一层中,每个单元由32台服务器组成,每台服务器连接2x4=8台交换机。在具有4个单元的SuperkPOD中,第一层总共需要4x8=32台叶交换机。英伟达(NVIDIA)建议为管理目的(UFM)保留一个节点。由于对光模块的使用影响有限,因此我们以4台设备、总共128台服务器为基准进行近似计算。第一层共需要4x128=512个800G光模块和2x4x128=1024个400G光模块。

在第二层,交换机使用800G光模块直接连接。每个叶交换机都以32x400G的单向速率向下连接。为保证上行和下行速率一致,上行连接需要16x800G的单向速率。这需要16个脊交换机,因此总共需要4x8x162=1024个800G光模块。在这种架构中,基础设施总共需要1536个800G光模块和1024个400G光模块。考虑到SuperPOD的完整组成,其中包括128台(4x32)服务器,每台服务器配备8个H100 GPU,总共有1024个H100 GPU。GPU与800G光模块的比例为1:1.5,相当于1024个GPU需要1536个光模块。GPU与400G光模块的比例为1:1,1024个GPU与1024个光模块的数量相等。第四种情况:H100+ConnectX8(暂未发布)+QM9700三层网络

在假设的情景中,如果H100GPU的网卡升级到800G,那么外部接口就需要从四个扩展到八个OSFP接口。因此,层间连接也将使用800G光模块。基本网络设计与初始方案保持一致,唯一的变化是将200G光模块替换为800G光模块。在此网络架构内,GPU数量与所需光模块保持1:65的比例,与初始场景相同。基于上述情况整理,假如2023年H100 GPU的出货量为300000个,A100 GPU的出货量为900000个,将产生315万个200G光模块、300000个400G光模块和787500个800G光模块的总需求。展望2024年,预计交付150万台H100 GPU和150万台A100 GPU,产生需求将包括75万台200G光模块、75万台400G光模块和675万台800G光模块。对于A100 GPU,其连接均匀分配在200G交换机和400G交换机之间。对于H100 GPU,其连接均匀分配在200G交换机和400G交换机之间。综上所述

随着技术的不断进步和发展,网络领域见证了400G多模光模块、AOC和DAC的出现。预计这些将引领高速解决方案进一步的发展,为数字时代的网络需求提供强大的支持。下载链接:

转载申明:转载本号文章请注明作者和来源,本号发布文章若存在版权等问题,请留言联系处理,谢谢。更多架构相关技术知识总结请参考“架构师全店铺技术资料打包(全)”相关电子书(41本技术资料打包汇总详情可通过“阅读原文”获取)。全店内容持续更新,现下单“架构师技术全店资料打包汇总(全)”一起发送“服务器基础知识全解(终极版)”和“存储系统基础知识全解(终极版)”pdf及ppt版本,后续可享全店内容更新“免费”赠阅,价格仅收249元(原总价399元)。

温馨提示:

扫描二维码关注公众号,点击阅读原文链接获取“架构师技术全店资料打包汇总(全)”电子书资料详情。