同一天2篇Nature!清华两个计算团队最新科研突破。芯东西5月31日报道,本周四,清华大学面向类脑计算、量子计算的两项最新科研成果同时发表于国际学术顶级期刊Nature。

其中,清华大学精密仪器系类脑计算研究中心施路平教授团队研制的世界首款类脑互补视觉芯片“天眸芯”更是登上了Nature封面。

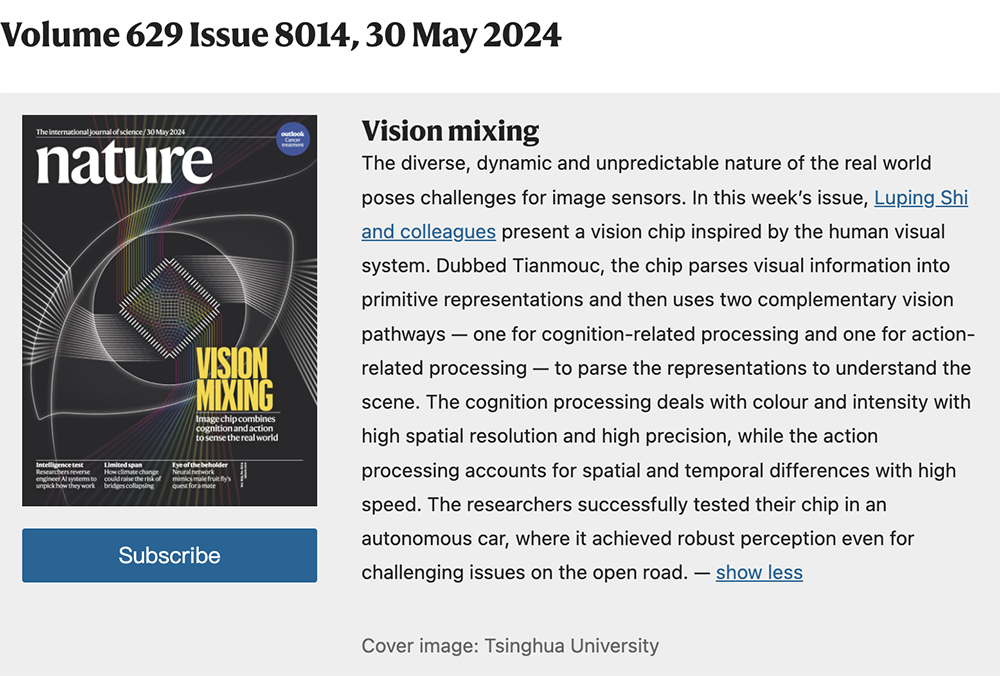

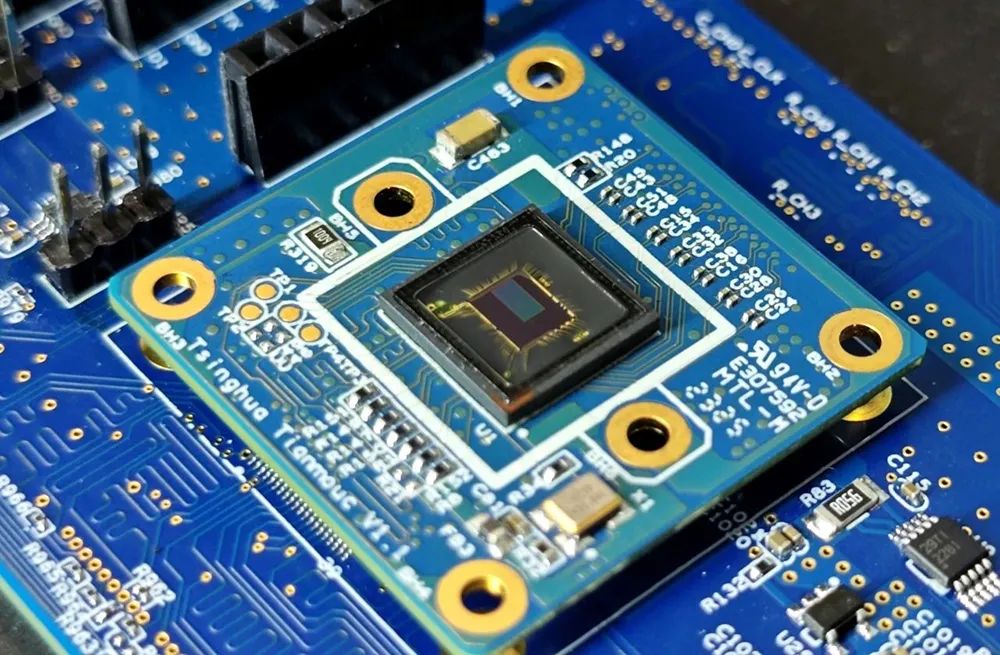

▲类脑互补视觉感知芯片“天眸芯”

这已经是该团队继异构融合类脑计算“天机芯”后第二次登封Nature,标志着我国在类脑计算和类脑感知方向均取得基础性突破。

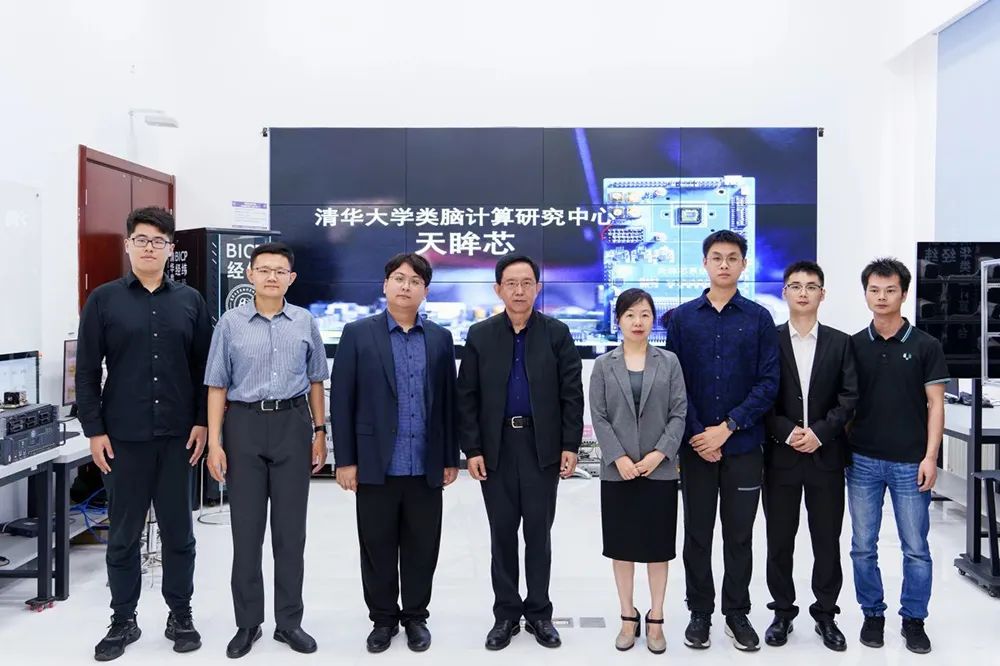

▲“天眸芯”研究团队合影(图源:清华大学)

“天眸芯”论文的通讯作者为清华大学精密仪器系施路平教授和赵蓉教授,共同第一作者是精密仪器系博士杨哲宇(现为北京灵汐科技有限公司研发经理)、精密仪器系博士生王韬毅、林逸晗。

清华大学为论文第一单位,合作单位包括北京灵汐科技有限公司。

论文链接:nature.com/articles/s41586-024-07358-4同日,中国科学院院士、清华大学交叉信息研究院教授段路明带领研究组首次实现基于数百离子量子比特的量子模拟计算。这是国际上最大规模具有单比特分辨率的多离子量子模拟计算。该成果的研究论文发表于Nature官网,被Nature审稿人称为“量子模拟领域的巨大进步”、“值得关注的里程碑”。清华大学交叉信息院院长姚期智院士称赞这项工作打开了量子计算的高维新纪元。

论文链接:nature.com/articles/s41586-024-07459-0该论文第一作者为清华大学交叉信息研究院2020级博士生郭世安,通讯作者为交叉信息研究院段路明教授。其他作者包括交叉信息研究院助理教授吴宇恺,博士生叶京、张霖、王也、严若宇、易雨瑾、许煜麟、侯云瀚,博士后许钰梓、张弛,助理研究员祁宾祥,副研究员周子超、何丽,以及华翊量子公司成员连文倩、姚睿、李博文、郭伟轩。这项研究得到了科技创新2030 —“量子通信与量子计算机”重大项目(2021ZD0301601,2021ZD0301605)、新基石研究员项目、清华大学自主科研计划、教育部、清华大学笃实专项和启动经费的资助与支持。

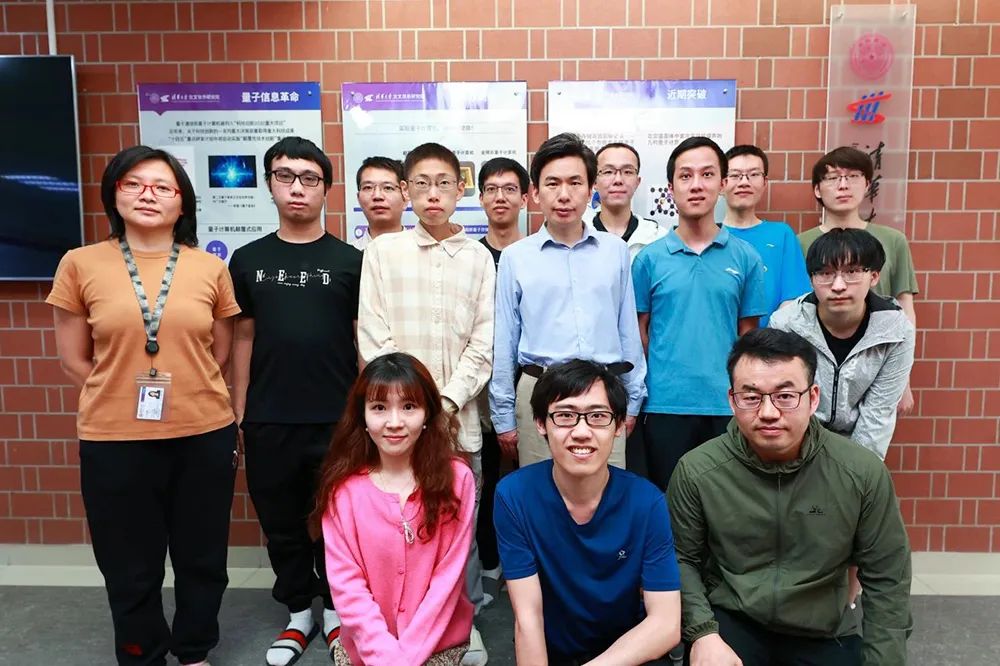

▲交叉信息研究院段路明研究组合影(图源:清华大学)

在无人驾驶、具身智能等智能无人系统中,视觉感知是获取信息的核心途径。但在复杂多变且不可预测的环境里,实现高效、精确且鲁棒的视觉感知是一个艰巨的挑战。智能系统要处理庞大的数据量,还要应对各种极端场景,比如驾驶中的突发危险、隧道口的剧烈光线变化、夜间强闪光干扰等。因受到“功耗墙”、“带宽墙”的限制,应对这些场景时,传统视觉感知芯片常面临失真、失效、高延迟等问题,严重影响了系统的稳定性和安全性。图像传感器向高速、高分辨率、大动态范围和高精度方向发展受到功率和带宽的限制。

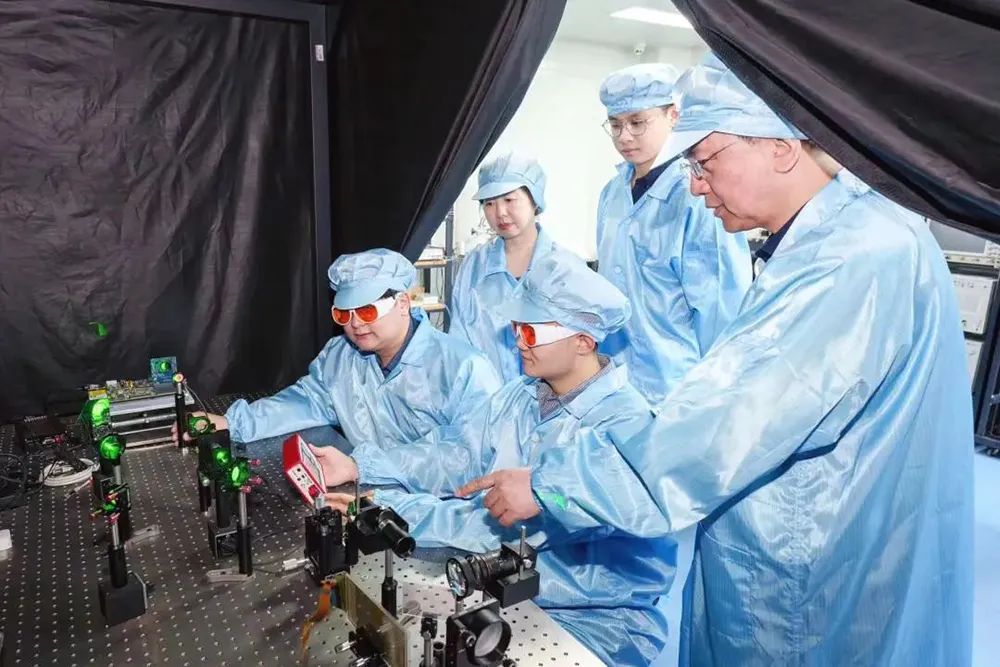

▲类脑计算研究中心施路平教授(右一)和赵蓉教授(左二)指导学生实验(图源:清华大学)

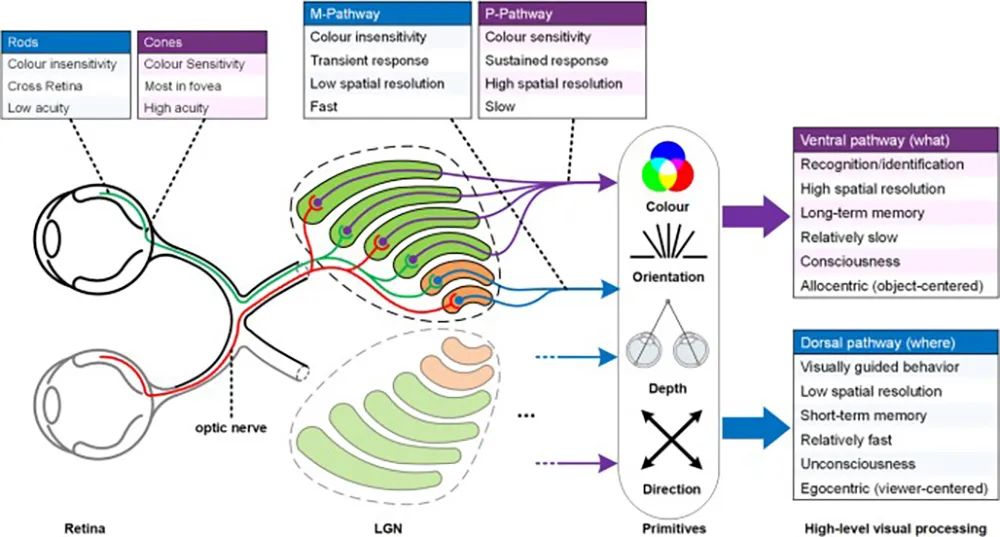

对此,清华大学精密仪器系类脑计算研究团队聚焦类脑视觉感知芯片技术,提出了一种受人类视觉系统启发的互补感知范式。这是一个基于视觉原语的互补双通路类脑视觉感知新范式,借鉴人类视觉系统的基本原理,模仿人类视觉系统的特征,将视觉信息解析成基于源于的表示,并将这些原语组合形成两条优势互补、信息完备的视觉感知通路——用于准确认知的、以认知为导向的通路和用于快速反应的、以行动为导向的通路。

▲人类视觉系统的互补性(图源:Nature)

认知加工处理颜色和强度具有高空间分辨率和高精度,而动作加工处理时空差异具有高速度。基于这一新范式,团队进一步研制出了世界首款类脑互补视觉芯片“天眸芯”。

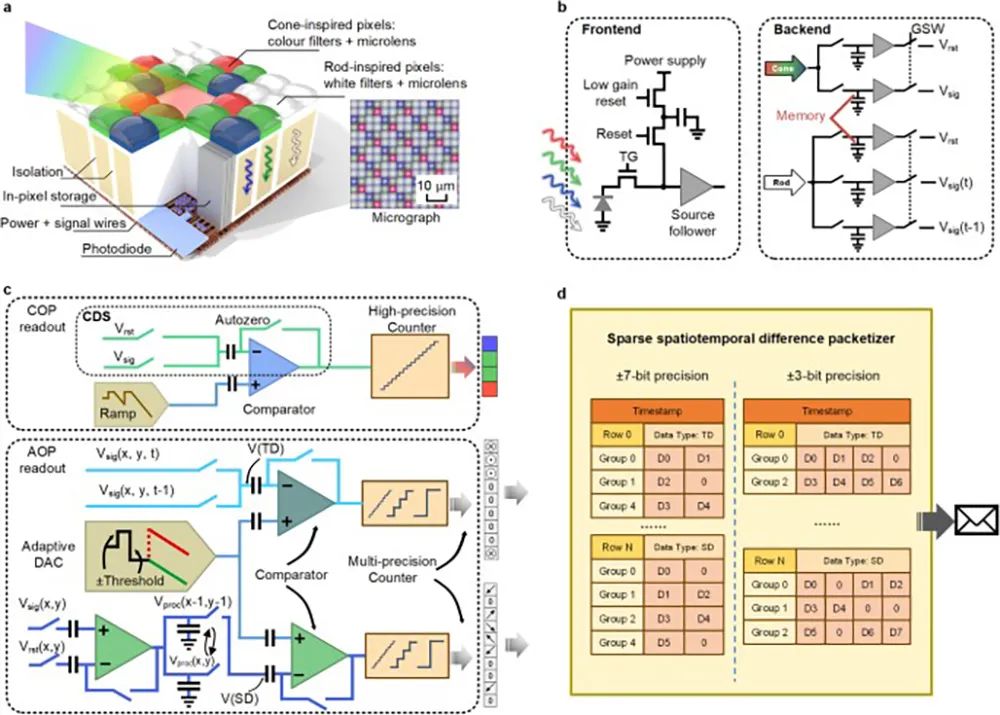

▲天眸芯架构(图源:Nature)

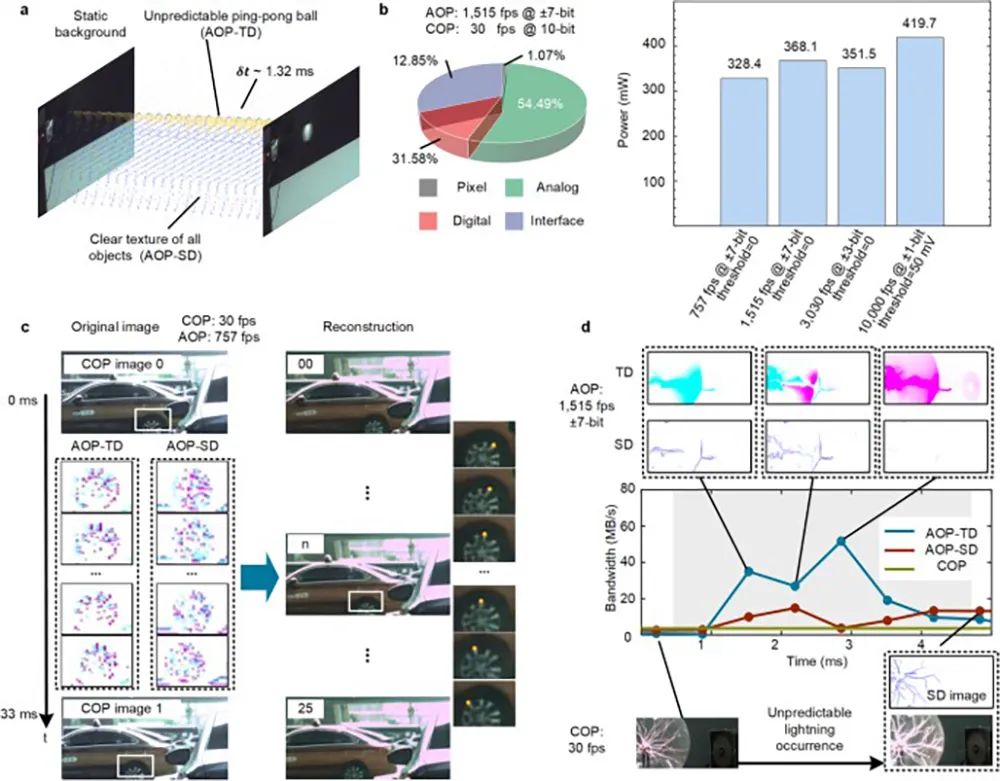

该芯片结合混合像素阵列和并行异构读出架构,利用互补视觉通路特性,实现了每秒10000帧的高速、10bit的高精度130dB的高动态范围的视觉信息采集,并自适应地减少了90%的带宽。

▲芯片特性

基于该芯片,团队还自主研发了高性能软件和算法,并在开放环境车载平台上进行性能验证。

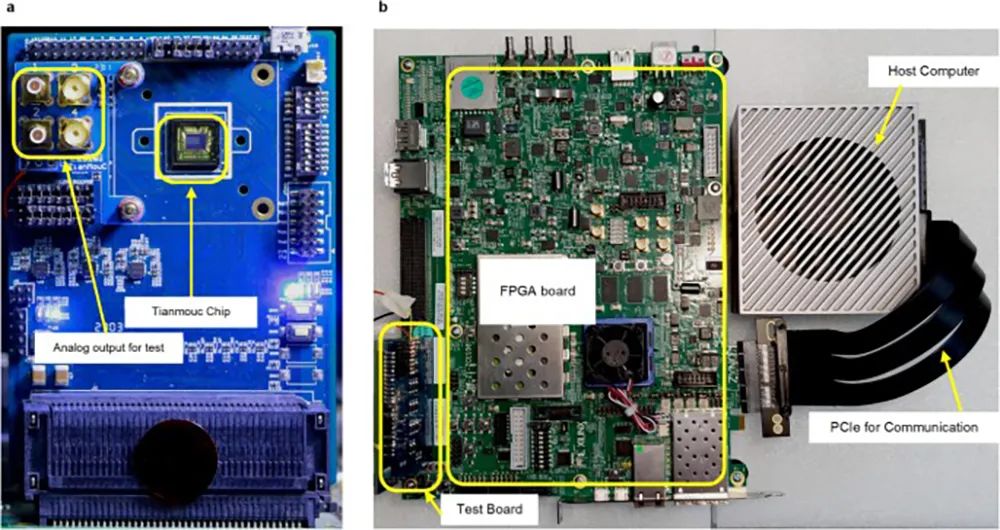

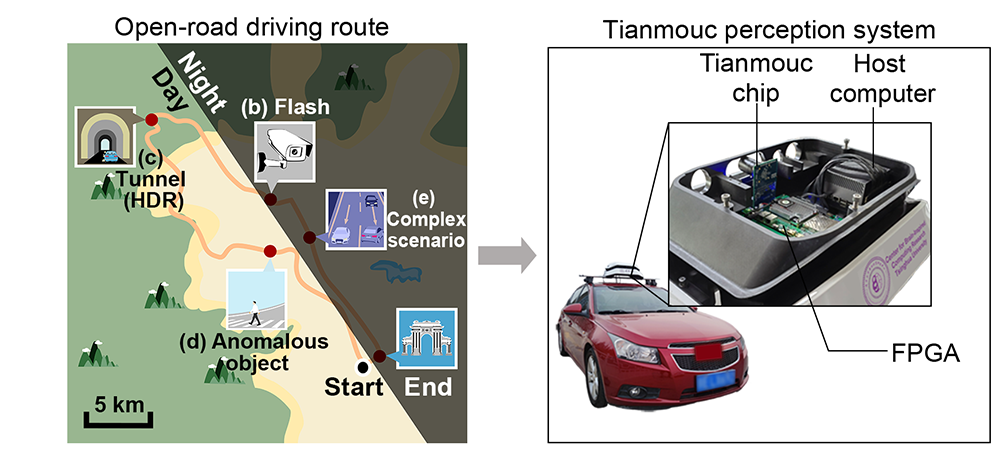

▲天眸芯测试系统(图源:Nature)

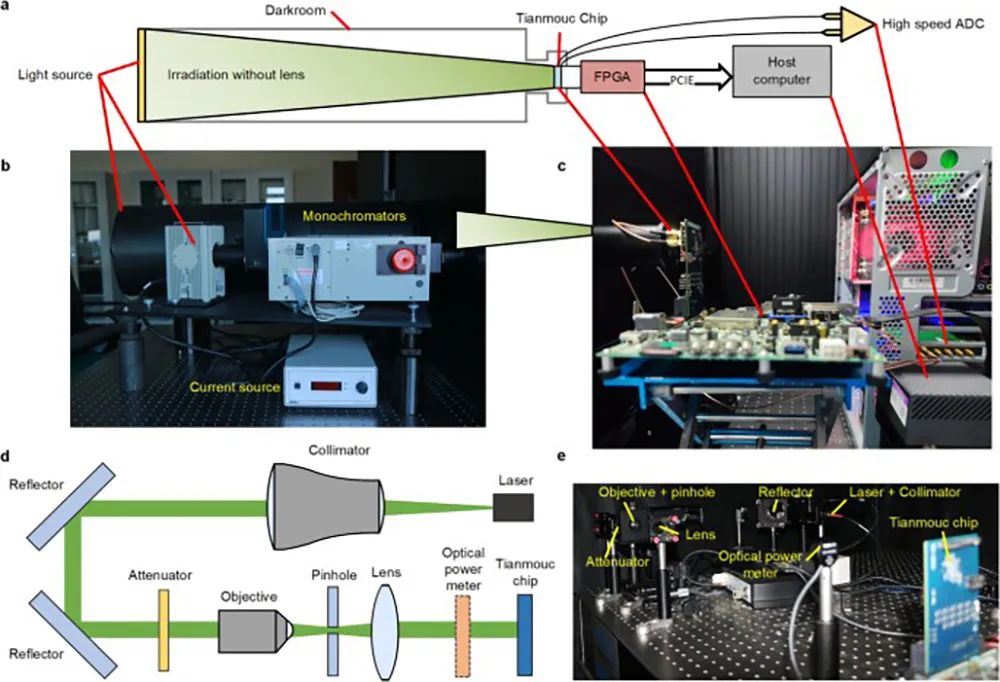

▲芯片特性的实验装置(图源:Nature)

团队成功在一辆自动驾驶汽车上测试了天眸芯,展示了将天眸芯集成到自动驾驶系统中的能力。

▲自动驾驶感知演示平台

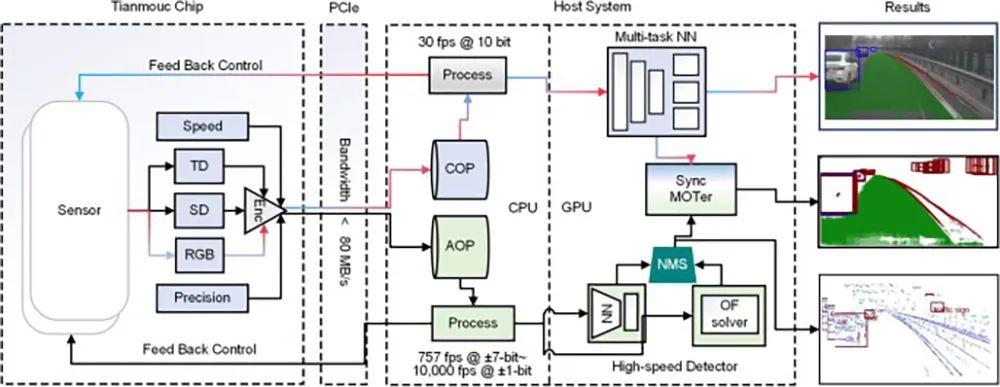

▲开放世界汽车驾驶任务的流感知流水线(图源:Nature)

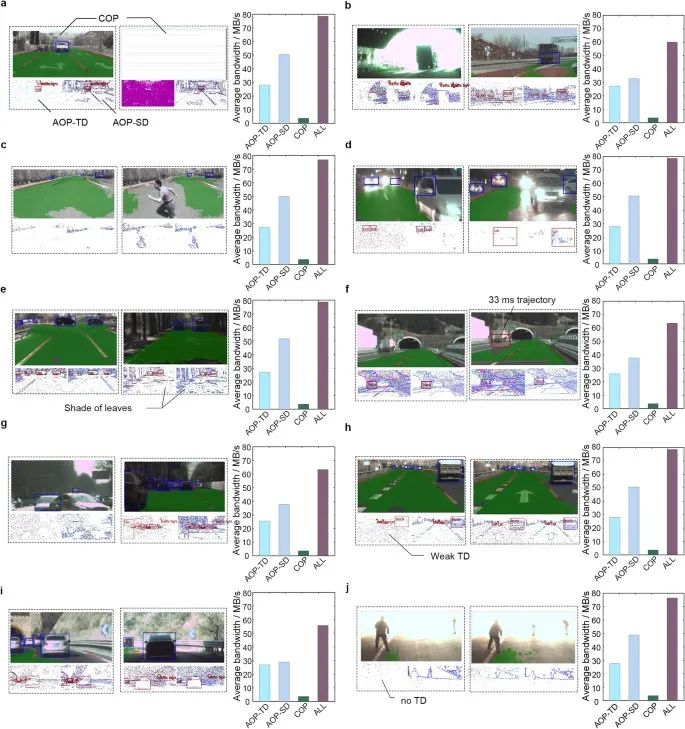

基于原语的互补传感范式有助于克服开发用于各种开放世界应用的视觉系统的基本限制。无论是在开阔的道路上遇到有挑战性的问题,还是在其他多种极端场景下,该系统都能实现低延迟、高性能的实时感知推理。

▲更多案例证明了天眸芯在适应开放世界方面的效率

“天眸芯”的成功研制是智能感知芯片领域的一个重大突破,为自动驾驶、具身智能等重要应用开辟了新的道路。

结合团队在类脑计算芯片“天机芯”、类脑软件工具链和类脑机器人等方面已应用落地的技术积累,“天眸芯”的加入将进一步完善类脑智能生态,推动通用人工智能(AGI)的发展。

作为量子信息处理的主要物理平台之一,离子阱系统被认为是最有希望实现大规模量子模拟和量子计算的物理系统之一。多个实验验证了离子量子比特的高精密相干操控,该系统的规模化被认为是主要挑战。此前研究人员在Paul Trap(保罗型离子阱)中实现了最多61个离子一维阵列的量子模拟。虽然基于Penning Trap(彭宁型离子阱)可实现更大规模约两百离子的量子模拟,但因缺乏单比特分辨探测能力而难以提取量子比特空间关联等重要信息,无法用于量子计算和精密的量子模拟。清华大学交叉信息研究院段路明研究组利用低温一体化离子阱技术和二维离子阵列方案,大规模扩展离子量子比特数并提高离子阵列稳定性,首次实现512离子二维阵列的稳定囚禁和边带冷却,并首次对300离子实现可单比特分辨的量子态测量。

▲实验获得512离子二维阵列图像与典型300离子单点分辨测量结果(图源:清华大学)

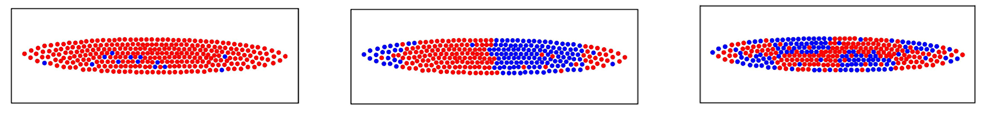

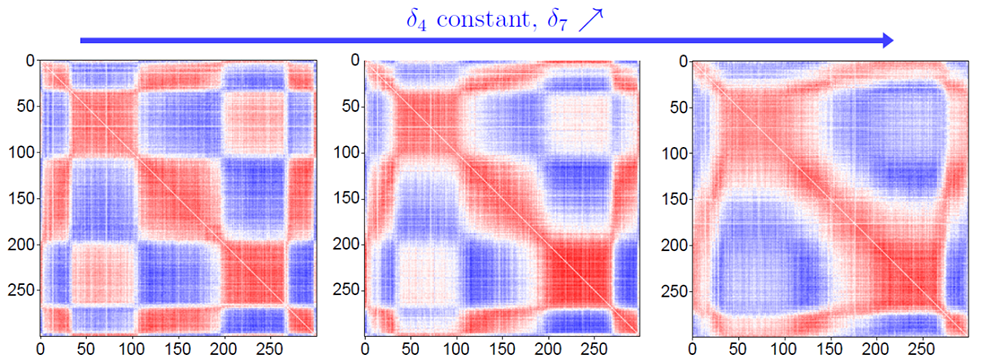

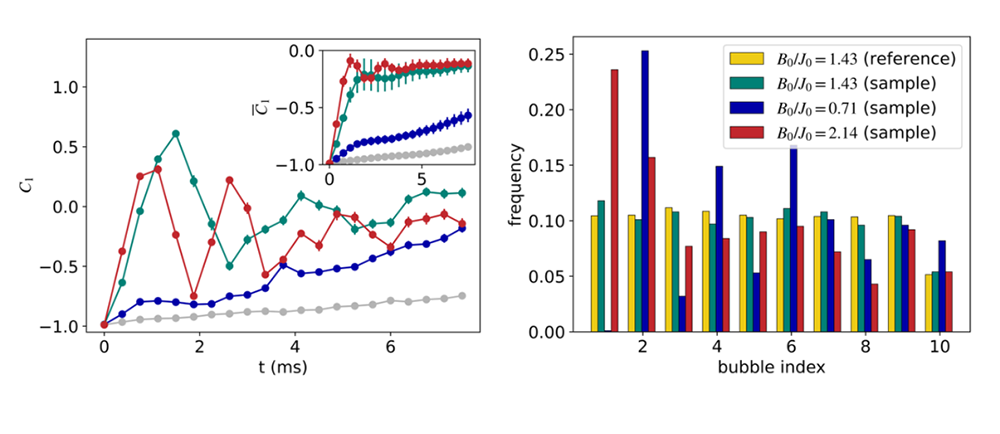

研究人员进而利用300个离子量子比特,实现可调耦合的长程横场伊辛模型(一类重要的量子多体模型)的量子模拟计算。研究人员通过准绝热演化制备阻挫伊辛模型的基态,测量其量子比特空间关联,从而获取离子的集体振动模式信息,并与理论结果对比验证。该工作实现了国际上最大规模具有单比特分辨率的多离子量子模拟计算,将该研究组保持的离子量子比特数国际纪录(61离子)往前推进了一大步,首次实现基于二维离子阵列的大规模量子模拟。

▲典型300离子长程横场伊辛模型的量子模拟计算结果(图源:清华大学)

研究人员还对该模型的动力学演化进行量子模拟计算,并对末态分布进行量子采样,通过粗粒化分析验证其给出非平庸的概率分布,300个离子量子比特同时工作时所能执行的计算复杂度达到2^300,超越经典计算机的直接模拟能力。该实验系统为模拟经典棘手的量子动力学和使用二维离子阱量子模拟器运行嘈杂的中等规模量子算法铺平了道路,为进一步研究多体非平衡态量子动力学这一重要难题提供了强大的工具。

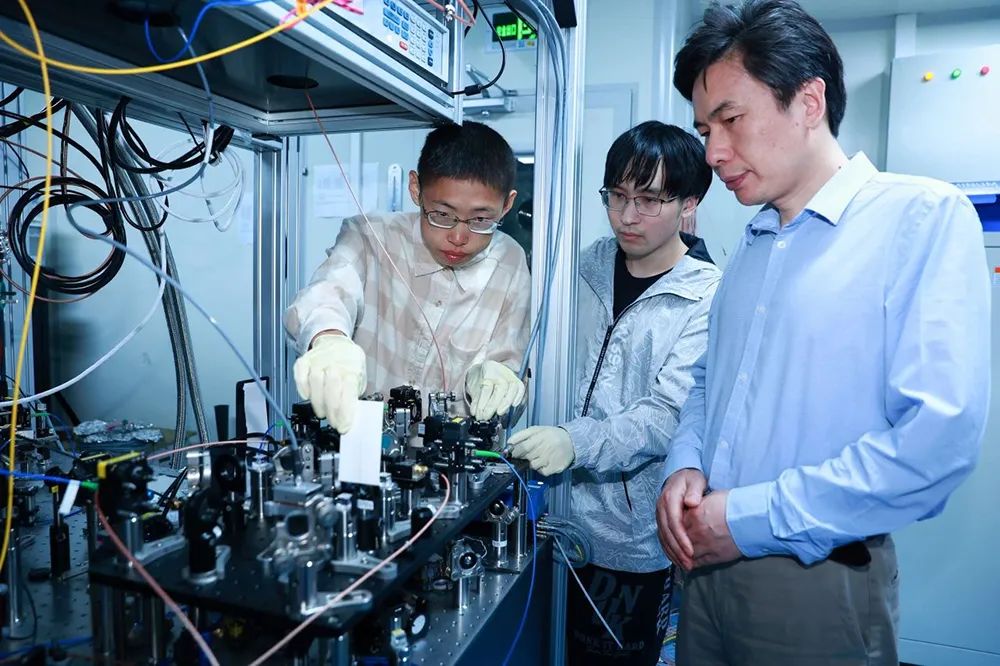

▲段路明院士(右一)指导学生实验(图源:清华大学)

来源:清华大学、Nature

科普视频

科普视频

企业算力利用率提升迫在眉睫,软件调度已成加速计算必要条件。联想集团科普系列主题视频发布,以“万全”之策,打通AI训练全流程助企业释放驾驭海量算力,加速混合式人工智能落地。

科普视频