©PaperWeekly 原创 · 作者 | 苏剑林既然有了一般解,那么自然就会引出一个问题:我们常用的 RoPE,只是一个以二维旋转矩阵为基本单元的分块对角矩阵,如果换成一般解,理论上效果会不会更好呢?本文就来回答这个问题。

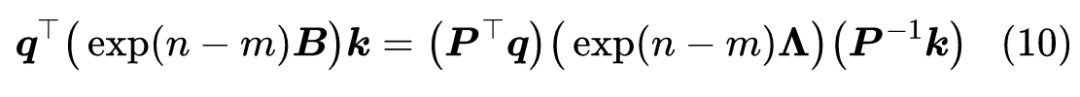

在《Transformer升级之路:二维位置的旋转式位置编码》中,我们将 RoPE 抽象地定义为任意满足下式的方阵

然后,我们探讨了如下矩阵指数形式的解

这里的矩阵指数,不是像 Softmax 那样的激活函数式的 element-wise 运算,而是按照泰勒级数定义的“Matrix Exponential”[1]。根据“Baker–Campbell–Hausdorff 公式”[2],我们有

这里 ,省略的都是 的三次或三次以上的项。按照式(1),那么上式指数部分应该等于 ,这就推出值得指出的是,在实数域内,并不是所有正交矩阵都可以写成 的形式,所以 实际上是比矩阵指数形式更宽泛的解。从《恒等式 det(exp(A)) = exp(Tr(A)) 赏析》[3] 中我们知道 ,所以能写成矩阵指数形式的正交矩阵行列式必然大于 0(即等于 1),事实上这个结果反过来也成立,即行列式等于 1 的正交矩阵,必然可以写成 的形式,其中 是反对称矩阵。(参考《Why can any orthogonal matrix be written as O=e^A》[4])。而对于 的正交矩阵,我们有 ,其中 是对角线元素有一个-1、剩下都是1的对角阵, 则是 的正交矩阵,它可以写成 的形式,此时 。这也就是说,即便对于 的 ,也只是 的简单变换,所以接下来我们主要研究 形式的解。众所周知,我们平时所用的 RoPE 位置编码,是如下形式的分块对角矩阵:这种选择可以说是最简单的一种,其本质原因可以说是为了降低计算量。那么,所谓完备性问题,就是要回答:如上的分块对角矩阵的特例,相比全参数 ,是否有能力上的缺失?换句话说,如果不考虑计算量,将 替换为一般的反对称矩阵,效果是否可能会有提升?回答这个问题不困难,事实上,对于任意偶数阶反对称矩阵,它都可以对角化为分块对角矩阵该结论可以参考 Skew-symmetric matrix [5]。也就是说,存在可逆矩阵 ,使得 ,于是也就是说,任意的 与分块对角的 ,仅仅相差一个相似变换,而我们在 Self Attention 中应用 RoPE 时,是

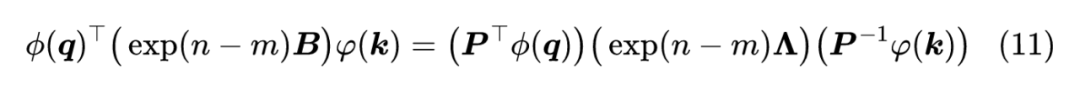

由于 一般都是输入 经过某个可学习的线性变换而来, 原则上都可以吸收到线性变换的训练参数中,因此直接设为 理论上不会损失一般性。所以,对于 Self Attention 来说,问题的答案是否定的。不过,如果是线性 Attention,答案会有少许区别,因为线性 Attention 的 加了个激活函数:

这就导致了 不一定能吸收到线性变换的训练参数中,因此对线性 Attention 补上两个参数矩阵,是有可能带来提升的。本文简单分析了 RoPE 的完备性问题,表明对于 Self Attention 来说,目前的分块对角型 RoPE 不会损失一般性。[1] https://en.wikipedia.org/wiki/Matrix_exponential[2] https://en.wikipedia.org/wiki/Baker–Campbell–Hausdorff_formula[3] https://kexue.fm/archives/6377[4] https://math.stackexchange.com/questions/2467531/why-can-any-orthogonal-matrix-be-written-as-o-ea[5] https://en.wikipedia.org/wiki/Skew-symmetric_matrix#Spectral_theory

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」