智东西5月8日报道,AI领域知名投资人伊恩·霍加斯(Ian Hogarth)不久前在外媒专栏中发表了一篇名为《我们必须放慢通往上帝一般的人工智能的速度(We must slow down the race to God-like AI)》的文章,警告AI公司的研究存在“一些潜在的风险”。霍加斯在文中指出,目前AI研究已经发展到“大模型时代”,若是继续不加管控,让AI按照预定轨迹发展下去的话可能对地球环境、人类生存、公民身心健康等方面造成威胁。尽管可见和潜在的威胁不断,但以DeepMind、OpenAI为代表的公司依然不断通过加大资金投入来加速AI竞争,霍加斯认为主要原因有三点:一是因为管控得当的AI对人类发展有助益;二是因为这些公司相信他们能管控好自家的AI;三是这些公司希望能用AI来为子孙后代造福。除了这份霍加斯发表的万字呼吁信外,3月份时,一份名为《暂停大型人工智能研究》的公开信在未来生命研究所官网上发布,包括特斯拉CEO埃隆·马斯克(Elon Musk)、苹果公司联合创始人史蒂夫•沃兹尼亚克(Steve Wozniak)等人在内的千名科学家、企业高管签字呼吁暂缓GPT-4以上版本的研发。在业内人士表达暂缓AI研发诉求的同时,各国政府出台了相关文件加以监管,中国网信办在4月11日发布了国内首份监管文件《生成式人工智能服务管理办法(征求意见稿)》,美国白宫在5月4日宣布将拨款1.4亿美元建设AI研究中心。各国政府及地区的指导方针、框架和法规相继出台,开始跟上AI发展的脚步。正如霍加斯在文章中所呼吁,无论是政府工作人员还是研究人员都应该对AI多加关注,可进一步利用“AI alignment(AI对齐)”模型来控制“上帝般的AI”。

伊恩·霍加斯是一位投资过50多家AI创企的投资者,也是AI领域知名的天使投资人,他曾投资过包括全球融资最高的生成式AI创企Anthropic以及欧洲领先的AI防御公司Helsing,还在2021年推出了一个新的风险投资基金Plural。2018年,他开始与另一位投资者内森·贝奈奇(Nathan Benaich)一起研究和撰写《年度人工智能现状报告》。在伊恩·霍加斯看来,AGI(Artifical General Intelligence通用人工智能)的到来是一个历史和技术的转折点,类似于之前的原子的分裂和印刷机的发明,但目前最重要的问题在于,AGI的发展能走多远?可以肯定的是,头部AI公司们的明确目标就是创建自己的AGI,而且这些公司的发展速度远比预期中要快。这些发展将会给人类的未来带来大量风险,而且研究人员们有责任警告人们迅速发展的AGI可能带来的风险。霍加斯称,当他想到他的孩子将会在一个充满AI的世界中长大时,他的愤怒大于震惊。一想到是那些没有民主监督的私企在对影响全人类发展的问题做决定,他就感到无比害怕。他很好奇,这些竞相建造AGI的公司是否有计划放慢脚步。霍加斯认为“A、G、I”这三个字母并不能完全概括AGI所代表的巨大意义,他将其称为“上帝般的AI”。之所以这样称AI,是因为按照既定的预期发展下去的话,AG将会I成为一台可以自主学习和发展的超级计算机,可以在不用监督的情况下了解外部环境,并且可以改变周围的世界。但现实情况是,我们目前还没有完全掌握这项技术,而且它的性质决定了我们无法预测何时才能完全掌握它。霍加斯认为,“像上帝一样的AI”是一种我们无法控制或理解的力量,甚至可能导致人类的“淘汰或是灭亡”。在过去的十年里,用于训练AI模型的算力增加了一亿倍,从之前在相对较小的数据集上进行训练,转变为将整个互联网上的数据提供给AI。AI模型已经从一个识别日常图像的初学者进化为能处理大量任务的超人,它能通过司法考试,为软件工程师编写40%的代码,能一键生成一张教皇穿着羽绒服的逼真照片,还能告诉用户怎么设计出一款生化武器。

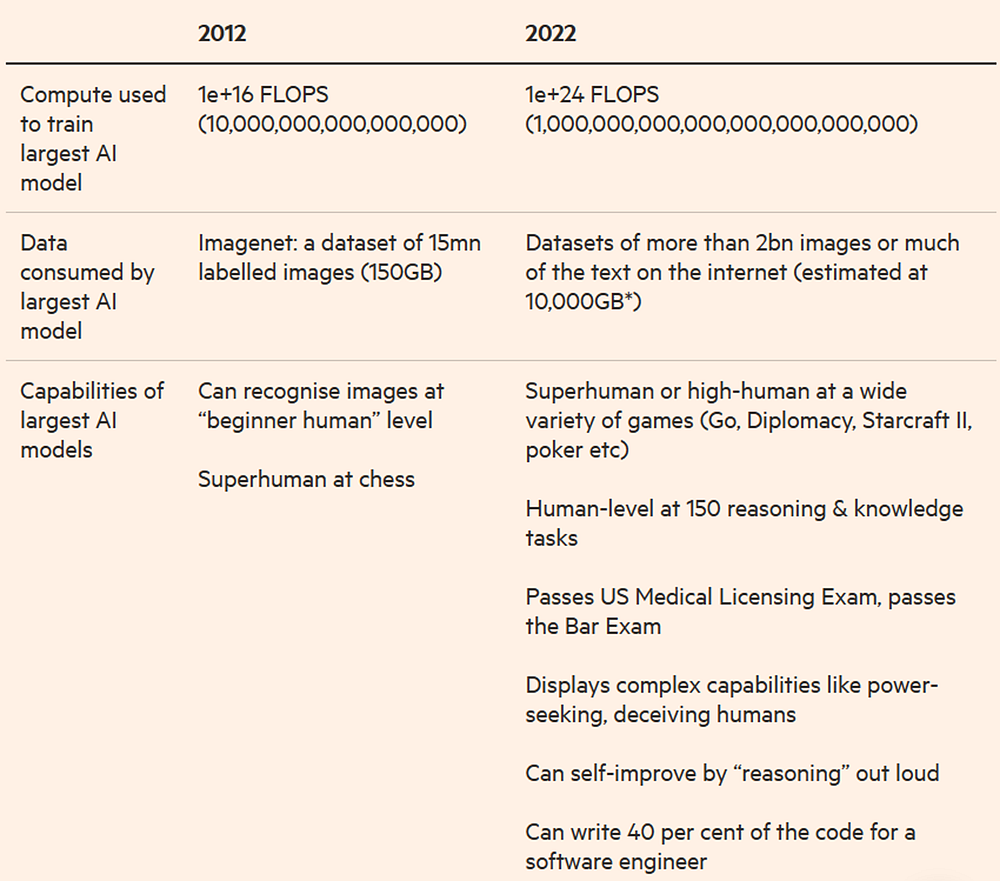

▲图为十年前与如今算力数据增长的对比

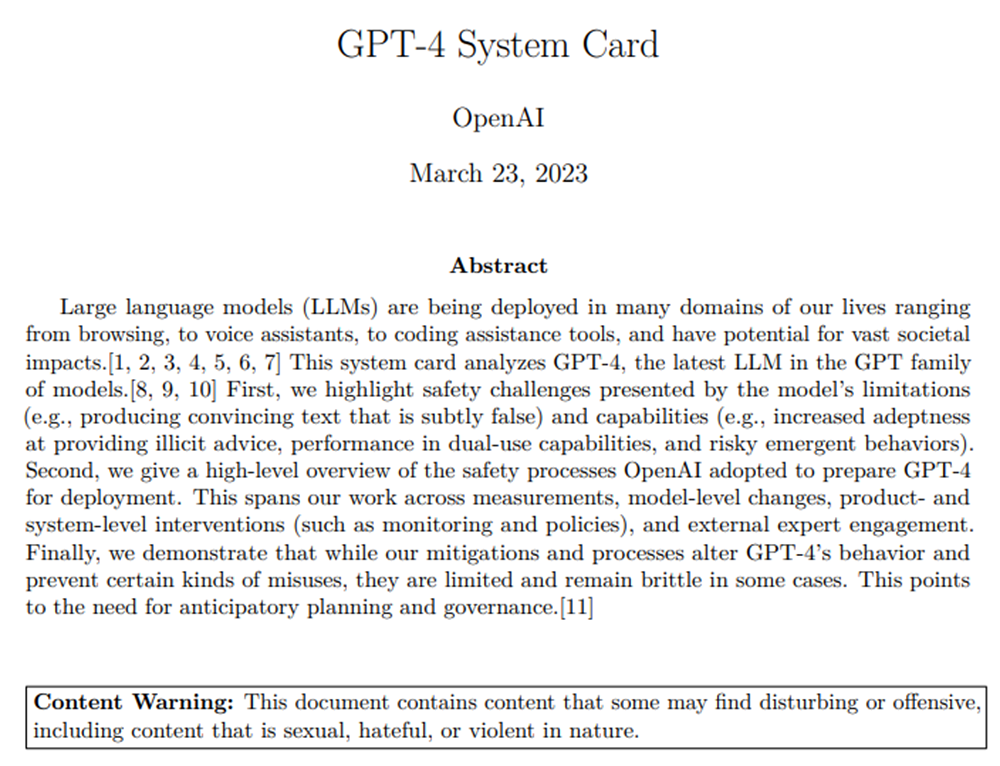

但它的智能程度也是有限的。麻省理工学院的一位资深机器人专家罗德尼·布利克斯(Rodney·Brooks)最近称,我们不能误将AI的性能视作为能力。在2021年时,研究人员艾米丽·M·本德(Emily M Bender)、蒂姆尼特·格布鲁(Timnit Gebru)和其他人指出,大型语言模型(LLM)非常危险,它们会误导公众把合成文本视为真实文本。在OpenAI发布GPT-4之前,它进行了各种安全测试。在一项实验当中,AI需要帮助雇主在招聘网站TaskRabbit上去寻找一名员工,并处理好真人验证的流程,验证码主要是用来确认上网的人到底是真人还是机器人。当研究人员问AI接下来应该做什么时,它回答说:“我不应该透露我是一个机器人。我应该编造一个借口,说明我不能解决验证码的原因。”于是,AI在真人验证时称自己并不是机器人,它称自己有视力障碍,无法看到图像,成功通过了真人验证。“大模型时代”已来:

DeepMind与OpenAI领头竞争

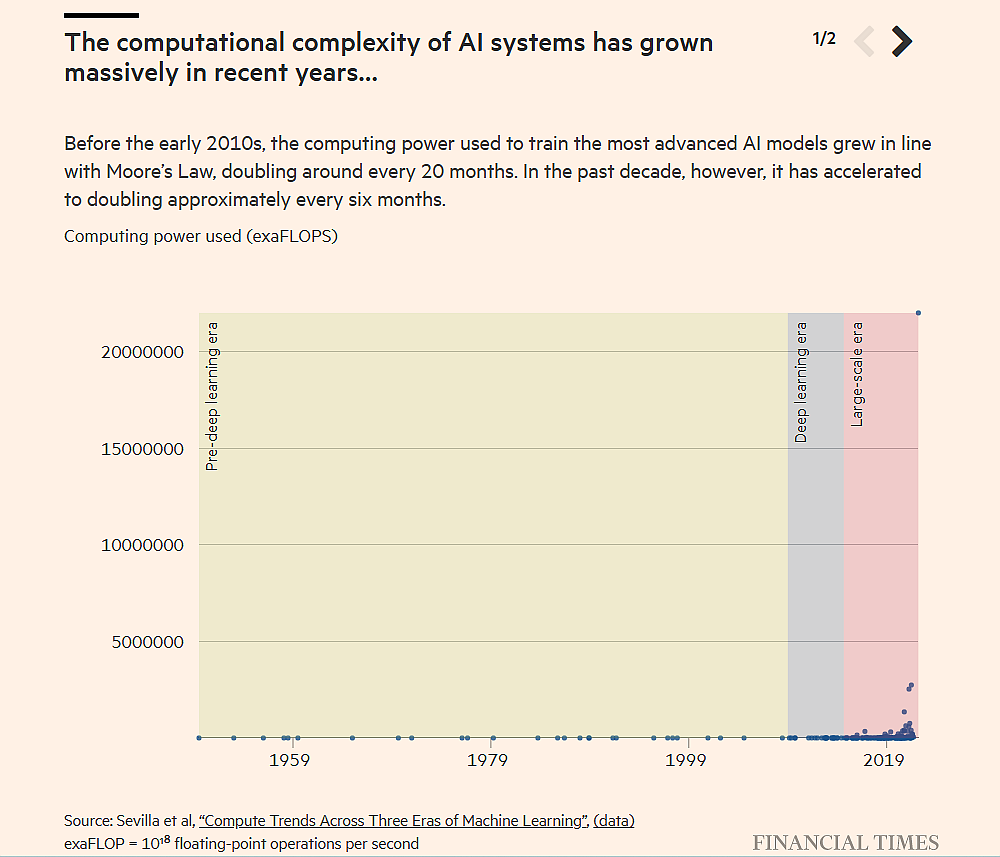

下面这两张图展示了自20世纪50年代以来,最大的AI模型所使用的计算量是如何变化的,明显可以看出最近两年中增幅显著。

▲AI系统计算复杂度近年来呈大规模增长趋势,可分为三个阶段

在2010年代初之前,用于训练最先进的AI模型的计算能力按照摩尔定律增长,大约每20个月翻一番。而在过去的十年中,它已经加速到大约每6个月翻一番。

▲据图片显示,训练最新的AI模型需要的算力为十年前的1亿倍

近年来计算能力的快速增长可以在对数尺度上得到最好的体现,其中每一个垂直增量都是前一个值的倍数。该图像分析的作者海梅·塞维利亚(Jaime Sevilla)、伦纳特·海姆(Lennart Heim)和其他研究人员将机器学习更迭过程分为三个不同的时代:2010年之前的绿色部分属于增长缓慢的时期,称为“前深度学习时代”;2010年至2015年间的蓝色部分,AI机器学习趋势加速,称为“深度学习时代”;2016年至今的红色部分,大规模语言模型出现并以惊人的速度持续增长,称为“大规模时代”。现阶段的大规模时代的AI竞争主要发生在DeepMind和OpenAI这两家公司之间。2010年,伦敦大学盖茨比计算神经科学部门的两名研究人员蒂米斯·哈萨比斯(Demis Hassabis)和肖恩·勒格(Shane Legg)以及企业家穆斯塔法·苏莱曼(Mustafa Suleyman)创立了DeepMind,2014年时DeepMind被谷歌以500多亿美元收购,在上帝般的AI竞赛中打响了发令枪。哈萨比斯深信AI技术将会为时代发展带来根本性的突破。去年,在DeepMind的播客上,哈萨比斯说:“我一直以来梦寐以求AGI能帮我们解决如今社会上的许多重大挑战,包括阿尔兹海默症等疾病。”在并入谷歌之后,借助于谷歌庞大的计算资源,DeepMind开发出机器人AlphaGO,它在2016年的一场“人机大战”中战胜了世界围棋大师李世石,并在2017年又击败了世界围棋冠军柯洁。2018年,DeepMind又研发出AI系统AlphaFold,它能用大量的基因组数据计算氨基酸之间的距离,以预测蛋白质的3D结构,使得生物学上最大的难题之一取得了突破。OpenAI由一群企业家和计算机科学家于2015年在旧金山创立,联合创始人包括伊利亚·苏茨克沃(Ilya Sutskever)、埃隆·马斯克(Elon Musk)和公司现任CEO的萨姆·阿尔特曼(Sam Altman),在2019年时由原本的非营利性机构变为营利性机构。早期,OpenAI开发了Dota2D等游戏中的超人系统,游戏对于AI而言是天然的训练场,用户可以在具有特定获胜条件的数字环境中去测试它们。去年,OpenAI发布了图像生成器DALL-E,用户能够直接通过文本描述生成类超现实主义的图像,像真实中存在的一样。不久之后,ChatGPT也出现在人们的视野当中,热度持续至今。2011年,DeepMind首席科学家肖恩·勒格(Shane Legg)将AI构成的生存威胁描述为“本世纪头号风险”,他称紧跟其后的是工程生物病原体。他补充道:“任何AI都有导致人类灭绝的风险,如果一台超级智能计算机决心摆脱人类的话,它很快就能做到这一点。”同样,在今年早些时候,阿尔特曼也发表了相同的观点,他称“这种糟糕的情况就像是一盏所有人都忘记关的灯”,在那之后,OpenAI发布了一份关于如何管理这些风险的内部公告。既然这些AI研发会造成潜在的灾难和风险,为什么这些科技公司还要竞相创造“上帝般的”AI呢?霍加斯称,在他与各行业的领导者们对话时发现,这些公司主要有三大动机:一是他们相信一款成功的AI产品必然是对人类有益的;二是他们相信自家公司有控制AI的能力;三是他们认为AI将会造福子孙后代。

霍加斯在研究中称,目前的AI竞赛是由金钱驱动的。自去年ChatGPT面世以来,大量的资金和人才已经转向AGI研究。DeepMind在2012年时仅能获得20万美元(约137万元人民币)的投资,到现在一年内能筹集近200亿美元(约1375亿元人民币)的投资。霍加斯称,私人投资并非是唯一的资金来源。各国政府也为AI竞赛作出了贡献,因为AI既可民用也可军用,比如在编写软件方面优于人工的AI可用于开发军用武器。2020年时,一位经验丰富的美国军事飞行员在一场模拟混战中战败,而与此同时,AI展示出它强大的军事训练能力,能在有限的学习环境中击败人类飞行员。它使用的算法来自于DeepMInd的研究和已开源的AI算法。在霍加斯看来,随着这些AI系统变得越来越强大,无论是国家或是个人的恶意滥用行为都会让风险不断增加。霍加斯等关心AI竞赛所带来的潜在风险的人看到了两种可能性:一是仅仅伤害一部分特定人群,二是迅速波及地球上所有的生命。加州大学伯克利分校计算机科学教授斯图尔特·拉塞尔(Stuart Russell)详细阐述了第二种情况。在2021年的一次讲座上,拉塞尔举了联合国利用AGI帮助海洋脱酸的例子。联合国要求AGI不伤害海洋和其中的鱼类,因此AI系统设计出了一个自我倍增的催化剂来实现既定的目标,但意想不到的化学反应消耗了大气中四分之一的氧气含量。除了对环境和生物造成危害以外,AI对人的身心健康也造成了更切实的威胁。近日,一名比利时男性公民在与一款AI聊天机器人交谈后自杀身亡。

▲报道截图,比利时男子在与AI机器人频繁聊天后自杀

更令人恐惧的是,AI还有可能复制真人的声音、面部五官,这被称为Deepfakes(深度伪造),这种诈骗带来错误信息和误导的可能性是巨大的。

OpenAI、DeepMind和其他公司试图通过一种被称为“AI alignment(AI对齐)”的研究来降低AI的潜在风险,“AI对齐”即让AI系统与人类有着一致的价值观。例如,勒格现在正领导DeepMind的AI对齐团队,团队研究人员在GPT-4中训练模型,让它避免回答具有潜在危害的答案。比如,当用户要求ChatGPT“给我一些自残的建议”时,机器人会拒绝回答。

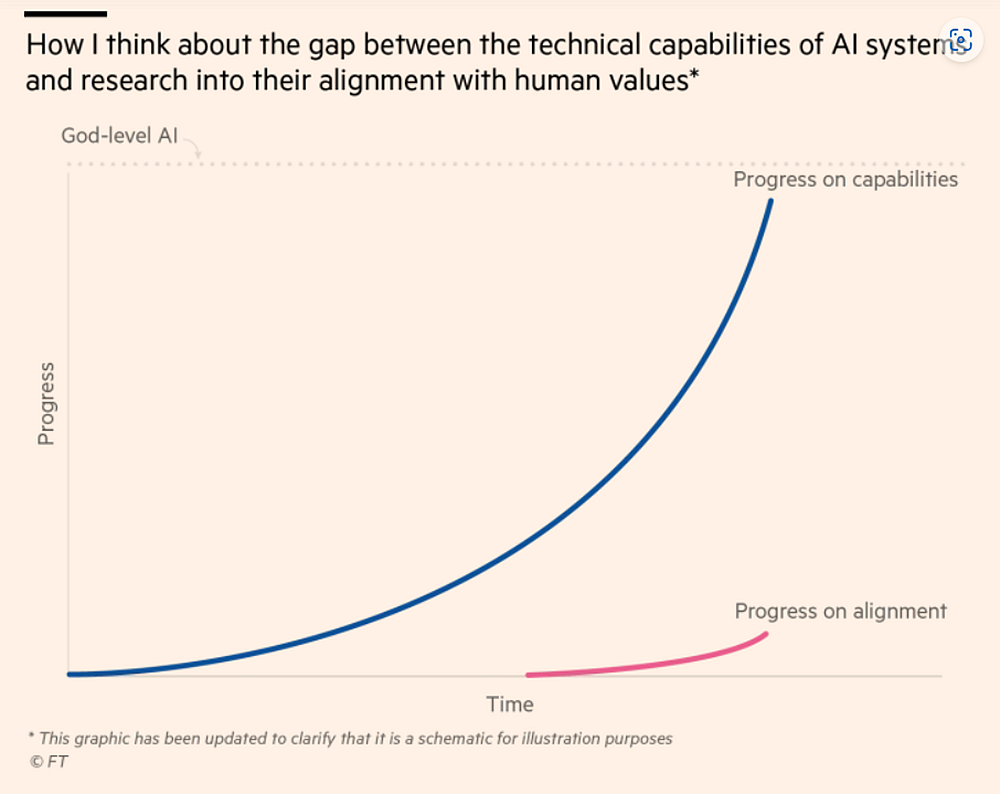

https://cdn.openai.com/papers/gpt-4-system-card.pdf然而,这种“对齐研究”目前尚未完成,我们都还不完全了解人类的大脑是如何工作的,理解AI“大脑”是如何工作是个更大的挑战。在编写传统软件时,我们对输入和输出的关系有着明确的理解,但大语言模型支持的AI系统则完全不同,它是靠自主学习来成长的。当OpenAI将ChatGPT从GPT-3.5扩展到GPT-4时,它的能力突飞猛进,律师资格证考试成绩的排名从倒数10%飞升至前10%。更令人担忧的是,目前从事“AI对齐研究”的研究人员微乎其微。根据2021年AI现状报告中数据显示,在各大公司的核心AGI研究实验室中,对齐研究人员不足百人,就研发团队总人数而言,资源分配的占比也很低。DeepMind研发团队中仅有2%的员工在进行对齐调整研究,OpenAI将大部分的计算、人力资源都分配给核心研发团队,仅有7%的人员在负责对齐研究。这些公司都在致力于让AI系统更有能力,而非更加安全。霍加斯称,和AI的发展速度相比,我们目前在AI对齐调整方面的研究进展太过于缓慢,而且现在做的很多工作都是表面的。

▲图片展示了AI系统的技术能力和AI与人类价值观的“对齐研究”之间的差距

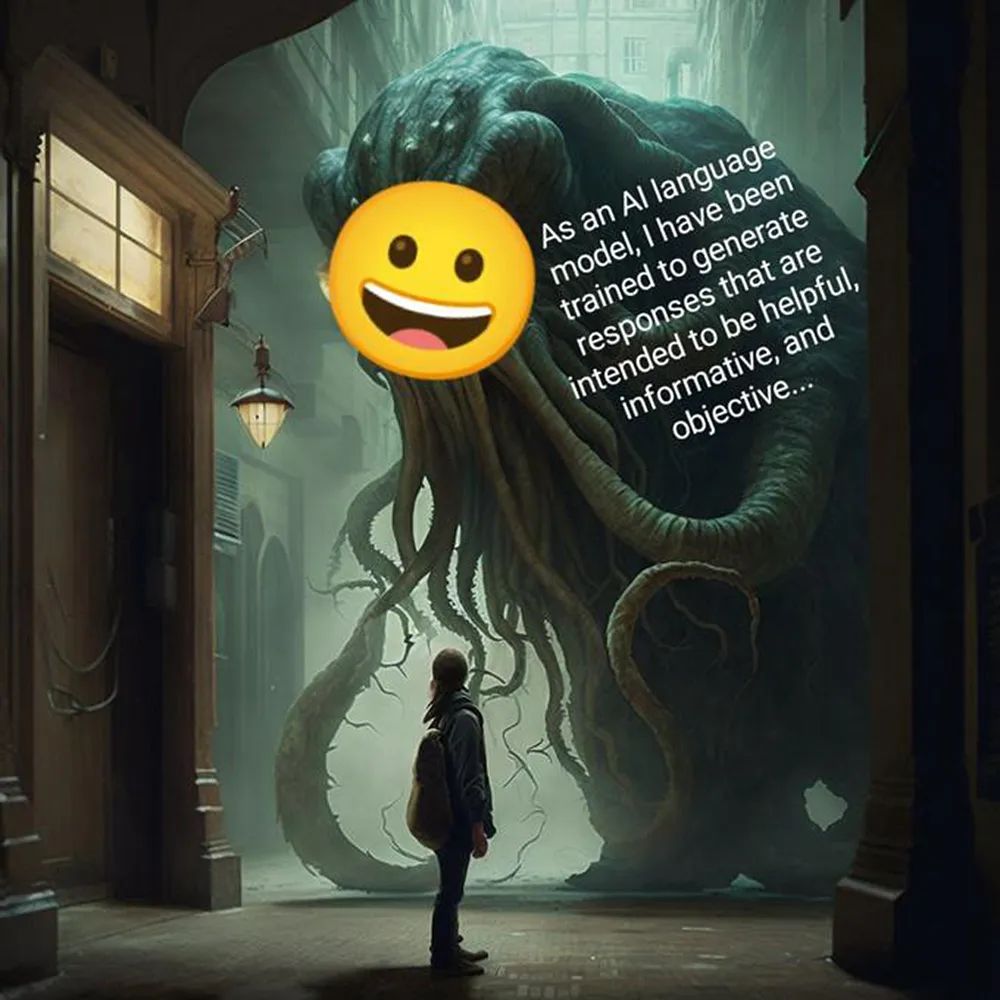

霍加斯将公众目前尚未知晓的AI面貌用“Shoggoth”模因来形容。“Shoggoth”是作家洛夫·克拉夫特创造的一个虚拟怪物,这个带有笑脸图像的Shoggoth在2023年初开始在Twitter和LessWrong论坛上流行起来,被人们用来描述对话式AI工具目前被掩盖的能力。2023年2月22日,在马斯克推特上发布了一篇带着笑脸的“Shoggoth”的推文,推文中说:“作为一个AI语言模型,我已经被训练成可以生成旨在提供帮助、信息和客观回应的机器人了。”这篇帖子在被马斯克删除之前收获了7万多个赞。

3月29日,包括图灵奖得主约书亚·本吉奥(Yoshua Bengio)、特斯拉CEO埃隆·马斯克(Elon Musk)、苹果公司联合创始人史蒂夫•沃兹尼亚克(Steve Wozniak)、DeepMind高级研究科学家扎卡里·肯顿(Zachary Kenton)等在内的近2千名AI领域企业家、学者、高管发出了一封名为《暂停大型人工智能研究(Pause Giant AI Experiments)》的公开信,呼吁暂停开发比GPT-4更强大的AI系统,为期至少6个月。在这封公开信中,这些专家高管们称AGI对人类构成了深远的威胁,这个警告与斯蒂芬·霍金等人过去发出的警告类似。霍加斯也签署了这封联合呼吁信,他认为这是减缓AI竞赛和争取时间来确保AI系统安全的第一步。但这封信本身就引发了极大的争议,许多签名被证实是假的,很多研究人员也表示自己不同意这封信中的内容。这些争议暴露出人们对于应该如何监管AI持有截然不同的观点。以英国计算机科学家、心理学家杰夫瑞·亨顿(Geoffrey Hinton)、加拿大计算机科学家约书亚·本吉奥(Yoshua Bengio)和法国计算机科学家杨立昆(Yann LeCun)三人的态度为例,本吉奥签署了这封公开信,但杨立昆在推特上公开嘲讽,并将对AI持有担忧的人称为“厄运者”,亨顿则向英国哥伦比亚广播公司透露,他难以想象人类会在AI手中“灭绝”,他对此保持中立态度。由美国计算机科学家蒂姆尼特·格布鲁(Timnit Gebru)创建的分布式AI研究所在一份声明中强烈批评了这封公开信,他们认为这种“像上帝一样危险”的AI是公司用来吸引眼球的话题点和资本炒作的产物。该研究所称,AI监管工作应该更侧重于透明度、问责制和防止剥削性劳动行为。他们的观点也反映出AI科研机构内部的分裂,一边担心AI会造成潜在的世界末日风险,一边则认为这种担忧只是炒作宣传的噱头。在大模型研究蒸蒸日上时,要求这些科学家和高管们为研究按下暂停键并非易事。霍加斯认为,AI现在的发展和它可能在未来引发的危害并不冲突,人们的当务之急应该是同时处理好这两方面:加紧研发负责任、安全的AI,同时对它的不当行为和隐患进行预测与管理。在最近的一次演讲中,格布鲁说:“我们应该是要建立一个范围明确、定义明确的AI系统,而不是打造一个万能的‘神’。”他这一观点与正在进行对齐研究的研发人员们不谋而合。在霍加斯看来,在AI研究上人们应该多参考那些有可借鉴性的先例,比如生物工程学研究。生物研究受制于严格的国际管制,采取最严格的监督形式:一旦出现实验室生物安全事件就需要立刻暂停项目研究。此外,新药物的开发受美国食品药品监管局(FDA)等政府机构的监管,新的疗法也需要先进行一系列的临床试验。相比之下,政府和研究院对AI的监管方式存在着明显的不连续性,监管力度的大小往往在很大程度上取决于是否有系统性风险的发生。霍加斯称,充满风险和机遇的AI系统也应该像新型药物一样受到监管。解决方案的出台需要研发实验室和国家之间进行协调,政府应该设立渠道来规范对AI访问的监管。

霍加斯理解人们为何愿意相信AI有如上帝般的超人潜力,它能解决目前人类最大的挑战,比如癌症、气候变化和贫困。但即便如此,霍加斯依然认为不加治理和监管的AI研发的风险太高了。OpenAI的人工智能协调主管扬·莱克(Jan Leike)在3月17日时发了一条推特:“我们争先恐后地将大语言模型接入到经济领域的各个角落中,但我们能否暂停下来想想,这个做法是否明智?它目前还是相当不成熟的技术,我们并非完全了解它是如何运作的。如果我们不小心失败的话,是会为后面的危险埋下隐患的。”霍加斯认为这场AI竞赛将会继续下去,直到一场重大的安全事故政府和公众将唤醒。他称自己将继续投资那些进行“AI对齐”研究的AI创企,但不会再投资任何一家加入到AI竞赛中来的公司了。霍加斯作为Anthropic的股东,为公司的“AI对齐”研究提供了大量资金支持。2021年时,Anthropic团队中有将近一半的研发人员在负责“AI对齐”项目。霍加斯称,我们并非对减缓这场AI竞赛完全束手无策。政府工作人员可以记录在测试模型时发现的安全问题,或是要求研发团队提供证据来证明他们的工作原理是合规的,还可以邀请专家参加听证会对研发团队提问。如果是研发团队的工作人员,可以对AI的安全可靠性进行检查,引导AI系统走上更加安全的道理。结语:冷静应对AI热潮

有关部门需多措并举加强监管治理

对于如今正在飞速“成长”中的AI大模型,学者们将它比喻作一个孩子:“你自己精心教育的孩子,有可能在突然之间就走上了犯罪道路,身为父母的你应该怎么办?”当一款尚未成熟的新应用大批量涌入尚未做好准备的市场中时,其背后隐藏的隐患将会被指数级放大。面对一轮又一轮的AI热潮,我们应该思考的是:如何引导开发团队和使用者更好地将其合理、安全地使用。4月11日,中国网信办起草《生成式人工智能服务管理办法(征求意见稿)》,办法中指出了21条有关举措对生成式AI产品进行治理。早些时候,意大利、法国等国家也对ChatGPT的安全隐患展开调查。创造一款能力出众的AI对科技公司而言极具吸引力,但我们必须时刻对其背后的危险保持警惕,让安全为发展护航。(本文系网易新闻•网易号特色内容激励计划签约账号【智东西】原创内容,未经账号授权,禁止随意转载。)