高考期间,大模型再次“卷”起来了。ChatGPT、文心一言、通义千问、360智脑等大模型纷纷参与到押题、模拟答题、模拟写作文等环节,在“线上考场”赚足眼球。当前,“模型热”经久不散,业内普遍认为,“这是人类历史上距离实现通用人工智能最近的时刻”。也正因如此,国内“百模大战”愈演愈烈,其中10亿以上参数规模大模型已达到79个。然而,大模型是不是越多越好?中国到底需不需要这么多大模型?“模型热”下或许还需要一些“冷思考”。

中国大模型数量进入第一梯队

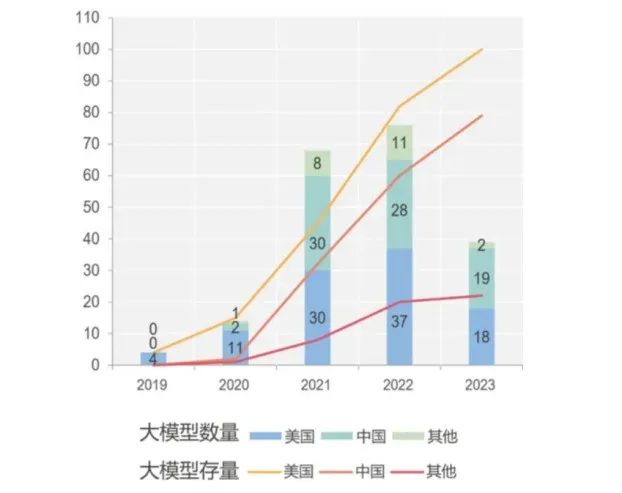

中国科学技术信息研究所发布的一份报告显示,从全球已经发布的大模型分布来看,美国在大模型数量上居全球之首,中国从2020年进入大模型快速发展期,目前与美国保持同步增长态势,中国和美国超过全球总数的80%。

据了解,早在2020年,美国就推出了11个大模型,其中包括著名的GPT-3。彼时,中国只推出了两个人工智能大模型。不过,短短三年时间内,中国10亿以上参数规模的大模型已经发布了79个,与美国现有的100个大模型在数量上已相差无几。

尤其值得一提的是,截至5月底,中国今年已开发出19个大模型,而美国年内推出了18个大模型,包括新发布的GPT-4。这意味着,中国大模型的开发速度已呈现出赶超美国的趋势。

全球大模型分布情况

来源:中国人工智能大模型地图研究报告

报告显示,截至目前,国内共计14个省区市正在开展大模型研发,主要集中在北京、广东、浙江、上海等地。各地密集发布的方针政策为捕捉大模型机遇、探索通用人工智能新路径创造了良好氛围。

国内市场呈现出了百花齐放的发展趋势,不仅有百度、华为、阿里、腾讯、京东、字节跳动、科大讯飞、商汤等先后公布大模型进展;还有AI创业圈大佬,如出门问问创始人李志飞、搜狗创始人王小川、美团联合创始人王慧文和元老级高管陈亮等投身其中;中科院自动化研究所、上海人工智能实验室、复旦大学、清华大学等科研院所也纷纷入局。整体来看,国内大模型数量增长之快、入局者之多、市场热度之高令人惊叹。

“多而不强”是中国大模型现状

“之前,无论从AI论文发布数量、引用量、专利数,还是从人工智能企业、独角兽数量来看,我们对中国在人工智能方向上的发展还是非常乐观。但在ChatGPT发布之后,大家突然发现中国人工智能的发展还有很多问题待解决。”中国科学院计算技术研究所研究员张云泉感叹道。

模型多而不强成为关注焦点,以至于业界纷纷质疑是否需要那么多大模型。“国内的大模型在能源消耗和数据消耗方面与国外的大模型相差不多,效果却差很多,在性能方面还有很大提升空间。”中国科学院院士陈润生坦言,“现在有这么多企业、机构都要做大模型,这是行不通的,实际上根本没有那么多的数据源,也没有那么多算力可供消耗。”

“实际上,国内有3、4个通用大模型就够了,蜂拥而上反而会导致很多重复的投资,产生一些低质量的产品。”晟云磐盾信息技术有限公司总裁郝峻晟向记者表示,“大模型是高投资、低商业回报的项目,OpenAI投入了130亿美元来做ChatGPT,一开始并不知道会取得如此大的成功,只是为了技术信仰而已。但是这一点大部分公司都做不到。未来只有愿意在某个技术领域持续进行长期、大量投入的公司才可能有机会。”他指出,一方面,国内比较缺乏专业的大模型人才;另一方面,LLM的算法本身是开源的,但需要根据数据来进行训练和调整,本土企业在数据量和算法理解方面还有提升空间。 但是,复旦大学教授、上海市数据科学重点实验室主任肖仰华认为,与国际同行相比,模型、数据和算力并不是中国最大的劣势,真正的短板在于对大模型“炼制”工艺的掌握,包括数据配方、数据清洗和参数设置等。“每一个具体模块,国内其实都知道怎么做,但是将它们整合在一起,总体效果和国外就是存在差距。”肖仰华表示,“中国AI产业面临的不是能不能做的问题,而是做出来的效果是70分与100分的差别。我们要赶上最后这几十分,就要不断试错、评测和改进。”中国工程院院士廖湘科也认同未来真正具备国际竞争力的通用大模型可能只有少数的一到两个,其他参与者将基于通用大模型进行微调和推理,提供行业定制化的模型服务。不过,清华大学教授陈文光认为,现在AI整体的发展仍处于非常初期阶段,未来究竟如何尚未可知。现阶段还是应该鼓励百花齐放、多方探索。国家层面应该加强相关布局与规划,剩下的可以交给市场,没必要过早限制大模型的发展。在势不可挡的生成式AI浪潮中,中国如何走出一条自己的大模型之路?“在大模型三要素——数据、算力、算法里,我们未来最有机会发力的就是算法和模型。”国家信息中心信息化和产业发展部主任单志广提出,“ChatGPT是采用集中式算力来推动的,未来我们或许可以换一条路,比如走下一代分布式路线,通过更先进的互联技术将国内的一些算力基础设施更好地连接起来,挖掘更强的计算能力。”异构计算为大模型寻找性能与成本之间的平衡提供思路。中国科学院院士钱徳沛表示,在现代工业化体系下,既要达到高的性能,又要实现低的运营成本、设计成本、制造成本,使得全系统成本降低,应该尽可能地用更高效的异构结构和部件来支持不同的计算。近日,一个疯狂开源计划在大模型圈掀起轩然大波。这个名为亚历山大的开源计划由四个平均年龄仅20岁的少年团队发起,他们宣布要将整个互联网变成大模型语料,每1亿个Token只需1美元,为降低模型成本提供了思路。这与中国产业界发展AI的理念不谋而合。实际上,不同于国外大模型走向闭源,目前国内发布的大模型一半以上都已经实现开源,主力是高校和科研机构。北京智源人工智能研究院院长黄铁军表示,开源是大模型的未来,需要不断加强协同创新。但是,创新工场董事长李开复提醒,要“支持开源,但不能过度依赖开源模型”。首先,开源模型无法达到国外大厂自研模型的性能,开源模型的能力会成为“天花板”;其次,海外大厂的开源技术有关闭风险;最后,由于国内外文化、用户习惯和法律法规不同,将在国外训练好的模型带到国内进行微调是存在风险的。“中国大模型公司不应再依赖于他人的开源模型,需要尽快建立自己的IP(知识产权)和技术优势,形成护城河。”他说。中国工程院院士郑纬民建议,可以多方合作打造一个共同的通用大模型,并让这个模型成为新的基础设施,但要实现这个目标还有很多问题待解决,比如怎么才能把不同的模型连接起来,怎么实现传输,怎样才能既满足对算力的要求,又比较节省成本等。“新兴技术的引入必然会经历从‘一拥而上’到‘潮水退去’的过程。预计在2025年之前,我们将看到大模型建设热潮褪去之后的真实情况。”Forrester 副总裁、研究总监戴鲲表示,“大模型的到来颠覆了人机、人人乃至机器与机器、技术领域与技术领域之间的交互协同机制,但同时也带来了更多的复杂性挑战。与其谈‘弯道超车’,不如谈‘厚积薄发’。只有面对现实、秉持用户至上的长期主义,才有可能真正为用户创造价值。”