本文提出了一个名为 “Reuse and Diffuse” 的框架。该框架可以在 LDM 已经生成的少部分视频帧之后,产生更多的视频帧,从而实现迭代式地生成更长、更高质量以及多样化的视频内容。

复旦大学联合华为诺亚方舟实验室的研究者基于图像扩散模型(LDM)提出了一种迭代式生成高质量视频的方案 ——VidRD (Reuse and Diffuse)。该方案旨在对生成视频的质量和序列长度上进行突破,实现了高质量、长序列的可控视频生成。有效减少了生成视频帧间的抖动问题,具有较高的研究和实用价值,为当前火热的AIGC社区贡献了一份力量。潜在扩散模型(LDM)是一种基于去噪自编码器(Denoising Autoencoder)的生成模型,它可以通过逐步去除噪声来从随机初始化的数据生成高质量的样本。但由于在模型训练和推理过程中都存在着计算和内存的限制,一个单独的 LDM 通常只能生成数量非常有限的视频帧。尽管现有的工作尝试使用单独的预测模型来生成更多的视频帧,但这也会带来额外的训练成本并产生帧级的抖动。在本文中,受到潜在扩散模型(LDMs)在图像合成方面的显著成功的启发,提出了一个名为“Reuse and Diffuse”的框架,简称VidRD。该框架可以在 LDM 已经生成的少部分视频帧之后,产生更多的视频帧,从而实现迭代式地生成更长、更高质量以及多样化的视频内容。VidRD 加载了预训练的图像 LDM 模型进行高效训练,并使用添加有时序信息的 U-Net 网络进行噪声去除。

- 论文标题:Reuse and Diffuse: Iterative Denoising for Text-to-Video Generation

- 论文地址:https://arxiv.org/abs/2309.03549

- 项目主页:https://anonymous0x233.github.io/ReuseAndDiffuse/

- 为了生成更加平滑的视频,本文基于时序感知的 LDM 模型提出了一种迭代式的 “text-to-video” 生成方法。通过重复使用已经生成视频帧的潜空间特征以及每次都遵循先前的扩散过程,该方法可以迭代式地生成更多的视频帧。

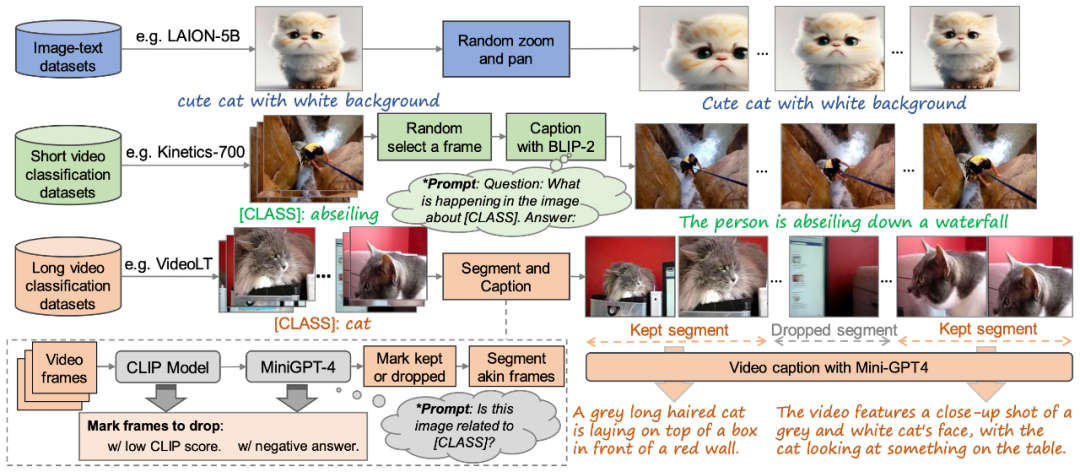

- 本文设计了一套数据处理方法来生成高质量的 “文本 - 视频” 数据集。针对现有的动作识别数据集,本文利用多模态大语言模型来为其中的视频赋予文本描述。针对图像数据,本文采用随机缩放和平移的方法来产生更多的视频训练样本。

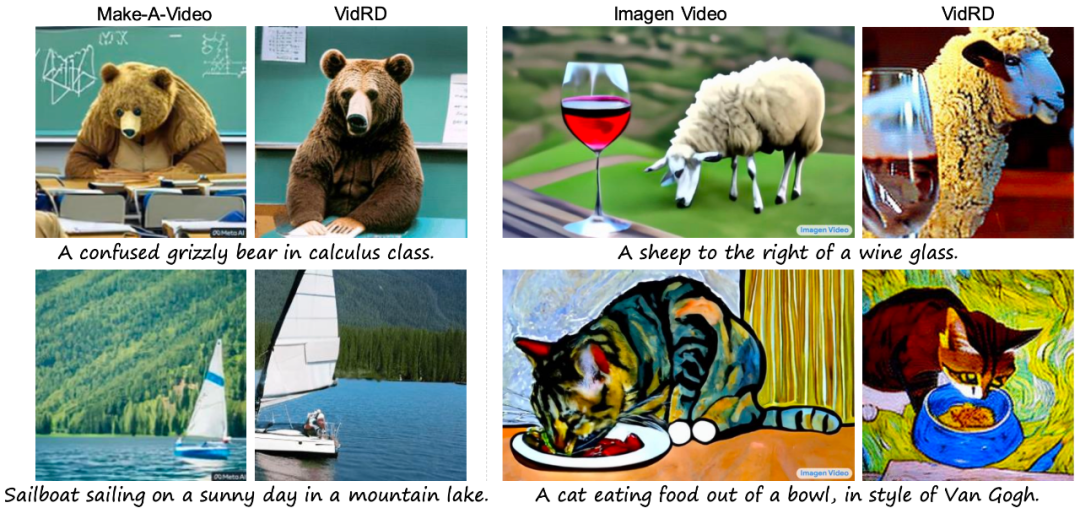

- 在 UCF-101 数据集上,本文验证了 FVD 和 IS 两种评价指标以及可视化结果,定量和定性的结果显示:相较于现有方法,VidRD 模型均取得了更好的效果。

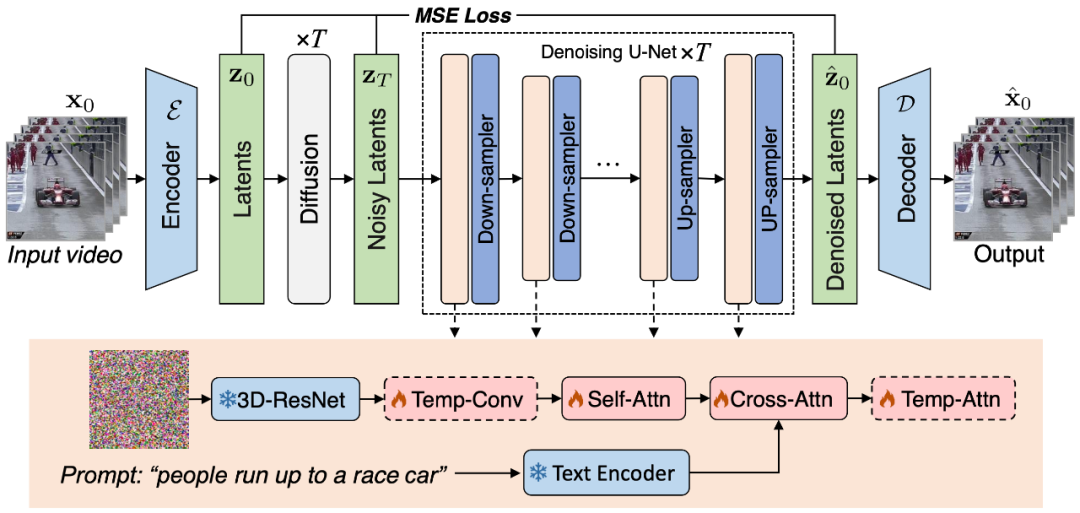

图 1. 本文提出的 VidRD 视频生成框架示意图

本文认为采用预训练的图像 LDM 作为高质量视频合成的 LDM 训练起点是一种高效而明智的选择。同时,这一观点得到了 [1, 2] 等研究工作的进一步支持。在这样的背景下,本文精心设计的模型基于预训练的稳定扩散模型构建,充分借鉴并继承了其优良的特性。这其中包括一个用于精准潜在表示的变分自编码器(VAE)和一个功能强大的去噪网络 U-Net。图 1 以清晰、直观的方式展示了该模型的整体架构。在本文的模型设计中,一个显著的特点是对预训练模型权重的充分利用。具体来说,大部分网络层,包括 VAE 的各组件和 U-Net 的上采样、下采样层,均使用稳定扩散模型的预训练权重进行初始化。这一策略不仅能显著加速模型的训练过程,还能从一开始就确保模型表现出良好的稳定性和可靠性。本文的模型可以在一个初始的包含少量帧的视频片段的条件下,通过重用原始的潜在特征和模仿之前的扩散过程,迭代地生成额外的帧。此外,对于用于在像素空间和潜在空间之间进行转换的自编码器,本文在其解码器中注入了和时序相关的网络层,并对这些层进行了微调,以提高时间一致性。为了保证视频帧间的连续性,本文在模型中添加了 3D Temp-conv 和 Temp-attn 层。Temp-conv 层紧跟在 3D ResNet 后面,该结构可以实现 3D 卷积操作,以捕捉空间和时间的关联,进而理解视频序列汇总的动态变化和连续性。Temp-Attn 结构与 Self-attention 相似,用于分析和理解视频序列中的帧间关系,使模型能够精准地同步帧间的运行信息。这些参数在训练时随机初始化,旨在为模型提供时序结构上的理解和编码。此外,为了适配该模型结构,数据的输入也做了相应的适配和调整。

图 2. 本文提出的高质量 “文本 - 视频” 训练数据集构建方法为了训练 VidRD 模型,本文提出了一种构建大规模 “文本 - 视频” 训练数据集的方法,如图 2 所示,该方法可以处理 “文本 - 图像” 数据和无描述的 “文本 - 视频” 数据。此外,为了实现高质量的视频生成,本文也尝试对训练数据进行了去水印操作。尽管当前市场上高质量的视频描述数据集相对稀缺,但存在大量的视频分类数据集。这些数据集拥有丰富的视频内容,每段视频都伴随一个分类标签。如 Moments-In-Time、Kinetics-700 和 VideoLT 就是三个代表性的大规模视频分类数据集。Kinetics-700 涵盖了 700 个人类动作类别,包含超过 60 万的视频片段。Moments-In-Time 则囊括了 339 个动作类别,总共有超过一百万的视频段落。而 VideoLT 则包含了 1004 个类别和 25 万段未经编辑的长视频。为了充分利用现有的视频数据,本文尝试对这些视频进行自动化地更加详细的标注。本文采用了 BLIP-2、MiniGPT4 等多模态大语言模型,通过针对视频中的关键帧,结合其原始的分类标签,本文设计了许多 Prompts,以通过模型问答的方式产生标注。这种方法不仅增强了视频数据的语音信息,而且可以为现有没有详细描述的视频带来更加全面、细致的视频描述,从而实现了更加丰富的视频标签生成,以帮助 VidRD 模型带来更好的训练效果。此外,针对现有的非常丰富的图像数据,本文也设计了详细的方法将图像数据转换为视频格式以进行训练。具体操作为在图像的不同位置、按照不同的速度进行平移和缩放,从而为每张图像赋予独特的动态展现形式,模拟现实生活中移动摄像头来捕捉静止物体的效果。通过这样的方法,可以有效利用现有的图像数据进行视频训练。

如上述视频所示,为本文VidRD模型生成的视频。描述文本分别为:“Timelapse at the snow land with aurora in the sky.”、“A candle is burning.”、“An epic tornado attacking above a glowing city at night.”、以及“Aerial view of a white sandy beach on the shores of a beautiful sea.”。更多可视化效果可见项目主页。

最后,如图 3 所示,分别为本文生成结果与现有方法 Make-A-Video [3] 和 Imagen Video [4] 的可视化比较,展现了本文模型质量更好的生成效果。[1] Ge S., Nan S., Liu G., et al. “Preserve your own correlation: A noise prior for video diffusion models”. 2023.[2] Blattmann A., Rombach R., Ling H., et al. “Align your latents: High- resolution video synthesis with latent diffusion models”. CVPR, 2023.[3] Uriel S., Adam P., Thomas H., et al. “Make-a-video: Text-to- video generation without text-video data”. ICLR, 2023.[4] Jonathan H., William C., Chitwan S., et al. “Imagen video: High definition video generation with diffusion models”. 2022.

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]