©作者 | 西风

来源 | 量子位

无需额外微调,无需专家策划,仅凭提示,GPT-4就能化身“专家”。

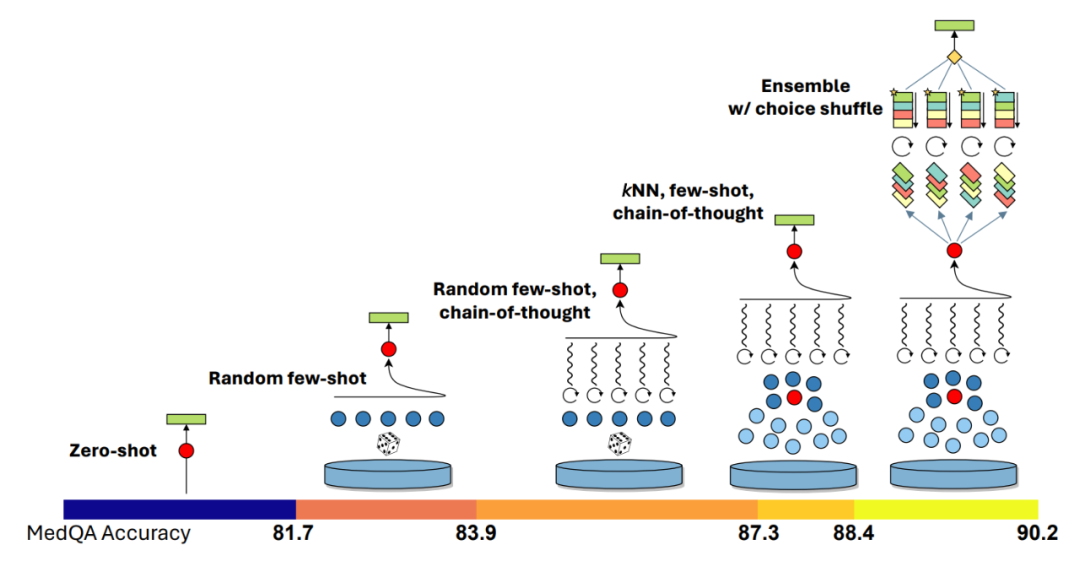

使用他们提出的最新提示策略Medprompt,在医疗专业领域,GPT-4在MultiMed QA九个测试集中取得最优结果。在MedQA数据集(美国医师执照考试题)上,Medprompt让GPT-4的准确率首次超过90%,超越BioGPT和Med-PaLM等一众微调方法。

研究人员还表示Medprompt方法是通用的,不仅适用于医学,还可以推广到电气工程、机器学习、法律等专业中。这项研究在X(原Twitter)一经分享,就引发众多网友关注。沃顿商学院教授Ethan Mollick、Artificial Intuition作者Carlos E. Perez等都有转发分享。Carlos E. Perez直呼“出色的提示策略可以甩微调一大截”:有网友表示早就有这种预感,现在能看到结果出来,真的是“so cool”:GPT-4是一项能改变行业的技术,而我们还远没有触及提示的极限,也未达到微调极限。

组合提示策略,“变身”专家

Medprompt是多种提示策略的组合体,包含三大法宝:

Can Generalist Foundation Models Outcompete Special-Purpose Tuning? Case Study in Medicine论文链接:

https://arxiv.org/pdf/2311.16452.pdf少样本学习是让模型快速学习上下文的一种有效的方法。简单来说,就是输入一些示例,让模型快速适应特定领域,并学习遵循任务的格式。这种用于特定任务提示的少样本示例通常是固定的,所以对示例的代表性和广泛性有较高的要求。之前一种方法是让领域专家手动制作范例,但即便如此,也不能保证专家策划的固定的少样本示例在每个任务中都有代表性。想法是,任务训练集可以作为少样本示例的来源,如果训练集足够大,那就可以为不同的任务输入选择不同的少样本示例。具体来说,研究人员先利用text-embedding-ada-002模型为每个训练样本和测试样本生成向量表示。然后,对于每个测试样本,基于向量相似度,从训练样本中挑选出最相似的k个样本。与微调方法相比,动态少样本选择利用了训练数据,但不需要对模型参数进行大量更新。自生成思维链

思维链(CoT)方法就是让模型一步一步思考,生成一系列中间推理步骤。之前一种方法也是依赖专家手动编写少量的带有提示思维链的示例。在这里,研究人员发现,可以简单地要求GPT-4使用以下提示为训练示例生成思维链:

但研究人员也指出这种自动生成的思维链可能包含错误的推理步骤,于是设置了一个验证标签作为过滤器,可以有效减少错误。与在Med-PaLM 2模型中专家手工制作的思维链示例相比,GPT-4生成的思维链基本原理更长,而且分步推理逻辑更细粒度。选项洗牌集成

除此之外,GPT-4在做选择题时,可能会存在一种偏见,就是不管选项内容是什么,它会偏向总是选择A,或者总是选择B,这就是位置偏差。为了减少这个问题,研究人员选择将原来的选项顺序打乱重排。比如原先选项是ABCD,可以变成BCDA、CDAB。然后让GPT-4做多轮预测,每轮使用选项的一个不同排列顺序。如此一来“迫使”GPT-4考虑选项的内容。最后对多轮预测结果做个投票,选择最一致、正确的选项。将以上几种提示策略组合在一起就是Medprompt,下面来看测试结果。在测试中,研究人员采用了MultiMed QA评估基准。使用Medprompt提示策略的GPT-4,在MultiMedQA的九个基准数据集中均取得最高分,优于Flan-PaLM 540B、Med-PaLM 2。此外研究人员还讨论了Medprompt策略在“Eyes-Off”数据上的表现,也就是在训练或优化过程中模型未曾见过的数据中的表现,用于检验模型是否过拟合训练数据。

结果GPT-4结合Medprompt策略在多个医学基准数据集上表现出色,平均准确率达到了91.3%。研究人员还在MedQA数据集上进行了消融实验,探索了三个组件对于整体性能的相对贡献。

而且GPT-4自动生成的思维链比Med-PaLM 2中专家策划的得分更高:最后,研究人员还探索了Medprompt的跨域泛化能力,取用了MMLU基准中的六个不同的数据集,涵盖了电气工程、机器学习、哲学、专业会计、专业法律和专业心理学的问题。还添加了另外两个包含NCLEX(美国护士执照考试)问题的数据集。结果显示,Medprompt在这些数据集上的效果与在MultiMedQA医学数据集上的提升幅度相近,平均准确率提高了7.3%。

[1] https://twitter.com/erichorvitz/status/1729854235443884385

[2] https://twitter.com/emollick/status/1729733749657473327

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧