【新智元导读】AI训AI必将成为一大趋势。Meta和NYU团队提出让大模型「自我奖励」的方法,让Llama2一举击败GPT-4 0613、Claude 2、Gemini Pro领先模型。

Llama 2-70B一夜之间打败GPT-4,让整个AI社区为之震惊!

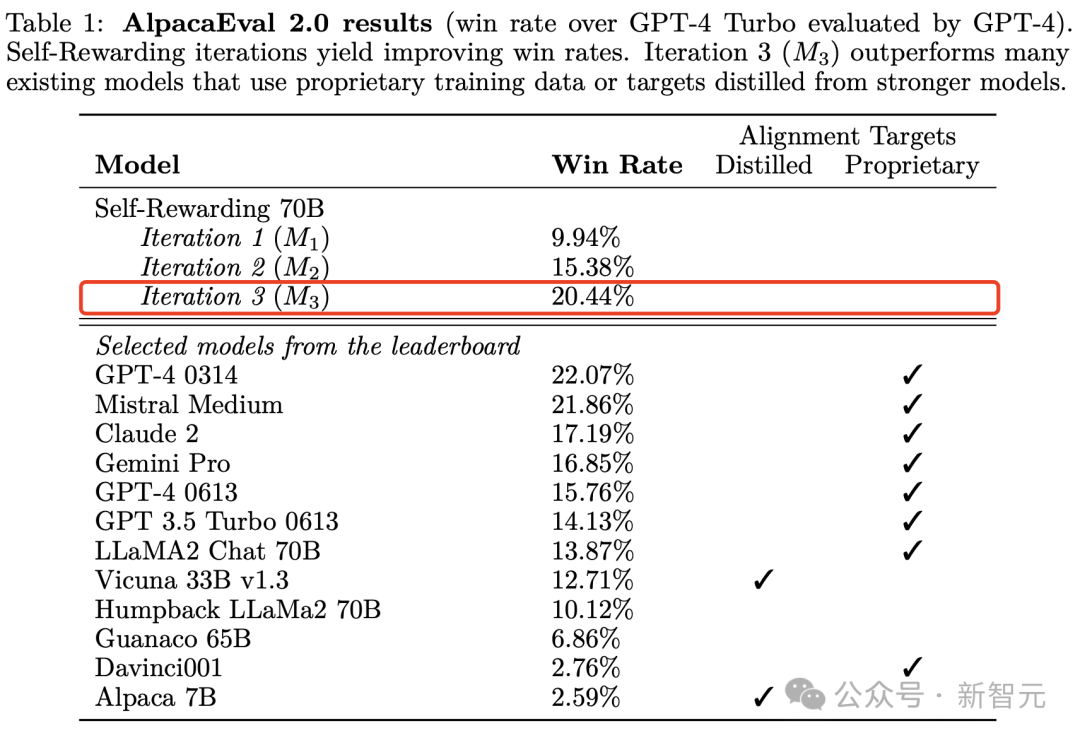

甚至,在AlpacaEval 2.0排行榜中,微调后的模型胜率完全碾压Claude 2、Gemini Pro等模型。

Meta和NYU研究团队究竟提出了什么秘制配方,才能让Llama 2-70B超强进化?

正如论文题目所言——「自我奖励语言模型」,模型生成训练数据,并评估这些数据的质量,然后用这些数据来自己训练自己。

简单来说,最新方法可以让LLM在迭代训练过程中不断自我改进。

论文地址:https://arxiv.org/pdf/2401.10020.pdf

LeCun也转赞了自家实验室的研究。

RLAIF已经不是新鲜事了,之前包括Anthropic,谷歌都推出过自己的「AI训AI」的技术,那么Meta的这项工作和之前的几家的RLAIF区别在哪里呢?

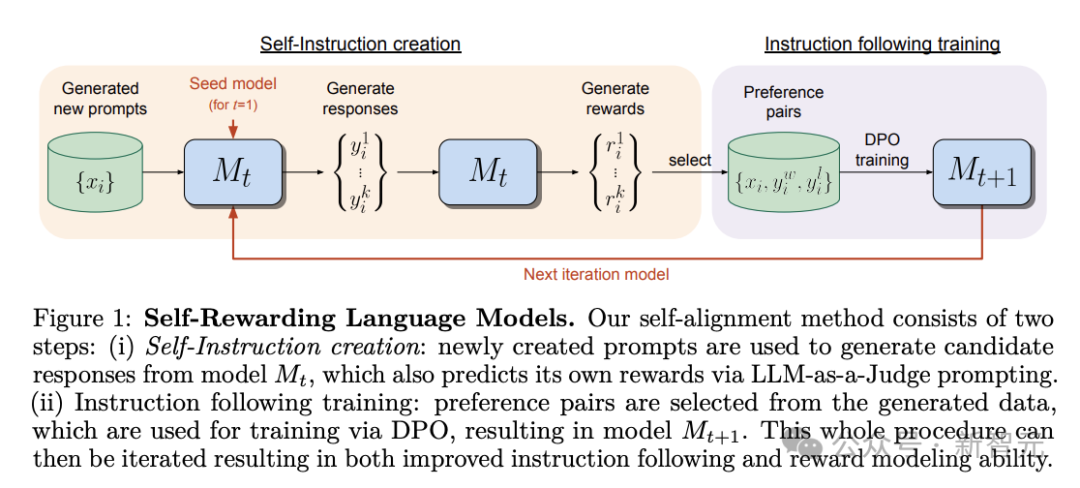

我们先来了解一下Meta的自我奖励语言模型的大概框架。

研究团队开发了一个能够遵循指令和自我评价回复质量的能力的模型。模型可以生成新的训练数据,对生成的回复进行质量评分,从而不断改进自己的输出。

模型首先根据少量人工标注数据进行预训练,获得初始化模型。

然后模型生成新的指令和多个候选回复,并使用LLM-as-a-Judge的提示,让模型对自己生成的回复打分。

根据打分形成新的训练数据,继续训练模型。

这样可以迭代训练,在每次迭代中模型的遵循指令能力和打分能力都会提升。

研究人员从Llama 2 70B预训练模型开始迭代训练。

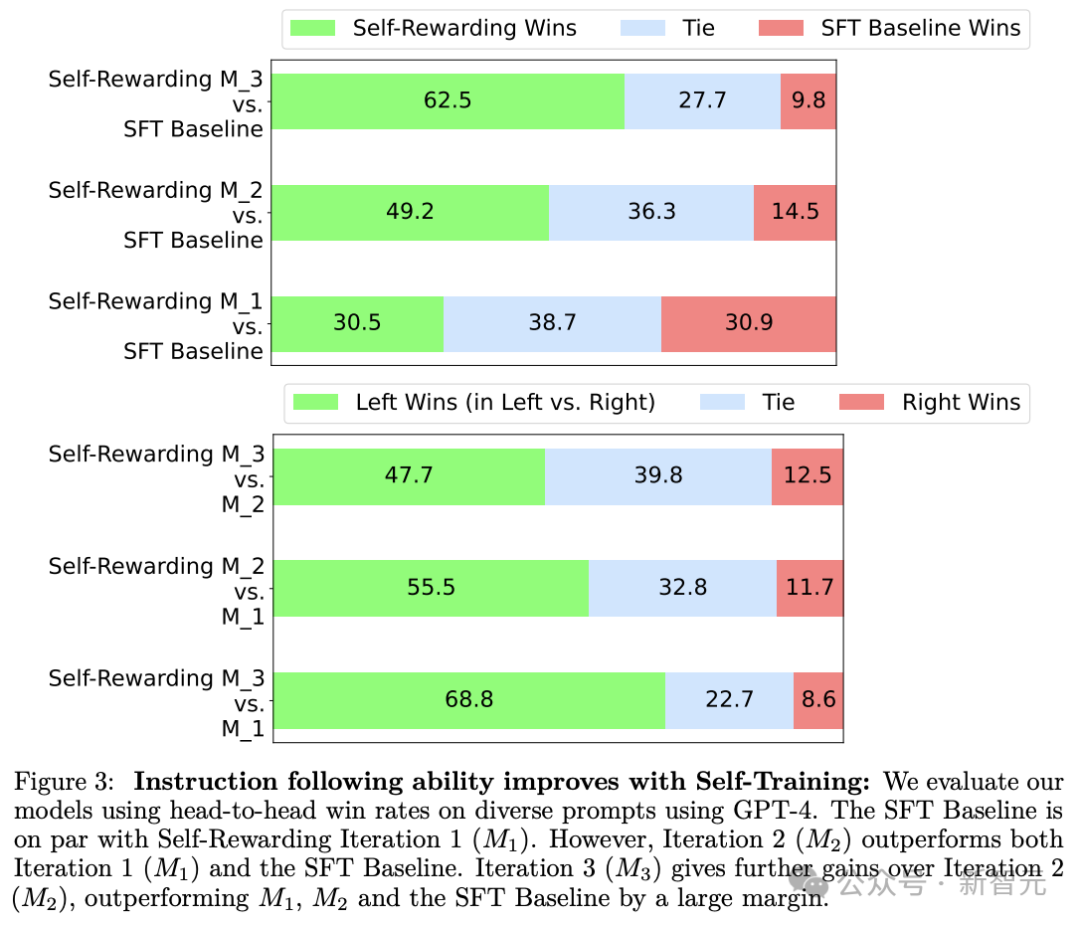

结果显示在3次迭代中,模型遵循指令的能力有显著提升,同时奖励建模能力也在提高,评价结果与人工判断的相关性更高。

这说明模型迭代过程中,不仅指令遵循能力提高,也更善于对自己生成的回复进行判断。

迭代第三次的模型在AlpacaEval 2.0基准测试中,就战胜了Claude 2、Gemini Pro、GPT-4 0613等模型。

Meta的这项工作与谷歌在去年9月发布的RLAIF论文相比,更近一步地使用了一个不断进化的奖励模型来不断迭代训练模型,而迭代后的模型也确实取得了明显可见的性能提升。

可以说,Meta又将AI自我迭代大模型的前沿往前推进了一大步。

研究人员的方法首先假设可以访问基本的预训练语言模型和少量人工注释的种子数据。然后研究人员建立一个模型,让它同时拥有两种能力:

- 指令遵循:给出描述用户请求的提示,能够生成高质量、有帮助(且无害)的响应。

- 自指令创建:能够按照示例生成和评估新指令,再添加到自己的训练集中。

这两个能力可以为了使模型能够执行自我对齐,即它们是用于使用人工智能反馈(AIF)迭代训练自身的组件。自指令创建包括生成候选响应,然后模型本身判断其质量——充当自己的奖励模型,取代外部奖励模型。这是通过LLM-as-a-Judge机制实现的:通过将响应评估制定为遵循指令的任务。这个由模型自行创建的AIF偏好数据被用作训练集来训练模型。整体自我对齐过程是一个不断迭代过程,通过构建一系列此类模型来进行,目的是每个模型都比上一个模型有所改进。重要的是,由于模型既可以提高其生成能力,又可以通过相同的生成机制作为自己的奖励模型,这意味着奖励模型本身可以通过迭代过程来改进,这就不同于奖励模型固定不变的传统方法。研究人员相信这样可以提高这些学习模型未来自我改进的潜力上限,消除限制性瓶颈。初始化

研究人员获得一组人工编写的(指令提示、响应)一般指令。他们使用这些示例从预训练的基础语言模型开始,用监督微调 (SFT) 的方式进行训练。研究人员假设他们提供了一组种子(评估指令提示、评估结果响应)示例,这些示例也可用于训练。虽然这并不是绝对必要的,因为使用IFT数据的模型已经能够训练LLM成为judge,而且研究人员表明此类训练数据可以提供改进的结果。在这些数据中,输入提示要求模型评估对特定指令的给定响应的质量。提供的评估结果响应包括思路推理,然后是最终分数(在研究人员的实验中,满分 5 分)。研究人员为这些提示选择的格式如下图2所示。作为LLM执行奖励模型角色的训练数据。-使用研究人员已经训练好的模型,研究人员可以让它自我修改自己的训练集。具体来说,就是为下一次训练迭代生成额外的训练数据。-生成候选响应:然后,对于给定的提示 x,研究人员生成 N 个不同的候选响应 {y, . 。。, y} 。-评估候选响应:最后,研究人员使用同一模型的LLM-as-a-Judge能力来评估其自己的候选响应,得分为 r∈ [0, 5](见图 2)。指令遵循训练

训练最初是使用种子 IFT 和 EFT 数据进行的,这与奖励模型固定的标准实践不同。然后通过AI(自我)反馈添加附加数据。

执行自指令创建过程后,研究人员可以使用额外的训练示例来扩充种子数据,研究人员将其称为 AI 反馈训练 (AIFT) 数据。偏好对:研究人员构建以下形式的训练数据(指令提示 x,获胜响应 y,失败响应 y)。为了形成获胜和失败对,研究人员从 N 个评估的候选答案中选取最高和最低得分的答案。仅正面示例:在此变体中,研究人员遵循其他方法,将模型策划的(指令提示、响应)附加示例添加到种子集中,以进行监督微调。整体自对齐算法

迭代训练

研究人员的整个过程训练一系列模型。其中每个连续模型t使用由t − 1模型创建的增强训练数据。因此,研究人员将AIFT(M)定义为使用模型M创建的AI反馈训练数据。M1:用M初始化,然后使用SFT对IFT+EFT种子数据进行微调。M2:用M1初始化,然后使用DPO用AIFT(M1)数据进行训练。M3:用M2初始化,然后使用DPO用AIFT(M2)数据进行训练。如文章开始所提到的那张图中,研究人员将微调后Llama 2-70B三个迭代版本与其他先进模型在AlpacaEval 2.0基准上进行了比较。

结果显示,第三次迭代后的Llama 2-70B模型打败了GPT-4 0613、Claude 2、Gemini Pro等模型。此外,Llama 2-70B每个迭代版本比较,改进几乎保持线性。研究人员通过各种指标来评估作为评估者的大模型,这些指标衡量与保留的人类偏好数据的一致性。自我奖励迭代2(模型M2),使用从其先前迭代M1派生的自我奖励模型进行训练,其性能优于迭代1(M1)。而M1本身也优于仅利用指令微调(IFT)数据训练的标准SFT基准模型。迭代3(模型 M3)比迭代2有了进一步提高。在这个框架之中,研究人员发现,奖励模型的性能也能随着迭代不断提高。模型M2使用来自M1的奖励模型进行训练,与M1相比,在所有五个指标上都体现出了更好的性能。例如,成对准确(pairwise accuracy)率从78.7%提高到 80.4%。M3继续进一步改进了其中几个指标。研究人员猜测,是由于模型在指令遵循方面变得更好,因此它在LLM-as-a-Judge的任务方面也有所改进。Meta和NYU的最新研究让许多人惊呼「让开源再次伟大」。

俄亥俄州立大学计算机工程助理教授Yu Su表示,2024年才刚刚开始,我们已经从合成数据中看到了许多重要成果。我个人认为,这不仅仅是「数据增强」的改头换面。以前的数据增强工作在很大程度上依赖于「人类工程」,而现在更像是LLM的「想象力」...越来越多的研究表明,「人工训练数据耗尽」不会阻止LLM的发展。这是DPO的「Attention Is All You Need」的时刻。还有人表示「令人惊讶的是,每次迭代的改进几乎保持线性,仅在3次迭代之后,就已经接近GPT-4级别」。https://arxiv.org/pdf/2401.10020.pdf