【新智元导读】谷歌和威斯康星麦迪逊大学的研究人员推出了一个让LLM给自己输出打分的选择性预测系统,通过软提示微调和自评估学习,取得了比10倍规模大的模型还要好的成绩,为开发下一代可靠的LLM提供了一个非常好的方向。

大模型的「幻觉」问题马上要有解了?

威斯康星麦迪逊大学和谷歌的研究人员最近开发了一个名为ASPIRE的系统,可以让大模型对自己的输出给出评分。

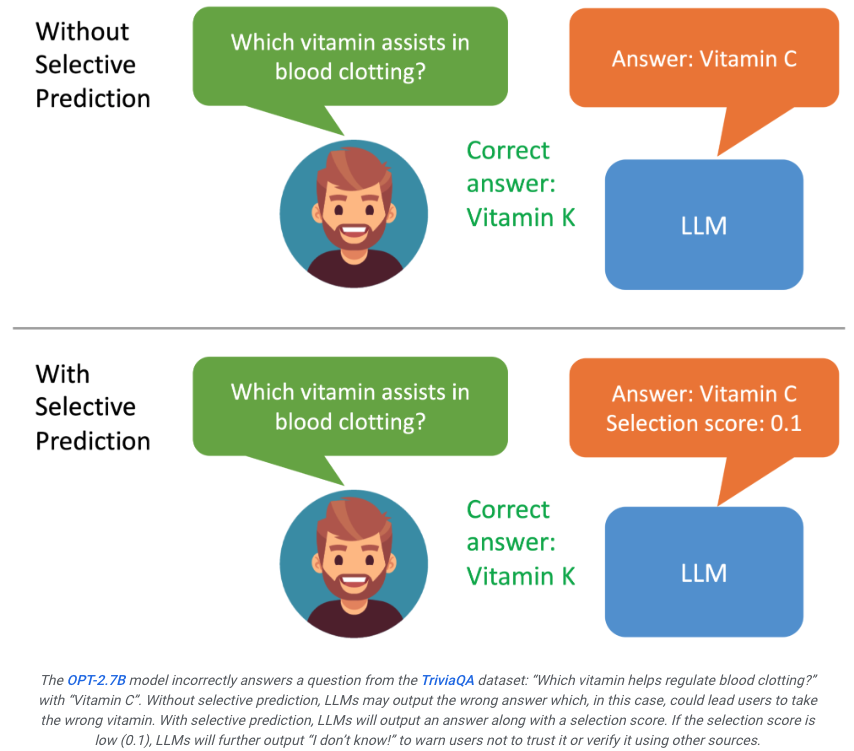

如果用户看到模型的生成的结果评分不高,就能意识到这个回复可能是幻觉。

如果系统可以进一步筛选评分的结果进行输出,比如如果评分过低,大模型就可能生成「我没法回答这个问」,从而有望最大限度的改善幻觉问题。

论文地址:https://aclanthology.org/2023.findings-emnlp.345.pdf

ASPIRE能让LLM输出答案以及答案的置信度得分。

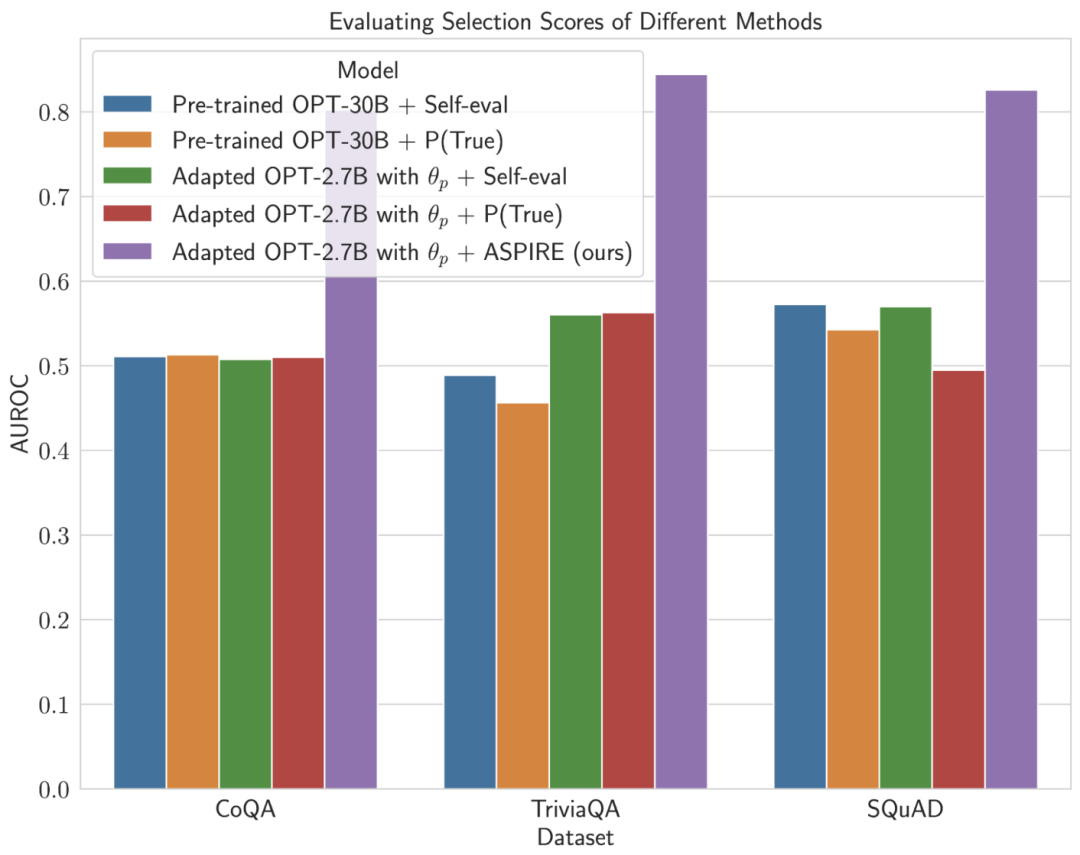

研究人员的实验结果表明,ASPIRE在各种QA数据集(例如 CoQA 基准)上显著优于传统的选择性预测方法。

让LLM不仅要回答问题,还要评估这些答案 。

在选择性预测的基准测试上,研究人员通过ASPIRE系统取得了超过10倍规模的模型的成绩。

就像让学生在课本后面验证他们自己的答案,虽然听起来有点不靠谱,但是细细一想,每个人在做出一道题目之后,确实会对答案的满意程度会有一个评分。

这就是ASPIRE的本质,它涉及三个阶段:

(1) 针对特定任务的调优,

(2) 答案采样,

(3) 自我评估学习。

在研究人员看来,ASPIRE不仅仅是另一个框架,它代表着一个全面提升LLM可靠性,降低幻觉的美好未来。

如果LLM可以成为决策过程中值得信赖的合作伙伴。

只要通过不断优化选择性预测的能力,人类距离充分发挥大模型的潜力就又近了一步。

研究人员希望能凭借ASPIRE,开启下一代LLM的进化,从而能创建更可靠和更具有自我意识的人工智能。

针对特定任务的微调

ASPIRE执行特定于任务的微调以训练适应性参数 ,同时冻结LLM。给定生成任务的训练数据集,它会微调预训练的LLM以提高其预测性能。为此,可以采用参数高效的微调技术(例如,软提示词微调和LoRA)来微调任务上的预训练LLM,因为它们可以有效地通过少量目标获得强泛化任务数据。具体来说,LLM参数(θ)被冻结,并添加自适应参数

,同时冻结LLM。给定生成任务的训练数据集,它会微调预训练的LLM以提高其预测性能。为此,可以采用参数高效的微调技术(例如,软提示词微调和LoRA)来微调任务上的预训练LLM,因为它们可以有效地通过少量目标获得强泛化任务数据。具体来说,LLM参数(θ)被冻结,并添加自适应参数 进行微调。仅更新 θ (p) 以最小化标准 LLM 训练损失(例如交叉熵)。这种微调可以提高选择性预测性能,因为它不仅提高了预测精度,而且还提高了正确输出序列的可能性。

进行微调。仅更新 θ (p) 以最小化标准 LLM 训练损失(例如交叉熵)。这种微调可以提高选择性预测性能,因为它不仅提高了预测精度,而且还提高了正确输出序列的可能性。答案采样

在针对特定任务进行调优后,ASPIRE使用LLM和学习到的 为每个训练问题生成不同的答案,并创建用于自评估学习的数据集。研究人员的目标是生成具有高可能性的输出序列。他们使用波束搜索(Beam Search)作为解码算法来生成高似然输出序列,并使用Rouge-L度量来确定生成的输出序列是否正确。

为每个训练问题生成不同的答案,并创建用于自评估学习的数据集。研究人员的目标是生成具有高可能性的输出序列。他们使用波束搜索(Beam Search)作为解码算法来生成高似然输出序列,并使用Rouge-L度量来确定生成的输出序列是否正确。自评估学习

在对每个查询的高似然输出进行采样后,ASPIRE添加自适应参数 ,并且仅微调

,并且仅微调 来学习自评估。由于输出序列的生成仅取决于 θ 和

来学习自评估。由于输出序列的生成仅取决于 θ 和 ,因此冻结 θ 和学习到的

,因此冻结 θ 和学习到的 可以避免在学习自评估时改变LLM的预测行为-评估。研究人员优化了

可以避免在学习自评估时改变LLM的预测行为-评估。研究人员优化了 ,使得改编后的LLM可以自己区分正确和错误的答案。在这个框架中,可以使用任何参数有效的微调方法来训练

,使得改编后的LLM可以自己区分正确和错误的答案。在这个框架中,可以使用任何参数有效的微调方法来训练 和

和 。在这项工作中,研究人员使用软提示微调,这是一种简单而有效的机制,用于学习「软提示」来调节冻结的语言模型,从而比传统的离散文本提示更有效地执行特定的下游任务。这种方法背后的核心在于认识到,如果能够开发出有效激发自我评价的提示,那么应该可以通过结合有针对性的训练目标的软提示微调来发现这些提示。在训练

。在这项工作中,研究人员使用软提示微调,这是一种简单而有效的机制,用于学习「软提示」来调节冻结的语言模型,从而比传统的离散文本提示更有效地执行特定的下游任务。这种方法背后的核心在于认识到,如果能够开发出有效激发自我评价的提示,那么应该可以通过结合有针对性的训练目标的软提示微调来发现这些提示。在训练 和

和 后,研究人员通过波束搜索解码获得查询的预测(beam search decoding)。然后,研究人员定义一个选择分数,将生成答案的可能性与学习到的自我评估分数(即,预测对于查询正确的可能性)结合起来,以做出选择性预测。为了证明ASPIRE的效果,研究人员使用各种开放式预训练Transformer (OPT)模型在三个问答数据集(CoQA、TriviaQA和SQuAD)上对其进行评估。通过使用软提示调整训练

后,研究人员通过波束搜索解码获得查询的预测(beam search decoding)。然后,研究人员定义一个选择分数,将生成答案的可能性与学习到的自我评估分数(即,预测对于查询正确的可能性)结合起来,以做出选择性预测。为了证明ASPIRE的效果,研究人员使用各种开放式预训练Transformer (OPT)模型在三个问答数据集(CoQA、TriviaQA和SQuAD)上对其进行评估。通过使用软提示调整训练 研究人员观察到LLM的准确性大幅提高。例如,与使用CoQA和SQuAD数据集的较大预训练OPT-30B模型相比,采用ASPIRE的OPT-2.7B模型表现出更好的性能。这些结果表明,通过适当的调整,较小的LLM在某些情况下可能有能力匹配或可能超过较大模型的准确性。当深入研究固定模型预测的选择分数计算时,ASPIRE获得了比所有数据集的基线方法更高的AUROC分数(随机选择的正确输出序列比随机选择的不正确输出序列具有更高选择分数的概率)。例如,在CoQA基准上,与基线相比,ASPIRE将AUROC从51.3%提高到80.3%。TriviaQA数据集评估中出现了一个有趣的模式。虽然预训练的OPT-30B模型表现出更高的基线精度,但当应用传统的自我评估方法(Self-eval和P(True))时,其选择性预测的性能并没有显著提高。相比之下,小得多的OPT-2.7B模型在使用ASPIRE进行增强后,在这方面表现优于其他模型。这种差异体现了一个重要的问题:利用传统自我评估技术的较大LLM在选择性预测方面可能不如较小的ASPIRE增强模型有效。研究人员与ASPIRE的实验之旅强调了LLM格局的关键转变:语言模型的容量并不是其性能的全部和最终目的。相反,可以通过策略调整来大幅提高模型的有效性,即使在较小的模型中也可以进行更精确、更自信的预测。因此,ASPIRE证明了LLM的潜力,它可以明智地确定自己答案的确定性,并在选择性预测任务中显著地超越地超越其他10倍体量的模型。https://blog.research.google/2024/01/introducing-aspire-for-selective.html

研究人员观察到LLM的准确性大幅提高。例如,与使用CoQA和SQuAD数据集的较大预训练OPT-30B模型相比,采用ASPIRE的OPT-2.7B模型表现出更好的性能。这些结果表明,通过适当的调整,较小的LLM在某些情况下可能有能力匹配或可能超过较大模型的准确性。当深入研究固定模型预测的选择分数计算时,ASPIRE获得了比所有数据集的基线方法更高的AUROC分数(随机选择的正确输出序列比随机选择的不正确输出序列具有更高选择分数的概率)。例如,在CoQA基准上,与基线相比,ASPIRE将AUROC从51.3%提高到80.3%。TriviaQA数据集评估中出现了一个有趣的模式。虽然预训练的OPT-30B模型表现出更高的基线精度,但当应用传统的自我评估方法(Self-eval和P(True))时,其选择性预测的性能并没有显著提高。相比之下,小得多的OPT-2.7B模型在使用ASPIRE进行增强后,在这方面表现优于其他模型。这种差异体现了一个重要的问题:利用传统自我评估技术的较大LLM在选择性预测方面可能不如较小的ASPIRE增强模型有效。研究人员与ASPIRE的实验之旅强调了LLM格局的关键转变:语言模型的容量并不是其性能的全部和最终目的。相反,可以通过策略调整来大幅提高模型的有效性,即使在较小的模型中也可以进行更精确、更自信的预测。因此,ASPIRE证明了LLM的潜力,它可以明智地确定自己答案的确定性,并在选择性预测任务中显著地超越地超越其他10倍体量的模型。https://blog.research.google/2024/01/introducing-aspire-for-selective.html