https://arxiv.org/abs/2308.15321代码连接:

https://github.com/forever208/ADM-ES摘要

扩散模型在图像生成方面非常成功,但其曝光偏差(exposure bias)的问题(训练和采样过程的输入存在偏差)缺乏深入的探索。在本文中,我们通过首先对真实的采样分布进行分析,并找出了暴露偏差问题的根本原因。此外,我们讨论了该问题一些潜在解决方案,并且提出了一种简单且高效的无需训练的方法,称为 Epsilon Scaling(ES),来减轻暴露偏差。

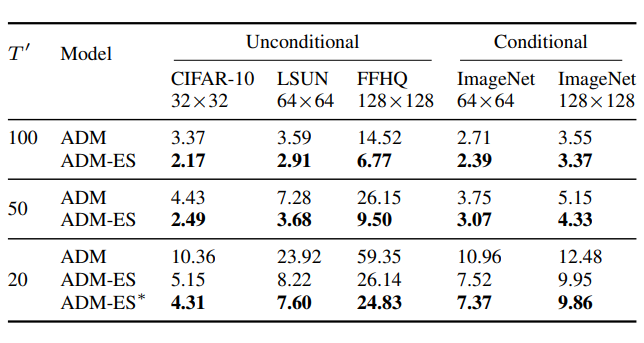

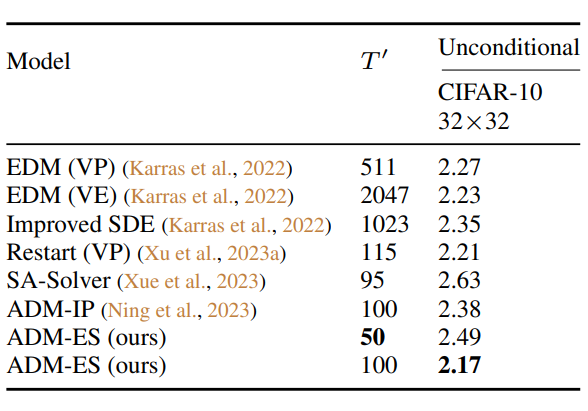

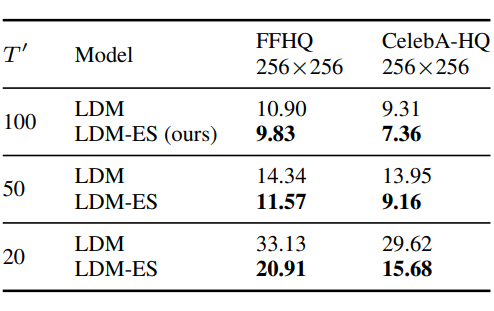

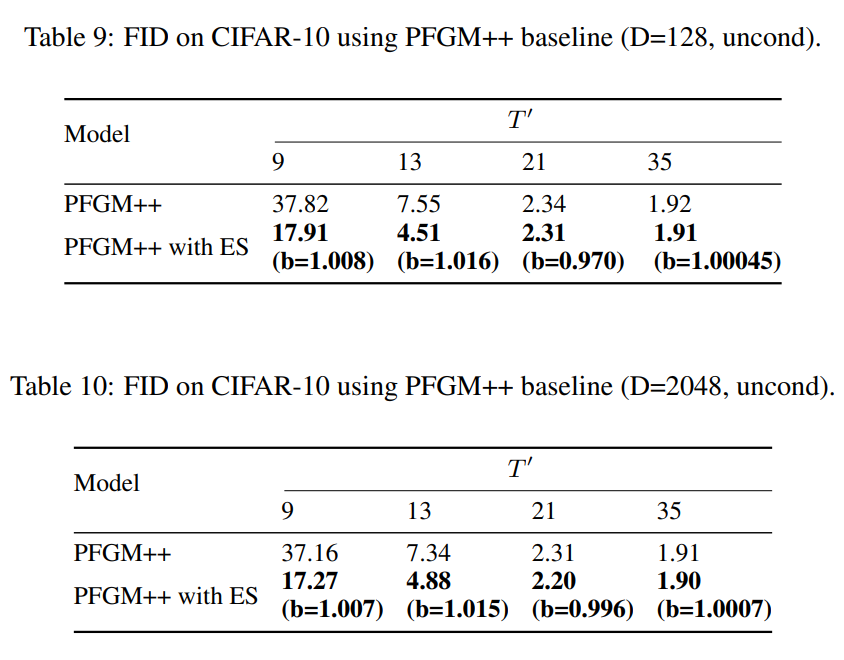

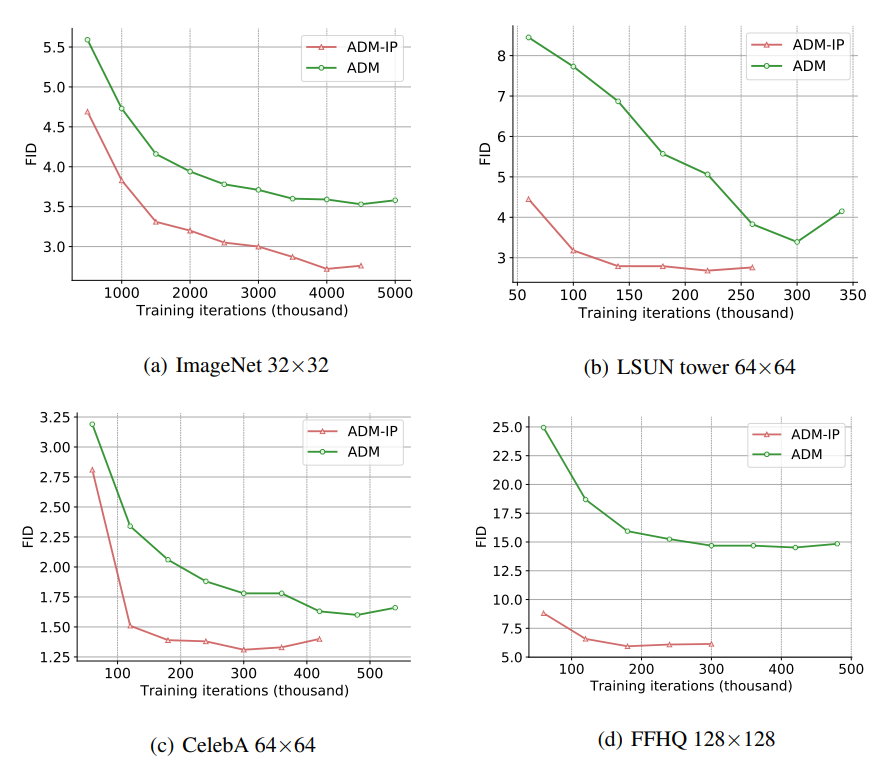

实验表明,ES 显式地让采样轨迹向训练轨迹(训练得到的向量场)靠近,从而减轻训练和采样之间的输入不匹配。我们在各种扩散模型框架(ADM、DDIM、EDM、LDM、DiT、PFGM++)上验证了 ES 的有效性。比如将 ES 应用于 ADM 上,我们得到了一个 SOTA 的随机采样器:在 100 步无条件生成下,在 CIFAR-10 上获得了 2.17 FID.扩散模型中的曝光偏差

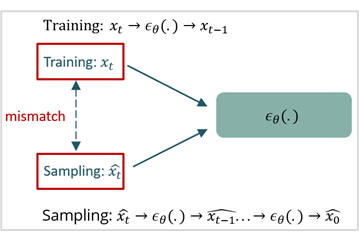

与自回归的文本生成类似,扩散模型也存在曝光偏差问题。即训练阶段喂给网络的是真值 ,而采样阶段喂给网络的是上一时刻网络预测的 ,由于网络在训练阶段从来没有看过 ,因此无法学习准确的 score 或 epsilon。

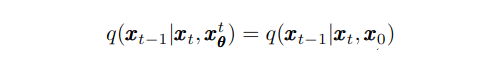

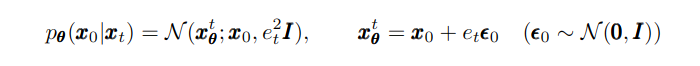

我们显式地建模真实的采样分布以比较 和 的差异。以 DPPM 为例,理论上的采样分布是基于 posterior(下图右式)得到的,其中 是指神经网络通过输入 预测的 。

但上式仅在 时成立,而神经网络对于 的预测始终存在误差,因此真实的采样分布需要考虑网络在每一步采样中关于 的预测误差。以 Analytic-DPM 为例,假设该预测误差为高斯分布:

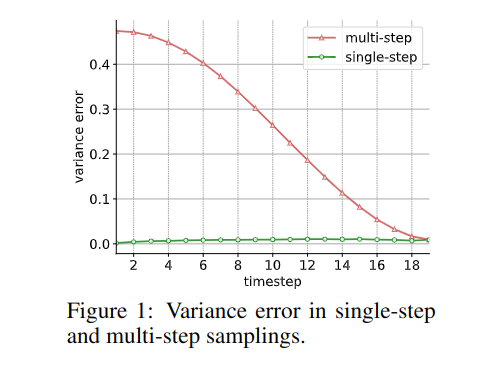

我们最终能得到真实的采样分布 ,将其与训练过程中的条件 分布做比较,我们得到表 1 的结果,显然采样阶段网络看到的 具有更大的方差。上述是对于单步采样的解析,迭代后可得到多步采样的真实分布,此外 DDIM 也具有类似的结果(详见论文)。我们对表 1 两个分布的方差之差(方差误差)进行可视化,得到了图 1 的结果,可以看到误差会逐步积累。

曝光偏差的解决方案

我们现在谈论曝光偏差的解决方案:

- 最直接的方式就是训练一个更准确的网络,参考 EDM 的调参;

- 通过数据扩增训练一个更稠密的向量场,如 EDM 的几何扩增,DDPM-IP 的输入扰动;

- 采用 PFGM 生成框架,其框架对于预测误差有更强的鲁棒性。

但上述方法都需要重新训练一个模型,而我们下文提出方案是针对采样过程,并与上述方案兼容。

Epsilon Scaling

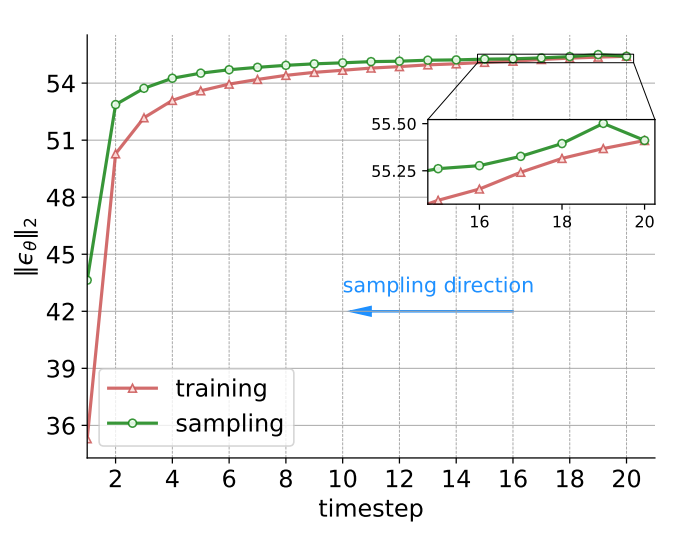

通过观察网络输出的 的模长,我们可以看出训练和采样过程存在偏差,且该偏差会逐步累计。我们因此提出 Epsilon Scaling 以缩放采样过程中的 以使其向训练过程中的 靠拢,即让下图绿色轨迹向红色轨迹靠拢。

因此,我们的采样方案仅需在原有采样函数上加一个缩放因子 ,基于误差传递的分析,我们最后得到了 的一次函数缩放策略,并且发现 k 在实际中接近于0,因此简单起见推荐 的常数缩放策略。ES 的实验结果

ADM-ES 优于其他 stochastic samplers:

ES 改善采样轨迹

我们可以看到 ES 将原有的采样轨迹(绿色线)推到了蓝色线,后者更靠近训练阶段得到的向量场(红色线)。通过对每一步采样设置 random seed,我们从下图发现 ADM(第一行) 和 ADM-ES(第二行)生成得到的样本点相似,但是后者的生成质量更高。

文章的最后

如果你有从头训练一个扩散模型的需求,推荐一下我们 ICML 2023 的文章,提出了一行代码提升扩散模型生成质量和训练速度的方法,改论文从训练角度给出了曝光偏差的多种方案。

https://arxiv.org/abs/2301.11706代码链接:

https://github.com/forever208/DDPM-IP

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧