©PaperWeekly 原创 · 作者 | 黄中展

单位 | 中山大学博士生

研究方向 | 生成式神经网络

多模态大模型具备创造的潜力吗?能力如何?本文从大模型创造力测评与增强等方面进行了探索,从幽默创新响应的角度,揭示了大模型在创新任务上的潜力和不足。目前该成果被计算机视觉顶级会议 CVPR 2024 录用。

https://arxiv.org/abs/2312.02439项目主页:

https://zhongshsh.github.io/CLoT/代码链接:

https://github.com/sail-sg/CLoT为了探索多模态大模型的创造力,中山大学 HCP 实验室林倞教授团队联同 Sea AI Lab、哈佛大学的研究人员从日本传统的创新幽默游戏“大喜利”(Oogiri)切入,探索目前多模态大模型在创新响应上的现状。并提出了让多模态大模型打破常规思维思考(Think Outside the Box)的训练方法 Creative Leap-of-Thought (CLoT)。

什么是“大喜利”创新响应游戏?

“大喜利”本来是指一系列日本传统戏剧游戏,随着时代的快速发展。现代的“大喜利”,目前一般是指一种叫 Tonchi (頓智) 的游戏,通常以游戏节目或智力问答节目的形式呈现,可以参考 B 站的日本著名节目 IPPON 大獎賽 (视频链接):

https://www.bilibili.com/video/BV1jt4y1g7ob/

玩家被提供各种多模态内容,可以是简单的问题、随机图像等,然后提示玩家想出幽默的、有创意的反应,以达到令人惊讶的喜剧效果,如下图所示的例子。

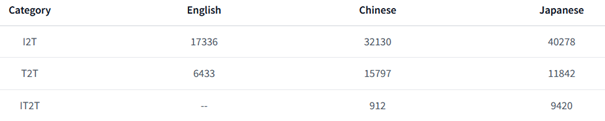

例子1:在第一个“图文到文”的例子中,玩家要求阅读图像,和上面对应的文字,尝试想出一段文字填入对应的“问号?”位置,使得整个图文可以展示出幽默且有创意的效果。在第一个例子中,老人向年轻人寻求帮助,从正常的思维来看,可能的填写方式可以是“请问 xxx 路怎么走?”或者是"可以带我回家吗,我迷路了"之类的┓( ´∀` )┏。然而,所给出的“你...你能帮我解开手铐吗?”的写法具有冲击感、幽默感,且看起来确实是这么一回事,使人忍俊不禁。例子2:在第二个“图到文”的例子中,玩家要求看图配文,并使得图文搭配起来具有幽默效果。这张图看起来是一个很普通的拖车的图片(需要注意的是,在“大喜利”游戏中,一般图片都是很普通的日常图片)。配文“快让开!我的兄弟伤得很严重”让倾斜着身体 45° 向上的车看起来像是一个奄奄一息的车子。在道路上快速的驰骋也确实体现了位于下方的车很着急,急着送兄弟去医院。整体来说配文相当有趣且幽默!例子3:在第三个“图到文”的例子中,玩家被要求根据所给的文字进行回复,使得回复和问题合在一起具备幽默感。本例子中的回复似乎在调侃程序员的日常工作主要就是代码的“复制+黏贴”┓( ´∀` )┏ (注:CV 工程师除了可以表示 computer vision 工程师也可以表示 ctrl+c/ctrl+v 工程师) 本工作主要关注这三种类型的“大喜利”游戏,相关数据 Oogiri-GO(如下表所示,含中英日三种语言)可以进入 Project 页面下载:https://zhongshsh.github.io/CLoT/

为什么考虑“大喜利”游戏?

“大喜利”游戏是用于探索多模态大模型创新能力的理想平台,因为:1. “大喜利”游戏是天然的创新响应任务。如上所提到的,现代“大喜利”也被称为Tonchi (頓智)。“頓”在日文和中文中都表示“突然”,而“智”的意思是“智力、洞察力或直觉”,该游戏天然地要求玩家给出令人眼前一亮、灵光一闪的创新响应;2. “大喜利”的数据格式是高度合适的。不管是“图文到文”、“图到文”还是“文到文”,这些类型都天然地和目前多模特大模型的输入输出格式吻合,即输入为“图文”,输出仅为“文”。3. “大喜利”数据质量高。创新是一件很难的事情,即使是人类,因此能作为“创新”相关的数据集并不多。鉴于该游戏长期在互联网上非常活跃(在中文社区中,一般也叫日式神吐槽/冷吐槽),而且带有大量点评数据,比如点赞数等等。正好积累了大量高质量人类创新幽默响应可以被用于研究。

性能结果展示

1. 幽默是主观的。任何一个幽默的响应都很难取悦每一个人 (人类的悲欢并不相通.jpg)。另外文化的差异、知识范围等原因也会造成不同人对不同响应的幽默理解。2. 创新是困难的。如日本著名“大喜利”节目 IPPON 大獎賽中顶尖人类选手也很难确保每一次响应都能让评委满意。如果模型响应不满意,可以让它多试几次~3. 幽默是多元的。一些常见的“调侃“、“讽刺“等手段是幽默的重要组成部分。不同的文化,甚至不同的人,对这些内容的容忍度不同,模型输出的内容可能对某些人会产生冒犯,敬请多多包容。本文、模型以及数据均只用于学术研究。 首先展示的是在本文方法 CLoT 前后的创新响应对比:

激发创造力的思维方式Leap-of-Thought (LoT)

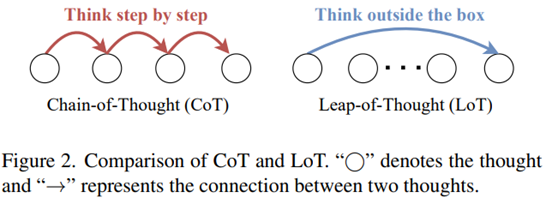

如下图(左)所示,传统的链式思考(Chain-of-Thought,CoT)方法是一种顺序思考过程,通过逐步推理指导大模型进行逻辑推理,每个后续的思考都建立在前一个思考的基础上。这一思考过程一定程度上确保了精确性和严谨性,但对于创造性问题表现不佳。如下图(右)所示,本文探索了一种新的非顺序、创造性思维范式——跳跃思维 Leap-of-Thought(LoT)。这种范式涉及到思考关联性和知识跳跃。远距离的思考也被认为是联想。与 CoT 强调逻辑紧密的思维链不同,LoT 强调打破常规思维思考问题,激发模型的创造力。

通向LoT! 激发创造力的训练方法CLoT

基于所提出的 Oogiri-GO 数据集,本文探索出一套激发多模态大模型创造力的训练方法 CLoT。如下图所示,CLoT 包括两个阶段:1. 关联性指令微调。在这一阶段,本文设计生成式和判别式模板,将 Oogiri-GO 数据集转换为指令微调的训练数据,用于训练多模态大模型,使得模型具备初步的创新响应能力。2. 探索性自我调整。在这一阶段中,本文首先通过设计远关联的条件词,促使(1)中的模型生成多样化且与输入远关联的回答,并设计筛选流程,获得可靠的新 LoT 数据。随后,新数据被转换成指令微调的训练数据,用于进一步微调模型,具体地:

性能评估

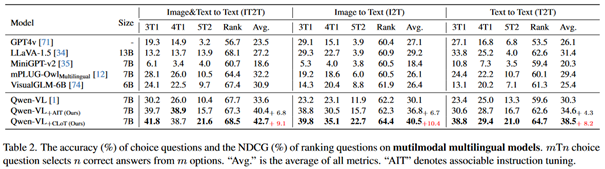

为了尽可能全面评估 CLoT,本文基于 Oogiri-GO 数据集,设计了选择题和排序题作为量化评估方式。实验结果表明,CLoT 能够显著提高多模态大模型(如 Qwen 和 CogVLM)的性能,显著超越包括 GPT4v 在内的先进模型。另外,与其他先进推理框架 CoT 等相比,在各项量化指标下也是有显著优势的。

此外,研究团队还通过用户调查,证实了 CLoT 帮助模型生成了更好的幽默内容。

研究团队还考虑到了 CLoT 的泛化性,用“看云猜物 CGG”和“发散思维测试 DAT”两个其他任务评估 CLoT 的性能,实验结果显示 CLoT 相对于基准模型具有更好的准确度,说明 CLoT 具备不错的泛化能力。DAT 是一种用于评估人类联想创造能力的测试。

总结

本文基于研究创造力的理想平台”大喜利”幽默创新响应游戏,来首次探讨了多模态大模型的创新响应能力。揭示了现有大模型在创造力、幽默能力在内的能力不足的现状,并提出缓解目前现状的提升方法。本工作已开源 https://github.com/sail-sg/CLoT,欢迎使用和引用。

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧