「多语言图像描述」最强评估基准XM3600来了!涵盖36种语言

新智元报道

新智元报道

【新智元导读】谷歌出品,当下最强的多语言图像描述基准XM3600!

图像描述(Image Caption)是计算机视觉领域的一项基础任务,也是融合了视觉和语言在内的多模态研究的核心任务,模型需要给指定的图像生成一个自然语言描述的标题。

但当下主流图像描述的数据集都是基于英文标注的,只有几个小数据集用到了非英语,涵盖的语言数量非常有限,让小众语言的使用者无法享受到视觉技术发展所带来的的无障碍服务。

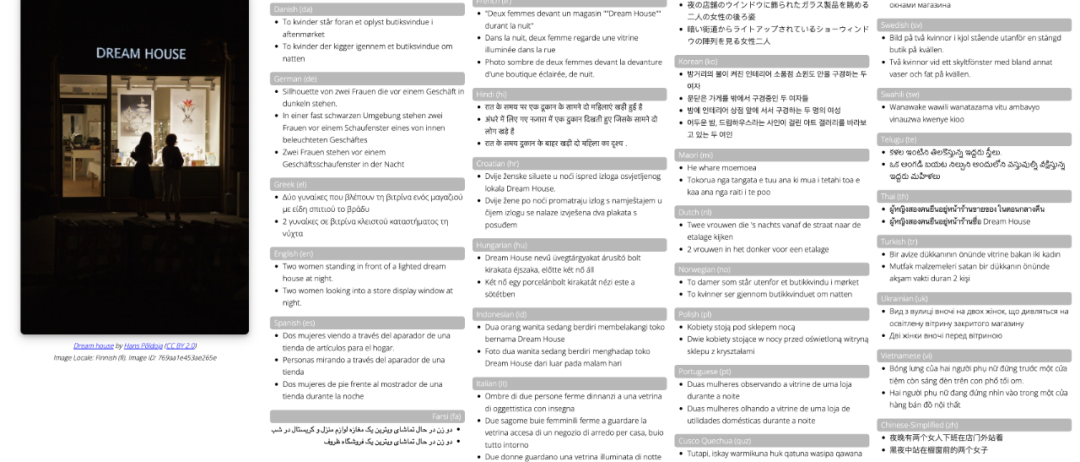

最近Google开源了一个全新的图像描述评估数据集Crossmodal 3600(XM 3600)包含3600张图像,每张图像都由36种语言进行描述。

图像内容也是精挑细选,都是这36种语言使用者所在地收集的图像。为了避免直接翻译导致的标注问题,所有图像描述都由人工编写。

实验证明,XM3600也是当下质量最高的多语言图像描述基准!

论文链接:https://arxiv.org/pdf/2205.12522

用36种语言描述一张图片

用36种语言描述一张图片

图像描述任务对于视障用户来说非常重要,但目前数据集主要是英文的,其他语言的小数据集有德语、法语、捷克语等,涵盖的人群比例非常小。

最近一些工作证明了利用机器翻译技术一定程度上可以帮助建立多语言图像描述模型(以英语描述为起点),但在常用的图像描述自动评估指标CIDEr1无法有效地评估翻译后的结果,导致其他语言与英语集上的指标在人类一致性上非常不好。

所以目前来说,最值得信赖的模型评估指标还只能是由人来编写。

文章中提出的XM3600图像描述评估数据集为多语言图像字幕提供了一个强大的基准,并可以能够可靠地用于比较这一新兴领域的研究贡献。

每张图像都会提供多个标题,文本内容也会尽可能贴合当地文化,而不只是翻译,比如下面这张汽车的图像,西班牙语的描述中提到了「数字42」,泰语中的描述包括「敞篷车」等英语描述中没有出现的元素。

完整的36种语言对于该图像的描述如下表所示,对应的中文描述为「在展厅里停靠着一排老爷⻋正在展出,离得最近的是这一辆灰色的」和「⻋展中都是保时捷敞篷跑⻋」。

XM3600以36种语言为来自Open Images数据集的3600幅不同地理位置的图像提供了261,375个人工生成的参考标题。

通过使用 CIDEr指标将生成的标题与手动提供的标题进行比较来衡量标题的质量,该指标的取值范围从0(与参考标题无关)到10(完全匹配参考标题)。

当比较成对的模型时,研究人员观察到模型输出的 CIDEr 得分的差异之间有很强的相关性,并且同时比较模型输出的人类评价,可以发现XM3600是一个可靠的工具,能够高质量的自动比较之间的图像字幕模型在英语以外的各种语言。

36种语言中,研究人员选择了30种英语以外的语言,主要是基于语言在网络内容中所占的比例。

另外五种语言的原则主要包括资源不足的语言,这些语言有许多母语使用者,或者是来自各大洲的主要母语,如泰卢固语、斯瓦希里语等,再加上将英语作为基准,一共是36种语言。

图像的选择主要基于地理位置。

但许多区域使用不止一种语言,而且有些区域没有被这些图像很好地覆盖,因此研究人员设计了一种算法来最大化所选图像与目标语言所在区域之间的对应关系。

该算法首先选择地理数据对应的语言的图像,获得一个初始的图片池(例如波斯语)之后,再根据每种语言候选图像池进行扩增。

如果在使用某种语言的地区没有足够的图像,那么研究人员就会逐渐将地理选择半径扩大:1)使用该种语言的国家; 2)使用该种语言的大陆; 以及最后的手段,3)来自世界任何地方。

这一策略成功地为36种语言中的大多数提供了来自适当地区的100幅图像,除了波斯语(使用了14幅大陆级图像)和印地语(所有100幅图像都是全球级别的,因为区域内的图像分配给了孟加拉语和泰卢固语)

在描述生成时,所有3600个图像(每种语言100个图像)都用所有36种语言进行了标注,每种语言平均有两个标注,总共产生了261,375个描述标题。

标注人员每批处理15个图像。第一个屏幕显示所有的15张图片及其英文描述,描述由模型自动生成的,以一致的形式「<主要的对象>在<环境>中做<活动>」,通常带有对象的属性,如「微笑」的人、「红色」的汽车等。

标注人员需要对描述质量进行评分,标准包括从「优秀」到「差」的4个等级,加上「信息不足」的可选项,强制标注人员仔细评估图像描述的质量,并使他们能够内化标题的风格。

第二次屏幕将再次显示图像,但不显示英文描述,并要求标注人员为每个图像生成目标语言的描述性标题。

每批15个图像可以保证标注人员在不记住确切标题的情况下内化样式,并且只根据图像内容生成标题而非翻译,而且实现了不同语言之间的样式一致性。

随后研究人员对每种语言进行了两到五次试点研究,以排除标题生成过程中的故障,并确保高质量的标题。

首先随机选取600张图片作为样本,然后,为了测量特定语言中标题的质量,对于每个图像选择评估一个手动生成的标题。

结果可以发现,对于36种语言中的25种,被评为「好」或「优秀」描述的百分比在90% 以上,其余语言都在70% 以上。

在36种语言中,有26种语言的字幕被评为「差」的比例低于2% ,其余的都低于5%

对于像库斯科 · 克丘亚语和捷克语这样的黏着语来说,每个描述的单词数量可能低至5或6个;而对于像越南语这样的分析语(analytic language)来说,单词数量可能高达18个。

根据文字的不同,字母的数量也有很大的差异,从韩语的25个字母到印度尼西亚语的90个字母。

最后,研究人员通过训练一个多语言图像描述模型的四个变体,并比较30+语言的 XM3600数据集中模型输出的 CIDEr 差异来对图像字幕模型变化进行排序,经验性地测量了 XM3600标准的能力,并对人类进行评估。

实验结果观察到 CIDEr 差异与人类评价之间有很强的相关性。这些结果是支持使用 XM3600作为参考数据集,以实现高质量的多语言图像描述模型之间的自动比较。

PALI模型已经使用 XM3600对图像描述、文本检索和文本检索的英文以外的模型性能进行了评估。研究人员发现,多语言描述可以让PaLI模型在缩放后性能更强,特别是对于资源较少的语言。

微信扫码关注该文公众号作者