【新智元导读】谷歌刚刚上线了一个炸弹级「通才」模型PaLM-E,足足有5620亿参数。它是一种多模态具身视觉语言模型,从引导机器人执行任务,到回答关于可观察世界的问题,全都能搞定。

大语言模型的飞速「变异」,让人类社会的走向越来越科幻了。点亮这棵科技树后,「终结者」的现实仿佛离我们越来越近。前几天,微软刚宣布了一个实验框架,能用ChatGPT来控制机器人和无人机。谷歌当然也不甘其后,在周一,来自谷歌和柏林工业大学的团队重磅推出了史上最大视觉语言模型——PaLM-E。

论文地址:https://arxiv.org/abs/2303.03378作为一种多模态具身视觉语言模型 (VLM),PaLM-E不仅可以理解图像,还能理解、生成语言,而且竟然还能将两者结合起来,处理复杂的机器人指令。此外,通过PaLM-540B语言模型与ViT-22B视觉Transformer模型相结合,PaLM-E最终的参数量高达5620亿。

PaLM-E,全称Pathways Language Model with Embodied,是一种具身视觉语言模型。它的强大之处在于,能够利用视觉数据来增强其语言处理能力。

当我们训练出最大的视觉语言模型,并与机器人结合后,会发生什么?结果就是PaLM-E,一个 5620亿参数、通用、具身的视觉语言通才——横跨机器人、视觉和语言

据论文介绍,PaLM-E是一个仅有解码器的LLM,在给定前缀(prefix)或提示(prompt)下,能够以自回归方式生成文本补全。其训练数据为包含视觉、连续状态估计和文本输入编码的多模式语句。经过单个图像提示训练,PaLM-E不仅可以指导机器人完成各种复杂的任务,还可以生成描述图像的语言。可以说,PaLM-E展示了前所未有的灵活性和适应性,代表着一次重大飞跃,特别是人机交互领域。更重要的是,研究人员证明,通过在多个机器人和一般视觉语言的不同混合任务组合进行训练,可以带来从视觉语言转移到具身决策的几种方法,让机器人规划任务时能够有效地利用数据。除此之外,PaLM-E尤为突出的一点在于,拥有强大的正迁移能力。在不同领域训练的PaLM-E,包括互联网规模的一般视觉-语言任务,与执行单一任务机器人模型相比,性能明显提高。而在模型尺度上,研究人员则观察到了一个显著的优势。语言模型越大,在视觉语言与机器人任务的训练中,保持的语言能力就越强。从模型规模来看,5620亿参数的PaLM-E几乎保持了它所有的语言能力。尽管只在单个图像进行训练,但PaLM-E在多模态思维链推理和多图像推理等任务中表现出突出的能力。在OK-VQA基准上,PaLM-E取得了新的SOTA。测评结果

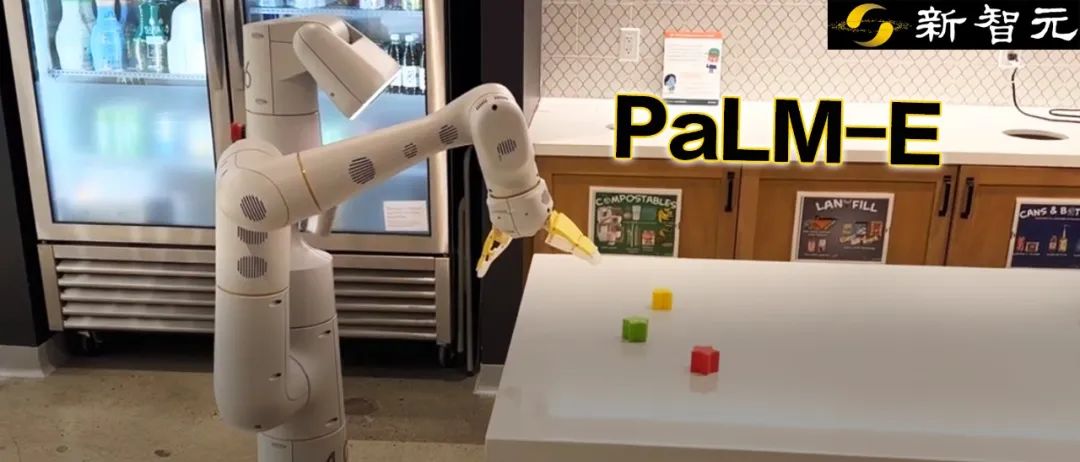

在测试中,研究人员展示了如何使用PaLM-E在两个不同实体上执行规划以及长跨度的任务。值得注意的是,所有这些结果都是使用基于相同数据训练的相同模型获得的。在以前,机器人通常需要人工的协助才能完成长跨度任务。但现在,PaLM-E通过自主学习就可以搞定了。比如,「从抽屉里拿出薯片」这类指令中,就包括了多个计划步骤,以及来自机器人摄像头的视觉反馈。经过端到端训练的PaLM-E,可以直接从像素开始对机器人进行规划。由于模型被集成到一个控制回路中,所以机器人在拿薯片的过程中,对途中的干扰都有鲁棒性。机器人:1. 走到抽屉旁 2.打开最上面的抽屉 3. 从最上面的抽屉里拿起绿色的薯片 4.放在柜台上。同样,让机器人去拿一个苹果时,给出图片后,机器人执行任务步骤如下——机器人:1.走向苹果 2.拿起苹果 3.把它拿给操作员 4.放下苹果 5.完成。除了执行长跨度任务,PaLM-E可以让机器人执行规划任务,比如排列积木。研究人员根据视觉和语言输入成功地进行多阶段的计划,并结合了长时间范围的视觉反馈,进而让模型能够成功地规划一个长周期的任务「将积木按颜色分类到不同的角落」。如下,在排列组合上,机器人化身为多面手,按颜色将积木排序。模型的泛化方面,PaLM- E控制的机器人可以把红色积木移到咖啡杯的旁边。值得一提的是,数据集只包含有咖啡杯的三个演示,但其中没有一个包括红色的积木块。类似的,虽然模型此前从未见过乌龟,但照样可以顺利地把绿色积木推到乌龟旁边在零样本推理方面,PaLM-E可以在给定图像的情况下讲述笑话,并展示了包括感知,基于视觉的对话和计划在内的能力。多张图的关系,PaLM-E也整得很明白,比如图一(左)在图二(右)的哪个位置。此外,PaLM-E还可以在给定带有手写数字的图像执行数学运算。比如,如下手写餐馆的菜单图,2张披萨需要多少钱,PaLM-E就直接给算出来了。最后,研究结果还表明,冻结语言模型是通向完全保留其语言能力的通用具身多模态模型的可行之路。但同时,研究人员还发现了一条解冻模型的替代路线,即扩大语言模型的规模可以显著减少灾难性遗忘。https://palm-e.github.io/