【新智元导读】强大P图工具DragGAN一作正式成为南洋理工大学助理教授。

还记得前一阵子爆火的DragGAN吗?

没错,就是那个拖一拖,拽一拽,就能实现完美P图的模型。

因为其「傻瓜式」的操作,和强大的性能,直接炸翻了作图圈。

人们直言,现在终于能实现甲方「让大象转过来」的需求了!

而现在,论文的第一作者Xingang Pan也正式成为了南洋理工助理教授。

消息一出来,业内人士也是第一时间送上了祝贺。

在Pan教授的GitHub主页上,他的个人职务已经更新完毕。

在成为南洋理工大学的助理教授之前,他是马克斯·普朗克计算机科学研究所的博士后研究员,由Christian Theobalt教授指导。

在此之前,他于2016年在清华大学获得学士学位,并2021年在香港中文大学多媒体实验室获得博士学位,导师是汤晓鸥教授。

他的研究兴趣在计算机视觉、机器学习和计算机图形学的交叉领域。

目前,他的研究方向主要集中在生成式AI模型、AI与人类协同内容生成、3D/视频编辑和生成、神经场景表示和渲染,以及物理感知内容生成。

目前,Pan教授开始在推特上进行「招生」宣传,表示任何对生成式AI感兴趣,想继续跟进DragGAN的研究者都可以来。

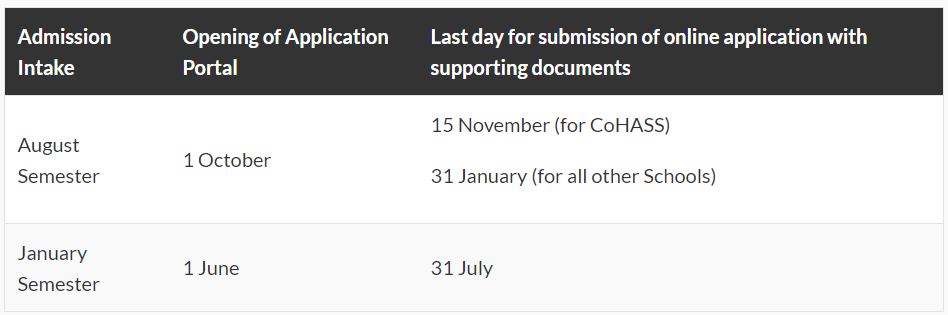

一月学期申请的DDL是7月31日,而七月学期申请的DDL是1月31日。

南洋理工大学的官网上也是给出了申请指南。

包含具体的要求、学制,以及申请费。

要知道,南洋理工大学(新加坡)是很多人心中的科研圣地。

作为一所科研密集型大学,在2023年的QS排名中,全球排名第19,亚洲排名第4。

2022年的U.S.News世界大学排名中,全球排名第33,亚洲排名第3。

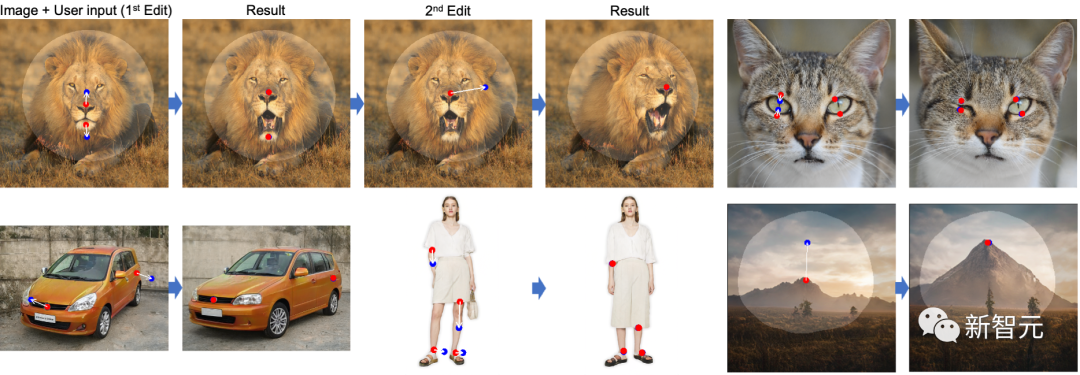

DragGAN之所以厉害,是因为研究团队应用了一种强大但还未被充分探索的控制GAN的方法——以交互的方式将图像中任意一点精确「拖动」至目标点。

DragGAN主要包括以下两个主要组成部分:

一个新的点跟踪方法,利用区分性的GAN特征持续定位操作点的位置

通过DragGAN,任何人都可以对像素进行精确的控制,进而编辑如动物、汽车、人类、风景等多种类别的姿态、形状、表情和布局。由于这些操作在GAN的学习生成图像流形上进行,因此它们倾向于生成逼真的输出,即使在富有挑战性的场景下也是如此,例如被遮挡的内容和变形的图像。定性和定量的对比表明,DragGAN在图像操作和点跟踪任务中,都明显优于先前的方法。在DragGAN的加持下,用户只需要设置几个操作点(红点),目标点(蓝点),以及可选的表示可移动区域的mask(亮区)。然后,模型就会自动完成后续的图像生成,其中,动态监控步骤会让操作点(红点)向目标点(蓝点)移动,点追踪步骤则通过更新操作点来追踪图像中的对象。此过程会一直持续,直到操作点达到其相应的目标点。具体来说,团队通过在生成器的特征图上的位移修补损失来实现动态监控,并在相同的特征空间中通过最近邻搜索进行点追踪。值得注意的是,用户可以通过添加mask的方式,来控制需要编辑的区域。可以看到,当狗的头部被mask时,在编辑后的图像中,只有头部发生了移动,而其他区域则并未发生变化。但如果没有mask的话,整个狗的身体也会跟着移动。这也显示出,基于点的操作通常有多种可能的解决方案,而GAN会倾向于在其从训练数据中学习的图像流形中找到最近的解决方案。因此,mask功能可以帮助减少歧义并保持某些区域固定。在真实图像的编辑中,团队应用GAN反转将其映射到StyleGAN的潜在空间,然后分别编辑姿势、头发、形状和表情。到目前为止,团队展示的都是基于「分布内」的编辑,也就是使用训练数据集内的图像来实现编辑。但DragGAN实际上具有强大的泛化能力,可以创建出超出训练图像分布的图像。比如,一个张得巨大的嘴,以及一个被极限放大的车轮。在某些情况下,用户可能希望始终保持图像在训练分布中,并防止这种超出分布的情况发生。实现这一目标的方法可以是对潜在代码𝒘添加额外的正则化,但这并不是本文讨论的重点。首先,与UserControllableLT相比,DragGAN能够编辑从输入图像中检测到的特征点,并使其与从目标图像中检测到的特征点相匹配,而且误差很小。从下图中可以看出,DragGAN正确地张开了照片中人物的嘴,并调整了下巴的形状来匹配目标的脸型,而UserControllableLT未能做到这一点。在DragGAN与RAFT、PIPs和无追踪的定性比较中,可以看得,DragGAN可以比基线更准确地跟踪操作点,进而能够产生更精确的编辑。而在移动操作点(红点)到目标点(蓝点)的任务上,定性比较的结果显示,DragGAN在各种数据集上都取得了比UserControllableLT更加自然和优秀的效果。如表1所示,在不同的点数下,DragGAN都明显优于UserControllableLT。而且根据FID的得分,DragGAN还保留了更好的图像质量。由于具有更强的跟踪能力,DragGAN还实现了比RAFT和PIPs更精确的操纵。正如FID分数所显示的,如果跟踪不准确的话,很可能会造成编辑过度,从而降低图像质量。虽然UserControllableLT的速度更快,但DragGAN在很大程度上提升了这项任务的上限,在保持相对较快的运行时间的同时,实现了更靠谱的编辑。https://twitter.com/XingangP/status/1666496444092538886