【新智元导读】AI智能体或许会是下一个前沿。今天,德扑AI之父Noam Brown宣布加入OpenAI。

首席科学家Andrej Karpathy认为,AI智能体代表着一个疯狂的未来,此刻正是再次回归神经科学,从中寻求灵感的时刻。

他表示,每次有与智能体相关研究一出来,OpenAI团队都要仔细研究一番。就在今天,德扑AI之父Noam Brown官宣重磅加盟OpenAI!Brown在推特上发布了这一重量级消息,表示自己在德扑AI领域的经验将会让LLM比现有的GPT-4强上1000倍。「我很激动地宣布,我已加入OpenAI!很多年来,我一直在研究如何让AI学会自己和自己玩一些类似扑克牌的游戏,以及训练它们在游戏中的推理能力。现在,我有机会能够探索如何在更广泛的情况下推广这些方法了!如果成功的话,有一天我们能看到新的大语言模型性能要比GPT-4好上1000倍。」

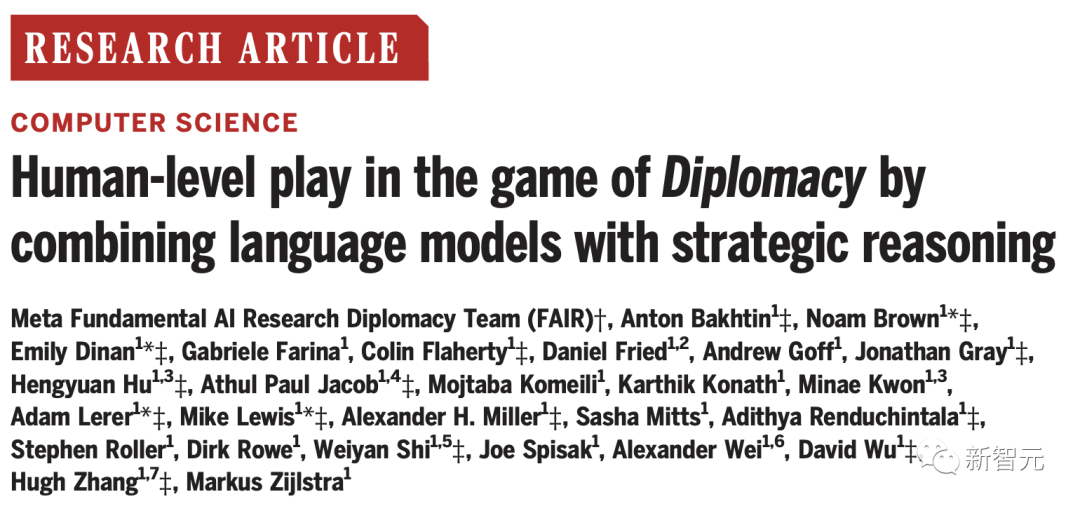

Brown是OpenAI的研究科学家,从事多步骤推理、自我游戏(self-play)和多智能体AI的研究。Brown之前曾在Meta工作,Brown和他的队友们开发了CICERO,这是第一个在战略游戏「Diplomacy」中达到人类水平的AI。

论文地址:https://noambrown.github.io/downloads/diplomacy_science_all.pdfBrown还将他的研究用于制作第一个在无上限扑克中击败顶级人类的AI。Brown和他在CMU的顾问一起创造了Libratus和Pluribus,它们在人类与机器的比赛中击败了顶级的人类德扑大师。同时,Libratus获得了Marvin Minsky AI杰出成就奖。Pluribus还登上了「Science」的封面,并获得了「Science」2019年年度突破的亚军。他还被评为「麻省理工科技评论」35位35岁以下创新者之一。Noam Brown在卡耐基梅隆大学获得了计算机科学博士学位。在CMU之前,Brown在联邦储备委员会的国际金融市场部工作,研究金融市场的算法交易。Brown还在推特下面回顾了游戏AI的简易版发展史,从AlphaGo说起。但其中的关键是,AI在走每一步棋之前都要思考1分钟。这对它的提高有多大?对于AlphaGoZero来说,这相当于将预训练扩大了100000倍。可以看到,上图中横坐标是不同版本的AlphaGo,纵坐标则是各版本的Elo评分。这里简单插播一个科普,Elo评分是一种用于衡量棋手、运动员、游戏玩家等竞技水平的评分系统。一开始是由美国国际象棋大师艾洛(Arpad Elo)于20世纪50年代提出的,目的就是为了更加公正地评定国际象棋选手的水平。可以看到,人类的最佳水平大概在3500+的位置,而带有树状搜索的Zero版AlphaGo一骑绝尘,Elo高达5000+。该发现也是让Brown开发的Libratus玩儿牌AI首次战胜了人类。

Jim Fan也在推上表示,游戏AI研究中的很多内容都可以应用在LLM上,这会是很关键的一个点。「我相信,下一代的大语言模型会大量从游戏AI的研究中借鉴东西。Noam Brown加入OpenAI,以及DeepMind Gemini表示会从AlphaGo中借鉴技术等等,都在佐证这一点。这实际上是很有道理的。游戏AI在训练中所采用的自己和自己对打的策略,以及在推理时采用的树状搜索(tree search)的方法,让AI在诸如围棋、扑克、Dota、星际争霸等游戏中能够赢过人类。根源在于,这些方法以一种高度可扩展的方式提升了模型推理的能力。目前,我们已经见过很多这种方法被应用在LLM领域了。比如Voyager,这是一个能推断时间的算法,可以让AI智能体不停写代码,此外,思维之树(Tree of Thought)在语境中的LLM与搜索引擎结合,以此促进推理的进步。https://twitter.com/polynoamial/status/1676971503261454340

https://twitter.com/DrJimFan/status/1677000660791992320