©作者 | Feng Liu

单位 | 中国科学院大学

宣传一下和小松师兄合作的工作 imTED,被 ICCV 2023 接收了。

论文题目:

Integrally Migrating Pre-trained Transformer Encoder-decoders for Visual Object Detection

https://arxiv.org/abs/2205.09613

https://github.com/LiewFeng/imTED

太长不看,一句话总结就是,将 MAE 预训练好的 Encoder-Decoder 整体迁移到目标检测中,比只迁移 Encoder 的方案性能↑,泛化性↑。

Motivation

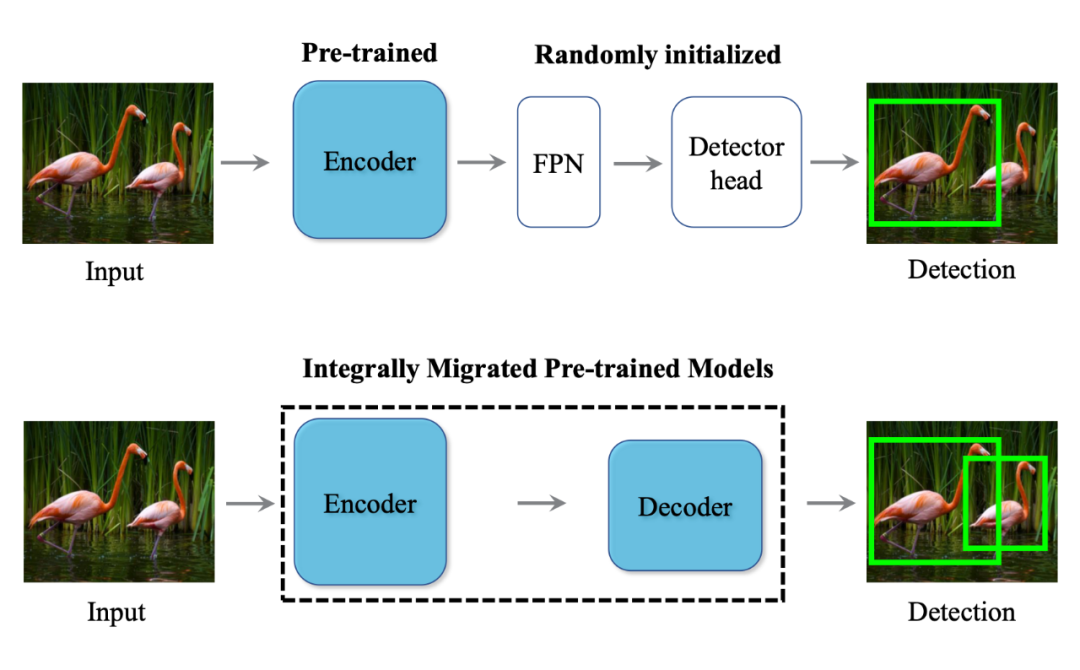

在做目标检测等下游任务的时候,往往是把在 ImageNet 上预训练的 Backbone 迁移过去,对于检测头来说,都是随机初始化的,这是因为在 ImageNet 是进行预训练的时候,不管是基于 Supervised Learning 还是 Self-supervised Learning 中的 Contrastive Learning 的方式,最后的head都是一个简单的 fc 或 MLP,没法直接迁移过去。最近大火的基于 Masked Image Modeling 的预训练方式,在训练 Backbone(Encoder)的同时,还会有一个 Decoder,这就为获得一个经过预训练的检测头提供了一个基础。如图 1 所示。

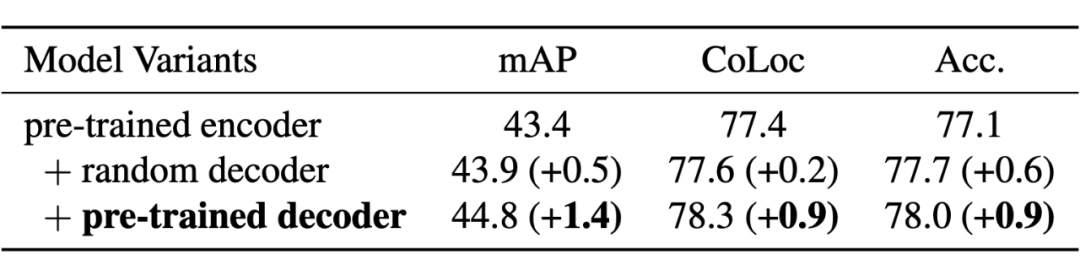

MIM 的 Decoder 具有很强重构能力,将预训练好的 Encoder 和 Decoder 整体迁移到目标检测器中,能不能对定位性能有所提升呢?为了验证这个想法,我们在 ImageNet 是进行了一个单目标检测实验,实验性能如表 1 所示,

使用预训练的 Enocder-Decoder,比只使用预训练的 Encoder,可以提高 1.4mAP,0.9CoLoc 和 Acc,其中 CoLoc 是定位精度,Acc 是分类精度,为了排除Decoder引入的计算量对实验的影响,我们增加了一个对照实验,预训练的 Encoder + 随机初始化的 Decoder,也能提升性能,但提升幅度远小于预训练的 Encoder-Decoder,尤其是在 CoLoc 指标。实锤了,经过预训练的 Decoder 是个好东西,直接丢掉就可惜了。用起来!

Method

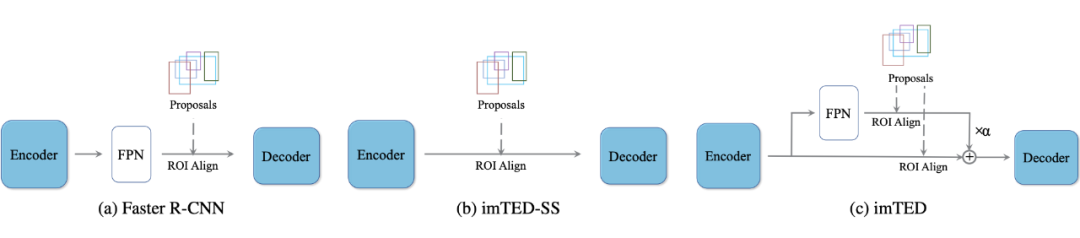

Motivetion 中的实验验证了 Decoder 对检测任务是有帮助的,要如何把预训练的 Encoder-Decoder 整体迁移到目标检测器中呢?简单将检测头替换为经过预训练的 Decoder 是否可行?如图 2(a)所示:

这个简单粗暴的迁移方案会带来一个尴尬的局面,那就是在经过预训练的 Encoder 和 Decoder 之间有一个随机初始化的 FPN,经过随机初始化的 FPN 处理的特征分布跟 Encoder 输出的特征分布肯定是不一样的,这样预训练的 Decoder 的功能就要大打折扣了。为了构建一个跟预训练时一致的特征流,我们取 Encoder 的最后一层的特征输入到 Decoder 中,如图 2(b)所示,这样才能将预训练的 Decoder 的威力充分发挥出来。

图 2(b)中方案虽然构建了一个跟预训练相同的特征流,但是丢掉了多尺度特征,而多尺度特征对于目标检测来说又十分重要,为了弥补这一缺陷,我们提出了一个多尺度调制器,如图 2(c)所示。具体来说,就是在 RoI Align 的时候,我们分两组进行,一组对 Encoder 最后一层的特征进行,另一组对 FPN 输出的多尺度特征进行,然后以 learnable 的方式将这两个特征组合后送入到 Decoder 中,如式 1 所示。为了保持跟预训练时一致的特征流,我们将 初始化为 0,然后在模型的更新中按需从 FPN 提取多尺度特征。

Experiment

如表 2 所示,我们训练 36 epoch 的 imTED+ViT-B 比训练 100epoch的 ViTDet+ViT-B 高 1.7 box AP。

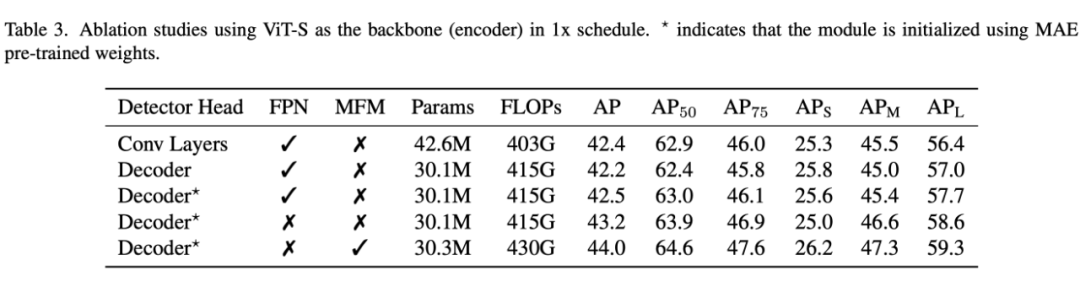

将原来的检测头简单替换为预训练的 Decoder,仅能提升 0.1AP(42.4 v.s. 42.5),而整体迁移和多尺度特征调制分别可以提升 0.7AP(42.5 v.s. 43.2)和 0.8AP(43.2 v.s. 44.0)。

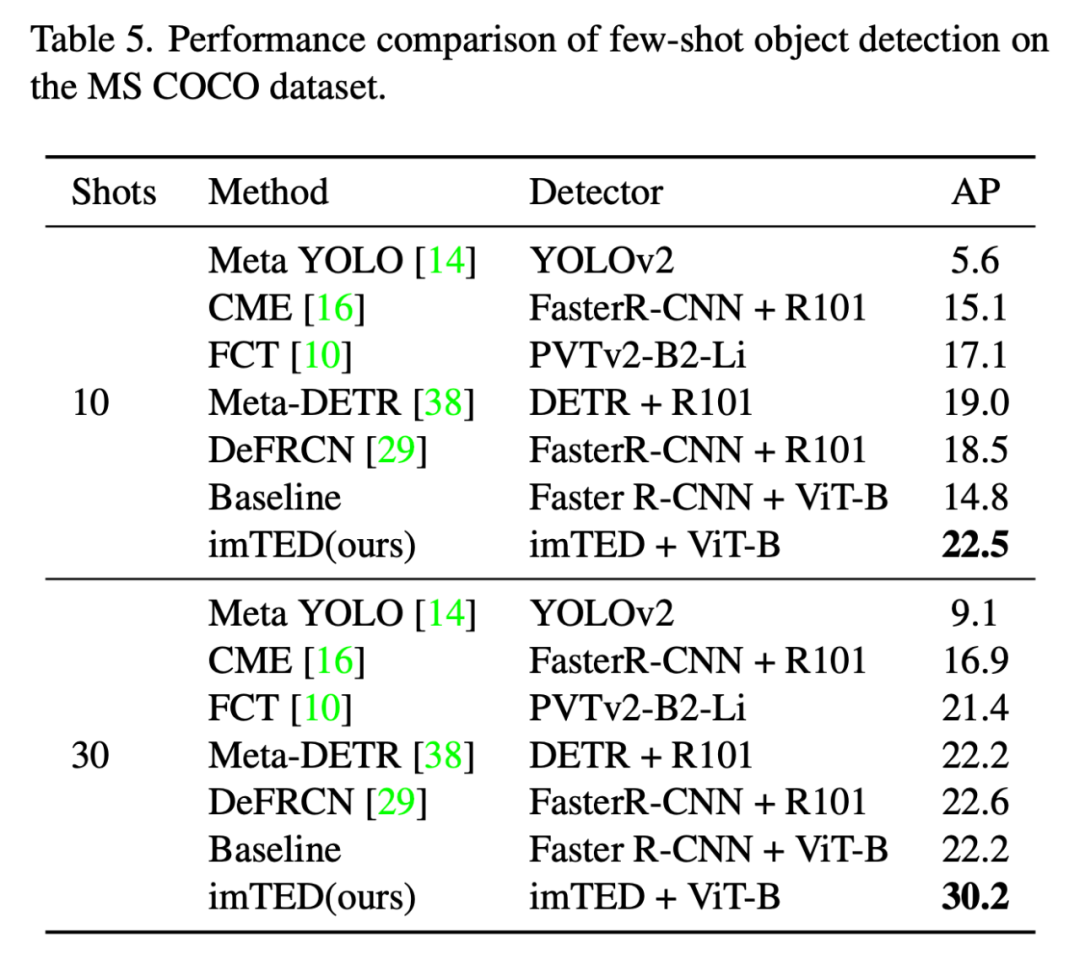

为了验证 imTED 的泛化性,我们在小样本目标检测这个任务进行了实验,10 shot 和 30 shot 分别比 baseline 高 6.7AP 和 8AP,比 SOTA 的性能也高很多。论文中还有 Low shot,遮挡目标检测等实验,详情移步论文啦。

Conclusion

我们的工作探索了将预训练的 Encoder-Decoder 整体迁移到目标检测器的方案,并验证了性能上优越性,希望可以给大家带来一些思考和启发,比如在设计预训练的任务时可以同时考虑对下游任务友好的设计(结构设计,loss 设计等)。

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧