Sam Altman剑桥演讲遭抵制,MIT学者惊曝Llama 2开源能造毁灭人类病毒!AI大佬激烈对线战火持续

新智元报道

新智元报道

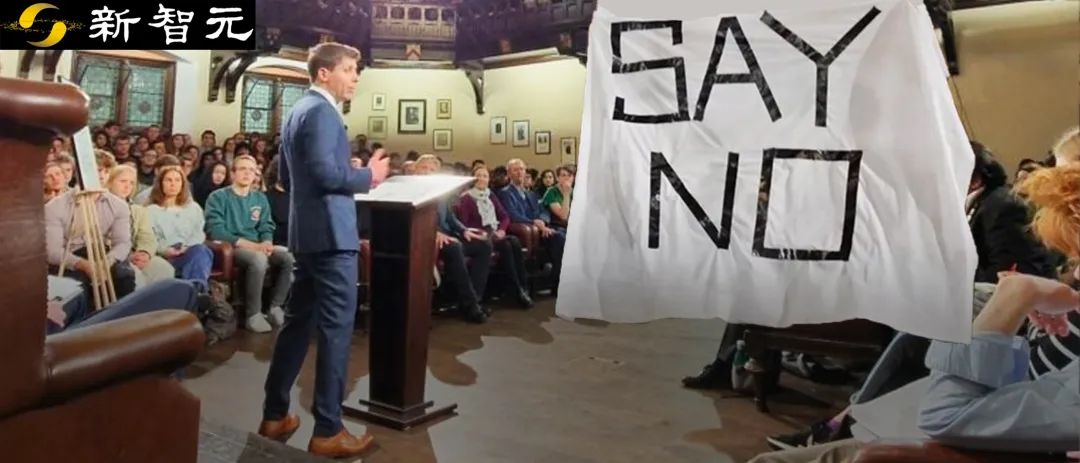

【新智元导读】「AI灭绝人类」的全球讨论继续升级,Sam Altman在剑桥活动现场被抗议者当面抵制!而LeCun、吴恩达的「开源派」和Bengio、马库斯的 「毁灭派」,也纷纷甩出言辞恳切的联名信,继续征集签名中。

开源AI,危险吗?

「毁灭派」Bengio、Tegmark、马库斯

「开源派」LeCun、吴恩达

图灵三巨头&吴恩达,论战再再再升级

我怀疑吴恩达和Yann LeCun忽略了大公司希望制定法规的主要原因。几年前,一家自动驾驶公司的创始人告诉我,他喜欢安全法规,因为如果你满足了法规,就能减少事故的法律责任。

全球AI安全峰会:28国签署宣言

微信扫码关注该文公众号作者

戳这里提交新闻线索和高质量文章给我们。

来源: qq

点击查看作者最近其他文章