(本文阅读时间:7分钟)

在 NLP 领域,大规模语言模型(LLM)已经成功地在各种自然语言任务中充当通用接口。只要我们能够将输入和输出转换为文本,就能使得基于 LLM 的接口完成一个任务。举例而言,对于摘要任务,我们能够将文档输入到语言模型,语言模型就可以生成摘要。

尽管 LLM 在 NLP 任务中取得了成功的应用,但研究人员仍努力将其原生地用于图像和音频等多模态数据。作为智能的基本组成部分,多模态感知是实现通用人工智能的必要条件,无论是对于知识获取还是与现实世界打交道。更重要的是,解锁多模态输入能够极大地拓展语言模型在更多高价值领域的应用,比如多模态机器人、文档智能和机器人技术。

因此,微软亚洲研究院在论文《Language Is Not All You Need: Aligning Perception with Language Models》中介绍了一个多模态大规模语言模型(MLLM)——KOSMOS-1,它可以感知一般模态、遵循指令(即零样本学习)以及在上下文中学习(即少样本学习)。研究目标是使感知与 LLM 保持一致,如此一来模型能够看到(see)和说话(talk)。研究员们按照 METALM(参见论文《Language models are general-purpose interfaces》 )的方式从头开始训练 KOSMOS-1。

论文地址:

https://arxiv.org/pdf/2302.14045.pdf

项目地址:

https://github.com/microsoft/unilm

研究员们将一个基于 Transformer 的语言模型作为通用接口,并将其与感知模块对接。他们在大规模多模态语料库上训练模型,语料库包括了文本数据、任意交错的图像和文本、以及图像描述数据。此外,研究员们还通过传输纯语言数据来校准跨模态的指令遵循能力。最终,KOSMOS-1 模型原生支持零样本和少样本学习设置下的语言、感知语言与视觉任务,具体如下表1所示。表1:在零样本和少样本下测试了 KOSMOS-1 在自然语言、多模态和视觉任务的能力。

研究员们在下图1和图2中展示了一些生成示例。除了各种自然语言任务,KOSMOS-1 模型能够原生处理广泛的感知密集型任务,如视觉对话、视觉解释、视觉问答、图像描述生成、简单的数学公式、OCR 和带描述的零样本图像分类。他们还根据瑞文推理测验(Raven's Progressive Matrices, RPM)建立了一个 IQ 测试基准,用来评估 MLLM 的非语言推理能力。图1:KOSMOS-1 生成的示例(蓝色框是输入提示,粉色框是 KOSMOS-1 输出)。(1)-(2)视觉解释,(3)-(4)视觉问答,(5)基于网页的问答,(6)简单的数学公式,(7)-(8)数字识别。

图2:KOSMOS-1 生成的示例(蓝色框是输入提示,粉色框是 KOSMOS-1 输出)。(1)-(2)图像描述生成,(3)-(6)视觉问答,(7)-(8)OCR,(9)-(11)基于视觉的对话。

这些示例表明,多模态感知的原生支持为将 LLM 应用于新任务提供了新的机遇。此外与 LLM 相比,MLLM 实现了更好的常识推理性能,表明了跨模态迁移有助于知识获取。由于 KOSMOS-1 模型的参数量为16亿,因此有网友表示有望在自己的电脑上运行这个多模态大模型。

如图3所示,KOSMOS-1 是一个多模态语言模型,它既可以感知一般的模态、遵循指令、还能在上下文中学习并生成输出。具体来说,KOSMOS-1 的主干是一个基于 Transformer 的因果语言模型。除了文本之外,其他模态也能被嵌入并输入到该模型中,如下图中,除了语言还有视觉、语音等的嵌入。Transformer 解码器用作多模态输入的通用接口。一旦模型训练完成,KOSMOS-1 在零样本和少样本中也能对语言任务和多模态任务进行评估。图3:KOSMOS-1 是一个多模态大规模语言模型,KOSMOS-1 能够感知多模态输入、遵循自然语言指令、在语言任务和多模态任务中完成上下文学习。本工作将视觉信息与大规模语言模型对齐,推进从大规模语言模型到多模态大规模语言模型。Transformer 解码器以统一的方式感知模态,输入信息会被 flatten 为带有特殊 token 的序列。例如 <s> 表示序列开始、</s> 表示序列结束。特殊 token <image> 和 </image> 表示编码图像嵌入的开始和结束。表2:KOSMOS-1 训练阶段使用的数据格式

嵌入模块将文本 token 和其他输入模态编码成向量表示,对于输入 token,该研究使用查找表将其映射到嵌入中。对于连续信号模态(例如图像和音频),也可以将输入表示为离散编码。之后,获得的输入序列嵌入会被馈送到基于 Transformer 的解码器。然后因果模型以一种自回归的方式处理序列,从而产生下一个 token。总而言之,MLLM 框架可以灵活地处理各种数据类型,只要将输入表示为向量即可。首先是训练数据集。数据集包括文本语料库、图像 - 字幕对、图像和文本交叉数据集。具体而言,文本语料库包括 The Pile 、Common Crawl (CC);图像 - 字幕对包括 English LAION-2B、LAION-400M、COYO-700M 以及 Conceptual Captions;图像和文本交叉多模态数据集来自 Common Crawl snapshot。数据集有了,然后是训练设置。MLLM 组件包含24层、隐藏维度是2048、8192个 FFN 和32个注意力头、参数量为 1.3B。为了使模型更好的收敛,图像表示是从具有1024个特征维度的预训练 CLIP ViT-L/14 模型获得的。图像在训练过程中被预处理为224×224分辨率,此外,训练期间除了最后一层,所有的 CLIP 模型参数被冻结。KOSMOS-1 的参数总数约为 1.6B。表3:KOSMOS-1 训练阶段使用的模型参数

该研究进行了一系列丰富的实验来评价 KOSMOS-1 :语言任务(语言理解、语言生成、 OCR-free 文本分类);跨模态迁移(常识推理);非语言推理( IQ 测试);感知 - 语言任务(图像描述生成、视觉问答、网页问答);视觉任务(零样本图像分类、带有描述的零样本图像分类)。图像描述生成。下表给出了不同模型在 COCO 和 Flickr30k 上的零样本性能。相比其他模型,KOSMOS-1 均取得了显著效果,甚至在参数量远小于 Flamingo 的基础上,性能也不错。表4:KOSMOS-1 在图像描述生成任务(COCO和Flickr30k)中的零样本测试结果

表5:KOSMOS-1 在图像描述生成任务(COCO和Flickr30k)中的少样本测试结果

视觉问答。KOSMOS-1 比 Flamingo-3B 和 Flamingo-9B 模型具有更高的准确率和鲁棒性:表6:KOSMOS-1 在视觉问答任务(VQAv2和VizWiz)中的零样本测试结果表7:KOSMOS-1 在视觉问答任务(VQAv2和VizWiz)中的少样本测试结果

IQ 测试。瑞文推理测验是评估非语言推理最常见的测试之一。图4显示了一个示例。 图4:上图为 Raven IQ 测试的一个例子,下图为 KOSMOS-1 如何完成 IQ 测试。提示包括 IQ 测试输入图像和自然语言指令。我们将每个候选图像分别附加到输入提示上,并询问模型是否正确。选择预测Yes概率最高的候选图像作为最终答案。

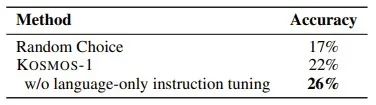

表8显示了在 IQ 测试数据集上的评估结果。KOSMOS-1 能够在非语言环境中感知抽象概念模式,然后在多个选择中推理出之后的元素。据了解,这是首次有模型可以执行此类零样本 Raven IQ 测试。

表8:KOSMOS-1 在 Raven IQ 测试中的零样本测试结果网页问答。网页问答旨在从网页中找到问题的答案。它要求模型既能理解文本的语义,又能理解文本的结构。结果如下:表9:KOSMOS-1 在基于网页问答的零样本测试结果多模态思维链提示。受思维链提示的启发,本文对这方面进行了实验。如图5本文将感知语言任务分解为两个步骤。在第一阶段给定图像,使用提示来引导模型生成合理的理由或者所需要的图像描述,以产生最终结果。图5:多模态思维链使 KOSMOS-1 首先生成合理的理由或者所需要的图像描述,然后将其用于解决复杂的问答和推理任务。

从表10可以看出,多模态思维链提示的得分为72.9分,比标准提示高出5.8分:表10:KOSMOS-1 利用多模态思维链提升 Rendered SST-2 的零样本结果

在进行计算机科研工作和学习的日日夜夜,你或许有些科研中的问题难以开口问询,或许有些焦虑与情绪无处安放,或许在感到迷茫时需要咨询与支持。微软亚洲研究院树洞计划现已开启。你在计算机领域科研、学习、生活中遇到的难题,都可以随时随地倾倒在树洞里。后台会从树洞收到的内容中选择具有代表性的问题匹配到最同频的频道,邀请微软亚洲研究院的研究员们帮忙回答。作为一个半透明的树洞,部分问题与回应会通过微软亚洲研究院账号公开发表。

快来点击上图链接,把你的难题倾倒在树洞里吧!让我们将这些困难封存在过去,轻装上阵,继续科研新旅途!

你也许还想看: