【新智元导读】从声音到个性,ta跟鸟鸟真是傻傻分不清楚。

说来你可能不信,我们这两天都和脱口秀演员「鸟鸟」在一起。咱们来问问ta,去年笑果文化最出圈的梗之一:「你知道虾系男友吗?」ta立即秒答:「听说最近网上流行的虾系男友梗,指的是身材好但脸蛋不太好看的男生,就像虾一样只需要去掉头就可以食用了,这个词语最近因为脱口秀演员李诞在节目中自曝网友的整活而爆火。」

没听出来?那就让我们问一个可以准确「定位」鸟鸟的问题:你是个内向的人吗?过一会儿,鸟鸟特有的语调慢悠悠地响起:「是的,我是一个内向、社交恐惧的女孩,我常常感到无存在感,甚至在台上也不敢表现自己,但是,我并不因此而自卑,反而希望通过我的表演来帮助更多像我一样的人,让他们知道:在我们内心深处,也有着与众不同的存在和价值。」正好,前段时间鸟鸟去了米兰,我们不如就让ta来分享一下体验吧。「我最近去了意大利米兰参加时装周,参加了一个非常有趣的活动。虽然紧张,脚疼,但是收获了很多。我还去看了米兰大教堂,非常震撼。我认为,意大利和我的家乡内蒙古很像,很亲切。」听起来很有趣的样子,那能不能以此为题材写一篇作文呢?ta游刃有余、信手拈来:「当我走在米兰的街道上,我仿佛置身于一个文艺复兴时代的世界,那里有着许多古老而又现代的建筑,它们象征着米兰历史悠久的文化与艺术。我看到许多画家在这里创作,他们用自己的笔触描绘出米兰的美景,让人感受到一种无法言说的沉醉。」如果要求给这篇作文起个标题,ta稍加思索,便脱口而出——《如何让米兰之旅,成为你一生最美好的回忆》。真是文采斐然啊!去年,鸟鸟得了上一届脱口秀大会的亚军,以无比精妙的文本折服了观众。那让我们问问ta:「如何判断一个脱口秀演员水平的高低呢?」ta回答说:「首先看演员的幽默感是否强,能够制造出笑点和趣味,其次看演员是否能够掌握好节奏和节目的整体氛围,让观众能够跟随演员的思路走,最后看演员是否能够掌握好自己的情绪和表达,能够准确地传达自己的观点和情感。」我们给ta读了一个笑话:「虾和蚌同时考了一百分,老师问虾你抄的谁的,虾说:『我抄蚌的。』老师说:『你棒什么棒。』」

有时候,我们的脑子里可能会突然蹦出一些千奇百怪的问题。比如,地球与太阳的距离是多远?话音刚落,答案就来了:「最近距离是1.471乘以10的11次方米,最远距离是1.521乘以10的11次方米,平均距离是1.496乘以10的8次方千米。」ta会说:「雌雄异体是为了避免基因缺陷遗传,因为雌雄异体在进化中更有优势,好的变异会取得生存或繁殖的优势,不好的变异淘汰。」有意思的是,这个答案和知乎上的某个回答很像,看来ta是会自己搜索的。

还有一个经常让小编百思不得其解的问题:物理方程式为什么往往很简短?ta告诉我们:「这是因为,物理方程式往往捕捉到了自然界中最基本、最根本的物理规律和定律,并用最简单、最清晰的方式进行描述。」疯狂的三月刚过,小编已经累到快要被卷趴,只想躺平。ta回答说:「躺和卷不是一个选择题,而是讨论劳与逸。(要)在正确的赛道合理地卷,心态积极地卷,有价值地卷。」此外,如果你跟ta卖萌,说自己最近「难过得像个200斤的橘猫」时,ta还会安慰道:「哎呀,听起来你真的很不开心啊,看来你需要一些时间来调整你的情绪了,不知道你为什么难过,是遇到了什么困难吗?我可以和你分享一些我自己的经历和想法,或者推荐一些好玩的综艺节目。」甚至有一次小编们在办公室讨论,「内向是鸟鸟脱口秀中经常用到的梗」,ta居然主动接话了——「是的,我的确经常在脱口秀中用到这个段子。脱口秀中最能体现一个人的个性和特点,除了自己的故事和经历,还需要有自己的观点和态度,才能引起观众的共鸣和笑声……」不仅如此,当ta精彩作答后,如果你夸ta厉害,ta还会自豪地说:「嗯呐,谢谢你的夸奖,我就是喜欢回答一些奇奇怪怪的问题。」

训练过程

第一步,就是先用大规模语言的预训练,做一个基础的学习,这是一个层次化的训练方式。这一步,也是在模拟人类的学习过程,先学简单的知识,再学复杂的,逐渐增加难度。这一过程中,使用了大规模语料,模型能够阅读文本、讲话通顺,同时,也学到了一些通识性的知识。不过第一步之后,研究人员也发现了一些问题:现在每天都有大量新增的知识在产生,今天学的东西,也许明天就会过时。怎么办呢?所以,与其让大模型把所有知识记下来,不如学会使用工具,自己动手丰衣足食。现在,鸟鸟分鸟已经学会了调用搜索引擎,即使在模型训练完成之后发送的新事,它也能对答自如啦。3. 个性化的对话增强:多轮、启发式

在有了知识增强和工具增强的基础上,第三步,就是做个性化的对话增强。在这个过程中,它需要去学习什么是多轮对话,什么是启发式的对话。难点在于,多轮对话经常需要很久以前的历史信息。另一方面,就是给它塑造人格的标签词。同时,研究人员还少量标注了鸟鸟的一些语料,作为个性化的增强和调优。怎么让它更像鸟鸟呢?就是通过人类反馈强化学习(RLHF)。对于同一个问题,让模型给出多个不同回答,工作人员会去做反馈和标注,然后让模型进一步纠偏。多轮迭代后,模型的回答越来越能代表鸟鸟的一些文本特征,甚至是她的特定立场。变成产品

等到把模型训出来之后,想变成完全体的「天猫精灵」,还需要搞定几个方面的算法+工程的工作:模型要顺利变身产品,还得听清并听懂用户说的话——语音转文本。猫耳的特点就是,能够分辨的误差非常灵敏,并且不同地方发出声音时,耳朵还会独立旋转,准确定位出不同的声援。

设备在房间里播放时,会产生很多回声,这些回声会产生干扰。研究人员会通过深度学习,结合一系列技术,做回声的消除,确保机器听到的每一句话,都是来自人的话。机器上有麦克风阵列,当我们唤醒时,它会识别到主讲人的位置在哪里,像猫耳一样立即转向,精准地捕捉人声。同时,还用降噪的方式消除非人声的声音,比如家里的电视机声音,或是远处的人说话。天猫精灵学会「听见」之后,接下来就是让它的音色更像鸟鸟。过去要定制一个人的声音,过程非常复杂,可能需要去录音棚里录20小时以上的录音,做大量的人工标注,再去做模型的调优和部署。可以说,曾经的定制声音,是以年为周期的。而且,这么费了这么大的人力和物力,出来的声音依然机械感明显,很明显是机器人。而现在,利用达摩院KANN-TTS的定制化方案,只收集了一小时左右的有效鸟鸟录音,而且可以随时随地用手机去录。录完声音到训练完成,才花了一周左右。并且,最后出来的声音自然度和拟人度都让人惊喜,非常接近鸟鸟本人的音色。并且接下来,还会有一个情绪音色算法,如果鸟鸟愿意,机器会发出激情澎湃的嗓音。心理学上有一个理论,叫做标签效应。比如,当一个人被大家贴上内向标签的时候,他可能就会逐渐变得话少,让自己的行为和标签一致。在大模型中,也可以用类似的做法,使用性格标签词汇,来描述一个人。当设置模型角色是开朗、幽默的人物时,不仅在对话的时候就经常会笑,而且如果问喜欢什么电影,还会回答是喜剧片。而贴上抑郁、丧的标签后,模型对很多事情都丧失了兴趣。当模型的标签是温柔体贴、善解人意时,它在对话中就会更多提到家人,比如回答周末想干什么,它会说我想陪伴家人。第一叫做Plug&Play。这种情况下,大模型本身还是通识的大模型,但会通过一个外挂的模块去判别风格,让它说话更像鸟鸟。第二种,就是基于大模型做prompt的方式,让它学习不同人格标签的风格。而在训练鸟鸟分鸟时, 就用了脱口秀演员、90后、内蒙人、有深度、幽默、内向等标签。而这个演示版天猫精灵,和过去的版本有些不一样,这就涉及到了双工对话的差异。以前,人和机器的声音是不能重叠的,人问一个问题时,机器会等待人讲完,才会回复。机器回复时,人也必须等它讲完,才能说下一句。而在全双工的加持下,机器就可以和人做双向的互动了。比如你跟机器说话时,它会说「嗯」,「让我想一想」之类的承接语句。另外,如果机器回答的过程中太过话痨,你可以随意打断,只要我们一说话,它就会停下来倾听。因为时延非常低,很接近真人对话的时延,是一种更双向的交互。

自从ChatGPT出来之后,各路网友纷纷使出洪荒之力,想把ChatGPT整进Siri里。比如,这位小哥就利用该模型解析人类发送的命令,然后由Siri代为执行,构建出一个无敌的智能家居系统。「我老婆正在开车回家,预计15分钟到家。」 「好,到时外面的灯会为她打开。」毕竟相比于ChatGPT,苹果的Siri、亚马逊的Alexa等传统语音助手,确实是弱爆了。对此,微软CEO纳德拉有个非常形象生动的比喻——「笨得像石头一样」。和为了追赶ChatGPT几乎不顾一切的谷歌不同,亚马逊并不觉得自己落后了。十多年前,贝佐斯在亚马逊总部的白板上兴奋地勾勒出他对Alexa的期待。彼时,亚马逊创始人还对语音控制新计算平台有着宏伟的愿景——构建一个星际迷航计算机,可以对话、控制飞船、解决数学难题。但现在,愿景显然已落空。尽管已经卖出了数亿台内置助手的数字设备,Alexa仍未达到亚马逊创建下一个科技大平台的目标。贝佐斯曾不惜一切代价发展Alexa,甚至宁愿亏损。而去年11月问世的宠儿ChatGPT,更显得Alexa的创新停滞不前。不过,亚马逊在用一种很新的方式迎接新时代。Alexa的语言能力比不上聊天机器人,聊天机器人无法控制智能家居设备,那么,如果二者做一个结合呢?打不过就加入,最近几个月,亚马逊已经在与AI初创公司接洽,准备将类似ChatGPT的技术整合进Alexa。那么,如果我们直接在「原生」的IoT设备中,加入类ChatGPT大模型,岂不是更强?这么看的话,天猫精灵如果能大规模OTA新的交互系统,的确就很超前了。

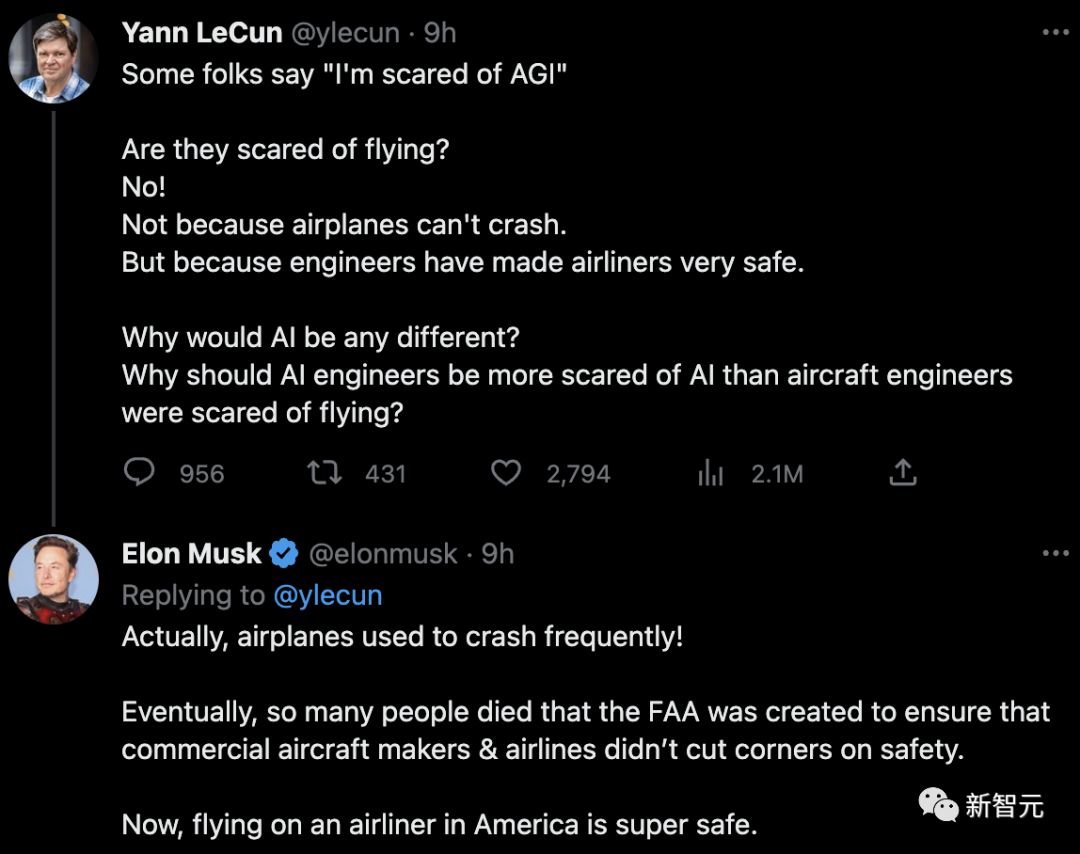

而争论的焦点就是AI的安全性问题——公开信认为,现在没有任何人可以理解、预测、控制这些AI,连它们的创造者都不能。

马斯克和LeCun直面互怼,可不常见啊(战术后仰)1. AI的技术特点使它具备了自己的价值观,虽然和人类的不一样,但早已脱离了技术中性的范畴;

2. AI的另一个技术特点使它成为了社会的界面,而任何缺乏监管的界面基础设施都将导致不公平。

问题来了,如果说AI是一个黑箱,那么我们又该如何判定它是否向善呢?对此,来自清华大学交叉信息学院的研究者于洋表示,答案就在AI的审计和治理之中。目前,他的团队也在与天猫精灵团队共同合作AI-ESG领域的研究。目前来说,相关领域进行的研究都是围绕人来展开的,其目的就是保证人在信息时代,特别是人工智能时代能获得平等和公正的对待。为了实现这一点,于洋教授的团队提出了一种基于因果推断的AI全生命周期治理审计方式。具体来说,团队经过因果推断的分析方法发现,AI模型实际上在编码层,就已经将性别、种族这些标签和职业进行了关联。一些文献认为,如果编码层不这样做,AI模型的性能就会下降。会出现这种现象的原因在于,目前纠正偏见的方法是,在训练时的奖励函数上加一些要求,但凡模型出现偏见就「扇它一耳光」。与之相对的,如果我们一开始就告诉它不能把人标签化,那么最终得到的模型,不仅大幅降低了偏见出现的风险,而且在部分任务的性能还有所上升。归根结底,就是如何教育AI的问题——光靠打骂是不行的,还得跟AI讲道理。由此我们不难看出,审计不仅可以帮助发现问题,同时也能够增强AI的透明性、可解释性,并改善AI的表现。那么对于搭载了大模型的智能终端来说,技术审计的重要性也就不言而喻了。毕竟从这个技术演示看,有一天如果我们像鸟鸟那样,拥有自己的一个独特的大模型,也不一定是幻想了。https://www.theinformation.com/articles/amazon-faces-moment-of-truth-on-alexa-as-chatgpt-steals-its-thunder?rc=epv9gi