【新智元导读】计算机视觉迎来大突破!新加坡国立大学学者开发Anything-3D,单图超快3D重建!

2D图像的3D重建一直是CV领域的重头戏。

层出不同的模型被开发出来试图攻克这个难题。

今天,新加坡国立大学的学者共同发表了一篇论文,开发了一个全新的框架Anything-3D来解决这个老大难问题。

论文地址:https://arxiv.org/pdf/2304.10261.pdf

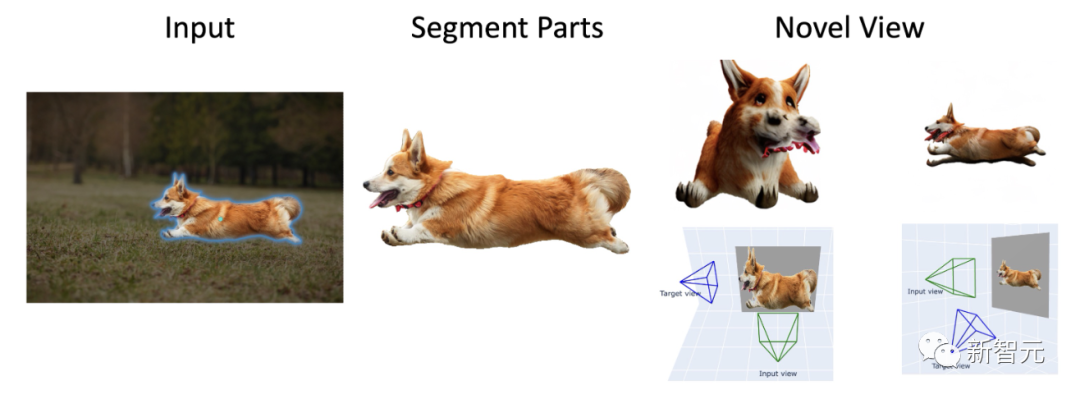

借助Meta「分割一切」模型,Anything-3D直接让分割后的任意物体活起来了。

另外,再用上Zero-1-to-3模型,你就可以得到不同角度的柯基。

甚至,还可以进行人物3D重建。

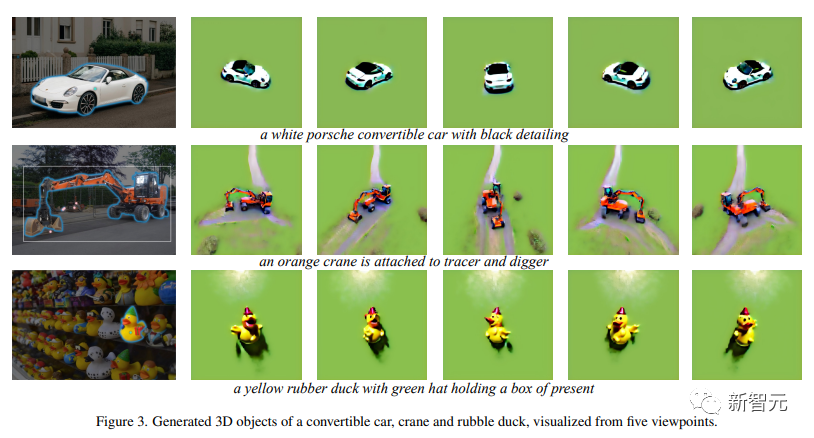

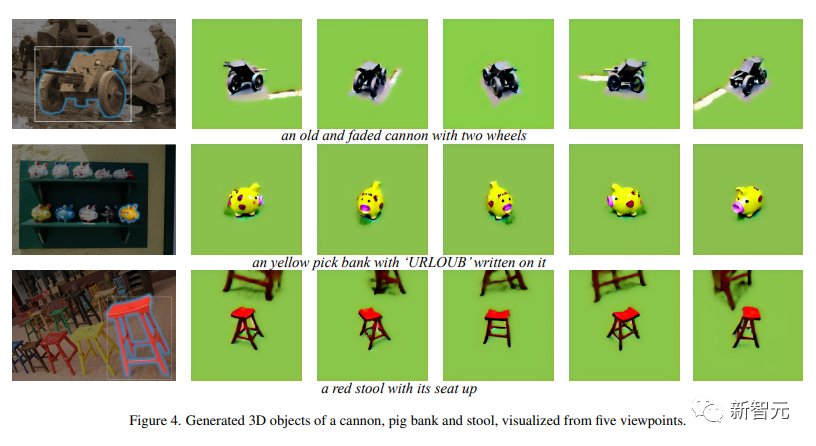

在现实世界中,各种物体和各类环境既多样又复杂。所以,在不受限制的情况下,从单一RGB图像中进行三维重建面临诸多困难。在此,新加坡国立大学研究人员结合了一系列视觉语言模型和SAM(Segment-Anything)物体分割模型,生成了一个功能多、可靠性强的系统——Anything-3D。他们采用BLIP模型生成纹理描述,用SAM模型提取图像中的物体,然后利用文本→图像的扩散模型Stable Diffusion将物体放置到Nerf(神经辐射场)中。在后续的实验中,Anything-3D展示出了其强大的三维重建的能力。不仅准确,适用面也非常广泛。Anything-3D在解决现有方法的局限这方面,效果明显。研究人员通过对各类数据集的测验和评估,展示了这种新框架的优点。上图中,我们可以看到,「柯基吐舌头千里奔袭图」、「银翅女神像委身豪车图」,以及「田野棕牛头戴蓝绳图」。这是一个初步展示,Anything-3D框架能够熟练地把在任意的环境中拍摄的单视角图像中恢复成的3D的形态,并生成纹理。尽管相机视角和物体属性有很大的变化,但这种新框架始终能提供准确性较高的结果。要知道,从2D图像中重建3D物体是计算机视觉领域课题的核心,对机器人、自动驾驶、增强现实、虚拟现实,以及三维打印等领域都有巨大影响。虽说这几年来取得了一些不错的进展,但在非结构化环境中进行单图像物体重建的任务仍然是一个具有很大吸引力且亟待解决的问题。目前,研究人员的任务就是从一张单一的二维图像中生成一个或多个物体的三维表示,表示方法包括点云、网格或体积表示。由于二维投影所产生的内在模糊性,不可能明确地确定一个物体的三维结构。再加上形状、大小、纹理和外观的巨大差异,重建自然环境下的物体非常复杂。此外,现实世界图像中的物体经常会被遮挡,这就会阻碍被遮挡部分的精准重建。同时,光照和阴影等变量也会极大地影响物体的外观,而角度和距离的不同也会导致二维投影的明显变化。论文中,研究人员详细介绍了这个开创性的系统框架,将视觉语言模型和物体分割模型融合在一起,轻轻松松就能把2D物体搞成3D的。这样,一个功能强大、自适应能力强的系统就成了。单视图重建?Easy.研究人员表示,将这两种模型结合,就可以检索并确定出给定图像的三维纹理和几何形状。Anything-3D利用BLIP模型(Bootstrapping语言-图像模型)预训练对图像的文本描述,然后再用SAM模型识别物体的分布区域。接下来,利用分割出来的物体和文本描述来执行3D重建任务。换句话说,该论文利用预先训练好的2D文本→图像扩散模型来进行图像的3D合成。此外,研究人员用分数蒸馏来训练一个专门用于图像的Nerf.上图就是生成3D图像的全过程。左上角是2D原图,先经过SAM,分割出柯基,再经过BLIP,生成文本描述,然后再用分数蒸馏搞个Nerf出来。通过对不同数据集的严格实验,研究人员展示了这种方法的有效性和自适应性,同时,在准确性、稳健性和概括能力方面都超过了现有的方法。研究人员还对自然环境中3D物体重建中已有的挑战进行了全面深入地分析,探讨了新框架如何解决此类问题。最终,通过将基础模型中的零距离视觉和语言理解能力相融合,新框架更能从真实世界的各类图像中重建物体,生成精确、复杂、适用面广的3D表示。可以说,Anything-3D是3D物体重建领域的一个重大突破。

炫酷黑内饰小白保时捷,亮丽橙色挖机吊车,绿帽小黄橡皮鸭

时代眼泪褪色大炮、小猪猪可爱迷你存钱罐、朱砂红四腿高脚凳这个新框架可以交互式地识别单视角图像中的区域,并用优化的文本嵌入来表示2D物体。最终,使用一个3D感知的分数蒸馏模型有效地生成高质量的3D物体。总之,Anything-3D展示了从单视角图像中重建自然3D物体的潜力。研究者称,新框架3D重建的质量还可以更完美,研究人员正在不断努力提高生成的质量。此外,研究人员表示,目前没有提供3D数据集的定量评估,如新的视图合成和误差重建,但在未来的工作迭代中会纳入这些内容。同时,研究人员的最终目标是扩大这个框架,以适应更多的实际情况,包括稀疏视图下的对象恢复。

Wang目前是新加坡国立大学(NUS)ECE系的终身制助理教授。在加入新加坡国立大学之前,他曾是Stevens理工学院CS系的一名助理教授。在加入Stevens之前,我曾在伊利诺伊大学厄巴纳-香槟分校Beckman研究所的Thomas Huang教授的图像形成小组担任博士后。Wang在洛桑联邦理工学院(EPFL)计算机视觉实验室获得博士学位,由Pascal Fua教授指导,并在2010年获得香港理工大学计算机系的一等荣誉学士学位。https://arxiv.org/pdf/2304.10261.pdf