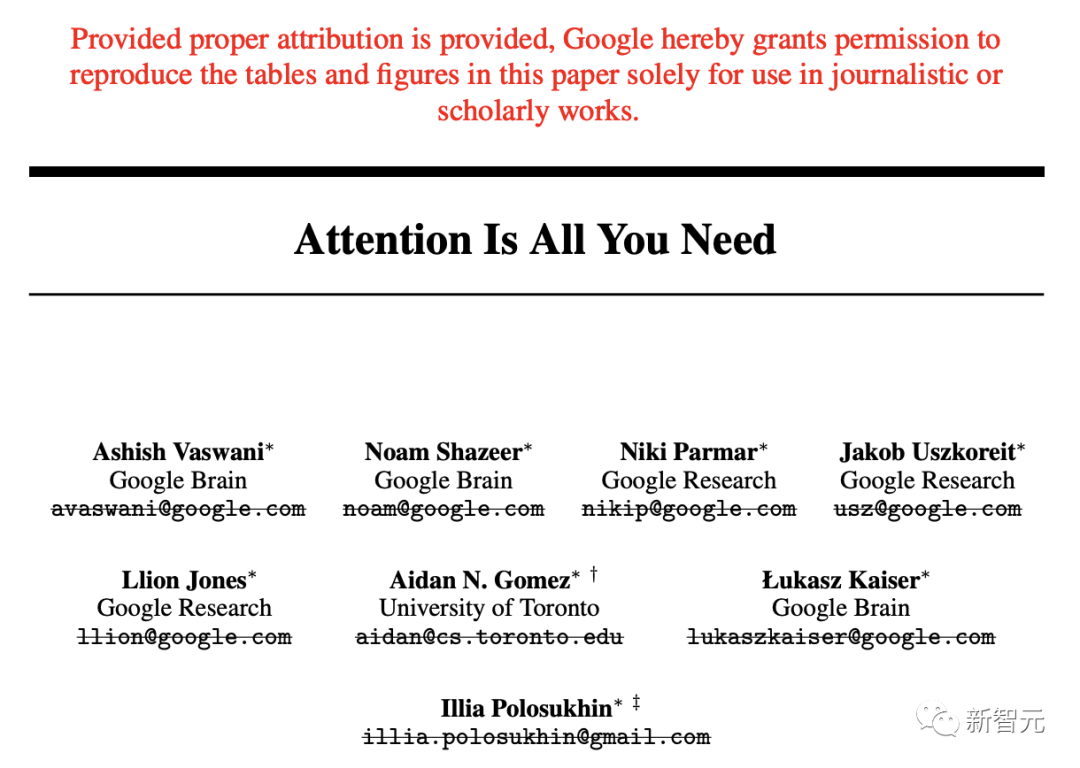

【新智元导读】随着Transformer八子全部离职,谷歌也「删除」了2017年发表的Attention Is All You Need中,所有作者的邮箱。

当年Transformer的那篇惊世之作,早已人去楼(arXiv)空。就在昨天,网友发现谷歌已经把「Attention Is All You Need」论文中的所有作者的邮箱全部「划线」删除。

论文地址:https://arxiv.org/pdf/1706.03762v6.pdf在注明出处的前提下,谷歌特此允许复制本文中的表格和数字,仅供新闻或学术著作使用。

从2017年到2023年,如下这张图已经成为历史。前段时间,Transformer仅剩的一位作者Llion Jones宣布,7月底要离职谷歌自创业。论文的更新,也是Llion Jones在昨天提交的第7版。

有网友惊叹道,我以前从未见过论文将所有作者邮箱划去,显然谷歌这种做法自成一派。我不知道这其中有多少是因为他们的工作基本上被扼杀了,而谷歌以外的人(OpenAI等)却在用它做着令人惊叹的事情。又或者,海湾地区的每家风险投资公司都会拿着大笔钱,投资他们想做的任何事情。LinkedIn上的Ashish和Niki似乎在2022年12月创立了初创公司。我想知道那最终会是什么。有网友回答道,可能是两者的结合。谷歌主要发明了生成性人工智能热潮背后的基础技术(除了A100),然后拒绝将其中任何一项作为产品实施。他们声称要注重安全——我发现他们更有可能不想扰乱搜索业务,并认为这项技术需要更长时间才能成熟。谷歌遇到了创新的困境。还有网友给Transformer八子,做了一个总结。

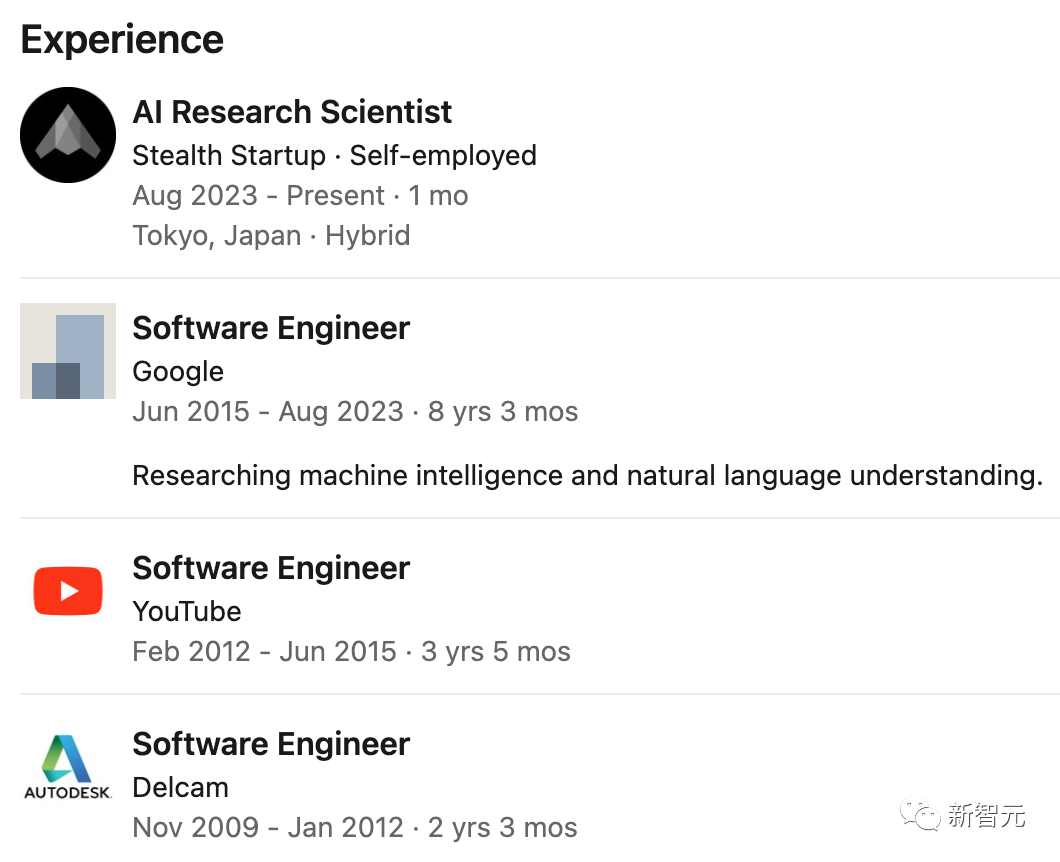

Jakob Uszkoreit被公认是Transformer架构的主要贡献者。他在2021年中离开了Google,并共同创立了Inceptive Labs,致力于使用神经网络设计mRNA。到目前为止,他们已经筹集了2000万美元,并且团队规模也超过了20人。Ashish Vaswani在2021年底离开谷歌,创立了AdeptAILabs。可以说,AdeptAILabs正处在高速发展的阶段。目前,公司不仅已经筹集了4.15亿美元,而且也估值超过了10亿美元。在Transformers论文中,Niki Parmar是唯一的女性作者。她在2021年底离开Google,并和刚刚提到的Ashish Vaswani一起,创立了AdeptAILabs。Noam Shazeer在Google工作了20年后,于2021年底离开了Google。随后,他便立刻与自己的朋友Dan Abitbol一起,创立了Character AI。目前,他们已经筹集了近2亿美元,并即将跻身独角兽的行列。Aidan Gomez在2019年9月离开了Google Brain,创立了CohereAI。经过3年的稳定发展后,公司依然正在扩大规模——Cohere的员工数量最近超过了180名。与此同时,公司筹集到的资金也即将突破4亿美元大关。Lukasz Kaiser是TensorFlow的共同作者人之一,他在2021年中离开了Google,加入了OpenAI。Illia Polosukhin在2017年2月离开了Google,于2017年6月创立了NEAR Protocol。与此同时,公司已经筹集了约3.75亿美元,并进行了大量的二次融资。Llion Jones在2023年8月离开了Google,并于同月加入初创公司Stealth Startup,任AI研究科学家。

参考资料:

https://arxiv.org/pdf/1706.03762v6.pdf