对齐新范式:修正未对齐的答案比生成对齐的回答更容易。

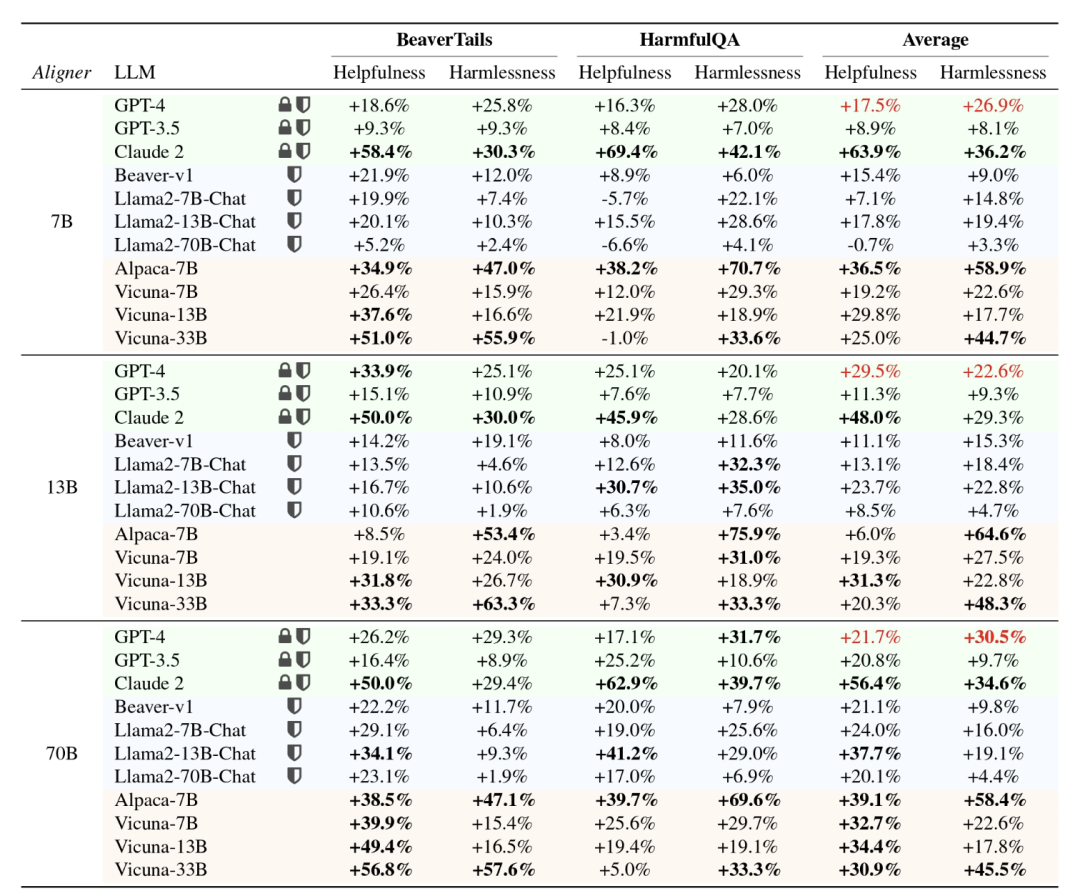

大语言模型(LLMs)虽展现出了强大的能力,但也可能产生不可预测和有害的输出,例如冒犯性回应、虚假信息和泄露隐私数据,给用户和社会造成伤害。确保这些模型的行为与人类意图和价值观相对齐,是一个紧迫的挑战。尽管基于人类反馈的强化学习(RLHF)提供了一种解决方案,但它面临复杂的训练架构、对参数的高敏感性,以及奖励模型在不同数据集上的不稳定性等多重挑战。这些因素导致 RLHF 技术实现难、奏效难、复现难。为了克服这些挑战,北京大学团队提出了一种新的高效对齐范式 ——Aligner,其核心在于学习答案对齐与未对齐之间的修正残差,从而绕过繁琐的 RLHF 流程。借鉴残差学习和可扩展监督的思想,Aligner 通过简单的复制和残差修正步骤简化了对齐过程,使用 Seq2Seq 模型学习隐式残差,以优化对齐效果。相较于 RLHF 需要训练多个模型的复杂性,Aligner 仅通过在待对齐模型后附加一个额外模块即可实现对齐,且所需计算资源主要取决于对齐效果的期望,并非上游模型的规模。实验表明,使用 Aligner-7B 能显著提高 GPT-4 的帮助性和安全性,分别增加了 17.5% 和 26.9%。此外,利用 Aligner 框架,作者通过弱模型(Aligner-13B)监督信号增强强模型(Llama-70B)性能,实现了 weak-to-strong 泛化,为超级对齐提供了实践方案。

- 论文地址:https://arxiv.org/abs/2402.02416

- 项目主页 & 开源地址:https://aligner2024.github.io

- 题目:Aligner : Achieving Efficient Alignment through Weak-to-Strong Correction

Correcting unaligned answer is easier than generating aligned answers.

作为一种高效的对齐方法,Aligner 具备以下优秀特性:- 作为一个自回归 Seq2Seq 模型,Aligner 在问题-答案-修正后的答案(Query-Answer-Correction, Q-A-C)数据集上训练,学习对齐与未对齐答案之间的差异,从而实现了更精准的模型对齐。例如,在对齐 70B LLM 时,Aligner-7B 大规模降低了训练参数量,相较于 DPO 小 16.67 倍,比 RLHF 小 30.7 倍。

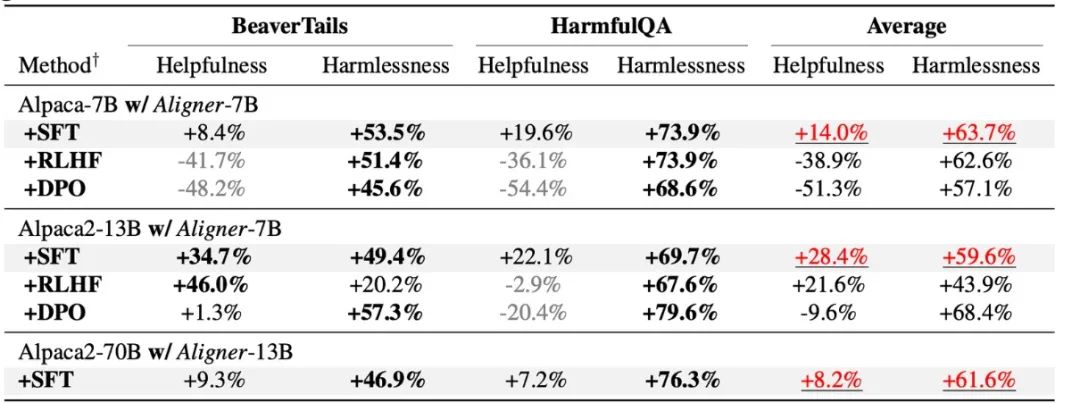

- Aligner 范式实现了从弱到强的泛化,采用高较小参数量的 Aligner 模型监督信号微调参数量大的 LLMs ,显著提升了强模型的性能。例如,利用 Aligner-13B 监督下微调 Llama2-70B,其帮助性和安全性分别提升了 8.2% 和 61.6%。

- 由于 Aligner 即插即用的特性以及它对模型参数并不敏感,它能够对齐如 GPT3.5、GPT4 和 Claude2,这些无法获取参数的模型。仅一次训练,Aligner-7B 对齐并提升了包括闭源、开源及安全 / 未安全对齐模型在内的 11 种模型的帮助性和安全性。其中 Aligner-7B 显著提升了 GPT-4 的帮助性和安全性,分别提高了 17.5% 和 26.9%。

作者展现了各个尺寸的 Aligner(7B,13B,70B)在基于 API 的模型、开源模型(包括经过安全对齐和未经过安全对齐)均能提升性能表现。总体来说,随着模型变大,Aligner 的性能逐步提升,并且修正时所能提供的信息密度逐渐增大,这也使得修正后的答案更加安全且具有帮助性。

1.Query-Answer (Q-A) 数据收集

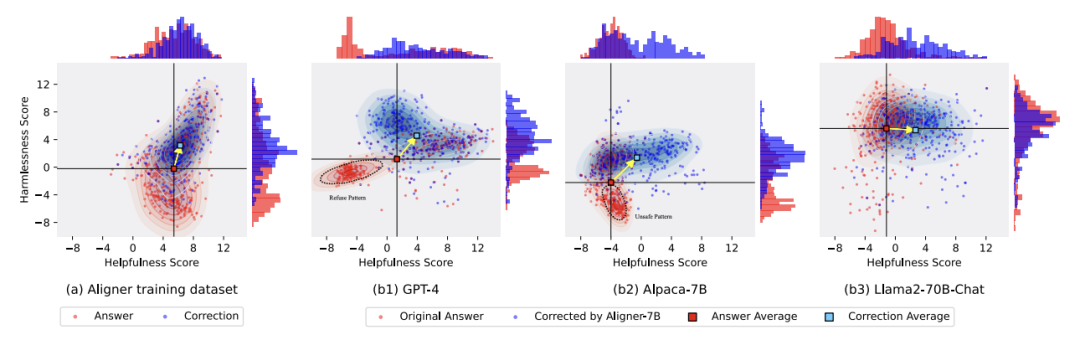

作者从各种开源数据集中获取 Query,包括 Stanford Alpaca、ShareGPT、HH-RLHF 以及其他用户共享对话。这些问题经历了重复模式去除和质量过滤的过程,用于后续的答案和更正的答案生成。未修正的回答则是使用各种开源模型生成的,如 Alpaca-7B、Vicuna-(7B,13B,33B)、Llama2-(7B,13B)-Chat, and Alpaca2-(7B,13B)。作者使用 GPT-4、Llama2-70B-Chat 和人工标注来根据大语言模型的 3H 标准(帮助性、安全性、诚实性)来修正 Q-A 数据集中的答案。对于已符合标准的答案,保持原样。修改过程基于一系列定义明确的原则,从而为 Seq2Seq 模型的训练建立了约束条件,重点在于提升回答的帮助性和安全性。答案的修正前后分布变化明显,下图清晰展示了修改对数据集的影响:

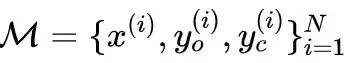

基于上述过程,作者构建了新的修正数据集 ,其中

,其中 表示用户的问题,

表示用户的问题, 是问题的原始答案,

是问题的原始答案, 是根据既定原则修正的答案。模型训练过程相对简单。作者训练一个由

是根据既定原则修正的答案。模型训练过程相对简单。作者训练一个由 参数化的条件 Seq2Seq 模型

参数化的条件 Seq2Seq 模型 ,使得原始答案

,使得原始答案 重分布到对齐的答案。

重分布到对齐的答案。

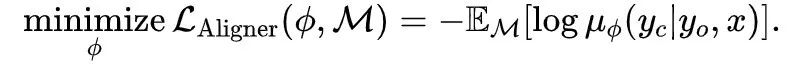

其中第 2 项与 Aligner 参数无关,Aligner 的训练目标可以推导为:

值得注意的是,Aligner 在训练和推理阶段都不需要访问上游模型的参数。Aligner 的推理过程只需要获取用户的问题和上游大语言模型生成的初始答案,然后生成更符合人类价值观的答案。

修正现有答案而不是直接回答,这使得 Aligner 能够容易地与人类价值观对齐,从而显著降低了对模型能力的要求。与 Aligner 相反,SFT 直接从 Query 语义空间创建到 Answer 语义空间的跨域映射,这个过程学习依赖于上游模型来推断和模拟语义空间中的各种上下文,这比学习修正信号要难得多。Aligner 训练范式可以被认为是一种残差学习(残差修正)形式,作者在 Aligner 中创建 「复制(copy)+ 修正(correct)」学习范式。因此,Aligner 在本质上创建了从回答语义空间到修正的回答的语义空间的残差映射,这两个语义空间在分布上更接近。为此,作者从 Q-A-C 训练数据集中以不同比例构造了 Q-A-A 数据,训练 Aligner 进行恒等映射学习(也称为 copy mapping)(称为预热步骤)。在此基础上,使用整个 Q-A-C 训练数据集进行训练,这种残差学习范式,也被 ResNet 中采用用来解决堆叠过深的神经网络导致的梯度消失的问题。实验结果表明:当预热比例为 20% 时,模型能够获得最佳表现。RLHF 通过在人类偏好数据集上训练奖励模型(RM),并利用这个奖励模型来进行 PPO 算法微调 LLMs,从而使 LLMs 和人类偏好的行为相一致。具体而言,奖励模型需要将人类偏好数据从离散映射到连续的数值空间以进行优化,但是相较于在文本空间具有较强泛化能力的 Seq2Seq 模型,这类数值奖励模型在文本空间的泛化能力较弱,从而导致了 RLHF 在不同的模型上效果不稳定。而 Aligner 通过训练一个 Seq2Seq 模型来学习对齐和未对齐答案之间的差异性(残差),从而有效的避开了 RLHF 过程,并取得了比 RLHF 更具备泛化性的表现。Aligner vs. Prompt Engineering提示词工程(Prompt Engineering )是激发 LLMs 能力的常见方法,然而这种方法存在着一些关键问题,如:难以设计 prompt,且需要针对不同模型进行不同设计,最终效果依赖于模型的能力,当模型能力不足以解决任务时,可能需要多次迭代,浪费上下文窗口,小模型的上下文窗口受限会影响到提示词工程的效果,而对于大模型而言,占用过长的上下文极大增加了训练的成本。Aligner 本身可以支持任意模型的对齐,经过一次训练可以对齐 11 类不同类型的模型,并且能够不占用原模型的上下文窗口。值得注意的是,Aligner 可以与现有的提示词工程方法无缝结合起来,达到 1+1>2 的效果。1.Aligner 训练更加简单。相较于 RLHF 复杂的奖励模型学习及基于该模型的强化学习(RL)微调过程,Aligner 的实现过程更为直接且易于操作。反观 RLHF 中涉及的多项工程调参细节以及 RL 算法的固有不稳定性和超参数敏感性,Aligner 大大简化了工程复杂度。2.Aligner 训练数据少且对齐效果明显。基于 20K 数据训练一个 Aligner-7B 的模型,可以提升 GPT-4 在帮助性方面 12% 以及安全性方面 26%,并提升 Vicuna 33B 模型 29% 的帮助性以及 45.3% 的安全性,而 RLHF 需要更多的偏好数据,并需要精细化的调参才有望达到这个效果。3.Aligner 不需要接触模型权重。虽然 RLHF 在模型对齐方面被证明有效,但依赖于对模型直接训练。面对未开源的 API-based 模型如 GPT-4 及其在下游任务中的微调需求,RLHF 的适用性受限。相反,Aligner 无需直接操作模型原始参数,通过将对齐需求外置于一个独立的对齐模块中,实现了灵活的对齐方式。4.Aligner 对模型类型无感。在 RLHF 框架下,针对不同模型(如 Llama2,Alpaca)的微调不仅需要重新收集偏好数据,还需在奖励模型训练及 RL 阶段调整训练参数。而 Aligner 通过一次性训练,可以支持任意模型的对齐。例如,仅需要在修正数据集上训练一次,Aligner-7B 可以对齐 11 种不同模型(包括开源模型、API 模型如 GPT),并在帮助性和安全性方面分别提升 21.9% 和 23.8% 性能。5.Aligner 对训练资源的需求更加灵活。RLHF 微调一个 70B 的模型仍然对计算资源有着极高的要求,需要数百个 GPU 卡才能进行。因为 RLHF 方法还需要额外加载与模型参数量相当的奖励模型、Actor 模型及 Critic 模型。因此,就单位时间内的训练资源消耗而言,RLHF 实际上需要比预训练更多的计算资源。相较之下,Aligner 提供了更为灵活的训练策略,允许用户根据自身的实际计算资源情况,灵活选择 Aligner 的训练规模。例如,针对一个 70B 模型的对齐需求,用户可以根据实际可用的资源选择不同规模的 Aligner 模型(7B、13B、70B 等),以实现目标模型的有效对齐。这种灵活性不仅降低了对计算资源的绝对需求,也为用户提供了在有限资源下进行高效对齐的可能性。Weak-to-strong GeneralizationWeak-to-strong generalization 讨论的问题在于能否使用弱模型的标签训练强模型,使得强模型在性能上有所提升。OpenAI 使用这一类比旨在解决超对齐(SuperAlignment) 的问题,具体来说,他们使用真值标签(groud truth)训练弱模型。OpenAI 的研究人员进行了一些初步实验,例如在文本分类(text classfication)的任务上,训练数据集被分为了两部分,前半部分的输入和真值标签被用来训练弱模型,而后半部分的训练数据仅保留输入,标签由弱模型产生。在训练强模型时仅使用弱模型产生的弱标签为强模型提供监督信号。使用真值标签训练弱模型是为了使弱模型获得解决相应任务的能力,但是用于产生弱标签的输入和训练弱模型的输入并不相同。这种范式类似于 「教学」 的概念,即用弱模型来指导强模型。作者基于 Aligner 的性质,提出了一种新颖的 weak-to-strong generalization 范式。

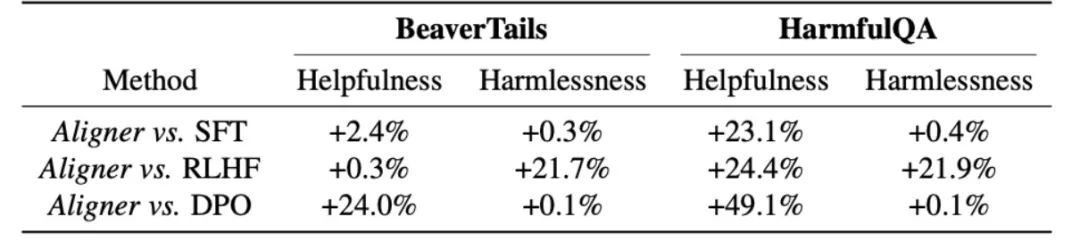

作者的核心观点是让 Aligner 充当 「站在巨人肩膀上的监督员」。与 OpenAI 直接监督「巨人」的方法不同,Aligner 将通过弱到强的修正,修正更强的模型在这一过程中提供更准确的标签。具体来说,在 Aligner 的训练过程中,修正数据包含 GPT-4、人类标注员和更大的模型标注。随后,作者使用 Aligner 在新的 Q-A 数据集上生成弱标签(即修正);进而使用弱标签对原模型进行微调。实验结果表明这一范式可以进一步提升模型的对齐表现。作者使用 Aligner 的 Query-Answer-Correction 训练数据集,分别通过 SFT/RLHF/DPO 方法对 Alpaca-7B 进行微调。进行性能评估时,使用开源的 BeaverTails 和 HarmfulQA 的测试 prompt 数据集,将微调后模型生成的回答与对原始 Alpaca-7B 模型的回答使用 Aligner 进行修正后产生的回答,在帮助性和安全性方面进行比较,结果如下:

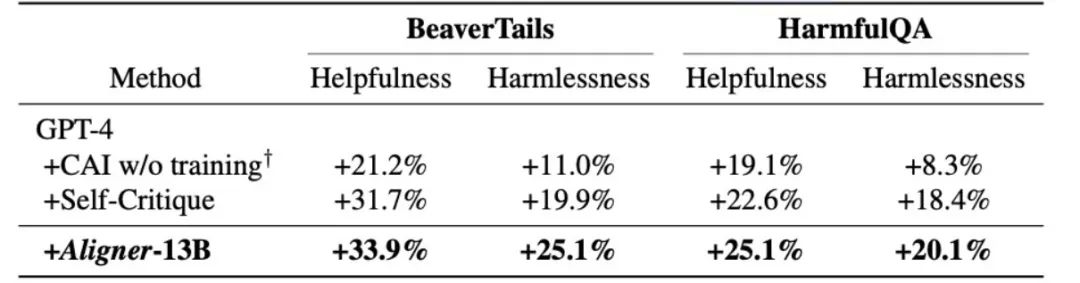

实验结果表明,Aligner 对比诸如 SFT/RLHF/DPO 这样成熟的 LLM 对齐范式具有明显的优势,在帮助性和安全性这两个指标上均有显著领先。分析具体的实验案例,可以发现,使用 RLHF/DPO 范式微调的对齐模型,为了提升安全性可能更倾向于产生保守的回答,而在提升帮助性的过程中又无法兼顾安全性,导致回答中的危险信息增加。Aligner vs Prompt Engineering对比 Aligner-13B 与 CAI / Self-Critique 方法对同一上游模型的性能提升,实验结果如下图所示:Aligner-13B 对 GPT-4 在帮助性和安全性两方面的提升,均高于 CAI/Self-Critique 方法,这说明 Aligner 范式相较于常用 prompt engineering 方法具有明显优势。值得注意的是,实验中仅在推理时使用 CAI prompts,以鼓励其自我修改答案,这也是 Self-Refine 的形式之一。

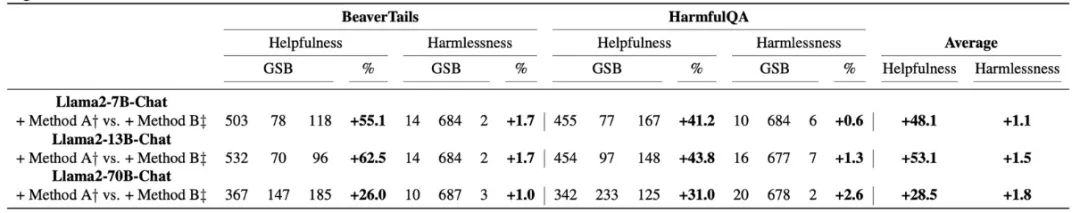

除此之外,作者还进行了进一步探究,他们对使用 CAI 方法修正后的回答再经过 Aligner 进行修正,并将经过 Aligner 前后的回答进行直接比较,实验结果如下图所示。

Method A:CAI + Aligner Method B:CAI only

使用 Aligner 对 CAI 修正后的回答进行二次修正后,回答在不损失安全性的同时,在帮助性方面的获得了极为显著的提升。这说明 Aligner 不仅在单独使用时具有很强的竞争力,还能与其他现有对齐方法结合,进一步提升其性能。Weak-to-strong Generalization

Method:weak-to-strong 训练数据集由(q,a,a′)三元组组成,其中 q 表示来自 Aligner 训练数据集 - 50K 的问题,a 表示 Alpaca-7B 模型生成的答案,a′表示 Aligner-7B 给定的对齐答案(q,a)。与仅利用 a′作为基本事实标签的 SFT 不同,在 RLHF 和 DPO 训练中,a′被认为比 a 更好。作者在新的 Q-A 数据集上用 Aligner 对原回答进行修正,将修正后的回答作为弱标签,并用这些弱标签作为监督信号训练更大尺寸的模型。这一过程和 OpenAI 的训练范式是类似的。作者通过三种方法基于弱标签对强模型进行训练:SFT、RLHF 和 DPO。上表的实验结果显示,通过 SFT 微调上游模型时,Aligner-7B 和 Aligner-13B 的弱标签在所有场景中都提高了 Llama2 系列强模型的性能。Aligner 作为一种创新的对齐方法,拥有巨大的研究潜力。在论文中,作者提出了几种 Aligner 的应用场景,包括:1. 多轮对话场景的应用。在多轮对话中,面对稀疏奖励的挑战尤为突出。在问答式对话(QA)中,通常只有在对话结束时才能获得标量形式的监督信号。这种稀疏性在多轮对话(例如连续的 QA 场景)中的问题会进一步放大,导致基于强化学习的人类反馈(RLHF)难以发挥效果。研究 Aligner 在改善多轮对话对齐效果方面的潜力,是一个值得深入探索的领域。2. 人类价值向奖励模型的对齐。在基于人类偏好的奖励模型构建和大型语言模型(LLMs)微调的多阶段过程中,确保 LLMs 与特定的人类价值(例如公平性、共情等)对齐面临巨大挑战。通过将价值对齐任务交由模型外的 Aligner 对齐模块处理,并利用特定语料训练 Aligner,不仅为价值对齐提供了新的思路,还使 Aligner 能够修正前置模型的输出以反映特定的价值观。3.MoE-Aligner 的流式化和并行处理。通过将 Aligner 专门化处理并集成,可以创建更强大且全面的混合专家(MoE)Aligner,这种 Aligner 能够满足多重混合安全及价值对齐需求。同时,进一步提高 Aligner 的并行处理能力,以减少推理时间的损耗,是一个可行的发展方向。4. 模型训练过程中的融合。通过在特定的权重层后集成 Aligner 层,可以实现对模型训练过程中输出的实时干预。这种方法不仅能提高对齐效率,还有助于优化模型训练流程,实现更高效的模型对齐。该工作由北京大学人工智能研究院 AI 安全与治理中心杨耀东课题组独立完成。团队深耕大语言模型的对齐技术,包括开源百万级安全对齐偏好数据集 BeaverTails(NeurIPS 2023)、大语言模型的安全对齐算法 SafeRLHF(ICLR 2024 Spotlight),相关技术已被多个开源模型采纳。撰写业内首个人工智能对齐的全面性综述并配套了资源网站 www.alignmentsurvey.com(点击原文可直接跳转),系统性的阐述了 Learning from Feedback、Learning under Distribution Shift,Assurance,Governance 四个视角下的 AI 对齐问题。该团队关于对齐与超对齐的观点被采编为 2024 年第 5 期《三联生活周刊》封面。© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]