2023年,几乎 AI 的每个领域都在以前所未有的速度进化,同时,AI也在不断地推动着具身智能、自动驾驶等关键赛道的技术边界。

多模态趋势下,Transformer 作为 AI 大模型主流架构的局面是否会撼动?为何探索基于 MoE (专家混合)架构的大模型成为业内新趋势?大型视觉模型 (LVM)能否成为通用视觉的新突破?...

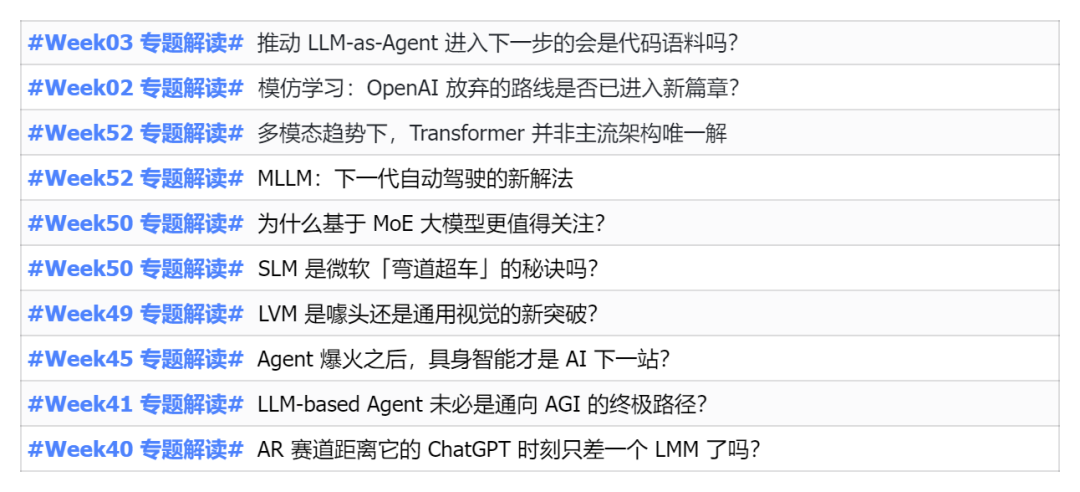

我们从过去的半年发布的2023年机器之心PRO会员通讯中,挑选了 10 份针对以上领域技术趋势、产业变革进行深入剖析的专题解读,助您在新的一年里为大展宏图做好准备。

本篇解读来自2023年 Week45 业内通讯 👇

专题解读 Agent 爆火之后,具身智能才是 AI 下一站?

1、北京人形机器人创新中心有限公司在北京经开区机器人创新产业园正式注册,标志着国内首家省级人形机器人创新中心成立。其将建造通用人形机器人「硬件母平台」,以及大模型+开源运控系统「软件母平台」。2、创新中心将开展通用人形机器人本体原型、人形机器人通用大模型、运控系统、工具链、开源 OS 及开发者社区等 5 项重点任务攻关。3、创新中心还将构建「公司+联盟」的发展模式,组建专家委员会和产业联盟,推动多技术路径探索,促进创新成果转化,构建良好产业生态,加速人形机器人技术供给能力和产业化进程。4、据中心负责人透露,北京市还将成立北京机器人产业发展基金,并正在布局服务机器人制造的共享加工中心。

表:2023 年人形机器人行业政策

你真的了解具身智能 (Embodied AI)吗?具身智能概念的演变史

1、具身智能的概念翻译于英文 embodied AI,字面意思为具有身体的人工智能。该概念的起源最早可追溯到 1950 年人工智能源点级人物艾伦·图灵的理论设想。2、1950 年,图灵在他的论文《Computing Machinery and Intelligence》中首次提出了具身智能的概念。图灵在论文结尾展望了人工智能可能的两条发展道路:一条路是聚焦抽象计算(比如下棋)所需的智能,另一条路则是为机器配备最好的传感器、使其可以与人类交流、像婴儿一样地进行学习。这两条道路便逐渐演变成了非具身和具身智能。3、在过去的几年里,具身智能概念主要受到了来自以下三个研究领域的学者的影响- 最早做具身智能研究的相关研究者大多具有计算机视觉的背景,具身智能的关键之一则是让机器能够通过视觉信息来理解和交互其所处的环境。早在 2018 年,相关研究学者提出了论文《On Evaluation of Embodied Navigation Agents》,通过计算机视觉+机器人的路径来实现具身智能。

- 此外,Peter Anderson、Angel Chang 等人发布的综述论文《A Survey of Embodied AI: From Simulators to Research Tasks》,将具身智能(Embodied Al)的基本研究任务归纳为视觉探索、视觉导航等。视觉探索通过收集关于 3D 环境的信息,通过运动和愿感知,以更新其内部环境模型;视觉导航则是在有无外部先验或自然语言指令的情况下,将三维环境导航到目标。包括 Point Navigation,Object Navigation, Navigation with Priors。Vision-and-Language Navvigation 等。

具身智能强调智能是通过身体与物理世界的交互而产生的,而强化学习作为一种学习范式,在这个范式中,智能体(agent)能够通过与环境的交互来学习策略,以最大化某种累积奖励,同时智能体做出的每个动作都会影响其后续接收的状态和奖励。因此,使用强化学习技术来进行机器人控制,成为具身智能的路径之一。- 随着激光雷达(LiDAR)、高分辨率摄像头等传感器技术的发展,边缘计算和专用硬件(如 GPU 和 TPU)的应用,以及深度学习等机器学习算法的突破,机器人硬件技术成熟度显著提高。这些技术的集成和应用,使得从事机器人硬件开发的研究者逐步转向更加智能、自主和高效的机器人系统。

- 人形机器人是实现具身智能的最佳形态之一。以特斯拉推出的人形机器人擎天柱 Optimus 为例,Optimus 可以自主地对物体进行分类,最终目标为成为拥有「大脑」的类人机器人。

做通用具身智能的「大牛团队」都在扎堆搞什么事 er?① 近期,随着大语言模型的爆火,一些研究者将大语言模型与机器人结合,产生了不错的效果。这类研究大多针对视觉-操作或视觉-导航任务。这些涉及到视觉任务的基础 AI 能力是 Visual Question Answering (VQA)。② 2022 年 8 月,谷歌提出 SayCan 框架,该模型能够更好地理解语言指令并给出回答,并且能结合当前物理环境评估每个回答的真正实现可能性,从而让机器人更好地帮助用户完成任务。SayCan 模型还能够提取大型语言模型中的结果,进行以语言为条件的价值函数的学习和训练,并采用强化学习方法。自谷歌提出 SayCan 框架以来,大语言模型赋能机器人对复杂任务的指令解释成为热门研究。③ 同时,微软团队也在探索如何将 OpenAI 研发的 ChatGPT 扩展到机器人领域,通过用语言直观控制如机械臂、无人机、家庭辅助机器人等多个平台。2023 年 2 月,微软发布《Autonomous Systems and Robotics Group》,在工作中,研究者使用 ChatGPT(基于 GPT3.5)生成机器人的高层控制代码,从而可以通过自然语言和 ChatGPT 交流,使用 ChatGPT 来控制机械臂、无人机、移动机器人等机器人。③ 2023 年 3 月,谷歌发布通才模型 PaLM-E。PaLM-E 是一种多模态具身视觉语言模型 (VLM),能够理解图像以及理解、生成语言,并且能将两者结合起来处理复杂的机器人指令。PaLM-E 实现了对具身任务的决策方案预测,不涉及机器人动作的实际控制,需要依赖低级别的现成策略或规划器来将决策方案「翻译」为机器人动作。④ 2023 年 7 月,斯坦福大学李飞飞团队发布 VoxPoser 系统,将大模型接入至机器人,可在无需额外数据和训练的情况下,将复杂指令转化为具体的行动规划。VoxPoser 系统的实现主要分为三个步骤:输入,给定环境信息以及需要执行的自然语言指令;处理,由 LLM、VLM 两部分构成。LLM 根据输入信息编写代码,然后与 VLM 进行交互,生成指令相应的操作指示地图即 3D Value Map;控制,将 3D Value Map 输入至动作规划器中,合成机器人所需执行的操作轨迹。① Sim2Real,即 Simulation to Reality,旨在解决将模拟环境中的算法迁移到真实世界中来的问题。在强化学习领域中,我们假如让机器直接在现实环境中与环境进行交互获得经验,可能会出现很多的问题,比如采样的效率会比较低,多次交互机器磨损可能也多和安全问题难以得到一定的保障等。但是在模拟环境中,上面的问题都会很好的被解决,所以假如我们能够在模拟环境中将算法给训练到位了,再部署到真实环境中,将会极大的降低我们的成本。

......

完整版专题解读「Agent 爆火之后,具身智能才是 AI 下一站?」已上架至机器之心Pro会员收件箱。新用户订阅限时特惠,单期低至 2.99 元!

- Step 3:进入「收件箱」,点击「参考」板块,畅读往期所有专题解读