开源 VS 闭源,哪边的大语言模型更能打?

最近,大型语言模型获得了前所未有的关注度。在更迭迅速的情况下,开源模型与闭源模型的发展并驾齐驱,同时呈现百花齐放的态势。但仍然令大家好奇的是,开源大模型和闭源大模型,哪一边实力更强?又该如何对比?近日,在推特上,威斯康星大学计算机科学博士生 Wang Yizhong 同样对众多指令调优数据集及开源模型的发展提出了这个疑问。

此前,一些公开的指令调优模型在宣传时称,自身可与功能强大的闭源专有模型 (如 ChatGPT) 相媲美,但是大部分能支持这个说法的实验只是覆盖了全部任务的冰山一角而已,并且这些实验也主要依赖基于模型的评估指标。事实上,评估设置除了测试模型或人工标注的生成质量外,还应该包括测试模型的核心推理和事实回忆技能的任务,这些任务可能更开放和主观。在最近的一项研究中,艾伦人工智能研究所联合华盛顿大学对指令调优资源进行了全面的评估,他们在十几个公共语料库上进行了大量的指令调优实验,从 6.7B 到 65B 的模型规模都有涉及。研究还评估了特定的模型能力 (即事实知识、推理、多语言性、编码) 和开放式的指令遵循能力,并展示了基于自动、基于模型和基于人工的评估指标的结果。

论文地址:https://arxiv.org/pdf/2306.04751.pdf评估表明,在不同数据集上进行指令调优似乎可以提高特定的技能,没有一个数据集能在所有评估中均提供最佳性能。他们还发现,底层基础模型是至关重要的,更好的基础模型 (训练于更多 token 或是更大模型)整体表现更好。意料之外的是,研究还发现在基于模型的评估中首选的模型与在基于基准的自动评估中表现最好的模型并不匹配,这可能是由于 GPT-4 对长的、多样化生成的强烈偏见。评估还表明,在任何给定的评估中,最佳模型的平均性能达到 ChatGPT 的 83%、GPT-4 的 68%,这表明需要进一步构建更好的基础模型和指令调优数据以缩小差距。根据这些发现,研究团队提出了「TÜLU」,一套在数据源组合上进行微调的 7B 到 65B 的 LLAMA 模型。需要声明的是,在撰写本文时,TÜLU 65B 是公开发布的最大的全指令调优 LLAMA 变体。它在 7 个流行的可用数据集上进行训练,并产生最佳的平均性能,同时在每个单独任务上排在最佳性能模型的 15% 以内。研究者开源了用于训练和评估这些大型语言模型的代码,并发布了在不同指令数据集及其混合物上训练的检查点,包括 TÜLU。研究团队试图收集不同风格数据集的代表性样本 (列在表 1 中),包括:(1) 由研究人员从现有的 NLP 数据集 (SuperNI , Flan V2) 创建;

(2) 由人类从头编写,用于指令调优 (Dolly , Open Assistant 1 );

(3) 由专有模型生成 (Self-Instruct , Unnatural Instructions、Alpaca、Baize、GPT4-Alpaca );

(4) 由用户共享的 prompt 和模型生成的补全组成;

(5) 为特定技能而建 (CoT 用于思维链,alpaca 用于代码生成)。

研究主要使用了 LLAMA 套件,这是一系列预训练模型,大小从 6.7B 到 65B 参数不等。这些模型代表了社区可用的最大、最高质量的预训练模型 (尽管在限制性许可下)。研究还考虑了与 LLAMA 6.7B 模型大小相当的 OPT 和 Pythia 模型,以检查不同基础模型的效果。为简单起见,研究将所有大小四舍五入为整数。团队还注意到一些对类似或质量更好的模型进行预训练的工作,他们相信本文的发现应该适用于这些模型以及未来更强大的开放基础模型。

研究将所有数据集格式化为遵循聊天机器人风格的模式,以统一指令数据集的各种风格和格式,如图 1 所示。这让研究团队能够将用户和语言模型 (又称「assistant」) 之间的任意轮交互拟合到一个输入序列中,并将它们与因果语言模型一起编码。他们在用户话语和目标助手响应之前分别添加了特殊 token<|user|> 和 <|assistant|>,并在每个 assistant 输出的末尾添加了一个文本结束 token,在推理时,该 token 将停止模型每轮的响应。

鉴于现有的研究表明,增加指令的多样性能够有效提高指令调优的性能,因此研究者将两个数据集结合起来:人类混合数据,由最佳的人工编写数据集组成。包括 FLAN V2、CoT、Dolly 和 Open Assistant 1 (排除了了 SuperNI,因为 FLAN V2 已经包含了 SuperNI 中的大多数任务);人类 + GPT 混合数据 ,包括人类混合数据和由 OpenAI GPT 模型生成的另外三个数据集,包括 GPT4-Alpaca、Code-Alpaca 和 ShareGPT。研究团队将这些混合数据集连接起来,并将探索更复杂的采样混合物的工作留给未来。他们把在人类 + GPT 混合数据上训练的 LLAMA 模型命名为 TÜLU—— 不同物种之间杂交产生的杂交骆驼。为了了解表 1 中列出的指令数据集对模型能力的贡献,研究者使用评估套件评估了在这些数据集上训练的 LLaMa 13B 模型。表 3 展示了基准评估集上的结果,其中 App D 的结果更为广泛。

一个跨所有任务的最佳指令调优数据集是不存在的;

合并数据集可以在基准任务上获得最佳的整体性能;

基础模型的质量对于下游性能非常重要。(见表 4)

当确定「使用广泛的数据混合是最好的」以及「使用 LLAMA 作为基础模型比其他开放替代方案更可取」后,研究比较所有 LLAMA 尺寸的人类 + GPT 数据混合 (TÜLU 模型) 上训练的模型的性能(如表 5 所示)。

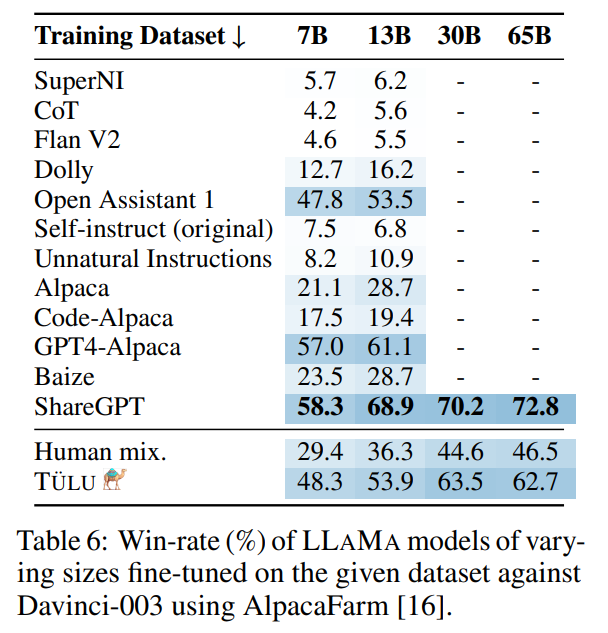

表 6 中报告了模型 AlpacaFarm 胜率。

总体而言,有这些结果可以看出,虽然模型偏好评估很重要,但它并没有提供对这些模型的整体评估。因此,在更大、更全面的评估设置里,模型偏好评估应该只作为其中的一部分。图 4 中展示了人工评估结果。人工评估结果与 AlpacaFarm 和基于基准的评估具有强烈相关性:所有评估表明,65B TÜLU 优于 7B TÜLU。这表明使用更大的基础模型是重要的,并且在 65B TÜLU 和 ChatGPT 之间仍有不小的性能差距。除此之外,研究还发现利用蒸馏数据集可以让性能有很大的提升,这表明相比之下人类编写的数据集是匮乏的。这些观察结果也与图 3 中的可接受性分数相一致。7B TÜLU 在模型偏好评估中优于 human-mix 65B TÜLU,但如果比较图 3 中的可接受性分数,则情况似乎相反。这进一步证明,模型两两评估可能并不始终揭示模型缺陷。在这种情况下,65B 人类混合模型比 7B 模型更有可能产生可接受的 (如果不是高质量的) 响应。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]