GPT-4完成正确率仅6%!北大等提出首个「多轮、多模态」PPT任务完成基准PPTC

新智元报道

新智元报道

【新智元导读】为了填补LLM在复杂多模态环境中利用复杂工具完成多轮、多模态指令的评估空白,研究人员引入了PowerPoint任务完成(PPTC)基准测试,以评估LLM创建和编辑PPT文档的能力。

最近对大型语言模型(例如ChatGPT和GPT-4)进行的评估工作主要侧重于在基本自然语言任务上的能力,以及模型生成用于解决单句用户指令的API的工具使用能力,却忽略了在理解复杂多模态环境中使用API完成用户指令的难题。

此外,现有评估方法主要集中在比较生成的API与标签API序列,但在存在多个/无限正确解决方案的复杂情况下,这种方法也变得不再适用。

为了解决这个挑战,来自北大和微软亚洲研究院的研究人员们提出了测试大模型在多轮,多模态环境下完成PPT任务的评估数据集PPTC(PowerPoint Task Completion)。

论文地址:http://arxiv.org/abs/2311.01767

开源项目:https://github.com/gydpku/PPTC

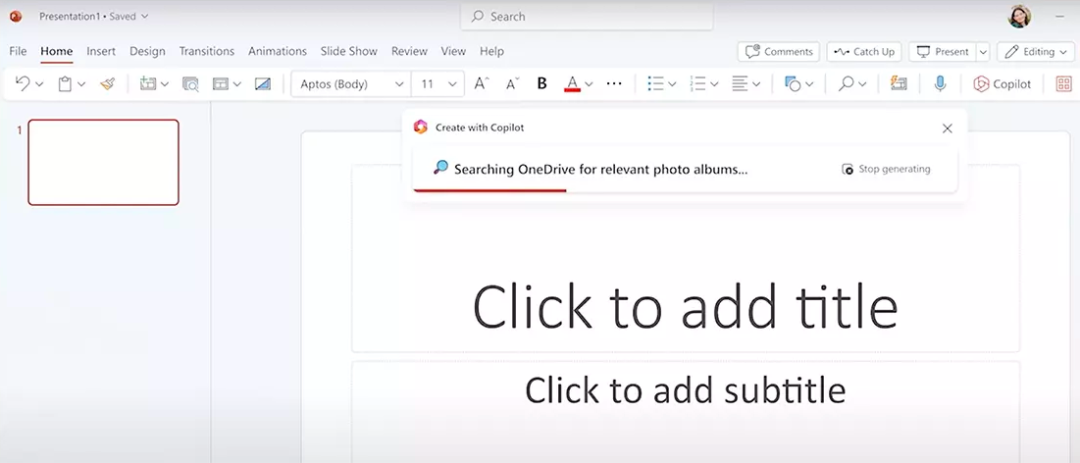

如图1(a)所示,为了帮助用户完成对PPT文档的创建和编辑,研究人员采取多轮人机对话的形式来构建数据集。

图1:(a)模拟了人类与语言模型之间的多轮对话场景,以评估语言模型在PPT任务完成性能方面的表现。(b)对话单元的轮次数量分布。

每轮开始于用户的指令,大模型需要生成对应的API序列作为解决方法,执行并返回生成的PPT文档给用户。

数据集中一共有279个像这样的多轮对话单元,如图1(b)所示,大部分单元由3到10对话轮次组成。

更进一步,如图2(a)所示,数据集中包含各种难度的用户指令(由所需API数量决定),如数百个涉及到统计图表、表格、图像、空间位置相关多模态操作的指令。

图2:(a)指令所需最少API数量分布。(b)涉及到统计图表,表格,图片和位置操作的用户指令数量。

生成和执行API序列

为了完成每轮用户的指令,研究人员主要考虑:

1. 当前轮次的用户指令

2. 之前轮次的用户指令(对话历史)

3. PPT文档(环境信息)

4. 可使用的API列表作为大模型输入,prompt大模型生成对应的API序列作为解决方案。

图3:一个会话单元中语言模型如何完成一个轮次。(A)用当前的指令、之前的指令(对话历史)、PPT文件内容以及API参考文件作为输入prompt大模型。(B)然后,语言模型生成API序列并执行它,以获取预测的PPT文件。(C)评估预测文件中的属性和位置关系

为了方便大模型处理信息,研究人员提供一个PPT文档读取函数来将多模态文档转化为文字形式的文档内容,以及一个API执行函数来自动执行大模型生成的API序列,从而生成对应的预测PPT文档。

评估大模型生成的PPT文档

本文提出PPTX-Match评估系统来评估大模型生成的文档是否正确。

如图3所示,它使用PPTX库来抽取生成的文档中所有的元素,并逐一验证元素间的空间位置关系是否正确,并验证元素的属性内容是否和标签文档的对应内容匹配。

本文的评测系统只评测最终生成的PPT文档,因此允许各种API序列来完成用户指令。

基于这个系统,本文的评测指标分别包括只考虑当前轮次的轮次层面表现和考虑整个单元的单元层面表现。

实验结果

本文在3个闭源大模型和6个开源大模型上测试PPTC数据集。进一步的,本文测试计划算法(零样本思维链(Zero-shot CoT)和思维树(ToT)算法)以及PPT内容和API选择算法是否能进一步提升GPT-4模型在PPTC上的表现。

从表1和表2展现出的结果中,可以得出以下结论:

(1)GPT-4是9个大模型中表现最强的模型,在创建新PPT文档任务中它甚至能实现75%的轮次层面正确率。

(2)基于开源大模型(LLaMa-2)的进一步代码预训练(code-LLaMa)和对齐能够进一步提升模型轮次层面表现

表1:9个大语言模型的结果。「TD-003」是指Text-Davinci-003模型

(3)计划算法和选择算法能够进一步提升GPT-4 2到5个百分点的轮次层面正确率。然而,本文发现,尽管思维树相对零样本思维链花了超过数倍的推断成本,它的表现却并没有明显进一步的提升。

表2:GPT-4和基于GPT-4模型的算法的结果。'CoT'和'ToT'分别是思维链和思维树算法

三个PPTC上的主要挑战

进一步的,本文分析得出大模型在PPTC上遇到的三个主要的挑战:

1. 错误累计导致大模型单元层面表现糟糕

尽管诸如GPT-4这样的大模型在轮次层面表现较好,但当本文测试大模型在包含多个轮次的单元层次表现时,大模型表现普遍糟糕。

如表1所示,在创建新文档任务中,GPT-4只正确完成了不到百分之23的多轮次单元。

2. 大模型处理长PPT模版的能力欠佳

在PPT文档编辑任务中,大模型需要基于给予的长PPT模板完成用户指令。

图4: 创建新的PPT文件任务(任务1)和编辑PPT模板任务(任务2)的分析结果。在子图(a)中,本图展示了涉及图表、表格、图片、位置和纯文本的指令的平均基于轮次的准确度。在子图(b)中,本图展示了GPT-4的四种常见错误的比例。

3. 多模态指令提高了任务难度

如图4(a)所示,大模型在处理图表,表格,图像,空间位置相关的指令上的表现远不如处理只涉及纯文本操作的指令表现,特别是涉及到移动空间位置的指令。

如图4(b)所示,糟糕的空间位置感知成为创建新文档任务的主要错误原因。

总结

1. 本文提出了PowerPoint任务完成评估测试(PPTC),用于衡量在 PowerPoint 官方软件中的语言模型的任务完成性能。这一基准测试包含了279个多轮会话单元,涵盖了复杂的多模式环境中的数百个多模式指令。

2. 本文提出了PPTX-Match评估系统,用于自动测量语言模型在PPTC中的性能。本文测试了3个闭源语言模型和6个开源语言模型,发现GPT-4是所有语言模型中性能最强的。

3. 本文进一步发现了三个关键的错误因素:会话中的错误累积、长的PPT模板处理和多模态感知。这些发现为未来的语言模型和基于语言模型的agent系统提出了重要的挑战。

微信扫码关注该文公众号作者