一句话概括:相对于静态温度超参蒸馏,本文提出了简单且高效的动态温度超参蒸馏新方法。

论文标题:

Curriculum Temperature for Knowledge Distillation

AAAI 2023

https://arxiv.org/abs/2211.16231

https://github.com/zhengli97/CTKD

背景问题

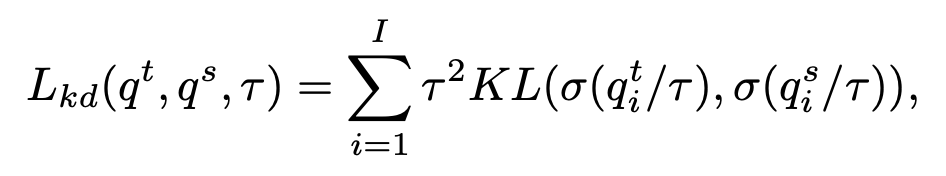

目前已有的蒸馏方法中,都会采用带有温度超参的 KL Divergence Loss 进行计算,从而在教师模型和学生模型之间进行蒸馏,公式如下:

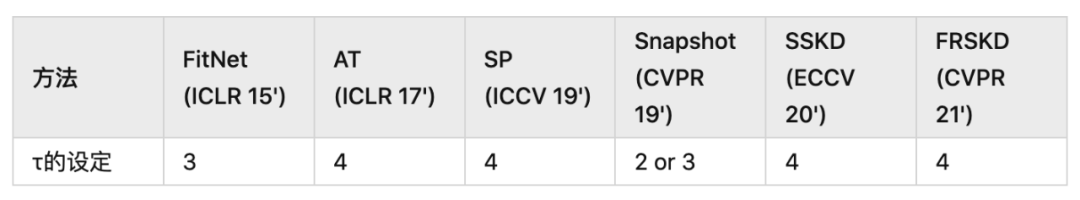

其中,温度超参 的大小控制了两个预测结果 和 的平滑程度,决定了两个概率分布间的距离,τ 越大 (τ>1),就会使得概率分布越平滑 (soft),τ 越小 (0<τ<1),越接近 0,会使得概率分布越尖锐 (sharp)。τ 的大小影响着蒸馏中学生模型学习的难度,不同的 τ 会产生不同的蒸馏结果。而现有工作普遍的方式都是采用固定的温度超参,一般会设定成 4。

1. 不同的教师学生模型在 KD 过程中最优超参不一定是4。如果要找到这个最佳超参,需要进行暴力搜索,会带来大量的计算,整个过程非常低效。 2. 一直保持静态固定的温度超参对学生模型来说不是最优的。基于课程学习的思想,人类在学习过程中都是由简单到困难的学习知识。那么在蒸馏的过程中,我们也会希望模型一开始蒸馏是让学生容易学习的,然后难度再增加。难度是一直动态变化的。 于是一个自然而然的想法就冒了出来:在蒸馏任务里,能不能让网络自己学习一个适合的动态温度超参进行蒸馏,并且参考课程学习,形成一个蒸馏难度由易到难的情况?

方法

既然温度超参 τ 可以在蒸馏里决定两个分布之间的 KL Divergence,进而影响模型的学习,那我们就可以通过让网络自动学习一个合适的 τ 来达到以上的目的。 在蒸馏过程里,学生网络被训练去最小化 KL loss 的情况下,τ 作为一个可学习的参数,要被训练去最大化 KL loss,从而发挥对抗 (Adversarial) 的作用,增加训练的难度。随着训练的进行,对抗的作用要不断增加,达到课程学习的效果。 以上的实现可以直接利用一个非常简单的操作:利用梯度反向层 GRL (Gradient Reversal Layer) 来去反向可学习超参 τ 的梯度,就可以非常直接达到对抗的效果,同时随着训练的进行,不断增加反向梯度的权重 λ,进而增加学习的难度。 1. 对抗温度超参 τ 的学习部分。这里只包含两个小模块,一个是梯度反向层 GRL,用于反向经过温度超参 τ 的梯度,另一个是可学习超参温度 τ。 其中对于温度超参 τ,有两种实现方式,第一种是全局方案 (Global Temperature),只会产生一个 τ,代码实现非常简单,就一句话:self.global_T = nn.Parameter(torch.ones(1), requires_grad=True)

第二种是实例级别方案 (Instance-wise Temperature),即对每个单独的样本都产生一个 τ,也就是对于一个 batch 中 128 个 sample,那么就生成对应 128 个 τ。代码实现也很简单,就是两层 conv 组成的 MLP。两种方案的对比图如 Fig.2 所示。随着训练的进行,不断增加 GRL 的权重 λ,达到增加学习难度的效果。在论文的实现里,我们直接采用 Co s的方式,让反向权重 λ 从 0 增加到 1。 总结一下方法:CTKD 总共包含两个模块,梯度反向层 GRL 和温度预测模块,CTKD 方法可以作为即插即用的插件应用在现有的 SOTA 的蒸馏方法中,取得广泛的提升。

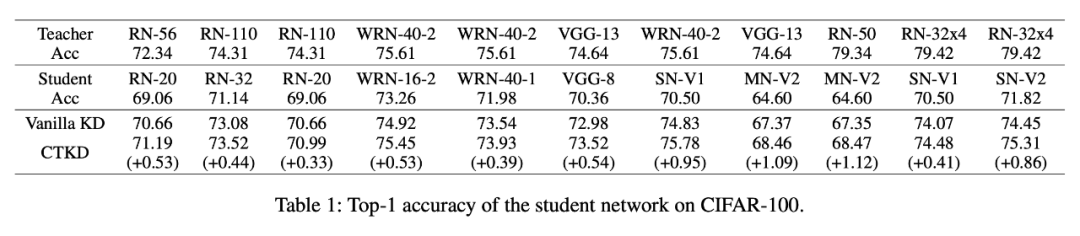

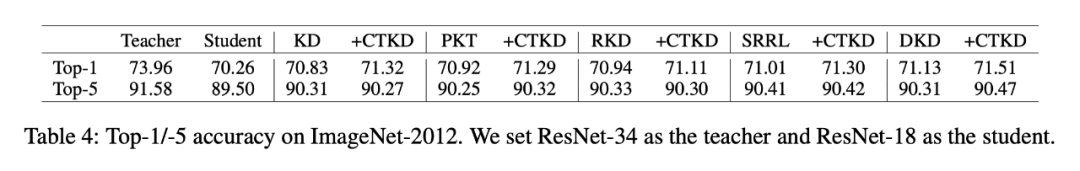

实验结果

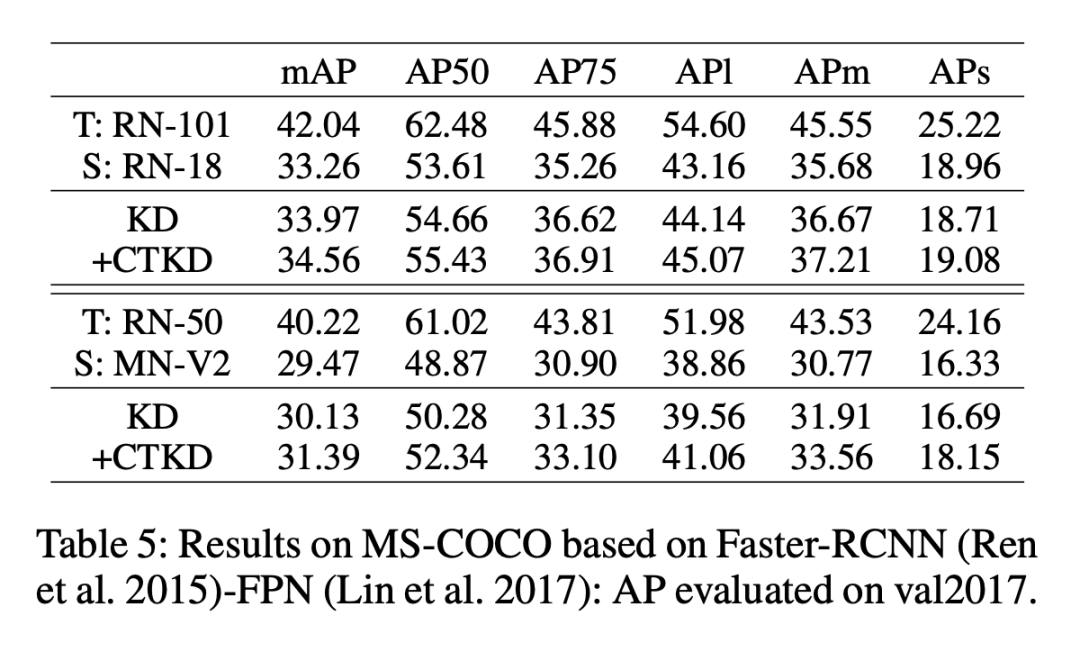

三个数据集:CIFAR-100,ImageNet 和 MS-COCO。

作为一个即插即用的插件,应用在已有的 SOTA 方法上:

在 MS-COCO 的 detection 实验上:

由以上图可以看到,CTKD 整体的动态学习 τ 的过程。将 CTKD 应用在多种现有的蒸馏方案上,可以取得广泛的提升效果。欢迎大家试用。

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」