©PaperWeekly 原创 · 作者 | 陈兆宇

单位 | 复旦大学ROILab

研究方向 | 对抗样本

论文标题:

Enhance the Visual Representation via Discrete Adversarial Training

http://arxiv.org/abs/2209.07735

https://github.com/alibaba/easyrobust

解决的问题

如今,深度神经网络(DNN)在大多数计算机视觉任务中都取得了超越人类的优异性能。尽管取得了显着进展,但当独立同分布的假设在非实验室的场景中不满足时,DNN 的成功实际上是一种错误的感觉。研究人员表明,深度模型在大多数情况下都会失败,包括对抗扰动、常见损坏、颜色或纹理变化等。这说明要使 DNN 更接近鲁棒的人类感知,还有很长的路要走。一种实现强大机器感知的可能方法是对抗训练(AT),它会自动发现 DNN 的故障输入样本,并通过这些样本在线扩充以修复“错误”。通过对抗样本的在线增强,AT 极大地增强了对抗鲁棒性,并有助于学习具有良好可解释性和可迁移性的感知对齐表示。然而,AT 是双刃剑,这种有问题的正则化会降低标准性能。这种有问题的正则化使决策边界过度平滑并扩大了不明确的区域。但与众不同的是,AT 在自然语言处理(NLP)中有着相反的表现。通过自动寻找对抗文本输入,AT 不仅不会降低准确性,甚至有利于语言模型的泛化和鲁棒性。这种现象促使作者考虑是否可以将 NLP 式 AT 的优点转移到视觉任务中。作者认为,这种优点可能源于语言模型独特的数据组织形式。具体来说,在连续像素空间中受到扰动的对抗图像实际上与现实世界中出现的真正“困难”样本不同。相反,文本空间是离散的和象征性的,当人类打错字时,对抗文本实际上存在。学习这样的对抗文本显然会提高对其他更多拼写错误文本的泛化能力。因此,可以借用语言的符号本质,通过将连续图像离散化为更有意义的符号空间,将其应用于 CV 任务。之后,进行 AT 以最小化具有符号对抗扰动的此类文本输入的最大风险 loss。于是,作者提出了离散对抗训练(DAT),旨在提高视觉模型的鲁棒性和泛化能力。DAT 利用 VQ-GAN 学习视觉词汇表,也称为图像代码本(image codebook)。对于连续的图像输入,每个编码的补丁嵌入被码本中最接近的视觉词(visual word)替换,并表示为相应的索引。然后将图像转换为类似于语言输入的一系列符号索引。为了基于这种符号序列生成对抗样本,在 NLP 中直接使用优化方法(如组合优化或同义词替换)可能具有挑战性。原因在于:1)图像的大搜索空间和 2)视觉代码本中不存在同义词。为了提高效率,DAT 采用基于梯度的方法,假设反向对抗梯度直接通过复杂的离散化过程,因此可以将离散化图像上的梯度复制到原始输入。然后它沿估计梯度的方向使用一步搜索,使得离散表示在离散化过程中发生对抗性变化,从而产生离散的对抗样本。最后,离散的对抗样本被输入模型进行训练。与总是在增强的对抗样本上添加 边界的 AT 不同,DAT 影响离散化过程以产生超出 界的各种对抗输入以进行训练,而且在一定程度上有利于防御不受限制的语义攻击。

提出的方法

2.1 传统对抗训练

传统对抗训练一般表述为一个 min-max 过程,即:一个问题是 AT 在连续像素空间中找到对抗样本,即 。然而,人类不是从复杂的像素值创建或识别图像,而是从离散的语义概念中创建或识别图像。尽管对抗样本可以成功骗过模型,但它们与实践中出现的真正的难样本仍然存在差异。

作者首先引入了离散视觉表征学习的概念,然后介绍了离散对抗训练,最后分析了能够提升鲁棒性和泛化性的可能原因。对于离散对抗训练,首先需要学习一个有表现力的视觉代码本,并在离散空间中表示训练图像集。本文中,作者利用 VQGAN 进行图像离散化。给定连续图像 ,VQGAN 会学习到一个编码器 ,解码器 和量化操作 。编码器 是一个卷积模型,将 映射到中间隐变量 。 会学习到一个代码本 ,每个隐变量 会被量化到最近的 ,即表示为:然后,解码器 会从量化后的隐变量 中重建出 。VQGAN 的训练是最小化 和 之间的区别。为简单起见,作者用 表示上述图像离散化过程,则有 。在离散对抗训练中,因为利用 VQGAN 来生成离散对抗样本,因此 DAT 的优化目标可以表述为:可以发现,作者删除了常规约束扰动 的约束项。同时,作者假定 是一个理想的离散器,即在离散化过程中是没有信息损失的。问题在于如何找到最差的 来最大化分类损失。与传统的 AT 类似,可以使用基于梯度的方法通过以下方式近似 ( 是扰动的幅度,因为这里是单步的,也可以理解为 PGD 等攻击的步长):

通过分析每一项的可行性,显然可以发现,由于式2是不可微的,所以 是不可微的。幸运的是,正如之前工作中提出的那样,可以通过将梯度从 复制到 来使用直通梯度估计器(straight-through gradient estimator)。尽管该解决方案在理论上似乎可行,但巨大的成本使其在大规模视觉任务上不切实际。其计算瓶颈在于 和 ,这部分计算要求对抗梯度对编码器和解码器的反向传播。实际上,能够产生高质量图像的生成器总是具有大量参数。与原来只需要 进行梯度计算的对抗训练相比,它需要三倍多的 GPU 内存和计算成本。为了解决这个问题并进一步提高效率,作者提出了一种高效的替代策略。因为假定 是理想的,那么能推出 ,那不妨在这两者之间再使用 straight-through gradient estimator,那么可以推出:最终,扰动 是根据 来计算的。通过这种方式,大大降低了 DAT 的计算成本。与原有的对抗训练相比,仅在 VQGAN forward 上有额外的计算开销,相对可控。DAT 的总体流程是:对于每个训练图像 ,DAT 首先使用 VQGAN 得到离散重建图像 。通过将 馈送到分类器 ,可以通过计算 的梯度以最大化分类损失来估计最坏情况的扰动 。因此,可以通过在原始 上添加 来创建扰动图像。最后, 再次被 VQGAN 离散化并作为对抗输入,通过最小化分类损失来训练 。从分布的角度解释为什么 DAT 会有效:之前的工作已经指出,对抗样本的底层分布与正常图像不同。在正常图像和对抗图像上进行训练将迫使 BN 估计不准确的特征分布混合统计,从而影响标准性能。

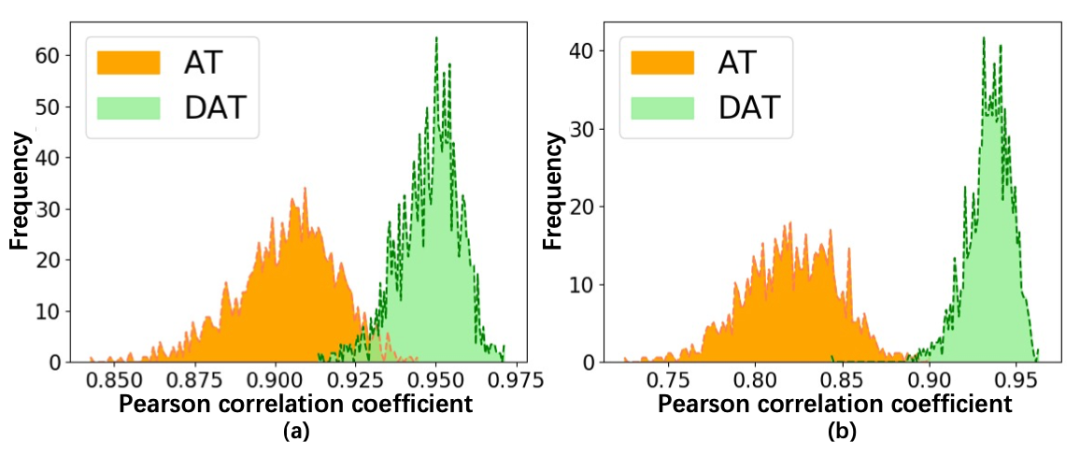

于是作者从 ImageNet 验证集中随机采样了 1,000 个 batch,分别用 AT 和 DAT 来生成对抗样本。对于每个 batch,作者统计了 ResNet50 最后一层 BN 的均值和方差。然后计算正常样本和对抗样本的统计数据之间的 Pearson 相关系数(PCC),以显示分布差异。

上图显示了 1000 个 batch 的分布差异的频率直方图。对于 DAT 的训练样本,直方图的峰值在 0.95 处,大于 AT。它表明 DAT 生成的离散对抗样本更接近正常分布。因此,对这些样本进行训练将减少 AT 中正常分布的偏移,从而提高鲁棒性和泛化能力。

实验和效果

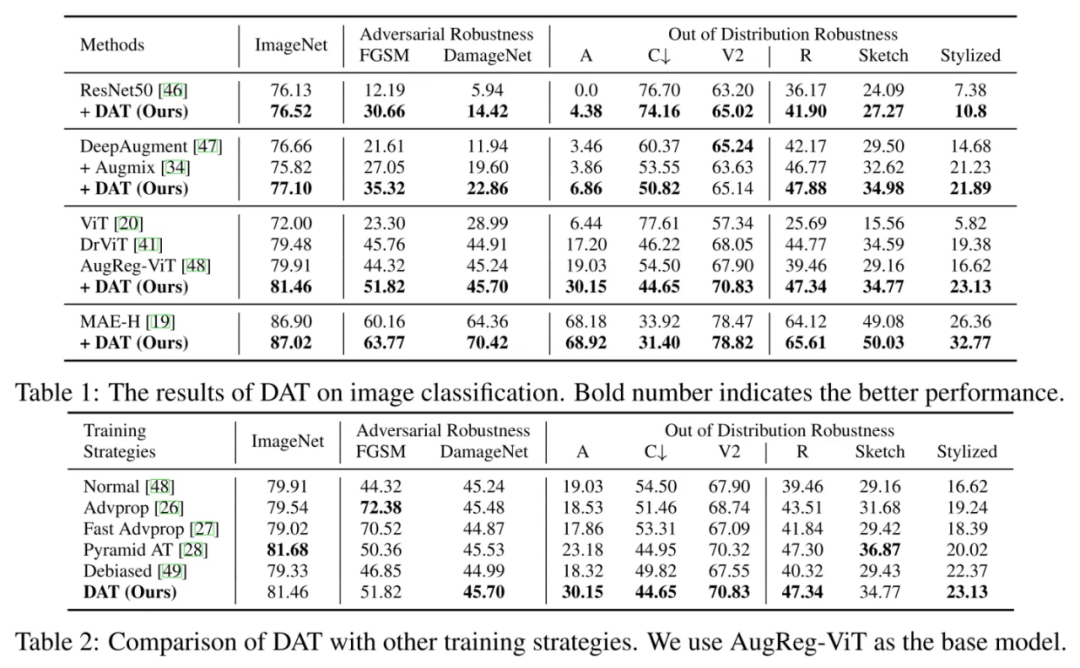

测试基准:域内性能,对抗鲁棒性,OOD鲁棒性

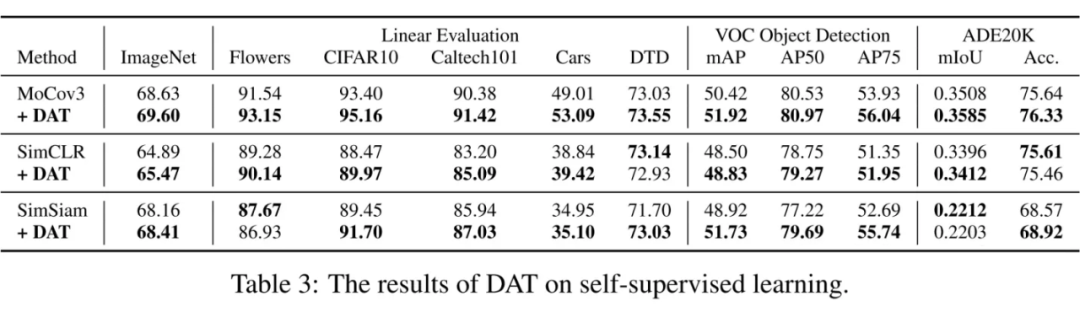

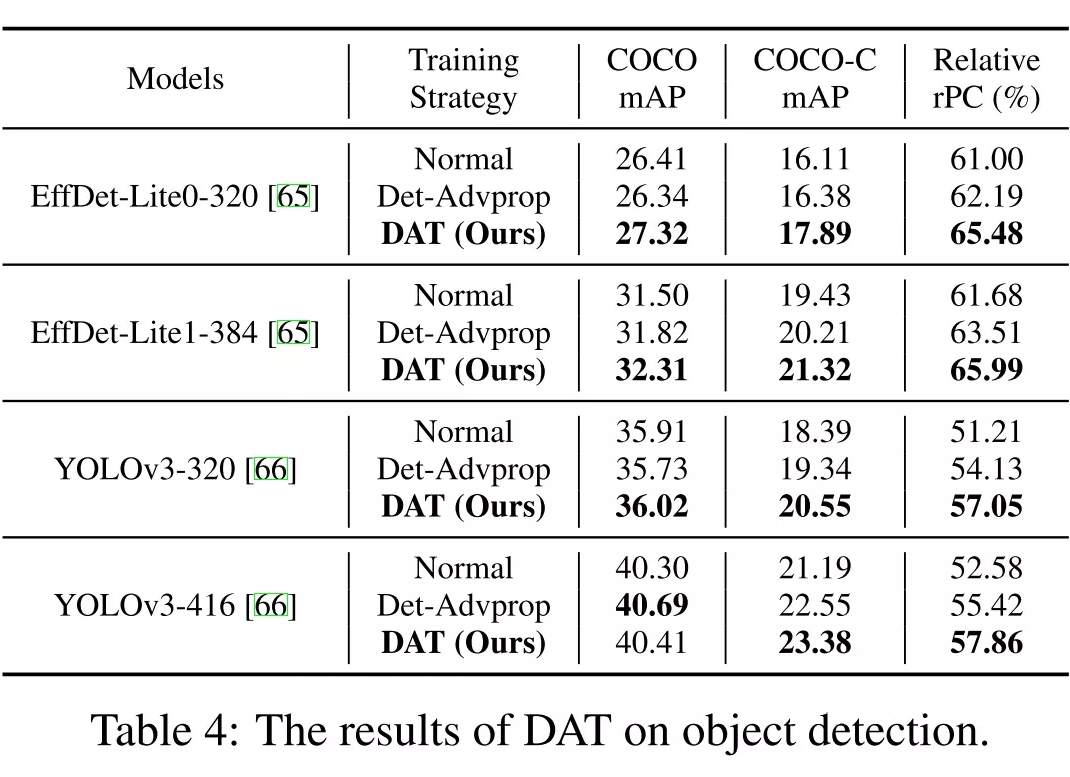

主要做图像分类,自监督和目标检测上进行了实验。

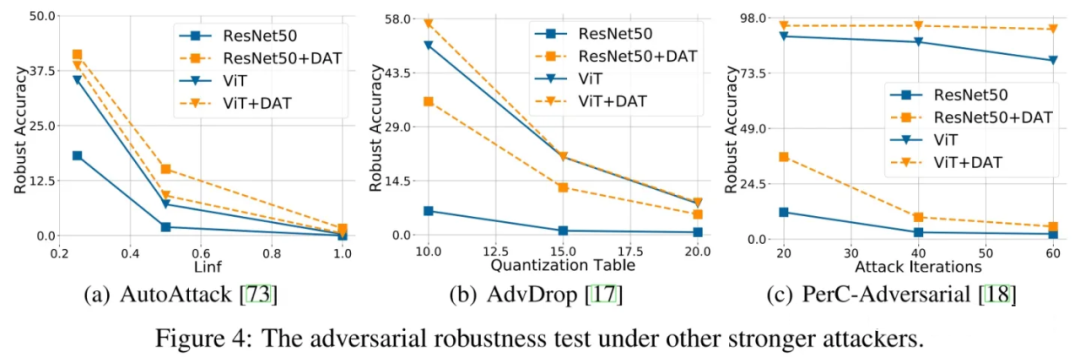

在更强攻击下的对抗鲁棒性,包括一些语义攻击:

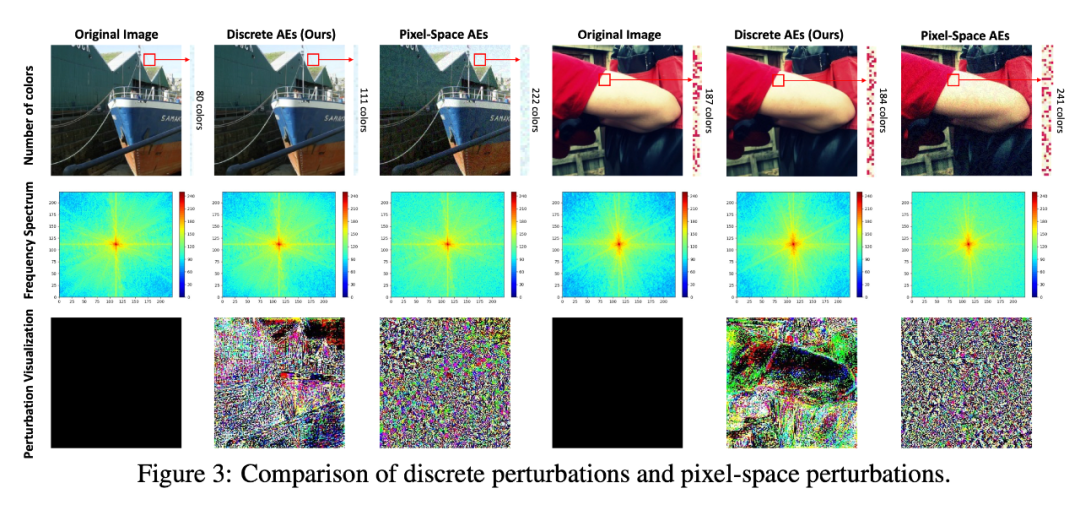

离散扰动 vs. 像素级别扰动:下图中将提出的离散对抗样本(DAE)与传统的像素空间对抗样本(PAE)进行了比较。DAE 具有以下三个优越的特性:1)DAE 更真实。通过计算颜色数量,发现 PAE 添加了更多无效颜色,导致图像出现噪声。虽然 DAEs 在颜色数字上有微小的变化,但它的修改更难被人类感知。为了给出定量结果,另外报告了 DAE 的 FID 分数。我们的 DAE 的 FID 分数是 14.65,低于 AE 的 65.18。结果也与下图中的视觉呈现结果一致;2)在频率分析中,DAEs 的高频分量比 AEs 少。它可能会使 DAE 更接近自然图像分布;3)离散扰动更具结构性。从下图第三行的扰动可视化中,作者发现离散扰动具有更多关于对象的结构化信息,表明它关注更重要的位置。虽然像素方向的扰动是嘈杂和无序的。

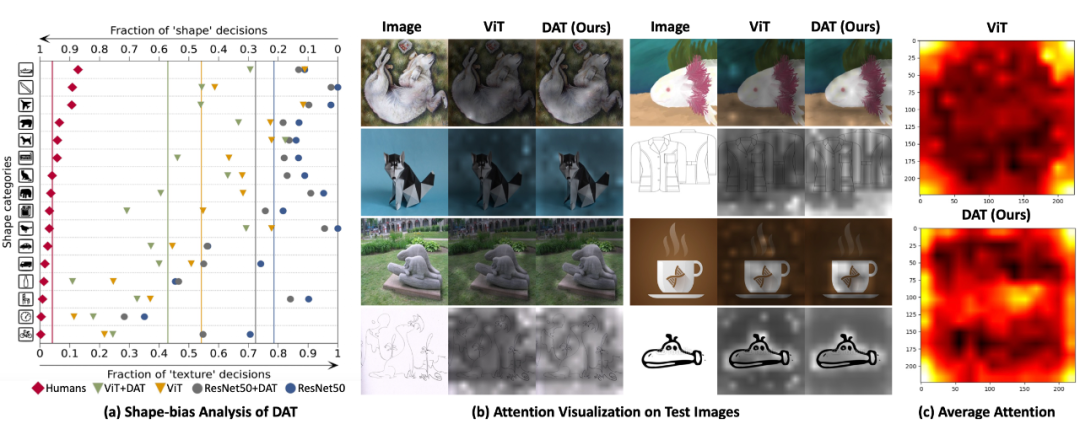

视觉注意力分析:在下图(b)中可视化了由 DAT 训练的 ViT 的注意力。对于 ImageNet-R 中具有异常再现的对象,ViT 无法关注语义相关的图像区域。而 DAT 可以将注意力定位到与分类更相关的中心对象。

这种现象也反映在下图(c)中注意力的统计平均值上。通过在 ImageNet-R 中随机采样 1000 张图像并对注意力图进行平均,DAT 的注意力更加全局。与 ViT 相比,它更加关注先前工作发现的图像的角落,DAT 还额外关注分类对象通常所在的中心区域。

形状偏差分析:形状偏差表示基于对象形状的正确决策的分数如上图(a)所示。16 个类别的平均分数由彩色垂直线表示。作者将决策与人类、ResNet50 w/ 和 w/o DAT、ViT w/ 和 w/o DAT 进行比较。人类的决定高度基于形状,达到 0.96 的最佳平均分数以按形状正确识别图像。

相比之下,ViT 和 ResNet50 在学习形状特征的能力上与人类还有较大差距。在这项工作中,DAT 可以帮助提高模型基于形状的决策的比例。这说明 DAT 对模型进行正则化以学习与纹理无关的形状特征,并表现得更像人类。

总结和不足

我感觉就是用 VQGAN 进行了一波数据增强提高了模型的泛化性和鲁棒性。因此来看,其他生成模型或者说离散视觉模型中的什么性质保证了这种泛化性和鲁棒性的提升,仍然值得探究。

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧