视频分割任务 (Video Segmentation) 由图像分割任务扩展而来,旨在同时分割、检测、追踪视频中的所有目标,是一项比图像分割更具挑战的基础任务。相比于逐帧处理视频帧的图像分割算法,视频分割算法可以提供时序稳定、准确的分割结果,并追踪每一个单独的目标,实现视频中实例级别的理解与编辑功能。视频分割在视频编辑、短视频基础工具、自动驾驶、监控安防等下游任务有着重要作用。

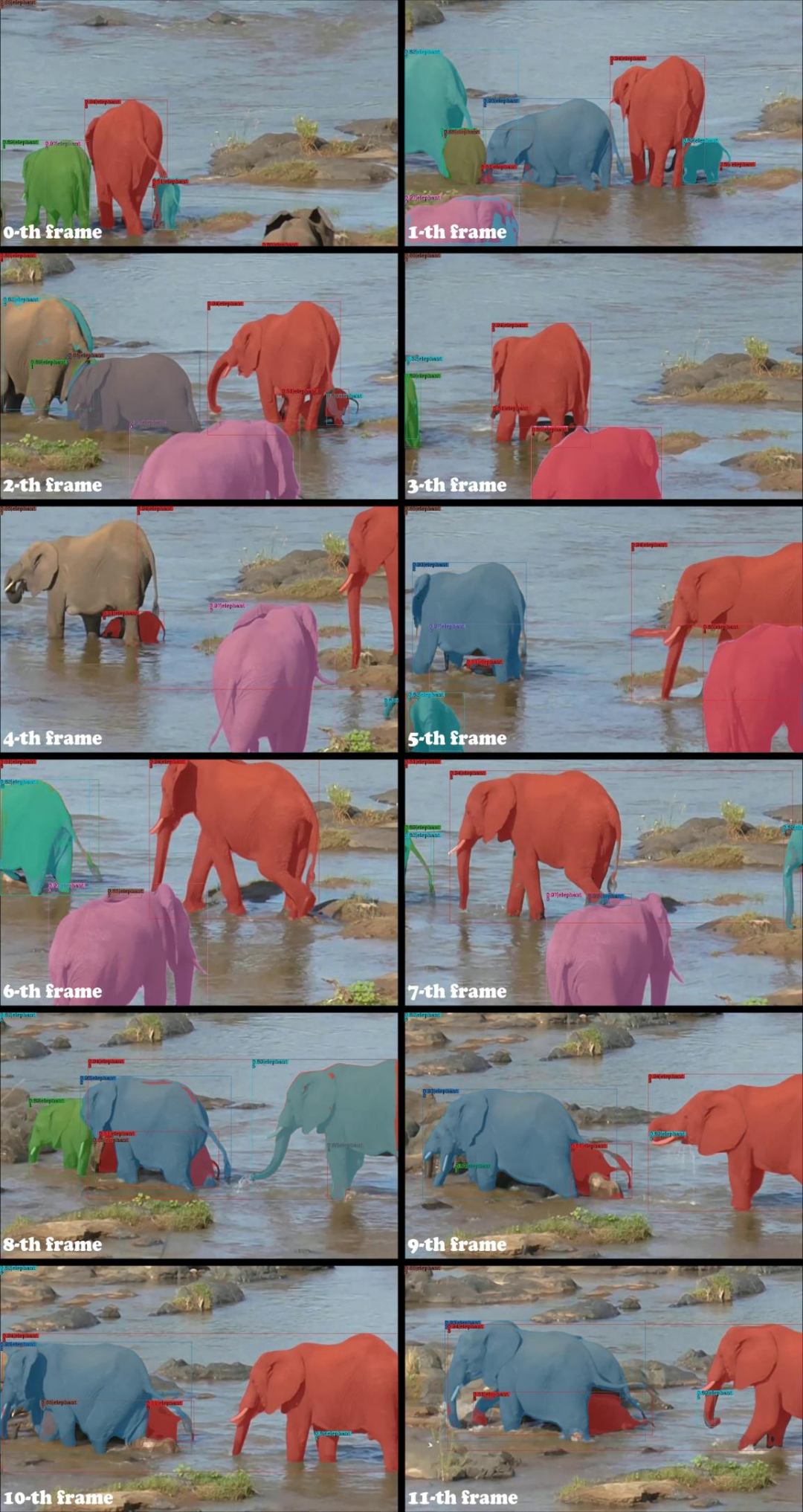

近年来,Transformer [1] 在 CV 中各个领域被广泛应用。DETR [2] 作为基于 Transformer 的经典工作之一,在图像目标检测、图像实例分割领域展现出了强大的潜力。相比于基于 ROI 的实例表征方式,DETR 所采用的基于 Query 的实例表征方式展现出了更强劲的表征能力以及灵活性。受到图像目标检测领域进展的启发,VisTR [9] 首次将 Transformer 应用于 VIS 领域,展现出了巨大的性能提升。随后基于 Transformer 的方法在 VIS 领域成为了主流。目前视频分割领域的方法可以分为在线 (online) 与离线 (offline) 方法。在线方法在预测当前帧结果时以当前帧及历史帧作为输入,主要应用于需要实时处理的需求场景,如自动驾驶中的实时感知。离线方法在预测当前帧结果时可以利用视频中任意帧作为输入,主要应用于离线处理的需求场景,如视频编辑等。现有的 SOTA 的 online 方法 (MinVIS [3]、IDOL [4] 等) 遵循着先执行图像分割后逐帧关联实例的技术路线。这种技术路线并未根据其他帧的信息来优化当前帧的分割结果,因此缺乏对于视频信息的有效利用。现有的 SOTA 的 offline 方法 (SeqFormer [5]、Mask2Former-VIS [6]、VITA [7]、IFC [8] 等) 采用一个紧耦合网络来端到端地处理视频分割任务。虽然这种技术路线理论上可以更加有效地利用视频信息,但是在长视频以及复杂场景中,性能却不尽人意。如以下视频抽帧所示,当视频中出现很多个同类目标发生相互遮挡换位等情况时,Mask2Former-VIS 的目标跟踪结果出现错乱,分割精度也受到影响。

▲ Mask2Former-VIS在换位场景极易追踪出错(ID请放大观看)

offline 方法相比于 online 方法可以利用更多的信息,因此理论上应该有着更好的表现。然而事实并非如此,在复杂场景下现有的 offline 方法的性能显著低于 online 方法。我们认为这是由于现有的 offline 方法对实例表征的设定所导致的。现有的 offline 方法采用单一的可学习的 query 来表征视频中的一个实例,这种可学习的 query 可以被看作位置以及大小先验。然而在实际场景中,某个实例的表观和空间位置都可能发生大幅变化,因此仅靠位置与大小先验很难从所有帧中都探测到该实例的正确特征。 正如上面视频 demo 所示,3 号 query(红色掩码覆盖)学习到的先验位置信息处在视频的右侧,然而视频前段所标记的大象在视频结束时已运动至视频左侧。那么如何充分利用视频信息以使得 offline 方法发挥出理论上应有的潜力?来自武汉大学与快手 Y-tech 的研究者共同研发了一种新的视频实例分割算法——DVIS,回答了该问题。研究论文已被 ICCV 2023 接收。

https://arxiv.org/pdf/2306.03413.pdf项目地址:

https://github.com/zhang-tao-whu/DVIS

DVIS 在 OVIS、YouTube-VIS、VIPSeg 等数据集上均取得了 SOTA 表现,在 OVIS 数据集上从 2023 年 2 月霸榜至今,并在 CVPR 2023 的 PVUW 挑战赛、ICCV2023 的 LSVOS 挑战赛等多项赛事中取得冠军。 具体来说,DVIS 具有以下特性:

DVIS 可以实现视频通用分割,可以处理视频实例分割 (VIS)、视频语义分割 (VSS) 以及视频全景分割 (VPS) 三大任务。

DVIS 可以在 online 以及 offline 模式下运行。

解耦的设计使得 DVIS 训练所需要的计算资源较少,相比于 segmenter 仅带来了不足 5% 的额外计算代价,DVIS-R50 可以在 2080Ti 上一天内完成训练。

- DVIS 在多个 VIS 以及 VPS 的数据集上均取得 SOTA 性能。

效果展示

在本文之前,VIS 领域的 SOTA 方法 MinVIS 在复杂视频上的表现较差,主要体现在目标跟踪 ID 容易发生错乱、分割掩码破碎等现象。本文提出的 DVIS 则可以在复杂长视频中追踪并稳定分割目标。MinVIS 和 DVIS 的对比如下视频所示。除此之外,DVIS 在目标占画面比例较小时依然表现良好:

方法简介

既然直接建模实例在整个视频上的表征是困难的,那么是否可以首先在单帧中建模实例,然后逐帧关联实例来获取同一实例在所有帧的表征,最后再对实例的时序信息加以利用。毫无疑问,逐帧关联的难度要比直接关联所有视频帧上的同一实例小得多。在给出时间上良好对齐的实例特征的情况下,有效地对这些特征加以利用也是轻而易举的。我们将 VIS 任务分解为图像分割、物体关联、时序精化三个子步骤,相应的我们分别设计 segmenter、tracker 和 refiner 三个网络模块来处理这三个子步骤。其中图像分割即为在单帧中分割出目标并获取目标的表征。物体关联即为关联相邻帧的目标表征,为 refiner 提供一个良好对齐的初值。时序精化即为基于对齐好的物体时序信息来优化物体的分割结果以及追踪结果。

当 DVIS 的架构确定好后,我们需要针对图像分割、物体关联、时序精化三个子步骤分别设计合理的 segmenter、tracker 以及 refiner 网络。图像分割子步骤中,我们采用了 SOTA 的图像通用分割网络 Mask2Former 作为 segmenter 来提取物体的表征;物体关联子步骤中,我们将追踪建模为参考去噪 / 重建任务,并设计了 Referring Tracker 来进行稳健的目标关联;在时序精化子步骤中,我们基于 1D 卷积以及 Self Attention 实现了 Temporal Refiner 来有效地利用物体的时序信息。

DVIS 将相邻帧物体的关联任务建模为根据上一帧物体 query 来重建当前帧对应的物体 query,即给定上一帧物体的 query 作为 reference query,然后从 segmenter 输出的当前帧的 object query 中聚合信息,最后输出 reference query 相应的实例在当前帧的掩码和类别。Referring Tracker 通过 Referring Cross Attention 来学习以上过程。Referring Cross Attention 充分利用 refrence query 来指导信息的聚合并阻隔了 reference query 与当前信息的混杂,其由标准 Cross Attention 稍作改动而得到:

在 Referring Tracker 输出在时间维度上基本对齐的目标 query 后,就可以很容易的通过标准操作(如 1D 卷积以及 Self Attention)来对时序特征进行有效利用。我们设计的 Temporal Refiner 也非常简单,由 1D 卷积以及 Self Attention 来聚合时序特征。Temporal Refiner 基于物体的时序特征来优化分割结果以及追踪结果。值得一提的是 DVIS 的设计很灵活,Referring Tracker 可以叠加于任何 query-based 的图像分割器来实现在线的视频分割,Temporal Refiner 同样可以叠加于任何在线的视频分割器来获取更强大的分割性能。

实验结果

我们在 OVIS 数据集上对于 Referring Tracker 和 Temporal Refiner 的作用进行了消融实验。Tracker 的主要作用是实现更鲁棒的目标关联,尤其是对于中度遮挡和重度遮挡的物体有较大改善(如下表所示,为中度遮挡以及重度遮挡的目标分别带来了 5.2 AP 和 4.3 AP 的性能提升)。Refiner 的主要作用是充分利用时序信息,结果显示由于时序信息的有效利用,Temporal Refiner 对于被轻度、中度、重度遮挡物体的性能都有显著提升(如下表所示,为轻度、中度以及重度遮挡的目标分别带来了 2.4 AP 和 1.8 AP 和 5.1 AP 的性能提升)。

并且,由于 Referring Tracker 和 Temporal Refiner 仅处理 object query,因此计算代价很小,计算量总和少于 Segmenter 的 5%(见下表):

DVIS 在 OVIS、YouTube-VIS (2019,2021) 以及 VIPSeg 等数据集上均取得 SOTA:

结论

在本文中,我们提出了 DVIS,一种将 VIS 任务解耦的框架,将 VIS 任务分为三个子任务:分割,跟踪和细化。我们的贡献有三个方面:1)我们将解耦策略引入了 VIS 任务并提出了 DVIS 框架,2)我们提出了 Referring Tracker,通过将帧间关联建模为引用去噪来增强跟踪的鲁棒性,3)我们提出了 Temporal Refiner,利用整个视频的信息来精化分割结果,弥补了之前工作在这方面的缺失。结果表明,DVIS 在所有 VIS 数据集上实现了 SOTA 性能。虽然 DVIS 的设计来源于对 VIS 领域内既有方法不足的反思,但是 DVIS 的设计并不局限于视频实例分割领域,其可以无任何改动的在 VIS,VPS 和 VSS 上都取得 SOTA 性能,这证明了 DVIS 的通用性与强大潜力。我们希望,DVIS 将成为一个强大且基础的基准,并且我们的解耦洞见将激发在线和离线 VIS 领域的未来研究。从未来技术发展的角度上,我们将会继续探索面向图像、视频以及更多模态的基础视觉感知技术,从模型通用性、开放类别等角度进一步拓展基础视觉感知技术的边界。

[1] Attention Is All You Need. NeurIPS2017

[2] End-to-End Object Detection with Transformers. ECCV2020

[3] MinVIS: A Minimal Video Instance Segmentation Framework without Video-based Training. NeurIPS2022

[4] In Defense of Online Models for Video Instance Segmentation.ECCV 2022

[5] SeqFormer: a Frustratingly Simple Model for Video Instance Segmentation. ECCV 2022

[6] Mask2Former for Video Instance Segmentation.

[7] Video Instance Segmentation via Object Token Association. NeurIPS2022

[8] Video Instance Segmentation using Inter-Frame Communication Transformers. NeurIPS2021

[9] End-to-End Video Instance Segmentation with Transformers

[a] https://github.com/zllrunning/video-object-removal

[b] https://github.com/PeterL1n/RobustVideoMatting

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:[email protected]

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧