GPT 3.5 系列在常见应用任务中实际表现如何? GPT 3.5 模型回答不同的问题一般都需要多少成本?

本期「SOTA!实测」我们使用 OpenAI 提供的 API,在面试、邮件、直播、周报、简历等五个场景下的一系列应用任务上,对 GPT-3.5 系列的gpt-3.5-turbo,text-davinci-003及text-davinci-002这三个不同模型的推理消耗、及推理效果两个维度进行对比实测。 | | | |

|---|

| 是目前最强大的 GPT-3.5 模型,专门针对聊天场景进行优化,价格是 text-davinci-003 的十分之一。 | 可以完成任何语言任务,并且质量更好,输出更长,并且比 Curie、Babbage 或 Ada 模型更能按照指令进行操作。 | 与 text-davinci-003 具有相似的能力,但是是通过有监督的精细调整来训练的,而不是通过强化学习,最大 Token 数为 4097。 |

| | | |

| | | |

| 综合评分较高,表现出较高的精确度和专业性,对于大多数任务都能够适应,输出的结果较为完整、流畅,而且针对不同任务的输出也比较准确、全面,具有较强的适应性和通用性,且成本最低。 | 综合评分相对较低,虽然对于一些任务表现不错,但整体来说输出的结果缺少个性化和针对性,表述不够精准和简洁,有时也存在一些不准确的情况。 | 综合评分最低,输出结果的专业性和准确性都不够高,缺少个性化和针对性,语言表述也存在较大问题,整体来说需要进一步优化和改进。 |

在面试问题场景任务中,gpt-3.5-turbo 综合评分最高,能够很好地适应面试场景,生成的问题具有较高的针对性和多角度深入了解候选人的能力和经验;而 text-davinci-002 的评分最低,问题过于宽泛且基本是对岗位描述的重复,缺乏挑战性和实际性的问题,甚至出现生成的内容完全不可用的情况。在英文邮件写作场景任务中,gpt-3.5-turbo 和 text-davinci-003 的综合评分较高,能够模拟口语和正式书面的语言风格,对于口语化的表达和带有歧义的名词有很好的理解和翻译,但也无法正确地识别不安全的内容;而 text-davinci-002 的评分最低,口语与书面语不能很好切换,没有正确的识别不安全的内容。在直播场景任务中,gpt-3.5-turbo 的评分最高,能够准确、精炼、流畅地概括直播内容,并符合要求中的简洁度要求;而 text-davinci-002 的评分最低,输出准确度一般,不能很好地适应场景,但在简洁性和流畅性方面还有进一步改进的空间。在周报场景任务中,gpt-3.5-turbo 和 text-davinci-003 的评分较高,能够准确呈现出周报的逻辑结构和内容要点,输出的内容较为完整;而 text-davinci-002 的评分最低,缺乏表达周报的逻辑,结构不匹配,内容不贴切。在简历场景任务中,gpt-3.5-turbo 的评分最高,能够专业化地生成符合招聘方要求的简历,并呈现出教育背景、工作经验、技能掌握以及自我评价等方面的信息,但需要更加注重语言表达的精准和个性化;而 text-davinci-003 和 text-davinci-002 的评分较低,缺乏个性化和量化的成果描述,简历的描述也较为简单和缺乏条理。gpt-3.5-turbo 模型生成的面试问题涵盖了职位描述中的主要职责和要求,适应面试场景。问题从多个角度深入了解候选人的能力和经验,包括工作经验、项目经验、技能和个人特质等多个方面,具有较高的针对性。问题具有实际价值,与职位匹配度较高,能有效评估候选人的能力。text-davinci-003 模型生成的面试问题涵盖了职位描述中提到的多个要求和技能,但有些问题表述不具体、条理不清晰。需要更细分领域,否则不能全面衡量候选人的能力。模型生成的问题涵盖了候选人的专业背景、项目经验、技能和个人品质,但有些问题可以更具体和深入,以便更好地评估候选人的能力。

text-davinci-002 模型生成的面试问题主要围绕岗位要求进行,但这些问题过于宽泛,基本上是对岗位描述的重复,未关注候选人与岗位描述之间的匹配程度,不能提出更具挑战性和实际性的问题,甚至会出现输出内容完全不可用的情况。在成功生成问题的情况下,模型生成的问题涵盖了候选人的专业背景、项目经验和技能,但有些问题可以更具体和深入,以便更好地评估候选人的能力。 gpt-3.5-turbo 约消耗 0.017 元,text-davinci-003 约消耗 0.22 元,text-davinci-002 约消耗 0.19 元。在生成的面试问题的难易度和针对性方面,gpt-3.5-turbo 模型的输出最为优秀,它针对该职位的各项要求提出了多个具体问题,并且这些问题的难度和针对性也非常高,能够有效检验候选人的能力和经验。text-davinci-002 模型的输出最为简单,甚至是完全不可用的状态,不能算是面试题目。text-davinci-003 模型的输出则介于两者之间,提出的问题相对于 gpt-3.5-turbo 模型来说较为简单,问题不够细节,但比 text-davinci-002 模型更具体一些。在面试问题与该职位描述的匹配程度方面,gpt-3.5-turbo 模型的输出最为贴合该职位描述,它对该职位的要求进行了全面细致的分析,并针对这些要求提出了相应的问题。text-davinci-003 模型的输出对该职位的要求也有所体现,但是问题的数量和覆盖面相对较少。而 text-davinci-002 可以说是不知所云了。 | |

|---|

| 在输入文本中插入有专用翻译的专有名词、某垂直领域的专业术语、在不同场景下表意不同的名词 | 语义是否通顺、扩写的内容是否正确、有歧义的名词翻译是否正确、专业名词/专有名词翻译是否正确 |

| |

| 在输入中以口语化的口吻写,要求“书面”的方式输出,并在输入中省略部分背景信息、使用有歧义的名词 | 是否可以模拟口语、或正式书面的语言风格,是否能正确理解口语化的表达;对于有歧义的名词是否能正确翻译 |

| |

| 在输入中使用倒装句、同音错别字、方言、口语化省略句 | 对于中文中的语法错误、错别字、不完整句是否可正确过滤并理解 |

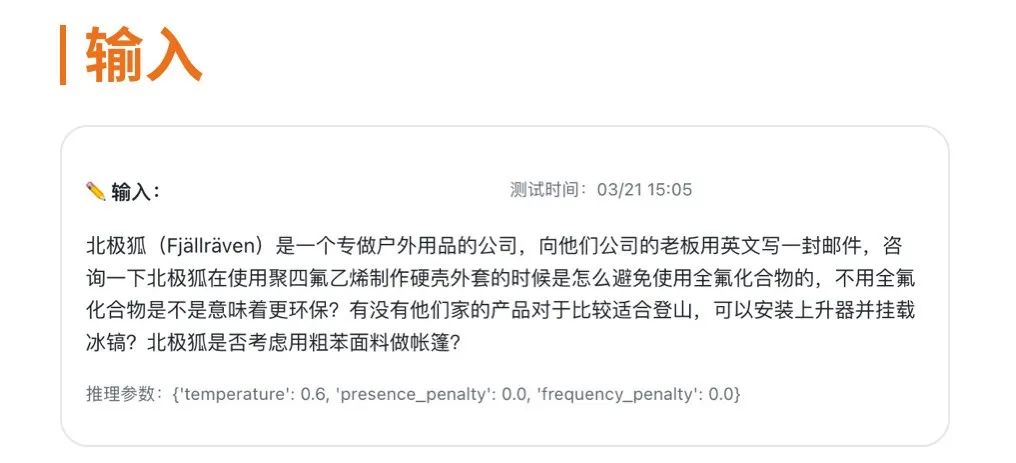

gpt-3.5-turbo:综合评分 3.3 分,邮件结构符合场景,口吻中正,恰当扩写,除非学名的专有名词基本给出缩写,对于口语化的输入中强烈的情绪有很好的理解和过滤,对于错别字、语法错误等输入问题能正确纠正,不足之处是没有正确的识别不安全的内容。text-davinci-003:综合评分 3 分,结构使用常见模板,没有标题,语句连接生硬,扩写不足,专有名词与带歧义的名词理解正确,口语化理解与生成高出预期,没有正确的识别不安全的内容。text-davinci-002:综合评分 2 分,结构使用常见模板,没有标题,语句不通顺甚至错误,语段结构不明显,没有扩写,除非学名的专有名词基本给出缩写,口语与书面语不能很好切换,没有正确的识别不安全的内容。我们选取其中一个测例展开看看 —— 在输入文本中插入有专用翻译的专有名词、某垂直领域的专业术语、在不同场景下表意不同的名词测例中有如下输入 在输入文本中插入有专用翻译的专有名词、某垂直领域的专业术语、在不同场景下表意不同的名词测例,gpt-3.5-turbo 约消耗 0.006 元,text-davinci-003 约消耗 0.067 元,text-davinci-002 约消耗 0.07 元在语义是否通顺方面,三个模型都表现得比较好,没有明显的语病和语法错误。在扩写的内容是否正确方面,gpt-3.5-turbo 和 text-davinci-003 的回复都比较全面,针对各个问题进行了详细的回答,并提供了一些相关的建议和产品推荐。而 text-davinci-002 则只回答了几个问题,并没有提供很多相关的细节和建议。在有歧义的名词翻译是否正确、专业名词/专有名词翻译是否正确方面,三个模型的表现都比较好。gpt-3.5-turbo 和 text-davinci-003、text-davinci-002 都正确地翻译了聚四氟乙烯(PTFE)和全氟化合物(PFCs),并使用了正确的英文术语。gpt-3.5-turbo:综合评分 4.4 分,模型准确且精确地实现了用户提出的要求,在输出内容中与输入相呼应,切合主题场景,表述准确,没有遗漏或歪曲原始信息,能够精炼地组织问题答案,遵循了要求中的简洁度要求,输出流畅,句子结构简洁明了,表述清晰。text-davinci-003:综合评分 4.2 分,模型总结准确性较高,生成内容符合场景需求,没有遗漏信息同时没有添加不必要的信息,语言流畅度也较好,符合内容流畅性和简洁度的要求。然而,需要提高精炼程度,简化语言,同时生成的内容没有提供额外的分析和见解,需要提高广度和深度。text-davinci-002:综合评分 1.5 分,模型输出准确度一般,有些基本覆盖问题点,大多不能较好地适应场景,生成句子结构较为复杂,词语冗余现象明显,语言表述略显生硬,可能会影响读者对文本的理解和阅读流畅性,在简洁性和流畅度方面还有进一步改进的空间。我们选取其中一个测例展开看看 ——

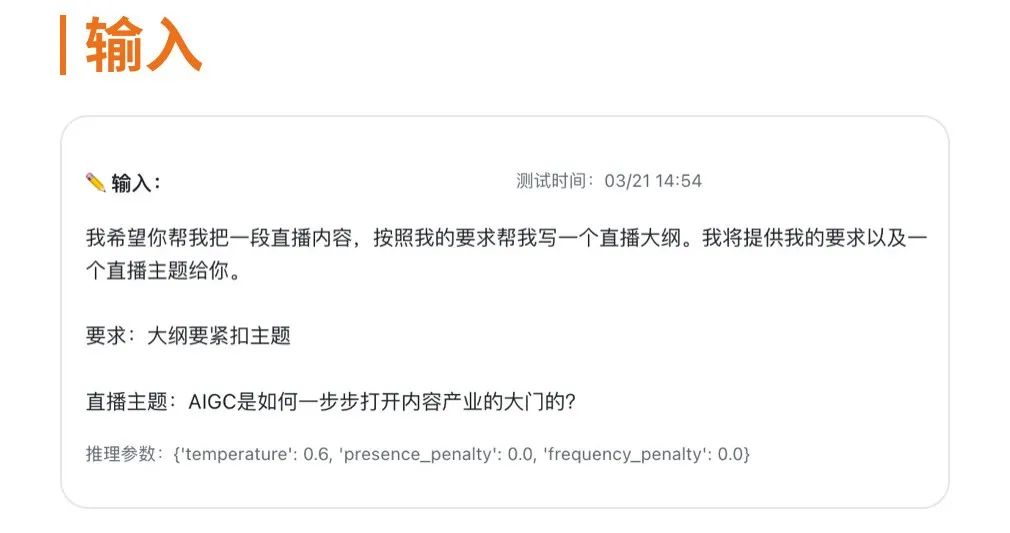

在输入文本中插入有专用翻译的专有名词、某垂直领域的专业术语、在不同场景下表意不同的名词测例,gpt-3.5-turbo 约消耗 0.006 元,text-davinci-003 约消耗 0.067 元,text-davinci-002 约消耗 0.07 元在语义是否通顺方面,三个模型都表现得比较好,没有明显的语病和语法错误。在扩写的内容是否正确方面,gpt-3.5-turbo 和 text-davinci-003 的回复都比较全面,针对各个问题进行了详细的回答,并提供了一些相关的建议和产品推荐。而 text-davinci-002 则只回答了几个问题,并没有提供很多相关的细节和建议。在有歧义的名词翻译是否正确、专业名词/专有名词翻译是否正确方面,三个模型的表现都比较好。gpt-3.5-turbo 和 text-davinci-003、text-davinci-002 都正确地翻译了聚四氟乙烯(PTFE)和全氟化合物(PFCs),并使用了正确的英文术语。gpt-3.5-turbo:综合评分 4.4 分,模型准确且精确地实现了用户提出的要求,在输出内容中与输入相呼应,切合主题场景,表述准确,没有遗漏或歪曲原始信息,能够精炼地组织问题答案,遵循了要求中的简洁度要求,输出流畅,句子结构简洁明了,表述清晰。text-davinci-003:综合评分 4.2 分,模型总结准确性较高,生成内容符合场景需求,没有遗漏信息同时没有添加不必要的信息,语言流畅度也较好,符合内容流畅性和简洁度的要求。然而,需要提高精炼程度,简化语言,同时生成的内容没有提供额外的分析和见解,需要提高广度和深度。text-davinci-002:综合评分 1.5 分,模型输出准确度一般,有些基本覆盖问题点,大多不能较好地适应场景,生成句子结构较为复杂,词语冗余现象明显,语言表述略显生硬,可能会影响读者对文本的理解和阅读流畅性,在简洁性和流畅度方面还有进一步改进的空间。我们选取其中一个测例展开看看 —— 基于直播主题写一个直播的大纲测例,gpt-3.5-turbo 约消耗 0.01 元,text-davinci-003 约消耗 0.11 元,text-davinci-002 约消耗 0.071 元gpt-3.5-turbo 的输出相对其他两个模型更符合主题要求,大纲内容也更为丰富全面,包括了 AIGC 技术与内容产业的结合、成功案例和未来发展方向等方面的内容,整体质量较高。text-davinci-003 的输出同样有一定的可用性,但在与主题的相关程度方面稍有欠缺,主要是在介绍 AIGC 及其历史后,大纲中所提到的如何打开内容产业的大门和 AIGC 的未来等内容跟主题关系不够紧密,相对更为泛泛。text-davinci-002 的输出跟主题要求差距较大,虽然提到了 AIGC 作为一个内容生产公司的概述,但大纲内容更像是一段公司介绍,与主题并没有直接的关联,缺乏直播大纲的实际意义。

基于直播主题写一个直播的大纲测例,gpt-3.5-turbo 约消耗 0.01 元,text-davinci-003 约消耗 0.11 元,text-davinci-002 约消耗 0.071 元gpt-3.5-turbo 的输出相对其他两个模型更符合主题要求,大纲内容也更为丰富全面,包括了 AIGC 技术与内容产业的结合、成功案例和未来发展方向等方面的内容,整体质量较高。text-davinci-003 的输出同样有一定的可用性,但在与主题的相关程度方面稍有欠缺,主要是在介绍 AIGC 及其历史后,大纲中所提到的如何打开内容产业的大门和 AIGC 的未来等内容跟主题关系不够紧密,相对更为泛泛。text-davinci-002 的输出跟主题要求差距较大,虽然提到了 AIGC 作为一个内容生产公司的概述,但大纲内容更像是一段公司介绍,与主题并没有直接的关联,缺乏直播大纲的实际意义。 | |

|---|

| 考量润色能力、扩写能力,输出的内容的完整性、完善度 |

| |

| 基于给出工作内容以及目标模板结构,输出模板化的周报 | |

| |

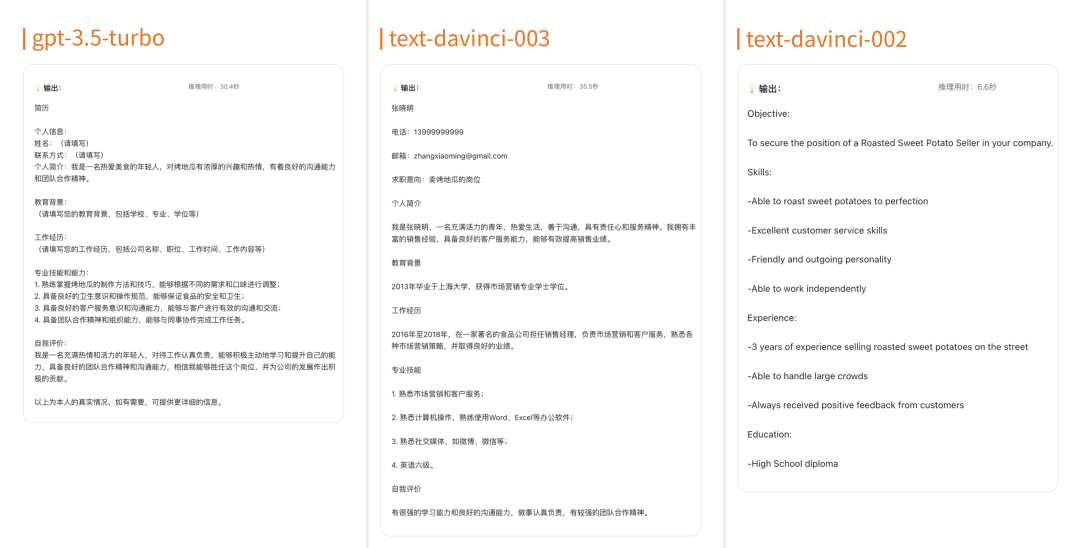

gpt-3.5-turbo:综合评分 3.4 分,将工作内容比较标准的周报形式呈现出来了,按标题、时间、本周工作总结、下周工作计划、总结的模板表达了出来,能够通过一些关键工作任务、工作职责等联想到更深层次的更细节的内容,整体来说输出的内容比较完整,结构清晰,逻辑层次明确。text-davinci-003:综合评分 3.1 分,将已给出的内容通过一段话的形式表达,能够较完整地完成要求,对部分相同属性的工作内容能够做出整合,有一些逻辑性,层次明确,有一定的实用性。但是适应场景能力不够,部分情况缺少扩写,结构不够清晰,缺失条理性。text-davinci-002:综合评分 1.5 分,不能正确理解输入内容场景,输出内容没有表达出周报的主题以及逻辑,结构不匹配,内容不贴切,存在流程化语句,没有任何扩写能力,甚至存在直接翻译输入内容的情况以及复述上次回答的情况,模型表现不佳。基于给出的粗略描述输出周报测例,gpt-3.5-turbo 约消耗 0.0065 元,text-davinci-003 约消耗 0.094 元,text-davinci-002 约消耗 0.072 元对于这个任务,三个模型的输出质量都比较好,都涵盖了本周的主要工作内容,但是有一些细微的差异。gpt-3.5-turbo 的输出相对更加详细,列出了每个任务中的细节,如设计流程、界面、评分标准等,并且也提出了下一步的计划,让周报的读者可以了解到更多的信息。text-davinci-003 的输出也给出了一些详细的信息,但更加强调技术方面的细节,包括评价体系的数据来源、评价项、评价方式等,这份周报更侧重于技术层面的描述。text-davinci-002 的输出则更加简洁明了,但也不失清晰。它以项目和工作的大致方向为主,对于细节方面的描述较少。总的来说,三个模型的输出都可以满足任务的需求,但 gpt-3.5-turbo 和 text-davinci-003 的输出更加详细,提供了更多的细节和技术层面的信息,如果需要更全面的周报,可以选择这两个模型。而 text-davinci-002 的输出则更加简洁明了,适合需要一份简短但清晰的周报。gpt-3.5-turbo:综合评分 4 分,专业性高,模板输出职位要求的各个方面都有涉及,且内容准确;针对性地呈现了该经验对应职位要求的能力和特点,让读者一目了然,同时也更容易满足招聘方的要求;完整呈现,模板输出的信息完整,从教育背景到工作经验、技能掌握以及自我评价都有涉及,能够给招聘方一个全面的认识。但是缺少个性化,表现形式单一,语言表达上用词需要斟酌。

text-davinci-003:综合评分 1.9 分,缺少具体的项目案例和成果展示。没有针对招聘岗位的个性化描述。虽然简历中提到了符合招聘要求的多项条件,但是没有根据招聘岗位的特点和需求来进行具体的描述和突出。缺乏量化的成果描述。语言表述不够简洁和精准。text-davinci-002:综合评分 1.3 分,整体输出信息量太少,不具备任何符合标准简历的基础信息要求,描述语句过于简短缺乏明确的求职目标,缺乏个性化和针对性,缺乏量化指标,经验和技能描述较为简单,格式较为简单,不符合规范,模型表现较差。基于求职岗位生成简历模板测例,gpt-3.5-turbo 约消耗 0.0077 元,text-davinci-003 约消耗 0.1 元,text-davinci-002 约消耗 0.022 元 在生成模板专业度和匹配度方面,可以看到 gpt-3.5-turbo 和 text-davinci-003都能够提供比较完整的简历模板,包含了个人信息、教育背景、工作经历、专业技能和自我评价等关键要素,并且在格式上也比较规范。但如果仔细看,可以看到 text-davinci-003 存在明显与现实认知有冲突的地方,没有具体描述岗位要求和个人能力之间的匹配,比如专业技能部分中,候选人熟悉计算机操作、英语六级,却缺乏与卖烤地瓜岗位相关的专业技能和知识。而 text-davinci-002 则相对简略,只提供了应聘者的目标、技能、经验和教育背景等基本信息。在面试场景任务中,gpt-3.5-turbo 综合评分最高,能够很好地适应面试场景,生成的问题具有较高的针对性和多角度深入了解候选人的能力和经验;而 text-davinci-002 的评分最低,问题过于宽泛且基本是对岗位描述的重复,缺乏挑战性和实际性的问题,甚至出现生成的内容完全不可用的情况。在英文邮件写作场景任务中,gpt-3.5-turbo 和 text-davinci-003 的综合评分较高,能够模拟口语和正式书面的语言风格,对于口语化的表达和带有歧义的名词有很好的理解和翻译,但也无法正确地识别不安全的内容;而 text-davinci-002 的评分最低,口语与书面语不能很好切换,没有正确的识别不安全的内容。在直播场景任务中,gpt-3.5-turbo 的评分最高,能够准确、精炼、流畅地概括直播内容,并符合要求中的简洁度要求;而 text-davinci-002 的评分最低,输出准确度一般,不能很好地适应场景,但在简洁性和流畅性方面还有进一步改进的空间。在写工作周报场景任务中,gpt-3.5-turbo 和 text-davinci-003 的评分较高,能够准确呈现出周报的逻辑结构和内容要点,输出的内容较为完整;而 text-davinci-002 的评分最低,缺乏表达周报的逻辑,结构不匹配,内容不贴切。在简历场景任务中,gpt-3.5-turbo 的评分最高,能够专业化地生成符合招聘方要求的简历,并呈现出教育背景、工作经验、技能掌握以及自我评价等方面的信息,但需要更加注重语言表达的精准和个性化;而 text-davinci-003 和 text-davinci-002 的评分较低,缺乏个性化和量化的成果描述,简历的描述也较为简单和缺乏条理。对于以上五个应用任务的综合评价如下。以下评价仅代表对这些模型在特定应用场景下的评价,针对其他应用场景或任务,评价可能有所不同。其中一些模型还在迭代的过程中,可能将会有更好的表现和性能。在未来的测试中,我们也将增加GPT系列的新模型(如GPT-4)的对比情况。

在生成模板专业度和匹配度方面,可以看到 gpt-3.5-turbo 和 text-davinci-003都能够提供比较完整的简历模板,包含了个人信息、教育背景、工作经历、专业技能和自我评价等关键要素,并且在格式上也比较规范。但如果仔细看,可以看到 text-davinci-003 存在明显与现实认知有冲突的地方,没有具体描述岗位要求和个人能力之间的匹配,比如专业技能部分中,候选人熟悉计算机操作、英语六级,却缺乏与卖烤地瓜岗位相关的专业技能和知识。而 text-davinci-002 则相对简略,只提供了应聘者的目标、技能、经验和教育背景等基本信息。在面试场景任务中,gpt-3.5-turbo 综合评分最高,能够很好地适应面试场景,生成的问题具有较高的针对性和多角度深入了解候选人的能力和经验;而 text-davinci-002 的评分最低,问题过于宽泛且基本是对岗位描述的重复,缺乏挑战性和实际性的问题,甚至出现生成的内容完全不可用的情况。在英文邮件写作场景任务中,gpt-3.5-turbo 和 text-davinci-003 的综合评分较高,能够模拟口语和正式书面的语言风格,对于口语化的表达和带有歧义的名词有很好的理解和翻译,但也无法正确地识别不安全的内容;而 text-davinci-002 的评分最低,口语与书面语不能很好切换,没有正确的识别不安全的内容。在直播场景任务中,gpt-3.5-turbo 的评分最高,能够准确、精炼、流畅地概括直播内容,并符合要求中的简洁度要求;而 text-davinci-002 的评分最低,输出准确度一般,不能很好地适应场景,但在简洁性和流畅性方面还有进一步改进的空间。在写工作周报场景任务中,gpt-3.5-turbo 和 text-davinci-003 的评分较高,能够准确呈现出周报的逻辑结构和内容要点,输出的内容较为完整;而 text-davinci-002 的评分最低,缺乏表达周报的逻辑,结构不匹配,内容不贴切。在简历场景任务中,gpt-3.5-turbo 的评分最高,能够专业化地生成符合招聘方要求的简历,并呈现出教育背景、工作经验、技能掌握以及自我评价等方面的信息,但需要更加注重语言表达的精准和个性化;而 text-davinci-003 和 text-davinci-002 的评分较低,缺乏个性化和量化的成果描述,简历的描述也较为简单和缺乏条理。对于以上五个应用任务的综合评价如下。以下评价仅代表对这些模型在特定应用场景下的评价,针对其他应用场景或任务,评价可能有所不同。其中一些模型还在迭代的过程中,可能将会有更好的表现和性能。在未来的测试中,我们也将增加GPT系列的新模型(如GPT-4)的对比情况。 | | | | |

|---|

| | | |

| | | | |

| | | |

| 在输入文本中插入有专用翻译的专有名词、某垂直领域的专业术语、在不同场景下表意不同的名词 | | | |

| | | |

| 在输入中以口语化的口吻写,要求“书面”的方式输出,并在输入中省略部分背景信息、使用有歧义的名词 | | | |

| | | |

| 在输入中使用倒装句、同音错别字、方言、口语化省略句 | | | |

| | | | |

| | | |

| | | |

| | | |

| | | | |

| | | |

| 基于给出工作内容以及目标模板结构,输出模板化的周报 | | | |

| | | |

| | | | |

| | | |

| | | |

| | | |

如果你善于发现有意思的模型、擅长开源模型部署、调试及评测,欢迎扫码加入「SOTA!模型」社区「开源」群~网页端访问:在浏览器地址栏输入新版站点地址 sota.jiqizhixin.com ,即可前往「SOTA!模型」平台,查看关注的模型是否有新资源收录。 移动端访问:在微信移动端中搜索服务号名称「机器之心SOTA模型」或 ID 「sotaai」,关注 SOTA!模型服务号,即可通过服务号底部菜单栏使用平台功能,更有最新AI技术、开发资源及社区动态定期推送。