「我们没有护城河,OpenAI 也没有。」在最近泄露的一份文件中,一位谷歌内部的研究人员表达了这样的观点。这位研究人员认为,虽然表面看起来 OpenAI 和谷歌在 AI 大模型上你追我赶,但真正的赢家未必会从这两家中产生,因为一个第三方力量正在悄然崛起。这个力量名叫「开源」。围绕 Meta 的 LLaMA 等开源模型,整个社区正在迅速构建与 OpenAI、谷歌大模型能力类似的模型,而且开源模型的迭代速度更快,可定制性更强,更有私密性……「当免费的、不受限制的替代品质量相当时,人们不会为受限制的模型付费。」作者写道。这份文件最初由一位匿名人士在公共 Discord 服务器上分享,获得转载授权的产业媒体 SemiAnalysis 表示,他们已经验证了这份文件的真实性。这篇文章在推特等社交平台上得到了大量转发。其中,得克萨斯大学奥斯汀分校教授 Alex Dimakis 发表了如下观点:- 开源 AI 正在取得胜利,我同意,对于全世界来说,这是件好事,对于构建一个有竞争力的生态系统来说也是好事。虽然在 LLM 领域,我们还没有做到这一点,但我们刚刚让 OpenClip 击败了 openAI Clip,并且 Stable Diffusion 比封闭模型更好。

- 你不需要庞大的模型,高质量的数据更有效、更重要,API 背后的羊驼模型进一步削弱了护城河。

- 你可以从一个好的基础模型和参数高效微调(PEFT)算法开始,比如 Lora 在一天内就能运行得非常好。算法创新终于开始了!

- 大学和开源社区应该组织更多的工作来管理数据集,训练基础模型,并像 Stable Diffusion 那样建立微调社区。

当然,并非所有研究者都同意文章中的观点。有人对开源模型是否真能拥有媲美 OpenAI 的大模型的能力和通用性持怀疑态度。

不过,对于学术界来说,开源力量的崛起总归是件好事,意味着即使没有 1000 块 GPU,研究者也依然有事可做。

我们一直在关注 OpenAI 的动态和发展。谁将跨越下一个里程碑?下一步会是什么?但令人不安的事实是,我们没有能力赢得这场军备竞赛,OpenAI 也是如此。在我们争吵不休的时候,第三个派别一直在渔翁得利。这个派别就是「开源派」。坦率地说,他们正在超越我们。我们所认为的那些「重要的待解决问题」如今已经被解决了,而且已经送到了人们的手中。- 能在手机上运行的大型语言模型:人们可以在 Pixel 6 上运行基础模型,速度为 5 tokens / 秒。

- 可扩展的个人 AI:你可以花一个晚上在你的笔记本电脑上微调一个个性化的 AI。

- 负责任的发布:这个问题与其说是「被解决了」,不如说是「被忽略了」。有的网站整体都是没有任何限制的艺术模型,而文字也不例外。

- 多模态:目前的多模态科学 QA SOTA 是在一个小时内训练完成的。

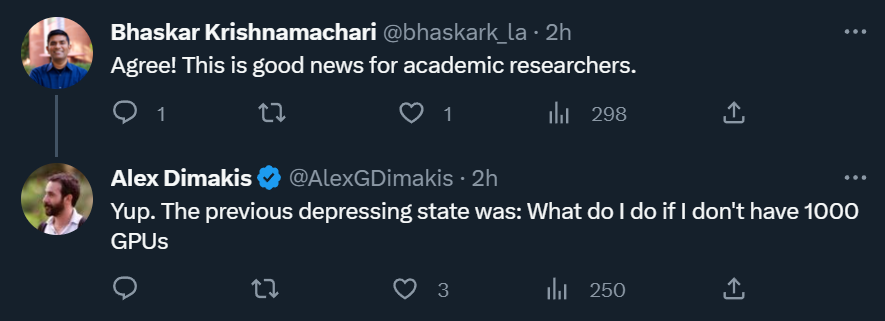

虽然我们的模型在质量方面仍然保持着轻微的优势,但差距正在以惊人的速度缩小。开源模型的速度更快,可定制性更强,更有私密性,而且在同等条件下能力更强大。他们正在用 100 美元和 130 亿的参数做一些事情,而我们在 1000 万美元和 540 亿的参数上却很难做到。而且他们在几周内就能做到,而不是几个月。这对我们有深远的影响:- 我们没有秘密武器。我们最大的希望是向谷歌以外的其他人学习并与他们合作。我们应该优先考虑实现 3P 整合。

- 当免费的、不受限制的替代品质量相当时,人们不会为受限制的模型付费。我们应该考虑我们的附加值到底在哪里。

- 巨大的模型拖慢了我们的速度。从长远来看,最好的模型是那些可以快速迭代的模型。既然我们知道 200 亿以下参数的模型能做什么,那我们应该在一开始就把它们做出来。

三月初,随着 Meta 的 LLaMA 模型被泄露给公众,开源社区得到了第一个真正有用的基础模型。该模型没有指令或对话调整,也没有 RLHF。尽管如此,开源社区立即把握住了 LLaMA 的重要性。随之而来的是源源不断的创新,主要进展出现的间隔只有几天(如在树莓派 4B 上运行 LLaMA 模型、在笔记本上对 LLaMA 指令微调、在 MacBook 上跑 LLaMA 等)。仅仅一个月之后, 指令微调、量化、质量改进、多模态、RLHF 等变体都出现了,其中很多都是在彼此的基础上构建的。最重要的是,他们已经解决了规模化问题,这意味着任何人都可以自由地修改和优化这个模型。很多新想法都出自普通人。训练和实验门槛已经从主要研究机构下放到一个人、一个晚上和一台功能强大的笔记本电脑。LLM 的 Stable Diffusion 时刻从很多方面来说,任何人都不应该对此感到意外。开源 LLM 当前的复兴紧随图像生成的复兴出现,很多人称这是 LLM 的 Stable Diffusion 时刻。在这两种情况下,低成本的公众参与是通过一种成本低得多的低秩适应(low rank adaptation, LoRA)微调机制实现的,并结合了 scale 上的重大突破。高质量模型的易得帮助世界各地的个人和机构孕育了一系列想法,并让他们得以迭代想法,并很快超过了大型企业。这些贡献在图像生成领域至关重要,使 Stable Diffusion 走上了与 Dall-E 不同的道路。拥有一个开放的模型促成了 Dall-E 没有出现的产品集成、市场、用户界面和创新。效果是显而易见的:与 OpenAI 解决方案相比,Stable Diffusion 的文化影响迅速占据主导地位。LLM 是否会出现类似的发展趋势还有待观察,但广泛的结构要素是相同的。开源项目使用的创新方法或技术直接解决了我们仍在努力应对的问题。关注开源工作可以帮助我们避免重蹈覆辙。其中,LoRA 是功能极其强大的技术,我们应当对其投入更多的关注。LoRA 将模型的更新展现为低秩因式分解,能够使更新矩阵的大小缩减几千倍。如此一来,模型的微调只需要很小的的成本和时间。将在消费级硬件上对语言模型进行个性化调整的时间缩减至几个小时非常重要,尤其是对于那些希望在近乎实时的情况下整合新的、多样化知识的愿景而言。虽然该技术对一些我们想要完成的项目有很大影响,但它并未在谷歌内部得到充分的利用。LoRA 如此高效的一个原因是:就像其他形式的微调一样,它可以堆叠。我们可以应用指令微调等改进,帮助完成对话、推理等任务。虽然单个微调是低秩的,当它们的总和并不是,LoRA 允许对模型的全等级更新随着时间的推移积累起来。这意味着,随着更新更好数据集和测试的出现,模型可以低成本地保持更新,而不需要支付完整的运行成本。相比之下,从头开始训练大模型不仅丢掉了预训练,还丢掉了之前进行的所有迭代和改进。在开源世界中,这些改进很快就会盛行起来,这让全面重新训练的成本变得非常高。我们应该认真考虑,每个新应用或想法是否真的需要一个全新的模型。如果我们真的有重大的架构改进,排除了直接重用模型权重,那么我们应该致力于更积极的蒸馏方式,尽可能保留前一代功能。对于最流行的模型尺寸,LoRA 更新的成本非常低(约 100 美元)。这意味着,几乎任何有想法的人都可以生成并分发它。在训练时间小于一天的正常速度下,微调的累积效应很快就可以克服开始时的尺寸劣势。事实上,就工程师时间而言,这些模型的改进速度远远超过了我们的最大变体所能做到的。并且最好的模型在很大程度上已经与 ChatGPT 基本没有区别了。因此,专注于维护一些最大的模型实际上使我们处于不利地位。这些项目中有许多是通过在小型、高度策划的数据集上进行训练来节省时间。这表明在数据缩放规律中较为灵活。这种数据集的存在源于《数据并非你所想(Data Doesn't Do What You Think)》中的想法,并正迅速成为无需谷歌的标准训练方式。这些数据集是使用合成方法(例如从现有的模型中滤出最好的反映)以及从其他项目中搜刮出来的,这但两种方法在谷歌并不常用。幸运的是,这些高质量的数据集是开源的,所以它们可以免费使用。最近的这一进展对商业战略有非常直接的影响。如果有一个没有使用限制的免费、高质量的替代品,谁还会为有使用限制的谷歌产品买单?况且,我们不应该指望能够追赶上。现代互联网在开放源码上运行,是因为开放源码有一些我们无法复制的显著优势。保守我们的技术机密始终是一个脆弱的命题。谷歌研究人员正定期前往其他公司学习,这样可以假设他们知道我们所知道的一切。并且只要这种 pipeline 开放,他们就会继续这样做。但由于 LLMs 领域的尖端研究可以负担得起,因此保持技术竞争优势变得越来越难了。世界各地的研究机构都在相互借鉴,以广度优先的方式探索解决方案空间,这远远超出了我们自身的能力。我们可以努力抓住自己的秘密,但外部创新会稀释它们的价值,因此可以尝试相互学习。多数创新构建在 Meta 泄露的模型权重之上。随着真正开放的模型变得越来越好,这将不可避免发生变化,但关键是他们不必等待。「个人使用」提供的法律保护和不切实际的个人起诉意味着个人可以在这些技术炙手可热的时候使用它们。矛盾的是,所有这一切只有一个赢家,那就是 Meta,毕竟泄露的模型是他们的。由于大多数开源创新是基于他们的架构, 因此没有什么可以阻止他们直接整合到自家的产品中。可以看到,拥有生态系统的价值再怎么强调都不为过。谷歌本身已经在 Chrome 和 Android 等开源产品中使用这种范式。通过孵化创新工作的平台,谷歌巩固了自己思想领导者和方向制定者的地位,获得了塑造比自身更宏大思想的能力。我们对模型的控制越严格,做出开放替代方案的吸引力就越大,谷歌和 OpenAI 都倾向于防御性的发布模式,使得他们可以严格地控制模型使用方式。但是,这种控制是不现实的。任何想要将 LLMs 用于未经批准目的的人都可以选择免费提供的模型。因此, 谷歌应该让自己成为开源社区的领导者,通过更广泛的对话合作而不是忽视来起到带头作用。这可能意味着采取一些不舒服的举措,比如发布小型 ULM 变体的模型权重。这也必然意味着放弃对自身模型的一些控制,但这种妥协不可避免。我们不能既希望推动创新又要控制它。考虑到 OpenAI 当前的封闭政策,所有这些开源讨论都会令人觉得不公平。如果他们都不愿意公开技术,我们为什么要分享呢?但事实却是,我们通过源源不断地挖角 OpenAI 的高级研究员,已经与他们分享着一切。在我们阻止这一潮流之前,保密仍是一个有争议的问题。最后要说的是,OpenAI 并不重要。他们在开源立场上犯了与我们一样的错误,并且他们保持优势的能力必然遭到质疑。除非 OpenAI 改变立场,否则开源替代产品能够并最终会让他们傲然失色。至少在这方面,我们可以迈出这一步。原文地址:https://www.semianalysis.com/p/google-we-have-no-moat-and-neither点击进入—>【Transformer】微信技术交流群

最新CVPR 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer333,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信号: CVer333,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉,已汇集数千人!

▲扫码进星球

整理不易,请点赞和在看